1. Introduction

Introduction

Réseau de neurones artificiel?

•Abstraction du système nerveux humain

–Traitement parallèle de l’information

•Par opposition à un automate sériel comme un

ordinateur

–Capacité d’apprentissage et d’adaptation

•Principe de traitement très simples et identiques

pour tous les éléments

•Mais comportement de groupe complexe!

•Applications

–Résolution de problèmes difficiles

–Modélisation biologique

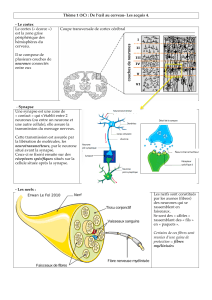

Réseau de neurones biologique

•Quand un pigeon devient expert en art!

(Watanabe et al. 1995)

–Experience :

•Pigeon dans une boîte de Skinner

•Exposition aux tableaux de deux artistes

(Chagall / Van Gogh)

•Récompense pour bec à la vue d’un tableau de

l’un des artistes (e.g. Van Gogh)

•Les pigeons utilisés ont pu distinguer Van

Gogh de Chagall avec 95% de précision

pour les tableaux d’entraînement

•Précision de 85% pour les tableaux non vus

auparavant!

•Mémoire oui, mais aussi

–Identification de traits essentiels et/ou

généralisation

–Pas d’usage apparent d’un processus réfléchi

–Force majeure des réseaux de neurones!

(artificiels et biologiques)

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

1

/

35

100%