Aucun titre de diapositive

L’information c’est physique

ou comment exorciser les Démons

David Poulin

Département de physique et DIRO

Université de Montréal

1. Introduction

Physique Information

Manipulation

•États quantiques

•Craie

•Feynman: problème quantique, info quantique

•Ordinateur analogique

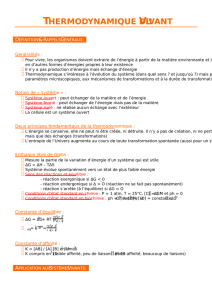

Physique Information

Prédictions

•Méthode d’entropie maximale

•Thermodynamique = minimiser Iavec

contraintes macroscopiques

Physique Information

Information -i

i. Information ??? intuition.

Gauchers

Droitiers

Prob.

Yeux bleus PGB PDB 1/3

Yeux verts PGV PDV 2/3

Prob. 1/3 2/3 1

But: Déterminer les 4 variables Pab.

À notre disposition: 4 équations linéaires

dont 3 indépendantes.

Solution: Choisir celle qui introduit le moins

d’information.

scontrainte|)(min ab

PPI

ab

Multiplicateurs de Lagrange.

Il nous reste à trouver I !!!

Information -2

2. Information

Information contenue en moyenne dans un

message An{Ai}i=1..N ?

Pr(An) = pn,

N

ii

p

11

Cas extrêmes

1) pn=1, pi=0, ij

Information=0

2) pi= , i=1..N

Information maximale

Cas général (Entropie de Shannon, 1949)

N

1

N

iiiNii ppkpI 1

..1ln}{

k > 0 (k =1 et ln = log2bits)

Information -3

Information = # minimal de bits par message

Exemple trivial:

Message

Probabilité

(fréquance)

Représentation

# de bits

A 1/4 00 2

B 1/4 01 2

C 1/4 10 2

D 1/4 11 2

24ln

4

1

ln

4

1

4I

2l

Exemple moins trivial:

Message

Probabilité

Représentation

# de bits

A 1/2 01

B 1/4 10 2

C 1/8 110 3

D 1/8 111 3

4

7

8

1

ln

8

1

8

1

ln

8

1

4

1

ln

4

1

2

1

ln

2

1I

Information -4

On trouve bien <l> = 7/4.

On est contraint à trouver une représentation qui

ne présente aucune ambiguïté:

1 0 1 1 0 1 0 0 1 1 1 0 ...

B C B A D A

De façon générale,

1 IlI

Jaynes, 1954. Faire de la thermodynamique, c’est

trouver les probabilités pi, associées à chaque état

microscopique i, qui minimisent l’information I

tout en respectant les contraintes macroscopiques

tels le volume, la pression, ...

Les résultats obtenus sont identiques aux résultats

établis depuis longtemps ...

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%