Tr-selection-attributs

1

Cornuéjols Apprentissage et prétraitement

16/01/06

Antoine Cornuéjols

Sélection d’attributs

CNAM-IIE

et L.R.I., Université de Paris-Sud, Orsay (France)

antoine@lri.fr

http://www.lri.fr/~antoine/

2

Cornuéjols Apprentissage et prétraitement

16/01/06

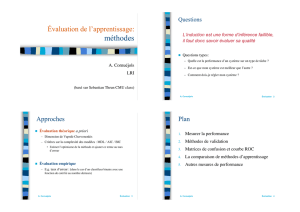

Cours : plan

1- Pourquoi sélectionner les attributs

2- Définition du problème

• Pertinence et sous-ensemble d’attributs pertinents

3- Méthodes de sélection

• Trois familles d’approches

• Mesures de pertinence

• Détermination du seuil

4- Étude de cas

3

Cornuéjols Apprentissage et prétraitement

16/01/06

Pourquoi la sélection d’attributs

•Facteurs sans influence ou peu influents

•Facteurs redondants

•Dimension des entrées telle que coût de

l’apprentissage trop grand

4

Cornuéjols Apprentissage et prétraitement

16/01/06

Pourquoi la sélection d’attributs

•Apprentissage moins coûteux

•Faciliter l’apprentissage

Meilleure performance en classification

Meilleure compréhensibilité de l’hypothèse

•Identifier les facteurs pertinents

Génomique

Vision

5

Cornuéjols Apprentissage et prétraitement

16/01/06

La sélection d’attributs

•Idéalement

Identifier le sous-ensemble d’attributs de taille minimale nécessaire et

suffisant pour définir le concept cible

•Classiquement

Sélectionner un sous-ensemble d’attributs de taille n<d, tel qu’un critère soit

optimisé par rapport à tous les sous-ensembles de taille n.

•Amélioration de l’erreur en classification

Apprentissage supervisé

•Rester proche de la distribution originale des classes

Apprentissage non supervisé

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

1

/

43

100%