PowerPoint Presentation - Architecture et technologie des

Architecture et technologie

des ordinateurs II

Gianluca Tempesti

EPFL-DI-LSL, INN 235

Tel: 693 2676

E-Mail: [email protected]

Web: lslwww.epfl.ch/~tempesti/CoursUNIL.htm

Bibliographie

John P. Hayes, Computer Architecture and Organization,

McGraw-Hill, 3rd ed., 1998.

David A. Patterson and John L. Hennessy, Computer

Architecture : A Quantitative Approach, Morgan

Kaufmann, 2nd Ed., 1996.

David A. Patterson and John L. Hennessy, Computer

Organization and Design : The Hardware/Software

Interface, Morgan Kaufmann, 2nd ed., 1997.

David A. Patterson and John L. Hennessy, Architecture

des ordinateurs: une approche quantitative, Thomson

Publishing, 2ème ed., 1996.

Programme détaillé

Semaine 1: Introduction

Historique

Prix vs. performance

Niveaux de conception

Semaine 2: Arithmétique I

Virgule fixe et flottante

Addition et soustraction

Semaine 3:

Arithmétique II

Multiplication et division

Unité de traitement

Semaine 4: Contrôle

Unité de contrôle

Programmes

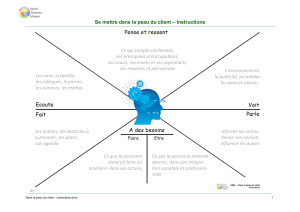

Semaine 5: Instructions

Jeux d’instructions

Décodage

Séquencement

Modes d’adressage

Semaine 6: Processeurs

Microprogrammation

Types de processeur

Programme détaillé

Semaine 7: Procédures

Gestion des procédures

Gestion des interruptions

Semaine 8: Mémoires I

RAM

Mémoire virtuelle

Semaine 9: Mémoires II

Mémoire cache

Mémoires associatives

Semaine 10: Périphériques

Gestion du bus système

Gestion des périphériques

Semaine 11: Petite pause

Semaine 12: Pipelining

Fonctionnement

Aléas des pipelines

Prédiction de branchement

Semaine 13: Parallélisme

des instructions I

Ordonnancement dynamique

Lancement multiple

Compilation

Semaine 14: Parallélisme

des instructions II

Architectures avancées

Historique I - Époque méchanique

Blaise Pascal - 1642 -Addition et soustraction

Retenue automatique, complément

Gottfried Leibniz - 1671 - Multiplication et

division

Additions successives

Charles Babbage

1823 - Difference engine - addition

Séquence d’instructions

1834 -Analytical engine - toute opération

Contrôle de séquence (programme), ALU et mémoire

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

1

/

24

100%