1 Objectif 2 Données

Didacticiel‐Étudesdecas R.R.

30novembre2009 Page1sur16

1 Objectif

Comparaisondepopulations.TestsparamétriquesunivariésavecTanagra.

LestestsdecomparaisondepopulationsvisentàdéterminersiK(K≥2)échantillonsproviennentdela

mêmepopulationauregardd’unevariabled’intérêt(X).End’autrestermes,noussouhaitonsvérifierquela

distributiondelavariableestlamêmedanschaquegroupe.Onutiliseégalementl’appellation«tests

d’homogénéité»danslalittérature.

Onparledetestsparamétriqueslorsquel’onfaitl’hypothèsequelavariableXsuitunedistribution

paramétrée.Dèslorscomparerlesdistributionsempiriquesconditionnellesrevientàcomparerlesparamètres,

soitlamoyenneetlavariancelorsquel’onfaitl’hypothèsedenormalitédeX.

Enfin,danscedidacticiel,noustraitonslestestsunivariésc.‐à‐d.nousétudionsuneseulevariabled’intérêt.

Lorsquenoustraitonssimultanémentplusieursvariables,onparledetestsmultivariés.Cequiferal’objetd’un

autredidacticielprochainement.

Cetypedetest1peutserviràcomparereffectivementdesprocessus(ex.est‐cequedeuxmachinesproduisent

desboulonsdemêmediamètre),maisilpermetégalementd’éprouverlaliaisonquipeutexisterentreune

variablecatégorielleetunevariablequantitative(ex.estcequelesfemmesconduisentenmoyennemoinsvite

queleshommessurtelleportionderoute).

Lesaspectsthéoriquesrelatifsàcedidacticielsontdécritsdansunsupportdecoursaccessibleenligne

http://eric.univ‐lyon2.fr/~ricco/cours/cours/Comp_Pop_Tests_Parametriques.pdf(PartiesIetII).Nous

utiliseronslesmêmesdonnéesetnoussuivronsexactementlamêmetramepourquelelecteurpuissesuivrele

détaildesformulesmisesenœuvre.

2 Données

LefichierCREDIT_APPROVAL.XLS2décrit50ménages,formésdecouplesmariés,tousdeuxactifs,quiont

déposéunedemandedecréditauprèsd’unétablissementbancaire.Lesvariablesdisponiblessontles

suivantes:

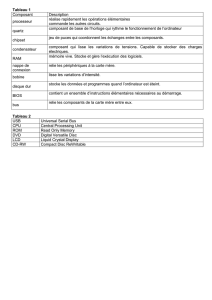

VariableDescription

Sal.HommeLogarithmedusalairedel’homme

Sal.FemmeLogarithmedusalairedelafemme

Rev.TeteLogarithmedurevenupartêtec.‐à‐d.totaldesrevenusdiviséparlenombrede

personnes

AgeLogarithmedel’âgedel’homme

AcceptationAccordducréditparl’organismeprêteur

Garantie.SuppGarantiesupplémentairedemandéeparl’organismeprêteur

EmploiTyped’emploioccupéparlapersonnederéférencelorsdelademandedecrédit

Lesvariablesquantitativessonttoutespotentiellement«variabled’intérêt»;lesvariablescatégoriellesvont

serviràdéfinirlessouspopulations.

1http://www.itl.nist.gov/div898/handbook/prc/prc.htm

2http://eric.univ‐lyon2.fr/~ricco/tanagra/fichiers/credit_approval.xls

Didacticiel‐Étudesdecas R.R.

30novembre2009 Page2sur16

3 Statistiques descriptives et test de normalité

3.1 ImporterlesdonnéesdansTanagra

LeplussimplepourlancerTanagraetchargerlesdonnéesestd’ouvrirlefichierXLSdansletableurEXCEL.

Noussélectionnonslaplagededonnées.Lapremièrelignedoitcorrespondreaunomdesvariables.Puisnous

activonslemenuTANAGRA/EXECUTETANAGRAquiaétéinstalléaveclamacrocomplémentaire

TANAGRA.XLA3.Uneboîtededialogueapparaît.Nousvérifionslasélection.Sitoutestenrègle,nousvalidons

encliquantsurleboutonOK.

Tanagraestautomatiquementlancé.Unnouveaudiagrammeestcréé.Nousvérifionsquel’ensemblede

donnéescomporte50observationset7variables.

3Voirhttp://tutoriels‐data‐mining.blogspot.com/2008/03/importation‐fichier‐xls‐excel‐macro.htmlconcernant

l’installationetl’utilisationdelamacrocomplémentaireTANAGRA.XLA.

Didacticiel‐Étudesdecas R.R.

30novembre2009 Page3sur16

3.2 Statistiquesdescriptives

Premièreétape,noussouhaitonsinspecterlesvariablesquantitativesàl’aided’indicateursstatistiques

simples.NousinséronslecomposantDEFINESTATUSdanslediagramme,vialeraccourcidanslabarre

d’outils,puisnousplaçonsenINPUTlesvariablesSal.Homme,Sal.Femme,Rev.TeteetAge.

NousintroduisonsalorslecomposantMOREUNIVARIATECONTSTAT(ongletSTATISTICS).Nouscliquons

surVIEWpourobtenirlesrésultats.

Didacticiel‐Étudesdecas R.R.

30novembre2009 Page4sur16

Aveccetyped’outils,onchercheavanttoutàdétecterlesanomaliesfortesdutype«distribution

asymétrique»,«bimodale»,l’existencedepointsatypiques,etc.Ilsemblequ’iln’yaitpaslieudeàs’inquiéter

outremesureici.

3.3 Testdenormalité

Lestestsquenousprésentonsdanscedidacticielsupposentgaussienneladistributiondesvariablesd’intérêt.

Certes,ilssontplusoumoinsrobustesfaceàcettehypothèse.Néanmoins,pourassurerl’affaire(etmontrer

commentfaire),nousdécidonsdeprocéderàcettevérification4,5.

Unepremièreévaluationempiriqueétaitdéjàpossibleaveclecomposantprécédent.Onsaitquelerapport

entrel’écartabsolumoyen(MAD:meanabsolutedeviation)etl’écarttype(STD‐DEV:standarddeviation)est

approximativementégalà0.8lorsqueladistributionestgaussienne6.Attention,l’inversen’estpasvrai.Ce

n’estpasparcequeleratioestprochede0.8queladistributionestforcémentnormale.Onutiliserasurtout

cetterègleempiriquepourdétecterlesécartsévidents,annonciateursdeproblèmes.Dansnotrecas,ilestn’y

apasd’écartsmanifestes.Eneffet,ilestégalà0.7162pour«Sal.Homme»,0.7846pour«Sal.Femme»,

0.7986pour«Rev.Tete»et0.7895pour«Age».Misàpart«Sal.Homme»,noussommesmême

étonnammentprochesdelavaleurderéférence.

Procédonsmaintenantàuneévaluationplusformelleenutilisantlestestsd’adéquationàlaloinormale.Nous

inséronslecomposantNORMALITYTEST(ongletSTATISTICS)danslediagramme.Nouscliquonssurlemenu

contextuelVIEW.

4Voirhttp://tutoriels‐data‐mining.blogspot.com/2008/04/tests‐dadquation‐la‐loi‐normale.htmlpourplusdedétailssurles

testsd’adéquationàlaloinormale.

5Attention:Letestdenormalitésurlaglobalitédel’échantillonn’estpasforcémentunebonneidée.Eneffet,prenons

l’exempled’unecomparaisondemoyennessuréchantillonsindépendants.Sil’hypothèsealternativeestvraie,la

distributiondesdonnéesregroupéesnepeutpasêtrecompatibleavecl’hypothèsedenormalitépuisqu’elleserabimodale.

Ilestsouventplusindiquéderéaliserlestestsdenormalitéàl’intérieurdessouspopulations.

6798.0

2≈

π

pourêtreprécis.Voirhttp://en.wikipedia.org/wiki/Mean_absolute_deviation

Didacticiel‐Étudesdecas R.R.

30novembre2009 Page5sur16

Aurisque5%,l’hypothèsedecompatibilitédesvariables(prisesindividuellement)aveclaloinormalen’estpas

remiseencauseparlesdonnées.Cecin’estguèreétonnant,nousavonsprocédéàdesajustements,enpassant

parleslogarithmesprincipalement,demanièreàrendreaumoinssymétriqueslesdistributions.

4 Tests pour échantillons indépendants

4.1 Comparaisonde2moyennes–Varianceségales

Noussouhaitonscomparerlesalairefémininselonquel’acceptation.End’autrestermes,nouscherchonsà

savoirsil’acceptationducréditpourraitêtreconditionnéeparlesalairedelapatronne7.Noussommesdansun

schémadecomparaisondemoyennes,connusouslenomde«TestdeStudent».

NousinséronsunnouveaucomposantDEFINESTATUSdanslediagramme,nousdésignonsSAL.FEMMEen

TARGETetACCEPTATIONenINPUT.

7Lalectureinverseestmoinscrédible.L’acceptationoupasd’unedemandedeprêtnedevraitpaspesersurlessalaires.

Cetexempleillustreparfaitementlerôled’unteststatistique.Laprocédurecalculemécaniquementlesécartsetchercheà

savoirsielleestsignificativeselonunschémaprobabiliste.L’interprétationenrevanchenepeutreposerquesurnos

connaissancesdudomaine.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

1

/

16

100%