Archeops et Planck à l`écoute du premier cri de l`univers

Ce numéro de « L’actualité du LAL » est construit autour de la rencontre « Résonances…» intitulée « Archeops et Planck, à

l’écoute du premier cri de l’univers ».

Olivier Perdereau nous offre un article qui est, en fait, peut-être un peu plus qu’une transcription de l’inter-

vention qu’il avait prononcée lors de la rencontre. Il effectue pour nous une remise en perspective

complète des deux expériences dans la théorie cosmologique contemporaine et dans la situation

expérimentale mondiale. Dans un second article Olivier dresse un panorama historique qui nous

rappelle à bon escient la dimension d’aventure humaine de toutes ces recherches.

C’est aussi d’aventure, mais peut-être d’un autre genre, ou plutôt d’un autre style, que nous

entretient Sophie Henrot-Versillé avec les « expéditions » de Kiruna. Mais avant

ces expéditions, il avait fallu mettre en œuvre des technologies avancées, entre

autres ces bolomètres refroidis à 100 mK, dont Sophie nous entretient

également.

La participation du LAL à ces expériences a de multiples

facettes. On s’en convaincra en lisant l’article sur l’analyse des

données, de François Couchot et l’entretien de membres du comité

de rédaction avec quelques participants aux expériences.

GUY LEMEUR

du

l'actu lité

a

Bulletin d’information interne du Laboratoire de l’Accélé

r

a

t

e

u

r

L

i

n

é

a

i

r

e

–

U

M

R

8

6

0

7

,

U

n

i

v

e

r

s

i

t

é

P

a

r

i

s

-

S

u

d

– B.P. 34 – 91898 Orsay Cedex

Comité de rédaction : M.-A. Bizouard, F. Berny, F. Couchot, F. Fulda-Que

n

z

e

r

,

S

.

H

e

n

r

o

t

-

V

e

r

s

i

l

l

é

,

H

.

K

é

r

e

c

,

D

.

L

e

c

o

m

t

e

,

G

.

L

e

M

e

u

r

,

P

.

R

o

u

d

e

a

u

.

Tél. 8410 E-mail : [email protected]

L

L

N°40

hiver

Archeops et Planck à l’écoute du premier cri de l’univers

Cosmologie

Archeops et Planck à

l’écoute du premier cri de

l’univers

par Olivier Perdereau

Analyse des données

de l’expérience Planck

par François Couchot

page 2

Les bolomètres et la dilution

par Sophie Henrot-Versillé

3

15

18

23

À l’écoute du

premier cri

de l’univers

Journal de mission à Kiruna

par Sophie Henrot-Versillé

Kiruna

Bolomètres

Analyse

La participation du

LAL à l’expérience

Planck

27

Entretien

Les très riches heures

du CMB

par Olivier Perdereau

31

Histoire

page 3

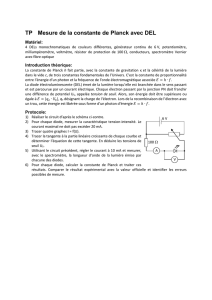

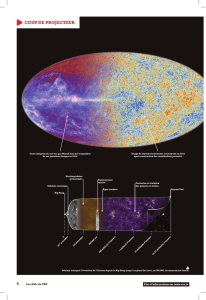

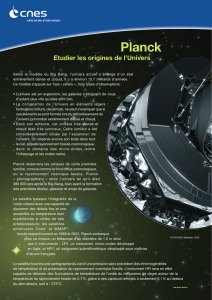

Introduction à la cosmologie

La cosmologie s’est édifiée progressivement, en s'appuyant sur trois observations fondamentales, appelées « les

trois piliers» : l’expansion de l’univers, sa composition chimique (grande proportion d’hélium), et le rayonnement

de fond cosmologique.

Les trois piliers

L'expansion de l'univers

Les mouvements des galaxies distantes ont été étudiés depuis le début du XXesiècle. E. Hubble et M. Humason

dès 1922 ont constaté que les galaxies distantes semblent s'éloigner de nous, et ce d'autant plus rapidement

qu'elles sont éloignées. Cette étude s'est affinée et complétée depuis, pour culminer avec les études menées par

un groupe d'astrophysiciens avec le télescope spatial de la NASA opportunément baptisé «Hubble Space

Telescope» (ou HST). Elle repose sur la comparaison de deux mesures : d'une part la mesure de la vitesse d'éloi-

gnement d'une galaxie (par effet Doppler), d'autre part la mesure de la distance qui nous sépare d'une galaxie. Ce

second aspect est bien souvent une mesure relative basée par exemple sur la luminosité d'objets particuliers : cer-

tains types d’objets semblent en effet être de nature à émettre toujours la même quantité de rayonnement (lumi-

nosité absolue). Leur luminosité apparente mesurera alors leur distance relative.

Les objets astrophysiques semblent s'éloigner de nous d'autant plus vite qu'ils sont distants. En vérité il s’agit

d’une dilatation d'échelle de l'univers. Considérons les raisins d'un cake, qui gonfle en cuisant lentement dans un

four. Pendant ce gonflement, les raisins s'éloignent les uns des autres. Les rapports entre les distances entre les

grains sont conservés.

La cosmologie peut être définie comme l'étude de «la structure et de l'évolution de l'univers considé-

ré comme un tout». Dans la seconde moitié du XXesiècle, une description phénoménologique et théo-

rique de l'histoire et de la géométrie de l'univers s'est peu à peu imposée, description fondée sur la théo-

rie de la Relativité générale : c’est la théorie du Big-Bang. Dès les premiers balbutiements des théories

cosmologiques, G. Gamow en 1948 avait prédit l'existence d'un rayonnement primordial. Hélas, il

annonçait aussi son indétectabilité ! Cela n’a pas empêché A. Penzias et R. Wilson de découvrir son exis-

tence en 1965 de manière fortuite (voir dans ce numéro «les très riches heures du CMB»). L'étude expé-

rimentale de ce rayonnement fossile constitue une source de contraintes sur le modèle du Big-Bang, en

particulier sur ses paramètres cosmologiques. Il est fondamentalement isotrope. Il présente cependant

des anisotropies résiduelles instructives quant aux modèles théoriques possibles. Leur étude est un des

objets majeurs des expériences Planck et Archeops auxquelles le LAL participe.

Illustration ima-

gée de l’expansion

de l’univers vue

comme le gonfle-

ment d’un cake.

Les «raisins»

(structures com-

pactes fortement

liées) s’éloignent

les uns des autres

du fait de la dilata-

tion d’échelle.

Cosmologie

ARCHEOPS ET PLANCK À L’ÉCOUTE

DU PREMIER CRI DE L’UNIVERS

Cosmologie

ARCHEOPS ET PLANCK À L’ÉCOUTE

DU PREMIER CRI DE L’UNIVERS

La composition chimique de l’univers

Même si on considère les objets les plus anciens, l'univers semble en gros composé d'un mélange d'hydro-

gène (environ 80 % en masse) et d'hélium (environ 20 % ), avec une proportion infime d'impuretés ... dont

nous sommes faits, soit dit en passant. L'origine des éléments chimiques a été l’un des points sensibles du

débat sur le Big-Bang (voir dans ce numéro «les très riches heures du CMB»). Une difficulté était de com-

prendre le mécanisme par lequel on pouvait expliquer l’abondance de l’hélium. On n’y parvint qu’en suppo-

sant qu’il a été fabriqué dans la phase primordiale de l'univers.

Le rayonnement de fond cosmologique

L'existence d'un rayonnement fossile est une preuve directe de l'existence d'un état dense et chaud au début

de l'histoire de l'univers. Ce rayonnement est le sujet central de cet article. Pour mieux comprendre son ori-

gine, nous allons commencer par un rapide survol de l'histoire de l'univers qui commence il y a 15 milliards

d'années…

Petite histoire de l’univers

1. On pense qu'au départ il y a une concentration colossale d'énergie. Dans ce milieu extrémement dense et

chaud, la densité et la température ont le comportement prédit par la mécanique quantique. En conséquence

elles présentent des fluctuations dans le temps et dans l'espace.

2. Sous l'effet d'un méca-

nisme dont on ne connaît pas

grand chose, appelé infla-

tion, l'univers subit une

expansion extrêmement bru-

tale. Ceci a pour effet de

«gommer» presque toute

trace de l'état précédent. En

10-30 secondes la taille de

l'univers augmente d'un fac-

teur environ 1050 ! Cela

signifie le gel des fluctua-

tions quantiques de sa densi-

té. Ainsi, ces fluctuations

engendrent de petites aniso-

tropies spatiales de densité.

L'univers après l'inflation

apparaît comme quasi uni-

forme et homogène, ce qu'il

est maintenant (à des

échelles suffisamment gran-

des).

3. L'univers va ensuite

suivre la dynamique décrite

par la Relativité générale: il

va se dilater lentement à la

manière d'un cake dans un

four, tout en se refroidissant.

À l'âge juvénile d'environ

10-30 seconde, l'univers est

composé d'une « soupe » où

nagent les particules élémen-

taires (quarks, antiquarks,

leptons,...). L'univers est tel-

page 4

Cosmologie

ARCHEOPS ET PLANCK À L’ÉCOUTE

DU PREMIER CRI DE L’UNIVERS

lement chaud que les particules plus complexes qui pourraient se former sont « cassées » dès leur apparition.

Au fur et à mesure de l'expansion et du refroidissement, cela va devenir de moins en moins vrai. En perma-

nence, particules et antiparticules s'annihilent et se recréent. Mais avec le refroidissement général, les annihi-

lations vont l'emporter. Cependant, le fait que seule la matière subsiste pourrait s’expliquer par un léger excès

de celle-ci sur l’antimatière dans la soupe initiale.

4. Au bout d'une seconde environ, une évolution considérable a lieu : des protons et des neutrons commen-

cent à pouvoir se former. Ceci est suivi, à partir de la seconde minute, par l'association de certains de ces

nucléons dans des noyaux légers comme l'hélium ou le lithium. C'est la phase de nucléosynthèse primordia-

le. Au bout d'un certain temps, l'univers se trouve donc composé de noyaux légers, d'électrons et de photons.

Les photons empêchent la formation des atomes : tout atome formé est immédiatement cassé, comme l'étaient

précédemment les noyaux.

5. L'univers poursuit son expansion pendant un «petit» moment, pendant lequel les densités des différents

constituants, et la température, diminuent régulièrement. Au bout de 300 000 ans environ, un bouleversement

intervient : la densité des photons n'est plus suffisante pour empêcher la formation des atomes. Les photons

étaient jusqu'alors incapables de se propager car très sensibles à la présence des particules chargées. Ils sont

maintenant libres de se propager partout dans l'univers, qui leur est transparent. C'est l'époque du découpla-

ge. Et c’est la naissance du rayonnement cosmologique.

6. L'expansion se poursuit ensuite jusqu'à nos jours. L'univers est maintenant dominé par un mélange d'hy-

drogène et d'hélium qui évolue sous l'effet de la gravitation : s'il existe une région de plus forte densité, la

matière qui s'y trouve va se contracter. Ainsi vont apparaître, progressivement, des structures de plus en plus

complexes dans l'univers. Des nuages de gaz, qui en se contractant encore, vont donner naissance aux pre-

mières galaxies, environ un milliard d'années après le début de l'histoire de l’univers.

7. Quelques 10 milliards d'années après la «naissance» de l'univers, quelque part dans une galaxie bien nor-

male, dans les mers d'une petite planète, la troisième d'« une petite étoile de proche banlieue », des choses

bien étranges commencent à se produire. Mais ceci est une autre histoire .

page 5

Les paramètres cosmologiques

●

Le modèle cosmologique évoqué possède un certain nombre de paramètres, parmi lesquels on peut mentionner : la « constan-

te » de Hubble (notée H0), qui est la valeur «actuelle» du taux d'expansion de l'univers. Ce taux peut varier pendant l'histoire de

l'univers.

●

la densité totale d'énergie de l'univers ; elle s’exprime par le

rapport

Ω

0de cette densité à une valeur critique qui (d’après la

Relativité générale) conférerait à l’univers une géométrie eucli-

dienne (ordinaire, plate), ce qui serait le cas si

Ω

0= 1.

Ω

0> 1 conduirait à une géométrie « fermée » (analogue à la géo-

métrie à deux dimension d’une surface sphérique, sur laquelle une

mouche marchant «droit» devant elle reviendrait à son point de

départ). Enfin

Ω

0<1 indiquerait une géométrie «ouverte» (illus-

trée par une surface en «selle de cheval»). Cette énergie présente

dans l’univers peut se décomposer en plusieurs parties :

❍

la densité de matière dans l'univers,

Ω

mqui se décompo-

se encore :

-la densité de matière «ordinaire», dite baryonique,

Ω

b

-la densité de matière «noire» (ou «cachée»),

Ω

CDM (invi-

sible directement mais déduite de l'observation de ses effets

gravitationnels)

❍

la constante «cosmologique», notée

Λ

; Einstein l’avait

ajoutée en écrivant les équations d'évolution de la géométrie de

l'univers. Sans elle l’univers aurait été soit en expansion soit en contraction, ce qu’Einstein ne pouvait imaginer.

Aujourd’hui cette constante est conservée pour des besoins théoriques :

Λ

s'apparente à une «densité d'énergie du vide».

Enfin certaines caractéristiques des fluctuations de densité issues de l'inflation (voir ci-après) sont aussi des paramètres

que l'on va chercher à mesurer en cosmologie, particulièrement avec le CMB.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

1

/

36

100%