Le client léger est un concept informatique. On a aujourd`hui une

Informatique

1

C

CO

OU

UR

RS

S

D

D’

’I

IN

NF

FO

OR

RM

MA

AT

TI

IQ

QU

UE

E

S

SC

CI

IE

EN

NC

CE

ES

S

P

PO

O

A

AI

IX

X

1

1E

ER

RE

E

A

AN

NN

NE

EE

E

Informatique

2

S

SO

OM

MM

MA

AI

IR

RE

E

C

CH

HA

AP

PI

IT

TR

RE

E

1

1

.............................................................................................................................................. 3

I

IN

NT

TR

RO

OD

DU

UC

CT

TI

IO

ON

N

A

A

L

LA

A

M

MA

AC

CH

HI

IN

NE

E

............................................................................................................. 3

I

I.

.

E

ET

TU

UD

DE

E

D

DE

E

L

LA

A

S

ST

TR

RU

UC

CT

TU

UR

RE

E

D

DE

ES

S

S

SY

YS

ST

TE

EM

ME

ES

S

I

IN

NF

FO

OR

RM

MA

AT

TI

IQ

QU

UE

ES

S

.......................................................................... 6

1

1)

)

O

OR

RG

GA

AN

NE

ES

S

D

D’

’E

EN

NT

TR

RE

EE

E

............................................................................................................................. 6

2

2)

)

L

LE

ES

S

O

OR

RG

GA

AN

NE

ES

S

D

DE

E

S

ST

TO

OC

CK

KA

AG

GE

E

................................................................................................................... 9

3

3)

)

L

LE

ES

S

O

OR

RG

GA

AN

NE

ES

S

D

DE

E

T

TR

RA

AI

IT

TE

EM

ME

EN

NT

T

.............................................................................................................. 18

4

4)

)

L

LE

ES

S

P

PO

OR

RT

TS

S

D

DE

E

C

CO

OM

MM

MU

UN

NI

IC

CA

AT

TI

IO

ON

N

........................................................................................................... 21

5

5)

)

L

LE

ES

S

O

OR

RG

GA

AN

NE

ES

S

D

DE

E

S

SO

OR

RT

TI

IE

ES

S

O

OU

U

P

PE

ER

RI

IP

PH

HE

ER

RI

IQ

QU

UE

ES

S

......................................................................................... 23

I

II

I.

.

L

LE

ES

S

P

PR

RO

OG

GR

RA

AM

MM

ME

ES

S

I

IN

NF

FO

OR

RM

MA

AT

TI

IQ

QU

UE

ES

S

..................................................................................................... 24

1

1)

)

L

LE

ES

S

D

DI

IF

FF

FE

ER

RE

EN

NT

TS

S

L

LO

OG

GI

IC

CI

IE

EL

LS

S

................................................................................................................... 24

2

2)

)

L

LE

ES

S

L

LA

AN

NG

GA

AG

GE

ES

S

D

DE

E

P

PR

RO

OG

GR

RA

AM

MM

MA

AT

TI

IO

ON

N

.................................................................................................... 26

3

3)

)

L

LE

ES

S

P

PR

RO

OG

GR

RA

AM

MM

ME

ES

S

D

D’

’A

AP

PP

PL

LI

IC

CA

AT

TI

IO

ON

N

........................................................................................................ 28

4

4)

)

L

LE

ES

S

V

VI

IR

RU

US

S

E

ET

T

A

AN

NT

TI

IV

VI

IR

RU

US

S

...................................................................................................................... 29

C

CH

HA

AP

PI

IT

TR

RE

E

2

2

............................................................................................................................................ 31

L

L’

’O

OR

RG

GA

AN

NI

IS

SA

AT

TI

IO

ON

N

D

DE

ES

S

S

SY

YS

ST

TE

EM

ME

ES

S

I

IN

NF

FO

OR

RM

MA

AT

TI

IQ

QU

UE

ES

S

........................................................................... 31

I

I.

.

L

LE

ES

S

T

TO

OP

PO

OL

LO

OG

GI

IE

ES

S

D

D’

’O

OR

RD

DI

IN

NA

AT

TE

EU

UR

R

.......................................................................................................... 31

1

1)

)

L

LE

ES

S

T

TO

OP

PO

OL

LO

OG

GI

IE

ES

S

P

PH

HY

YS

SI

IQ

QU

UE

ES

S

................................................................................................................. 32

2

2)

)

L

LE

ES

S

T

TO

OP

PO

OL

LO

OG

GI

IE

ES

S

L

LO

OG

GI

IQ

QU

UE

ES

S

.................................................................................................................. 34

Informatique

3

C

CH

HA

AP

PI

IT

TR

RE

E

1

1

I

IN

NT

TR

RO

OD

DU

UC

CT

TI

IO

ON

N

A

A

L

LA

A

M

MA

AC

CH

HI

IN

NE

E

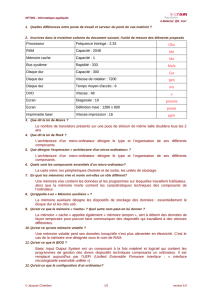

Un ordinateur est une machine de traitement automatique de l’information. Une polyvalence des

tâches est possible grâce aux logiciels informatiques. Il diffère ainsi d’une calculatrice par exemple

qui ne peut effectuer qu’une seule tâche à la fois, celle de calculer.

Ordinateur = Matériel + Logiciel (hardware + software) C’est un assemblage de circuits

électroniques et éléments électromagnétiques (ex : disque dur, lecteur CD, ventilateur etc.)

Ainsi, un ordinateur est un ensemble d’éléments électromagnétiques et de circuits électriques qui

grâce aux logiciels vont manipuler des données, les traiter sous forme binaire.

Les logiciels représentent l’ensemble des programmes, il y a plusieurs niveaux logiciels :

- 1er niveau : Les systèmes d’exploitation

- 2ème niveau : Les langages de programmation

- 3ème niveau : Les programmes d’application

Il existe plusieurs moyens de sécurité afin de préserver l’ordinateur d’une éventuelle panne ou

dysfonctionnement. Un ordinateur peut contenir plusieurs disques durs (notamment sur les

ordinateurs « sensibles »). Ainsi, si le disque dur tombe en panne, on bascule automatiquement sur

un autre disque dur afin de ne pas perdre les données et éviter la rupture du système. On appelle ces

ordinateurs des systèmes à tolérance de panne.

Sinon, on protège un système informatique grâce à un onduleur, qui alimentera le serveur en cas de

coupure de courant. Il est constitué de batteries. L’onduleur dure entre 10 et 30 min, afin de

permettre aux personnes d’arrêter proprement le système, qui ne subit pas de coupure brutale

(L’onduleur protège donc de la coupure brutale). Il est utilisé lorsque les systèmes sont « sensibles »

(ex : Air France).

Il existe deux catégories d’onduleur :

Les ON LINE : Le courant distribué par EDF (ou autre) passe dans l’onduleur dans tous les cas,

ce qui fait qu’en cas de panne, il n’y a aucune différence et l’ordinateur n’est pas « touché ».

Les OFF LINE : Ils sont moitié moins chers que les ON LINE. Ils sont bien moins performants

car ils ne repèrent pas toujours les microcoupures. C'est-à-dire que le courant distribué par

EDF ne passe pas dans l’onduleur, il n’y passe qu’en cas de panne et l’ordinateur subit les

microcoupures.

Informatique

4

Par suite, si la panne de courant est une panne prolongée, on a recours à des groupes électrogènes

qui fabriquent du courant et « remplacent » EDF. Dans tous les cas, ils interviennent suite à

l’onduleur, qui protège de la panne brutale.

Le dernier moyen de sécurité est la réplication du serveur (basculement vers un serveur de secours

en quelques secondes).

Il existe deux notions de compatibilité :

Compatibilité matérielle : elle consiste à pouvoir déplacer les éléments d’un ordinateur à

l’autre. Par exemple, Mac n’a pas de compatibilité matérielle avec d’autres ordinateurs, du fait

d’un coût de production élevé.

Compatibilité logicielle : elle n’est pas toujours possible. Un même logiciel n’est pas forcément

le même d’un ordinateur à l’autre (ex : Word pour Mac n’est pas compatible avec Word pour

HP). Pour que le logiciel soit compatible, il faut qu’il réponde aux critères du 1er niveau (=

système d’exploitation). Un programme va fonctionner sur un système mais pas sur un autre.

Par exemple, il existe une compatibilité entre Windows et Intel, le WINTEL, qui représente

actuellement plus de 90 % des PC. Le PC (Personal Computer) est lancé en 1981 par IBM. Jacques

Perret, à la demande d’IBM, décide d’appeler cette nouvelle machine « Computer » (ordinateur) qui

signifie calculateur et « Dieu mettant de l’ordre dans le monde ». L’ordinateur a très vite évolué grâce

aux interfaces et à la conception de nouveaux éléments matériels compatibles. Une interface est un

élément matériel que l’on ajoute entre les éléments pour qu’ils puissent communiquer et

fonctionner (ex : faire fonctionner un robot à l’aide d’un système informatique). L’entrée de données

se fait par le clavier. Puis le traitement est assuré par l’Unité Centrale. Enfin, le résultat se fait sur

l’écran ou sur une imprimante (selon si on a demandé l’impression).

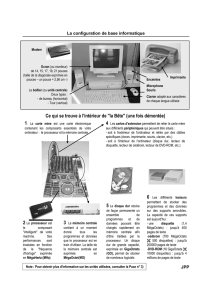

L’Unité Centrale comporte :

- Un processeur, qui exécute les programmes informatiques

- Une mémoire centrale, aussi appelée mémoire vive, mémoire de traitement ou RAM, qui

stocke les données en cours de traitement. De ce fait, elle n’a pas la fonction de stockage car

elle est conçue pour être extrêmement rapide afin d’enregistrer efficacement le traitement de

données. C’est donc une mémoire à très court terme, qui permet la modification ou la création

de données.

- Une mémoire de stockage, également nommée mémoire auxiliaire ou mémoire de masse.

Elle correspond au disque dur et stocke les données de l’ordinateur.

Les données sont regroupées dans des fichiers. Ceux-ci peuvent posséder différentes

extensions telles que .EXE, .DOC, .MP3, etc… Il existe deux catégories de fichiers :

Informatique

5

- Les fichiers exécutables, soit des fichiers programmes

- Les autres, c'est-à-dire, tout ce qui n’est pas exécutable, soit les fichiers de données, fichiers

d’information, fichiers structurés, etc…

.

Le processeur contenu dans l’Unité Centrale ne connait qu’un seul langage, le binaire de 0 et de 1 :

le Binary Digit (BT).

Bit : unité d’information exprimée en suite binaire (0,1) permettant de représenter toutes les

langues du monde

Ces unités servent à évaluer la capacité de stockage. On en arrive aujourd’hui aux Téraoctets (To) qui

représentent un billion d’octets. La mémoire vive évolue avec 1 à 5 Go alors que le disque de

stockage varie de quelques centaines de Go à 2 To. On peut supposer que les capacités de stockage

évolueront vers le Pétaoctet (Po). Dans un texte, la mise en page (saut de ligne, gras, alinéa)

augmente le poids du document. Les fichiers multimédia, très importants en taille, poussent les

constructeurs à augmenter les capacités de stockage.

Les taux de transfert de l’information sont souvent donnés en bit/s ou en kbit et Gbit/s. Il est aussi

possible d’utiliser l’octet/s et ses multiples pour mesurer les protocoles de transfert.

1 octet = 256 possibilités différentes

Le codage de l’information permet de communiquer selon chaque langage. En 1844, Samuel Morse

met au point un codage composé de tirets et de points. Emile Baudot (1845-1903) invente un code

dit « Baudot » fondé sur 5 bits, soit 32 caractères. Dans les années 50, l’Amérique met au point le

code ASCII (Code Standard Américain d’Echange d’Information), qui comporte 7 bits (128

caractères) avant d’évoluer en 8 bits (256 caractères). On va aujourd’hui vers un unicode qui, mis au

point en 1991, est codé sur 16 bits et permet de représenter n’importe quel caractère

indépendamment de tout langage d’exploitation et systèmes. Il est compatible avec le code ASCII. Il

évolue en version 32 bits (norme ISO 10 646) et devient mondial.

8 bits = 1 octet

1 kilo octet / 1 Ko = 𝟐𝟏𝟎 = 1024 octets

1 mega octet / 1 Mo = 𝟐𝟏𝟎 X 𝟐𝟏𝟎 = 1 048 576 octets

1 giga octet/ 1 Go = 210 X 210 X 210 = 1073 741 824

octets

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

1

/

35

100%