Arbres de décision

Introduction Classification supervis ´

ee par arbre de d´

ecision Algorithme d’apprentissage d’arbres de d ´

ecision

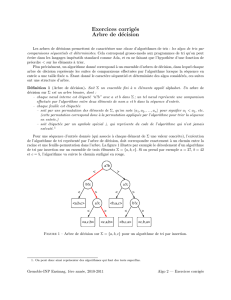

Les arbres de d´

ecision

Notations

Soient A1,...,Am: attributs binaires, n-aires, ou r´

eels. L’espace de

description est X=Qm

j=1Xjo`

uXjest le domaine de Aj.

D´

efinition d’un arbre de d´

ecision

Ensemble de r`

egles de classification basant leur d´

ecision sur des tests

associ´

es aux attributs, organis´

es de mani`

ere arborescente.

Introduction Classification supervis ´

ee par arbre de d´

ecision Algorithme d’apprentissage d’arbres de d ´

ecision

Les arbres de d´

ecision (cont’d)

Structure

•Noeuds internes (noeuds de d ´

ecision) : ´

etiquet´

es par des tests

applicables `

a toute description d’une instance. G´

en´

eralement, un noeud

interne = test sur un unique attribut.

•Arcs issus d’un noeud interne : r ´

eponses possibles au test du noeud.

•Feuilles de l’arbre : ´

etiquet´

ees par une classe.

•Chaque noeud interne ou feuille, est rep´

er´

e par sa position (liste des

num´

eros des arcs qui permettent d’y acc ´

eder en partant de la racine).

Arbre de d´

ecision et apprentissage

•Tout arbre de d´

ecision d´

efinit un classifieur

•Classifieur qui se traduit imm´

ediatement en terme de r `

egles de d´

ecision

Gros avantages des arbres de d´

ecision

1. D´

ecisions ais´

ement interpr´

etables,

2. classification tr`

es rapide.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

1

/

39

100%