projet de fouilles de donnees

!"#$%&#'!"#$!%&&%' ' '

()*+%,-''()%*'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

+$"'%*,-%,

."#/&&%0,-%,-"11%%0,

,

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

'

!&.#%/&#"#&*'0%+%/1'2)+'34'356)"#0'1(-/.''''''78+%$'9:;9'

' '

'

0"))(/$%,

'

'

+23456,/,7,%829:245;<,=6,>?@62<A,64,!(B,CCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCC,D'

!"#$%#&'(()%&)#*+,#-./0+1./),#1)/#%0+2)/#3)/#.%3.-.30/#/0,#0%#*1+%#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#4#

5"#$%#-./0+1./)#)%/0.6)#1)/#-,+.)/#&1+//)/#/0,#&)/#*1+%/#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#4#

4"#$%#+**1.70)#89()+%/#/0,#&:+70)#;+/)#&:'./.)#"""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#4#

<"#$%#-./0+1./)#1)/#&1+//)/#3)#1=+12',.6:()#89()+%/#/0,#0%#*1+%#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#<#

>"#?'(*+,+./'%#3)#1+#*+,6.6.'%#';6)%0)#+-)Y()+%/#)6#3)#1+#-,+.)#*+,6.6.'%#"""""""""""""""""""""""""""""""""""""""""""""""""""#<#

@"#$%#+**1.70)#0%)#&1+//.A.&+6.'%#+/&)%3+%6)#:.B,+,&:.70)#"""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#>#

C#D#E"#$%#-./0+1./)#1)/#+,;,)/#:.B,+,&:.70)/#';6)%0/#)6#'%#*,'*'/)#0%)#*+,6.6.'%#*'0,#&:+&0%#"""""""""""""""""""#>#

F"#$%#&'(*+,)#1+#*+,6.6.'%#';6)%0)#)6#1+#-,+.)#*+,6.6.'%#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#@#

!G"#?'(*+,+./'%#)%6,)#H9()+%/#)6#?IJ#"""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#C#

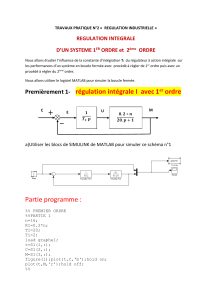

+23456,//,7,/<463E3F4245;<,=6A,G92AA6A,CCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCC,H'

K)0#3)#3'%%B)/#L.%)#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#E#

(+1.#&*)*%5&'0<'=#<'0#'05&&1#.'>%&#'4444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444'?#

!*<0#'0#'$)'0%.*+%@<*%5&'0#.'05&&1#.'>%&#'444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444'?#

7A('.<+'>%&#'44444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444';:#

BA(A'.<+'>%&#'44444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444';C#

7$/5+%*6"#'DE"#)&.'.<+'>%&#'4444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444';C#

K)0#3)#3'%%B)/#M"&'1.#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#!<#

(+1.#&*)*%5&'0<'=#<'0#'05&&1#.'!4,5$%'4444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444';F#

!*<0#'0#'$)'0%.*+%@<*%5&'0#.'05&&1#.'!4,5$%'44444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444';F#

7A('.<+'!4,5$%'44444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444';G#

BA(A'.<+'!4,5$%'44444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444';?#

7$/5+%*6"#'DE"#)&.'.<+'!4,5$%'4444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444444';?#

+23456,///,7,!92AA5I5G245;<,=2<A,92,J5;5<I;3@245K:6,CCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCC,LM'

!"#I**',6#3)#1+#&1+//.A.&+6.'%#3+%/#1)#3'(+.%)#3)/#3'%%B)/#;.'*0&)/#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#5G#

5"#I**1.&+6.'%#3)#89()+%/#)6#3)#1+#?IJ#"""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#5G#

4"#?'%/6,0&6.'%#3)/#(+6,.&)/#3)#&'%A0/.'%#"""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#5!#

(<<6N6,CCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCCC,LL'

N#O+,6.)#!#P#M-+10+6.'%/#89()+%/#)6#?IJ#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#55#

N#O+,6.)#5#P#Q%6),*,)6+6.'%#3)/#&1+//)/#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#5@#

N#O+,6.)#4#P#?1+//.A.&+6.'%#3+%/#1+#;.'9.%A',(+6.70)#""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""""#4G#

'

' '

R'6)#P#S'06)/#1)/#1.2%)/#3)#&'3)#/)#6,'0-)%6#)%#+%%)T)"#

+23456,/,7,%829:245;<,=6,>?@62<A,64,!(B,

'

H5<.' )85&.' ,65%.%' 0#' *+)8)%$$#+' .<+' $#.' C' 0)*).#*.' .<%8)&*' I' SU'V.+('%3/J' ?:+.%1.%H'#*' L.%2R064' K&'

.L%&*1+#..#')<M')8)&*)/#.' #*' )<M'01N)<*.'0#'2$<.%#<+.')$/5+%*6"#.' 0#',$)..%N%,)*%5&'I'DE"#)&.'#*'A7B'

OP)+0J'$%#&'"%&%"<"J'$%#&'")M%"<"J'$%#&'"5Q#&R4'

'

OC,"<,G;@@6<G6,E23,85A:295A63,96A,<:2P6A,=6A,5<=585=:A,A:3,:<,E92<,

,

,

'

• K&'8%.<)$%.#'0#<M'/+5<2#.'0L%&0%8%0<.'#&'N5+"#'0#'0%)")&*.'.<+'$#'&<)/#'0#'SU'V.+('%3/4'

• K&'0%.*%&/<#'0#<M'N5+"#.'+#,*)&/<$)%+#.'<&'2#<'0#&.#'2)+'#&0+5%*'.<+'$#'&<)/#'0#.'%&0%8%0<.'

0#'L.%2R064'

• K&'85%*'*+S.'&#**#"#&*'0#<M')&&#)<M'.<+'$#'&<)/#'0#.'%&0%8%0<.'0#'?:+.%1.%H4'

'

LC,"<,85A:295A6,6<A:546,96A,83256A,G92AA6A,A:3,G6A,E92<A,

'

'

'

• K&'8%.<)$%.#'@%#&'$#.'0#<M',$)..#.'#&'N5+"#'0#'0%)")&*.'0<'0)*).#*'SU'V.+('%3/4'

• K&'0%.*%&/<#'@%#&'$#.'0#<M',$)..#.'#&'N5+"#'+#,*)&/<$)%+#'0<'0)*).#*'L.%2R064'

• K&'85%*'*+S.'&#**#"#&*'0#<M',#+,$#.'.<+'$#'&<)/#'0#.'%&0%8%0<.'0<'0)*).#*'?:+.%1.%H4'

'

DC,"<,2EE95K:6,>?@62<A,A:3,GQ2K:6,J2A6,GQ;5A56,

'

TL)$/5+%*6"#'DE"#)&.',6#+,6#'U'0%"%&<#+'$L%&#+*%#'%&*+)E,$)..#'#*'U'")M%"%.#+'$L%&#+*%#'%&*#+E,$)..#4''

'

T#' 2+5@$S"#' 0#' $L)$/5+%*6"#' DE"#)&.' #.*' V<#' 0#.' %&%*%)$%.)*%5&.' 0%NN1+#&*#.' 2#<8#&*' "#&#+' U' 0#.'

,$<.*#+.' 0%NN1+#&*.' O2+5@$S"#' 0#.' "%&%").' $5,)<MR4'7%&.%J'25<+'5@*#&%+'0#.',$<.*#+.'.*)@$#.'OWN5+"#.'

N5+*#.XRJ'5&'#NN#,*<#'$L)$/5+%*6"#';:'N5%.'#*'5&'+#/+5<2#'$#.'%&0%8%0<.'V<%'.#'+#*+5<8#&*'*5<=5<+.'0)&.'$#'

"Y"#',$<.*#+4''

'

TL)$/5+%*6"#'-E"#)&.')'2)+*%*%5&&1'$#'=#<'0#'05&&1#.'#&'I'

E 9',$)..#.',5&*#&)&*',6),<&#'F::'%&0%8%0<.'25<+'$#'=#<'0#'05&&1#.'SU'V.+('%3/J'

E 9',$)..#.',5&*#&)&*'G:Z'#*'G:['%&0%8%0<.'25<+'$#'=#<'0#'05&&1#.'L.%2%06J'

E 9',$)..#.',5&*#&)&*'G:;'#*'FZZ'%&0%8%0<.'25<+'$#'=#<'0#'05&&1#.'?:+.%1.%H4'

WA$<.*#+' "#)&.X' %&0%V<#' $#.' 25.%*%5&.' 0#.' ,#&*+#.' 0#' ,6)V<#' ,$)..#4' (<%.' WA$<.*#+%&/' 8#,*5+X' #.*' <&'

8#,*#<+'V<%',5&*%#&*'$)',$)..#'2+10%*#')8#,'$L)$/5+*%6"#'DE"#)&.'0#',6)V<#'%&0%8%0<4'

T#' \9'#M2+%"#' $)' 2)+*' 0#' 8)+%)&,#' #M2$%V<1#' O+)225+*' 0#' $)' 8)+%)&,#' ' %&*#+E,$)..#.' #&*+#' $#.' ,#&*+#.'

25&01+1.'0#.',$)..#.'U'$)'8)+%)&,#'*5*)$#R'2)+'$)'2)+*%*%5&'#*'2#+"#*')%&.%'0L)22+1,%#+'$)'V<)$%*1'0#'$)'

2)+*%*%5&'/1&1+1#'2)+'$L)$/5+%*6"#'DE"#)&.4']$'#.*'1/)$#'U'I'

E [FJZ^'25<+'$#'=#<'0#'05&&1#.'SU'V.+('%3/J',#'V<%'#.*'.)*%.N)%.)&*J'

E G9JF^'25<+'$#'=#<'0#'05&&1#.'L.%2R06J',#'+1.<$*)*'&L#.*'2).'*+S.'.)*%.N)%.)&*J'

E F9JC^'25<+'$#'=#<'0#'05&&1#.'?:+.%1.%HJ',#'+1.<$*)*'&L#.*'2).'0<'.)*%.N)%.)&*4'

'

RC,"<,85A:295A6,96A,G92AA6A,=6,9S29P;354Q@6,>?@62<A,A:3,:<,E92<,

,

''

K&'85%*',%E0#..<.' V<#' 25<+'$#'0)*).#*'SU'V.+('%3/'$#.' ,$)..#.' .5&*' @%#&' N)%*#.' ")%.'25<+'$#' 0)*).#*'

L.%2R06J'@#)<,5<2'0L%&0%8%0<.'.5&*'")$',$)..1.4'!&',#'V<%',5&,#+&#'$#'0)*).#*'?:+.%1.%HJ'5&'2#<*'0%+#'

V<#'$L)$/5+%*6"#'-E"#)&.'&L#.*'2).'0<'*5<*')0)2*14'

,

TC,!;@E2325A;<,=6,92,E234545;<,;J46<:6,286G,>?@62<A,64,=6,92,83256,E234545;<,

'

H5<.',5&.*+<%.5&.'0#.'")*+%,#.'0#',5&N<.%5&'25<+'"#.<+#+'$)'V<)$%*1'0#'$L)$/5+%*6"#'-E"#)&.'.<+'&5.'

*+5%.'0)*).#*.4'

'

K- MEANS TwoDiamonds

K-means clustering with 2 clusters of

sizes 400, 400

Cluster means:

V2 V3

1 1.004370 0.004422253

2 3.084087 -0.002055800

Clustering vector:

1 2 3 4 5 6 7 8 9

1 1 1 1 1 1 1 1 1

[...]

793 794 795 796 797 798 799 800

2 2 2 2 2 2 2 2

Within cluster sum of squares by

cluster:

[1] 144.9399 144.3263

(between_SS / total_SS = 74.9 %)

'

K- MEANS WingNut

K-means clustering with 2 clusters of

sizes 509, 507

Cluster means:

V2 V3

1 0.9176798 1.053922

2 -0.9212998 1.947837

Clustering vector:

1 2 3 4 5 6 7 8 9

1 1 1 1 1 1 1 1 2

[...]

1011 1012 1013 1014 1015 1016

2 2 2 2 2 2

Within cluster sum of squares by

cluster:

[1] 484.6214 481.9787

(between_SS / total_SS = 52.4 %)

'

K- MEANS Chainlink

K-means clustering with 2 clusters of

sizes 501, 499

Cluster means:

V2 V3 V4

1 -0.016656 -0.294123 0.008488

2 0.000888 1.156772 -0.024356

Clustering vector:

1 2 3 4 5 6 7 8 9 10

1 1 2 2 1 2 2 1 1 1

[...]

994 995 996 997 998 999 1000

1 2 1 2 2 2 2

Within cluster sum of squares by

cluster:

[1] 334.9777 384.3083

(between_SS / total_SS = 42.3 %))

'

'

T#' +1.<$*)*' #.*' *+S.' .)*%.N)%.)&*'25<+' $)' ")*+%,#' 0#' ,5&N<.%5&' 0<' 0)*).#*' _P5' `%)"5&0.J' *5<.' $#.'

%&0%8%0<.'.5&*'@%#&',$)..1.4'

(5<+'$#'0)*).#*'L.%2R06J'$#'+1.<$*)*'#.*'"5Q#&&#"#&*'.)*%.N)%.)&*4'!&'#NN#*J'$)'")=5+%*1'0#.'%&0%8%0<.'

.5&*'@%#&',$)..1.'")%.'C['%&0%8%0<.'.5&*'")$',$)..1.',#'V<%'&L#.*'2).'&1/$%/#)@$#4'!&'#NN#*J'.<+'$#.'G:Z'

%&0%8%0<.'0#'$)' ,$)..#' ;J';Z'.#+5&*'#.*%"1.',5""#'1*)&*'0#'$)' ,$)..#' 9'#*'.<+'$#.'G:[' %&0%8%0<.'0#'$)'

,$)..#'9J';?'.#+5&*'#.*%"1.',5""#'1*)&*'0#'$)',$)..#';4'

!&N%&J'25<+'$#'0)*).#*#?:+.%1.%HJ'.<+'$#.'G:;'%&0%8%0<.'0#'$)',$)..#';J';[F'.#+5&*'#.*%"1.',5""#'1*)&*'

0#'$)',$)..#'9'#*'.<+'$#.'FZZ'%&0%8%0<.'0#'$)',$)..#'9J';[C'.#+5&*'#.*%"1.',5""#'1*)&*'0#'$)',$)..#';4'T#'

+1.<$*)*'&L#.*'2).'.)*%.N)%.)&*'0<'*5<*4'!&'#NN#*J'<&'*%#+.'0#.'%&0%8%0<.'.5&*'")$',$)..1.4'A#$)'#.*',561+#&*'

2)+'+)225+*')<M'/+)26#.'5a'$L5&'2#<*'8%.<)$%.#+'$#.',$)..#.'01*#+"%&1#.'2)+'$L)$/5+%*6"#'-E"#)&.4'

'

UC,"<,2EE95K:6,:<6,G92AA5I5G245;<,2AG6<=2<46,Q5F323GQ5K:6,286G,96,956<,@5<5@:@V,96,956<,

@2N5@:@V,96,956<,@;W6<,64,96,G354X36,=6,Y23=,

,

T#.')+@+#.'6%1+)+,6%V<#.'"#**#&*'#&'18%0#&,#'$#.'+#..#"@$)&,#.'#&*+#'$#.'%&0%8%0<.4'K&',5""#&,#'2)+'

,5&.*+<%+#'$#.'")*+%,#.'0#'0%..%"%$)+%*1.4'

'

Z,[,HC,"<,85A:295A6,96A,23J36A,Q5F323GQ5K:6A,;J46<:A,64,;<,E3;E;A6,:<6,E234545;<,E;:3,GQ2G:<,

,

A%E0#..5<.'$#.')+@+#.'6%1+)+,6%V<#.'0<'0)*).#*'SU'V.+('%3/'I'

'

'

'

K&'2#<*'85%+'V<L)8#,'$)'A7B' #NN#,*<1#')8#,'$#'$%#&'"%&%"<"'2+#.V<#'*5<.' $#.'%&0%8%0<.'.5&*'0)&.' $)'

"Y"#' ,$)..#',#' V<%' &L#.*' 2).' .)*%.N)%.)&*' 0<' *5<*4' T#.' A7B' #NN#,*<1#.' )8#,' $#' $%#&' ")M%"<"J' $#' $%#&'

"5Q#&'#*'$#',+%*S+#'0#'>)+0'5&*'$L)%+'0#'05&&#+'0#.'+1.<$*)*.'*+S.'.)*%.N)%.)&*4'K&'2#<*'"Y"#')=5<*#+'

V<L#&' <*%$%.)&*' $#' ,+%*S+#' 0#' >)+0J' $)' ,$)..%N%,)*%5&' .L#NN#,*<#' 2$<.' W8%*#X4'K&' .L%&*1+#..#' #&.<%*#' U'

L.%2%06#I'

'

'

MATRICE DE CONFUSION

TwoDiamonds

1 2

1 400 0

2 0 400

'

MATRICE DE CONFUSION

WingNut

1 2

1 490 18

2 19 489

'

MATRICE DE CONFUSION

Chainlink

1 2

1 327 173

2 174 326

'

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

1

/

31

100%