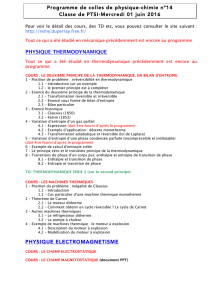

questions 2015

1TH - 1

Définir l’énergie cinétique et l’énergie potentielle et énoncer le principe de conservation

de l’énergie. Ce principe est-il violé lorsque l'énergie mécanique totale n'est pas conservée

(exemple : forces de frottement) ?

1TH - 2

Quel avantage présente un thermomètre à gaz parfait par rapport à un thermomètre à

mercure ?

Comparer les échelles de thermomètres utilisant un gaz parfait et un gaz de van der Waals.

Équation d'état d'un gaz de van der Waals :

( )

RTbv

v

a

p=−

+

2

1TH - 3

Justifier l’existence d’une température minimum. Introduire l’échelle de température

absolue et montrer comment elle se rattache à l’échelle de température légale (degrés

Celsius).

1TH - 4

Discuter le lien entre température absolue et énergie cinétique.

1TH - 5

En quoi la description d’un gaz par l’équation de van der Waals améliore-t-elle celle

donnée par l’équation des gaz parfaits ?

1TH - 6

Comment la chaleur spécifique d’un gaz réel assimilé à un gaz parfait dépend-elle de la

nature de ce gaz et des conditions dans lesquelles s’effectue le transfert de chaleur ?

1TH - 7

Définir : système, milieu extérieur, équilibre.

1TH - 8

Un système thermiquement isolé peut-il changer de température ? Illustrer par un

exemple.

1TH - 9

Discuter la différence entre transferts d’énergie sous forme de travail ou de chaleur, des

points de vue de la thermodynamique classique et de la mécanique statistique.

1TH - 10

Établir un parallèle entre les caractéristiques des transformations réversibles et des

transformations irréversibles.

1TH - 11

Décrire l’expérience de Joule (échauffement de l'eau d'un calorimètre par apport de

travail) et en déduire le premier principe de la thermodynamique.

1TH - 12

Montrer comment l’existence de l’énergie interne découle du premier principe de la

thermodynamique. Introduire la notion de fonction d’état.

1TH - 13

Le travail (W), la chaleur (Q) et l’énergie interne (U) sont-ils des fonctions d’état ?

Pourquoi ?

1TH - 14

Le mouvement perpétuel est-il compatible avec le premier principe de la

thermodynamique ? Illustrer par un exemple.

1TH - 15

Décrire l’expérience de Joule (détente libre d’un gaz parfait). Quelle conclusion tire-t-on

de cette expérience quant à l’énergie interne d’un gaz parfait ?

1TH - 16

Énoncer l’équation des adiabatiques réversibles d’un gaz parfait. Comparer le diagramme

de Clapeyron (représentation dans le plan (p, v)) de ces transformations avec celui des

isothermes.

1TH - 17

Donner deux énoncés du second principe de la thermodynamique (Kelvin et Clausius).

Montrer qu’ils sont équivalents.

1TH - 18

Définir l’énergie libre. Comment le travail fourni ou reçu au cours d’une transformation

monotherme réelle se compare-t-il à la variation d’énergie libre correspondant à la même

transformation ?

1TH - 19

Énoncer l’énoncé du second principe de la thermodynamique pour une machine ditherme

(énoncé de Carnot).

1TH - 20

Décrire le cycle (moteur) de Carnot, dans le cas où l’agent qui subit la transformation est

un gaz parfait. Donner la définition du rendement, et en donner l'expression en termes

d’échange de chaleur (Q

1

et Q

2

) ou de température des thermostats (T

1

et T

2

).

1TH - 21

Montrer que le rendement d’une machine ditherme réversible est indépendant de la nature

de l’agent qui subit la transformation.

1TH - 22

Montrer que le rendement d’une machine ditherme irréversible est toujours inférieur à

celui d’une machine ditherme réversible.

1TH - 23

Montrer que le rendement d’une pompe à chaleur irréversible est toujours inférieur à celui

d’une pompe à chaleur réversible.

1TH - 24

Montrer que le rendement d’un réfrigérateur irréversible est toujours inférieur à celui d’un

réfrigérateur réversible.

1TH - 25

Énoncer le théorème de Clausius pour une machine qui, au cours d’un cycle, échange de

la chaleur avec n thermostats. Comparer les cas réversibles et irréversibles.

1TH - 26

À partir du théorème de Clausius, introduire la notion d'entropie. Énoncer le lien existant

entre l'entropie, l'énergie interne et l'énergie libre.

2TH - 27

Définir potentiel et entropie d’information. Donner l’expression de ces grandeurs pour un

message composé de symboles équiprobables, émis par une source sans mémoire.

2TH - 28

Définir potentiel et entropie d’information. Donner l’expression de ces grandeurs pour un

message composé de symboles ayant des probabilités d’apparition différentes, émis par

une source sans mémoire.

2TH - 29

Définir la vitesse de transmission (le débit), la capacité temporelle et la capacité en

information d’un canal de transmission ; expliquer quel lien existe entre ces grandeurs.

2TH - 30

Dans quelles conditions l’entropie d’information d’un message atteint-elle sa valeur

maximale ?

2TH - 31

Pourquoi la formule de Shannon H = - Σ

i

p

i

log p

i

surestime-t-elle l’entropie d’information

d’un langage naturel (par exemple le français) ?

2TH - 32

Dans le cas d’une transmission avec bruit par un canal discret et constant, où les symboles

émis par une source sans mémoire sont choisis dans X = {x

1

…x

m

} et ceux issus du canal

sont choisis dans Y = {y

1

…y

n

}, on rencontre les relations

H(X) ≤ H(X,Y)

H(Y) ≤ H(X,Y)

H(X,Y) ≤ H(X) + H(Y).

Expliquer ce qu’elles signifient et indiquer dans quelles conditions il y a égalité.

2TH - 33

Dans le cas d’une transmission avec bruit, où les symboles émis par une source sans

mémoire sont choisis dans X = {x

1

…x

m

} et ceux issus du canal (discret et constant)

proviennent de Y = {y

1

…y

n

}, on rencontre la relation

H(X,Y) ≤ H(X) + H(Y)

Commenter cette relation.

2TH - 34

Une source sans mémoire émet un message transmis imparfaitement en raison de la

présence de bruit (le canal de transmission est discret et constant). Pour décrire cette

situation, on introduit l’équivocation qui obéit aux inégalités

0 ≤ H(X/Y) ≤ H(X)

où X désigne l'alphabet du message issu de la source et Y celui du message transmis par le

canal.

Expliquer la signification de cet énoncé. Dans quelles conditions a-t-on H(X/Y) = 0 ?

Dans quelles conditions a-t-on H(X/Y) = H(X) ?

2TH - 35

L’expression de Shannon pour l’entropie d’information,

H = -Σ p

i

log p

i

est la seule à présenter simultanément un certain nombre de propriétés. Lesquelles ?

2TH - 36

Une source émet des symboles choisis parmi X = {x

1

…x

N

}, qu’un codeur transforme en

chaînes de caractères choisis parmi U = {u

1

…u

r

}. Donner l’expression de l’efficacité du

codeur et en déduire une borne inférieure pour la longueur moyenne des chaînes.

2TH - 37

Une source émet des symboles choisis parmi X = {x

1

…x

N

}, qu’un codeur transforme en

chaînes de caractères choisis parmi U = {u

1

…u

D

}. Si le codage est uniforme, dans quelles

conditions son efficacité sera-t-elle égale à 1 ?

2TH - 38

Définir : codage uniforme, codage séparable, codage instantané. Énoncer et discuter la

relation de MacMillan et Kraft.

2TH - 39

Quand dit-on qu'un codage instantané est complet ? Quelle est la condition nécessaire et

suffisante pour que ce soit le cas ?

2TH - 40

Quand dit-on qu'un codage est absolument optimal ? Quelle est la condition nécessaire et

suffisante pour que ce soit le cas ?

2TH - 41

Énoncer et discuter le théorème de Shannon pour un codage sans bruit.

2TH - 42

Énoncer et discuter le théorème de Shannon pour un codage avec bruit.

2TH - 43

Montrer que, dans le cas d'une source sans mémoire, le code optimal pour une extension

donnée jouit de la propriété suivante :

(

)

(

)

0

i j i j

p p n n

− − ≤

1EX – 44

Un parachutiste (100 kg) parcourt les 100 derniers mètres de sa descente à une vitesse

constante de 10 m/s (les forces qui agissent sur le parachutiste sont son poids et la

résistance de l'air). Calculer la résistance de l'air, la puissance de cette force ainsi que

l'énergie cinétique du parachutiste à 100 m d'altitude et à l'atterrissage. On remarque que

l'énergie mécanique totale n'est pas conservée. Pourquoi ?

1EX – 45

On verse dans un thermos 1 l d'eau à 10 °C et 0.5 l d'eau à 90 °C puis on le referme.

Quelle sera la température finale du mélange ?

1EX – 46

À pression et à température ambiantes (105 Pa, 300 K), 1 kg d'air occupe un volume de

0,77 m3. Quel volume occupera cette quantité d'air, que l’on considère comme un gaz

parfait, si on en porte la température à 100 °C en gardant une pression constante ?

1EX – 47

On met en contact thermique deux enceintes rigides contenant l'une une mole d'oxygène

(O2) à 300 K et l'autre une mole de néon (Ne) à 400 K, l'ensemble étant isolé du monde

extérieur. Quelle sera la température finale de ce système ? Quelle quantité de chaleur

auront échangée les deux constituants du système ?

On donne : v

c

~

(Ne) = 3 cal/(mol K), v

c

~

(O2) = 5 cal/(mol K).

1EX – 48

L’arbre à palettes d’un calorimètre utilisé dans l’expérience de Joule est actionné par une

machine cyclique ditherme réversible. Sachant que le calorimètre contient un litre d’eau

dont chaque cycle de la machine élève la température de 0.6°C, que les deux thermostats

de la machine sont à des températures respectives de 20°C et 400°C, calculer quelle

quantité de chaleur la machine échange avec chacune des sources.

L’ensemble du processus est-il réversible ?

2EX – 49

On dispose de 9 pièces de monnaie dont une exactement est trop lourde. Déterminer

laquelle, en 2 pesées. Indiquer en quoi la méthode que vous suivez maximise

l’information extraite au cours de chaque pesée.

6

6

1

/

6

100%