Apprentissage et Mémoires - Introduction aux réseaux de

Apprentissage et Mémoires

Introduction aux réseaux de neurones artificiels

Yann Boniface, Nicolas P. Rougier

Master 1 - Sciences Cognitives

Université De Lorraine

Janvier 2012

Apprentissage et Mémoires

Introduction aux réseaux de neurones artificiels

•Introduction

•Le neurone formel

•Apprentissage supervisé

•Le perceptron simple

•Le perceptron multicouche

•Apprentissage non-supervisé

•Carte auto-organisatrices

•Modèle de Hopfield

•Dilemne stabilité-plasticité

•Théorie de la Résonance Adaptative

•Temporalité et réseau récurrent

•Modèle de Jordan

•Modèle de Elman

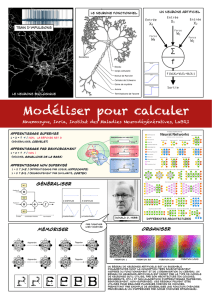

Le cerveau humain

•Nombre de neurones dans le

cerveau humain : 100 milliards

•Nombre moyen de connexions par

neurone : 10 000

•1mm3de cortex contient un 1

milliard de connexions

Le cortex cérébral

Structure topographique

•Lobe Frontal

•Lobe Occipital

•Lobe Pariétal

•Lobe Temporale

Structure modulaire

•Aires sensorielles (V1, A1, etc.)

•Aires motrices (M1, SM1, etc.)

•Aires associatives

L

o

b

e

F

r

o

n

t

a

l

L

o

b

e

t

e

m

p

o

r

a

l

L

o

b

e

O

c

c

i

p

i

t

a

l

L

o

b

e

P

a

r

i

é

t

a

l

Le cortex cérébral

Structure laminaire

•Couche moléculaire I

•Couche granulaire externe II

•Couche pyramidale externe

•Couche granulaire interne

•Couche pyramidale interne

•Couche polymorphe

Structure régulières

•Minicolonnes

•Maxicolonnes

•Modules corticaux

Santiago Ramon y Cajal (1852-1934)

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

1

/

29

100%