Chapitre 3 : La perception des sons de l`environnement, une

Chapitre 3

: La perception des sons de l’environnement, une revue de la littérature

95

Chapitre 3: La perception des sons de l’environnement, une

revue de la littérature

Les deux premiers chapitres posent le contexte théorique, le Chapitre 1 sur la mémoire

situe l’objectif, le Chapitre 2 sur l’amorçage fourni l’outil pour l’étudier. L’objectif de ce

troisième chapitre est de présenter le matériau que nous utiliserons pour étudier l’organisation

de la mémoire sémantique. Avant de continuer plus avant une définition, un peu plus

formelle, des sons de l’environnement, ou tout du moins de ce que nous considérerons, nous,

comme tel, s’impose.

Qu’est-ce qu’un son de l’environnement?

L'un des premiers travaux du domaine (Vanderveer, 1979) propose plusieurs critères

pour définir les sons de l'environnement :

i-Ils sont produits par des événements réels.

ii-Ils ont une signification donnée par les événements qui les produisent.

iii-Ils sont beaucoup plus compliqués que les sons simulés en laboratoire comme les

sons purs.

iv-Ils ne font pas partie d'un système de communication comme le langage.

Quelques années plus tard, Ballas et Howard (1987) apportent quelques modifications

à cette première définition. Ces stimulations ne sont clairement, ni du langage, ni de la

musique, mais ce type de définition par exclusion les renvoie à un plan secondaire. Ils

proposent de conserver uniquement les deux premiers critères proposés par Vanderveer, les

deux derniers étant exclusifs. Les avantages de garder uniquement ces critères seraient

Chapitre 3

: La perception des sons de l’environnement, une revue de la littérature

96

nombreux selon eux. Premièrement, ils sont consistants avec les notions intuitives sur la

nature des sons de l'environnement. Deuxièmement, ils demandent la spécification exacte de

la source qui produit le son, encourageant de fait la rigueur scientifique. Troisièmement, ces

critères impliquent que la fonction de la perception est de reconnaître les événements et non

pas simplement de traiter le signal acoustique. Finalement, ces deux critères rapprochent les

sons de l'environnement du langage, en gardant en tête que la signification des mots repose

sur des conventions sociales.

Comme nous pouvons le voir définir les sons de l'environnement n'est pas chose aisée,

nous garderons la définition proposée par Ballas et Howard (1987). Un son de

l'environnement est produit par un événement réel et a du sens en vertu de sa relation causale

à cet événement, mais contraste avec les conventions sociales définissant la signification des

mots.

Au même titre que le langage ou les images, les sons de l’environnement véhiculent

du sens. Cette caractéristique les rend très intéressants pour notre propos, l’organisation de

notre mémoire sémantique. En premier lieu, comment un son de l’environnement est-il

capable d’activer des connaissances sémantiques? Si un tel accès est possible, comment ces

connaissances sont-elles organisées en mémoire? Nous avons vu à travers les deux premiers

chapitres l’évolution des recherches et les débats engendrés par l’étude des objets visuels.

Nous pouvons à priori répondre par l’affirmative à la première question pour les images

(Bowers et al., 1999), les arguments expérimentaux restant cependant rares. Nous détaillerons

un certain nombre d’études comportementales ayant pour objets les sons de l’environnement

(Ballas, 1993; Van Petten & Rheinfelder, 1995), suggérant un accès à des structures de

connaissances abstraites, mais n’offrant pas une vue globale du phénomène observé. Nous

verrons également des études d’imagerie cérébrale, de neuropsychologie et

Chapitre 3

: La perception des sons de l’environnement, une revue de la littérature

97

d’électrophysiologie qui s’intéressent aux traitements sémantiques du langage et des sons de

l’environnement (Bozeat et al., 2000; Clarke et al., 1996, 2000; Lebrun et al., 1998, 2001;

Plante, Van Petten, & Senkfor, 2000). Les données de ces études ne sont pas convergentes,

suggérant ou non une dissociation des structures impliquées pour le traitement sémantique des

sons de l’environnement. Dans un premier temps, nous essaierons de comprendre, si comme

pour les images, les sons peuvent activer directement des connaissances en mémoire

sémantique. Avant de pouvoir répondre à cette question, il semble judicieux de présenter

quelques études relatives au matériel que nous utiliserons. L’objectif de ce chapitre sera de

situer les sons de l’environnement dans les recherches actuelles, plus particulièrement la

relation qu’ils entretiennent avec le sens qu’ils véhiculent.

1 Processus de traitement de l’information auditive

L’objectif de cette thèse est dans un premier temps de déterminer si un son de

l’environnement est capable d’activer des structures de connaissances abstraites en mémoire

sémantique. Nous ne cherchons pas à étudier les déterminants acoustiques qui permettent de

savoir si le son entendu est un aboiement de chien ou non, ni même les différences entre

l’aboiement d’un doberman et celui d’un teckel, nous voulons étudier les activations des

représentations de connaissances abstraites associées au concept «chien», par le biais d’un

son de l’environnement, si elles existent. L’étude des processus de traitements perceptifs qui

amènent à l’identification d’un son dépasse largement le cadre de ce manuscrit (voir,

McAdams & Bigand, 1993; Moore, 2003, pour une revue). Néanmoins, nous présenterons

rapidement les principales étapes perceptives nécessaires à l’identification d’un son (voir,

Ballas, 1993; Gygi, 2001, pour une revue sur les sons de l’environnement).

Chapitre 3

: La perception des sons de l’environnement, une revue de la littérature

98

«

In everyday life, the sound reaching our ears generally arises from a number of

different sound sources. The auditory system is usually able to parse the acoustic input, so

that the components deriving from each source are grouped together and form part of a

single perceptual stream. Thus each source may be ascribed its own pitch, timbre, loudness,

and location, and sometimes source may be identified as familiar. The identification of a

particular sound source depends on the recognition of its timbre.» (Moore, 2003, p.296-7).

Le propos de Moore (2003) nous intéresse particulièrement et marque la frontière de

notre recherche. Que se passe-t-il une fois qu’un ensemble de caractéristique acoustiques

correspondant à un son de l’environnement est perçu? Question ambitieuse s’il en est, qui

nous conduit directement au cœur de notre problématique. McAdams et Bigand (1993)

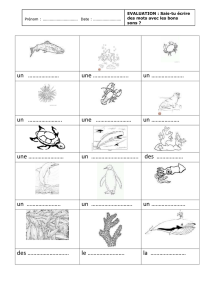

propose un schéma qui résume les principaux processus de traitement de l’information

auditive et leurs interactions (Figure 3.1). Nous détaillerons certaines de ces étapes de

traitement.

Figure 3.1: Principaux processus de traitement de l’information auditive et leurs interactions, figure

adaptée de McAdams et Bigand (1993).

Chapitre 3

: La perception des sons de l’environnement, une revue de la littérature

99

La transduction

Le processus de transduction consiste, dans le cas de l’audition, par la transformation

d’un signal mécanique engendré par le son, en un message nerveux utilisable par notre

système nerveux central. Pour plus de détails, nous renvoyons le lecteur au premier chapitre

de l’ouvrage de Moore (2003) qui explique brillamment les étapes conduisant à transformer

un son en signal nerveux (voir aussi, Delorme & Flückiger, 2003).

Processus de groupement auditif

Ces processus sont mis en jeu lors de l’analyse de scène auditive (Bregman, 1990).

L’être humain est capable dans un environnement sonore, d’une part de séparer les sons émis

par différentes sources (ségrégation), et d’autre part de réunir toutes les composantes

(fréquentielles par exemple) issues d’une même source (fusion). Ces processus renvoient

directement à une partie de la citation de Moore proposée quelques lignes plus haut: «The

auditory system is usually able to parse the acoustic input, so that the components deriving

from each source are grouped together and form part of a single perceptual stream.» (voir

Bregman, 1990, pour une revue).

Extraction ou calcul des propriétés ou attributs perceptifs

Cette extraction correspond à la deuxième partie de la citation empruntée à Brian

Moore: «Thus each source may be ascribed its own pitch, timbre, loudness, and location,

and sometimes source may be identified as familiar. The identification of a particular sound

source depends on the recognition of its timbre.». Après la ségrégation et la fusion des

différents événements sonores par les processus de groupement auditif, chaque événement

pourra être analysé selon différents attributs perceptifs (durée, intensité, hauteur, timbre...).

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

1

/

69

100%