La philosophie de l`expérience - Tracés. Revue de Sciences humaines

La philosophie de l’expérience :

illustrations de l’ultrafroid *

Ian Hacking, Collège de France

Je présente ici un exemple contemporain de science « en action » – selon l’expression

de Bruno Latour – pour illustrer certains thèmes importants de la philosophie des

sciences. Quelques-unes des questions philosophiques sont familières, quelques-

unes peut-être sont nouvelles. Mon propos sera un peu déséquilibré, dans la mesure

où je dois consacrer une proportion assez importante de ma présentation à donner

certaines explications simples sur une science assez nouvelle et très complexe. La

deuxième partie, l’analyse philosophique, ne fait donc qu’esquisser quelques idées

et suggestions.

Du contexte physique…

Des expériences sur le plateau d’une table

Dans la deuxième partie de mon livre Concevoir et expérimenter, j’appelais les phi-

losophes des sciences à étudier les expériences scientifiques 1. La version originale

de ce livre, Representing and Intervening, est parue en 1983, il y a plus de vingt ans.

À cette époque tous les grands auteurs répétaient que la science, c’est la théorie.

Popper affirmait que « la théorie commande le travail expérimental de sa conception

aux derniers maniements en laboratoire ». Il a écrit cela dans la première édition

de la Logik der Forschung (1934), et il l’a redit cinquante ans plus tard 2. omas

Kuhn, Bas van Fraassen et d’autres, ont eu la même attitude. Van Fraassen écrivait

dans son livre de 1980, L’image scientifique – et il le répète avec constance dans les

1. Concevoir et expérimenter, Paris, Christian Bourgeois, 1989. Traduction française de Representing and

Intervening, Cambridge University Press, 1983.

2. Karl Popper, La Logique de la découverte scientifique, Paris, Payot, 1973, p. 107.

Revue Tracés n° 11 – 2006 / 1 – p. 195-228

* N.D.R. : il s’agit du texte de la conférence prononcée par Ian Hacking à l’ENS LSH, le 22 novembre

2005. Ian Hacking avait été invité par Tracés, à l’occasion de la parution du n° 9, « Expérimenter ».

R T n° 11 – 2006 / 1

196

ouvrages plus récents 3 : « L’expérience, c’est la continuation de la théorie par d’autres

moyens. » Il n’y avait alors qu’un livre, un seul livre, où l’on trouvait une étude sur

le laboratoire : c’est le livre de Bruno Latour et Steve Woolgar, Laboratory Life: e

Social Construction of Scientific Facts, publié en anglais en 1979, mais qui n’a été

traduit en français qu’en 1988 4.

Les temps changent. Je suis très heureux que la revue Tracés ait traduit dans un

précédent numéro

* mon intervention de 1988 à la réunion biennale de la Philosophy

of Science Association 5. à cette date, on avait déjà des œuvres magistrales d’auteurs tels

que Steven Shapin et Simon Shaffer 6 Peter Galison 7, et cætera. J’ai peu écrit sur la

physique et l’expérimentation depuis vingt ans. Je considérais que j’avais dit ce qu’il

fallait dire en 1983, et je me suis tourné vers d’autres sujets. Cette année mon intérêt

s’est ranimé, après un cours donné au Collège de France par Sandro Stringari, un

physicien italien de l’université de Trente. Stringari est un théoricien, mais très proche

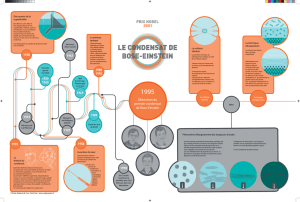

de l’expérience. Il traitait de la condensation de Bose-Einstein, un sujet qui me fas-

cine. Je dois signaler certaines différences entre mes exemples d’aujourd’hui et ceux

de la science qui avait cours à l’époque de la rédaction de Concevoir et expérimenter.

La plupart des exemples datant d’avant 1983 relèvent de la big science, la « grande

science ». J’habitais près du SLAC, le Stanford Linear Accelerator, et plusieurs de

mes proches étaient des physiciens des hautes énergies. Quelques années plus tard,

j’ai organisé à Toronto une conférence sur le thème : des expériences sur une table. La

« petite » science, si vous voulez. Les expériences que je décrirai aujourd’hui sont

vraiment petites.

3. Bas van Fraassen, e Scientific Image, Oxford, Clarendon, 1980. Laws and Symmetry, Oxford,

Clarendon, 1989, trad. fr. Lois et symétrie, Paris, Vrin, 1994. e Empirical Stance, New Haven, Yale

Univesity Press, 2002.

4. Bruno Latour et Steve Woolgar, Laboratory Life: e Social Construction of Scientific Facts, Los Angeles

et Londres, Sage, 1979, trad. fr. La vie de laboratoire, Paris, La Découverte, 1988. La deuxième

édition anglaise a supprimé l’adjectif « social » du titre, au motif que tout est social ; l’adjectif est

ainsi superflu.

5. « Philosophers of Experiment », PSA 1988, Vol. 2 (Evanston, Illinois, 1989), p. 147-155, trad. fr.

« Philosophes de l’expérience », Tracés, n° 9, novembre 2005.

6. Steven Shapin et Simon Schaffer, Leviathan and the Air Pump: Hobbes, Boyle and the Experimental

Life. Including a translation of omas Hobbes, Dialogus Physicus de natura aeris by Simon Schaffer,

Princeton, Princeton University Press, 1985. Trad. fr. Leviathan et la pompe à air. Hobbes et Boyle

entre science et politique, Paris, La Découverte, 1998. Noter la différence entre le sous-titre français et

le sous-titre anglais ; de plus, la version française n’inclut pas le texte de Hobbes.

7. Peter Galison, Ainsi s’achèvent les expériences. La place des expériences dans la physique du xx

e siècle, Éd.

la Découverte, 2002. Article original : How Experiments End, Chicago, University of Chicago Press,

1987.

* N.D.R. : voir Tracés n° 9, « Expérimenter » ; Hacking I., « Les philosophes de l’expérience », traduit

par Marc Lenormand et Anthony Manicki.

197

Les équipes du SLAC ou du CERN sont énormes. Pour prendre un exemple, à

Stanford, je me suis intéressé au projet « Gravity Probe B », commencé depuis bientôt

trente ans. Les responsables de ce projet sont en train de mener une expérience

réalisée dans un laboratoire spatial, qui vise à mettre à l’épreuve la théorie générale

de la relativité. Le physicien qui est à la tête du projet, Francis Everitt, a collaboré à

plusieurs sections de Concevoir et expérimenter (qui sont signalées par un « E »). Dans

la publicité de GP-B on lit : « Plus de 400 physiciens, plus de 2100 ingénieurs, des

milliers d’étudiants… »

Voilà le milieu dans lequel je travaillais il y a 25 ans. En comparaison, celui qui

m’intéresse aujourd’hui est tout petit. Une équipe travaillant sur les condensats de

Bose-Einstein ne comporte généralement pas plus de six personnes : le directeur,

deux post-docs, deux doctorants, et un ou deux étudiants de deuxième cycle. Une

partie essentielle de l’expérience est conduite littéralement sur une table, une table

à laser, mesurant 2 mètres sur trois 8. Le piège à atomes et quelques autres appareils

sont disposés sur une autre table. Il y a aussi une petite table pour les ordinateurs,

quelques papiers, et des tasses de café.

Nous sommes peut-être revenus à l’ère de la table. Le professeur Gérard Mourou

est un physicien des lasers qui a travaillé de nombreuses années aux États-Unis et

est revenu en France, au Laboratoire d’optique appliquée de Palaiseau. Voici un

article qu’il a publié il y a sept ans : « Les lasers à ultra-haute intensité : la physique

de l’extrême sur un plateau de table. » 9 Le 25 novembre 2005, Gérard Mourou a

donné une conférence à l’école normale supérieure de Paris : « Lumière extrême :

optique relativiste et ses applications. » Il a parlé d’une « montée spectaculaire de la

puissance et de l’intensité des lasers ». Sur une table, on peut produire des champs

et des énergies comparables aux énergies obtenues au CERN, pendant un très court

laps de temps.

Il y a une différence plus profonde entre mon sujet d’aujourd’hui et mes exemples

des années passées. Je vais parler de la condensation de Bose-Einstein, qui est liée

à la supraconductivité, et qui est liée aussi à la superfluidité, le phénomène qui

l’accompagne dans les plus basses températures. Autrement dit, je parlerai essentiel-

lement de ce qu’on appelle aujourd’hui la physique de la matière condensée, et qu’on

appelait autrefois la physique des solides. Les physiciens de la matière condensée

ont traditionnellement une perspective très différente de celle des physiciens des

8. Mais plus grandes que les tables décrites par Eric Cornell, quand il a rencontré Carl Wiemann (les

deux physiciens qui ont produit les premiers condensats de Bose-Einstein en 1995). « In contrast

to the other laser cooling experiments I had seen, which took up the better part of a room, Carl’s

experiment could have fit on a card table. » (Eric A. Cornell, Nobel Lecture, 2001)

9. Gérard Mourou, « Ultrahigh-intensity lasers: Physics of the Extreme on the Tabletop », Physics

Today, January 1998, p. 22-28.

La philosophie de l’expérience : illustrations de l’ultrafroid

R T n° 11 – 2006 / 1

198

hautes énergies. En particulier, ces derniers sont généralement « réductionnistes ».

Les physiciens dont je parle aujourd’hui ont tendance à avoir une position très diffé-

rente. Je regrette de ne pas avoir le temps de discuter ici de cet anti-réductionnisme.

Sa formulation classique est celle de Philip Anderson : more is different, « Plus est

différent » 10.

Le vide et le zéro : des indices de la réalité ?

Une remarque très brève et tout à fait spéculative. Je parle de températures très

proches du zéro absolu. Selon l’idée vulgaire, au zéro absolu, les particules n’ont

plus d’énergie, elles sont immobiles et rien ne se passe – et le vide est vraiment vide,

sans matière, sans énergie, sans rien. En effet, au e siècle, dans les débats sur les

atomes et le vide, les partisans de la théorie corpusculaire pensaient que le vide était

vraiment sans contenu. Descartes, de son côté, en doute. Ce n’est plus le cas depuis

le début du e siècle. Je cite les deux premières phrases d’un manuel bien connu

de Peter Milonni, Le Vide Quantique : « Dans les conceptions contemporaines, il

n’y a pas de vide au sens ordinaire d’un paisible néant. À la place, il y a un vide

quantique uctuant. » 11 Dans la même page, Milonni cite une remarque de P. C.

Davies adressée au grand public. Davies est un physicien qui a un penchant pour

les déclarations extrêmes : « Le vide renferme la clé d’une compréhension complète

des forces de la nature. » 12

Milonni ajoute que : « La conception moderne du vide est étroitement liée à

l’idée d’énergie du point zéro, l’énergie associée au mouvement persistant même à

une température atteignant le zéro absolu, où tout mouvement cesse, dans la vision

classique. » 13

Je voudrais sauter, pour une minute, de la physique d’aujourd’hui au monde

ancien. Pierre Hadot dans un merveilleux livre intitulé Le Voile d’Isis 14, retrace

10. Philip Anderson, « More is different. Broken Symmetry and the nature of the hierarchical structure

of science », Science, 177 (1972), p. 393-396. C’est à Anderson que nous devons le changement de

nomenclature de la physique des solides, qui devient « physique de la matière condensée ». Ce chan-

gement traduit une modification de la conception du sujet.

11. Peter W. Milonni, e Quantum Vacuum: An Introduction to Quantum Electrodynamics, Boston,

Academic Press Inc, 1997. « According to present ideas there is no vacuum in the ordinary sense of

tranquil nothingness. ere is instead a fluctuating quantum vacuum », p. .

12. P. C. W. Davies, Superforce, New York : Simon and Schuster, 1985. Trad. fr. Superforce : recherches

pour une théorie unifiée de l’univers, Paris, Payot, 1987. « e vacuum holds the key to a full unders-

tanding of the forces of nature », p. 104.

13 « e modern view of the vacuum is closely related to zero-point energy, the energy associated with

motion persisting even at the absolute zero of temperature, where classically all motion ceases »,

p. .

14. Pierre Hadot, Le Voile d’Isis. Essai sur l’histoire de l’idée de Nature, Gallimard, 2004.

199

l’histoire d’une phrase d’Héraclite que l’on traduit souvent ainsi : « La Nature aime

à se voiler. » Le livre est illustré de représentations classiques de la nature – il s’agit

toujours d’une femme, souvent Isis, qui se dévoile et révèle ses secrets devant la

science. Avec un message sous-jacent : elle se déshabille devant les hommes de

science. Pierre Hadot a reproduit les frontispices de plusieurs livres, dont un ouvrage

de 1687 publié par Leeuwenhoek, l’inventeur du microscope. Le livre montre aussi

une statue célèbre de Louis-Ernest Barrias, La Nature se dévoilant devant la science

(1899), conservée au Musée d’Orsay (je l’ai mentionnée dans mon article traduit

dans Tracés, n° 9, novembre 2005). C’est une image sexiste ! Pierre Hadot n’a pas

reproduit dans son livre la gravure qui orne le revers de la médaille du prix Nobel de

physique et de chimie. Elle « représente la nature sous la forme d’une déesse prenant

les traits d’Isis émergeant des nuées et tenant dans ses bras une corne d’abondance.

Le génie de la science lève le voile qui recouvre son visage ». Modeste allégorie ? Non :

sa poitrine est déjà nue.

On pourrait dire, pour parodier la formule d’Héraclite et celle du physicien

Davies : La Nature se cache dans le vide, où son énergie est « zéro ». Quelle cachette !

J’ai parlé de Gérard Mourou. Le 19 octobre dernier, Le monde lui consacrait

un article intitulé « L’intensité du laser fera jaillir la matière du vide ». L’article cite

Mourou :

« “Le vide est mère de toute matière”, lance-t-il avec une certaine jubilation. À l’état

parfait, “il contient une quantité gigantesque de particules par cm3… et tout autant

d’antiparticules”. D’où une somme nulle qui conduit à cette apparente absence de

matière que nous nommons…le vide. » 15

J’ai un programme de recherche philosophique sur ce que j’appelle les « styles de

raisonnements ». De ce point de vue, le style du laboratoire est capital. J’ai un faible

pour les mythes de l’origine, et j’ai choisi la pompe à air de Robert Boyle comme

l’invention qui marque le début de ce style 16. J’aime beaucoup l’idée que cette his-

toire du laboratoire, comme style de pensée, commence par des essais pour produire

le vide – où la nature se cache.

15. Le Monde, 20 octobre 2005.

16. Ian Hacking, « “Style” for historians and philosophers », Studies in History and Philosophy of Science

23 (1992), p. 1-20. J’utilise le livre de Shapin et Schaffer, op. cit. note 6, pour mon mythe de l’ori-

gine. On trouvera quelques remarques sur ce livre dans mon compte-rendu, « Artificial pheno-

mena », British Journal for the History of Science, 24 (1991), 235-241. Je mets l’accent sur la pompe,

comme instrument, sur le laboratoire, la création des phénomènes et les objections de Hobbes contre

la création de phénomènes nouveaux. Bruno Latour, initiateur de la traduction française et préfacier,

met l’accent sur la divergence, au temps de Boyle et Hobbes, entre la science et la société, d’où le

sous-titre français, et l’omission de la traduction de la diatribe contre la création des phénomènes.

La philosophie de l’expérience : illustrations de l’ultrafroid

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

1

/

33

100%