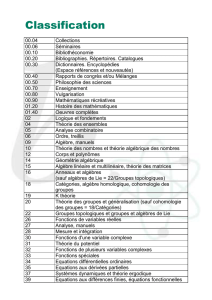

Table des matières - Université de Caen

Master 2 Introduction à la théorie de l’indice de Vaughan Jones 2007-2008

Table des matières

1 Algèbres et modules : définitions et exemples de base. Lemme de Shur. 2

1.1 Algèbres, idéaux et morphismes. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2

1.2 Modules. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

2 Présentation d’une algèbre. Modules et algèbres semi-simples. 5

2.1 Définition d’une algèbre par présentation de générateurs et relations entre eux. . . . . . . . . . . . 5

2.2 Modules et algèbres semi-simples. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

3 Structure d’une algèbre semi-simple de dimension finie. 8

3.1 Préparations. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

3.2 Le théorème de Wedderburn. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

4 Commutant et bicommutant. 11

4.1 Produit tensoriel de deux espaces vectoriels. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

4.2 Commutant et bicommutant. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

5 Inclusions d’algèbres semi-simples. 14

6 Indice. 17

7 La construction fondamentale. Traces. Espérances conditionnelles. 20

7.1 La construction fondamentale. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

7.2 Trace. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

7.3 Espérance conditionnelle. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 21

8 Une caractérisation de la construction fondamentale. 23

8.1 Dual et bidual d’un module. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

8.2 Produit tensoriel de deux modules. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

9 Les traces de Markov. 26

10 Tours d’algèbres. 28

10.1 Généralités. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

10.2 Exemple : les algèbres de Temperley-Lieb. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

Université de Caen Basse Normandie 1/30 c

Leonid Vainerman

Master 2 Introduction à la théorie de l’indice de Vaughan Jones 2007-2008

Résumé

Notons [G:H]l’indice d’un sous-groupe Hd’un groupe fini G. Le théorème de Lagrange indique que

[G:H]∈∗. En passant aux inclusions d’algèbres de groupes kH ⊂kG, où kest un corps algébriquement clos

tel que car(k) = 0 (typiquement, k=), on a [G:H] = dim(kG)

dim(kH). Dans ce cours, on définit et on étudie l’indice

[A:B]d’une inclusion d’algèbres unifères associatives semi-simples de dimension finie B⊂Asur k. Selon le

théorème de Mashke, l’algèbre de groupe kG d’un groupe fini Gest semi-simple donc cette nouvelle notion est

une extension de la notion d’indice d’un sous-groupe. On verra, en particulier, que la valeur de [A:B]n’est pas

nécessairement un nombre entier. Ensuite, on étudie la tour d’algèbres construite à partir d’une inclusion A⊂B

donnée à l’aide de la construction fondamentale ainsi que les propriétés des traces de Markov et d’espérances

conditionnelles associées.

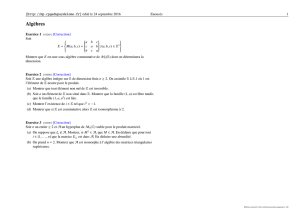

1 Algèbres et modules : définitions et exemples de base. Lemme de Shur.

1.1 Algèbres, idéaux et morphismes.

Définitions 1.1. -

– Une algèbre associative unifère Asur kest un espace vectoriel muni d’une application bilinéaire dite multi-

plication associative A×A→A: (a, b)7→ ab, ∀a, b ∈Aet d’unité 1A.

– L’algèbre opposée Aop de Aest le même espace vectoriel muni de la multiplication opposée (a, b)7→ ba.

– Une sous-algèbre B⊂Aest un sous-espace vectoriel stable pour la multiplication. Best unifère si 1A∈B.

– Le centre Z(A)de Aest l’ensemble de tous les a∈Atels que ab =ba, ∀b∈A. Évidemment, k1A⊂Z(A). Si

Z(A) = k1A, on dit que Aest un facteur.

– Un idéal à gauche (resp., à droite)I⊂Aest un sous-ensemble tel que AI ⊂I(resp., IA ⊂A) . Un idéal

bilatère de Aest un idéal à gauche et à droite de A. Un idéal propre de Ane contient pas 1A(le prouver).

– Une algèbre Aest commutative (ou abélienne) si Z(A) = A.

– Une algèbre Aest simple si elle n’a pas d’idéaux bilatères propres non nuls.

– On dit que a∈Aest inversible s’il existe un élément a−1∈Atel que aa−1=a−1a= 1A. On note A×

l’ensemble de tous les éléments inversibles de A. Un idéal propre de Ane contient pas d’inversibles (le prouver).

Si A=A×∪ {0}, on dit que Aest une algèbre à division. Une telle algèbre ne contient pas de diviseurs de 0.

Exemples 1.1. (Algèbres)

a) A=Endk(V)- l’algèbre des endomorphismes d’un espace vectoriel Vsur k, où la multiplication est la

composition d’endomorphismes, 1A=idV. Si Vest de dimension finie n, alors A=Mn(k)est un facteur

(vérification directe) ; A={a⊕a⊕...⊕a:a∈Mn(k)}est un facteur.

b) A=k[X]- l’algèbre commutative des polynômes en l’indéterminée X:

Pn(X) = anXn+an−1Xn−1+···+a1X+a0,

où ai∈k, ∀i∈ {1; 2; ...;n},et n∈, avec la multiplication usuelle et 1A= 1(X)≡1.

c) kG - l’algèbre d’un groupe Gest l’espace vectoriel des combinaisons linéaires formelles finies d’éléments de

G muni de la multiplication suivante :

(X

s∈G

as·s)(X

t∈G

bt·t) = X

s∈GX

t∈G

asbt·st =X

u∈G

(X

s∈G

asbs−1u)·u,

pour toutes suites (as)s∈Get (bt)t∈Gd’éléments de k. On a 1A=e, où eest l’élément neutre du groupe G.

Évidemment, cette algèbre est associative car la multiplication dans Gest associative ; elle est commutative

ssi Gest commutatif ; si Gest un groupe fini, alors dim(kG) = |G|.

d) Mn(A), où Aest une algèbre.

Exemples 1.2. (Sous-algèbres)

a) Le sous-espace vectoriel des matrices diagonales est une sous-algèbre de Mn(k).

b) Le sous-espace vectoriel des matrices triangulaires est une sous-algèbre de Mn(k).

c) Le sous-espace vectoriel des polynômes pairs (mais pas impairs !) en Xest une sous-algèbre de k[X].

d) kH est une sous-algèbre de kG, où Hest un sous-groupe de G.

Université de Caen Basse Normandie 2/30 c

Leonid Vainerman

Master 2 Introduction à la théorie de l’indice de Vaughan Jones 2007-2008

Exemples 1.3. (Idéaux)

a) Pour tout a∈A, Ig:= Aa (resp., Id:= aA) est un idéal à gauche (resp., à droite) ; si a∈Z(A),I:= aA est

bilatère ; I=Assi aest inversible.

b) L’ensemble des matrices lignes (resp., colonnes) forme un idéal à droite (resp., à gauche) de Mn(k).

c) L’ensemble des polynômes qui s’annulent en x0∈kforme un idéal bilatère de k[X].

Remarque.Si Aest simple, tout a∈Z(A), a 6= 0 est inversible donc Z(A)est une algèbre à division car sinon,

on peut fabriquer un idéal bilatère non trivial de A. On va montrer que si Aest simple et dim(Z(A)) <∞, alors

Aest un facteur.

Proposition 1.1. Une algèbre à division Dtelle que dim(D) = m < ∞est isomorphe à k.

Preuve. Si x∈D, la famille 1D, x, x2,...,xmn’est pas libre donc il existe un polynôme normalisé P∈k[X]de

degré minimal tel que P(x) = 0. Comme Dest une algèbre à division, le polynôme Pest irréductible sur k. En

effet, si P=P1P2avec deg(P1),deg(P2)<deg(P), on a P(x) = P1(x)P2(x) = 0 avec P1(x)6= 0, P2(x)6= 0 par

minimalité de deg(P): contradiction avec l’absence de diviseurs de 0dans une algèbre à division. Mais comme k

est algébriquement clos, pour tout polynôme irréductible, on a P(X) = X−zpour un z∈k. Donc x=z1D.

Définitions 1.2. -

– Un morphisme d’une algèbre Aunifère dans une autre algèbre unifère Best un morphisme ϕd’espaces vectoriels

Aet Btel que ϕ(a·b) = ϕ(a)·ϕ(b), pour tous a∈A, b ∈B, et ϕ(1A) = 1B. On peut parler des morphismes injectifs

(inclusions d’algèbres), surjectifs, isomorphismes, automorphismes. On dit qu’un automorphisme ϕ:A→A

est intérieur s’il existe b∈A×tel que ϕ(a) = bab−1, pour tout a∈A.

– Une représentation d’une algèbre Asur un espace vectoriel Vest un morphisme πde Adans Endk(V).

πest dit irréductible si Vn’a pas de sous-espaces non triviaux stables pour tous les endomorphismes de Im (π).

– Soit (Aj)j∈June famille d’algèbres. La somme directe des algèbres Ajest par définition la somme directe

⊕j∈JAjdes espaces vectoriels Ajmunie de la multiplication (⊕j∈Jaj)·(⊕j∈Jbj) := ⊕j∈J(aj·bj).

Exemples 1.4. -

a) Les morphismes de groupes engendrent les morphismes d’algèbres de groupes associés, les représentations

(en particulier, irréductibles) d’un groupe Gcorrespondent aux représentations (en particulier, irréductibles)

de kG.

b) En particulier, les représentations triviale πtriv :G→k:π(g)≡1ket régulière à droite πd

reg :G→

Endk(kG) : πd

reg(g)h=hg, ∀g, h ∈Gd’un groupe Get de kG. De même pour la représentation régulière

à gauche πg

reg :G→Endk(kG) : πg

reg(g)h=g−1h, ∀g, h ∈G.

c) L’inclusion Mn(k)⊂M2n(k) : a7→ a⊕an’est pas surjective.

Remarques.-

– On va voir dans le §2la relation très étroite entre les notions de morphisme d’algèbres et d’idéal bilatère.

– L’algèbre de groupe kG n’est jamais simple (sauf si G={e}). En effet, le noyau de la représentation triviale est

un idéal bilatère non trivial.

1.2 Modules.

Définitions 1.3. -

– Soit Aune algèbre unifère. Un A-module à gauche est un espace vectoriel Mmuni d’une application bilinéaire

dite action de Asur M·:A×M→Mtelle que (ab)·m=a·(b·m),1A·m=m, ∀a, b ∈A, ∀m∈M.

– On définit un A-module à droite de manière analogue. Toutes les définitions et tous les résultats ci-dessous,

formulés pour les A-modules à gauche (resp., à droite), ont leurs analogues évidents pour les A-modules à droite

(resp., à gauche).

– Un A-bimodule Mest un A-module à gauche et à droite tel que a·(m·b) = (a·m)·b, ∀a, b ∈A, ∀m∈M.

– Un sous-module d’un A-module Mà gauche est un sous-espace vectoriel de Mstable pour l’opération ·.

– On dit qu’un A-module non nul est simple s’il n’a aucun sous-module non-trivial.

– On dit qu’un sous-module de Mest minimal s’il est simple en tant que A-module.

– Un morphisme de A-modules à gauche Met Nest une application linéaire ϕ:M→Ntelle que ϕ(a·m) =

a·ϕ(m),∀m∈M. Parfois, on dit qu’une telle application est A-linéaire. On peut parler de morphismes injectifs,

surjectifs et bijectifs (équivalence de modules).

Université de Caen Basse Normandie 3/30 c

Leonid Vainerman

Master 2 Introduction à la théorie de l’indice de Vaughan Jones 2007-2008

– Une somme directe M=⊕iMid’une famille de A-modules à gauche Miest la somme directe des Mien

tant qu’espaces vectoriels (donc tout élément de Mest une somme finie d’éléments de Mi) munie de l’opération

a·(⊕imi) := ⊕i(a·mi),∀a∈A, ∀mi∈Mi. De même, pour les A-modules à droite. On peut définir naturellement

l’injection canonique νi:Mi→Met la projection canonique πi:M→Micomme morphismes de A-modules.

– On dit qu’un sous-module Nd’un A-module Mest un facteur direct de Ms’il existe un autre sous-module P

de Mtel que M=N⊕P.

– On vérifie directement que, si fi:Mi→Nest un morphisme de A-modules pour tout i, alors il existe un

morphisme f:M=⊕iMi→Net un seul tel que f◦νi=fi.

– On dit qu’un A-module à gauche Mest libre s’il possède une base (finie ou infinie) B={b1, b2,...}, c-à-d :

a) tout élément de Mest une combinaison linéaire d’éléments de Bà coefficients dans A;

b) Best libre : si m1b1+m2b2+...+mnbn= 0 pour m1,...,mn∈M, alors m1=m2=... =mn= 0.

– On dit qu’un A-module à gauche Mest de type fini s’il existe un ensemble fini B={b1, b2,...,bn}(pas

nécessairement libre) tel que tout élément de Mest combinaison linéaire d’éléments de Bà coefficients dans A.

Un A-module à gauche est cyclique s’il est engendré par un seul élément.

– On dit qu’un A-module à gauche Mest projectif s’il existe un autre A-module Ntel que la somme directe

M⊕Nest un A-module libre.

– Soit π:A→Endk(V)une représentation de Asur un espace vectoriel V. Dans ce cas, Vest un A-module

à gauche pour a·v:= π(a)v, ∀a∈A, ∀v∈V. Réciproquement, tout A-module Và gauche définit une

représentation πde Asur Vpar la même formule. De plus, πest irréductible ssi le A-module Vest simple.

Notations.-

– Homd

A(M, N)est l’ensemble de tous les morphismes de A-modules à droite Met N, c’est un A-module à gauche :

(a·ϕ)(m) := a·(ϕ(m)),∀a∈A, ∀m∈M, ∀ϕ∈Homd

A(M, N).

– Endd

A(M)est l’ensemble de tous les endomorphismes d’un A-module à droite M, c’est une algèbre (pour la

composition des endomorphismes) et un A-module à gauche.

Exemples 1.5. (Modules)

a) Toute algèbre Adéfinit un A-module à gauche gA(resp., à droite Ad) dit régulier - l’action de Aest définie

par la multiplication à gauche (resp., à droite). Ces modules sont cycliques car 1Aest vecteur cyclique.

b) De même, tout idéal à gauche de Aest un A-module à gauche ; les sous-modules à gauche de gAsont

exactement les idéaux à gauche de A.

c) Le sous-module Mdu module régulier à gauche gAsur l’algèbre A:= T+

2(k) = a11 a12

0a22:aij ∈k,

défini par la condition a22 = 0 (Aagit sur Mpar multiplication par a11) n’a pas de complément direct qui

soit un A-module. En effet, tout complément direct Ndu sous-espace vectoriel Mdans l’espace vectoriel gA

est de dimension 1 donc engendré par une matrice fixée avec a22 6= 0. Mais on a toujours dim(A·N)>1

donc Nne peut pas être un A-module.

Remarques.-

– Tout A-module simple à gauche Mest nécessairement cyclique et tout vecteur non nul est cyclique car si

m∈M, m 6= 0 n’est pas cyclique, le sous-module A·mde Mest propre et non nul (il contient m= 1A·m).

– On a dim(M)6dim(A), pour tout A-module simple à gauche Mcar dim(M) = dim(A·m)6dim(A),∀m∈M.

Lemme de Shur.-

Soient Aune algèbre et ϕ:M→Nun morphisme non nul de A-modules (à gauche ou à droite).

(i) Si Mest simple, alors ϕest injectif.

(ii) Si Nest simple, alors ϕest surjectif.

Preuve. Comme ϕ6= 0, on a Ker ϕ6=Met Im ϕ6= 0. Alors, si Mest simple, on a Ker ϕ= 0, et si Nest simple,

on a Im ϕ=N.

Corollaire. 1. Si Met Nsont simples, alors ou bien ils sont équivalents, ou bien HomA(M, N) = 0.

2. Soient Nun idéal à droite minimal de Aet x∈A. Alors ou bien xN = 0, ou bien xN est un idéal à droite

minimal de Aéquivalent à N.

En effet, n7→ xn est un morphisme surjectif de A-modules Net xN, et on applique le lemme de Shur.

Université de Caen Basse Normandie 4/30 c

Leonid Vainerman

Master 2 Introduction à la théorie de l’indice de Vaughan Jones 2007-2008

2 Présentation d’une algèbre. Modules et algèbres semi-simples.

2.1 Définition d’une algèbre par présentation de générateurs et relations entre eux.

Définition 2.1. Soient Aune algèbre et Iun idéal bilatère de A. On définit la relation d’équivalence Rsuivante :

∀(x, y)∈A2, xRy ⇔(x−y)∈I.

Deux éléments de Asont ainsi en relation si leur différence appartient à I. L’espace vectoriel quotient A/I, muni

de la multiplication induite par I : (x+I)×(y+I) = (x·y) + I, est une algèbre, nommée algèbre quotient de

Apar I. On a 1A/I = 1A+I.

Évidemment, si I=A, alors A/A est l’algèbre triviale {0}, et si I={0}, alors A/{0}est isomorphe à A.

Propriétés.-

a) L’application π:A→A/I définie par π(x) = x+Iest un morphisme surjectif d’algèbres (appelée projection

canonique) dont le noyau est I.

b) Si f:A→Best un homomorphisme d’algèbres, notons I=Ker fson noyau. C’est un idéal bilatère. Alors, f

se factorise en un morphisme injectif ¯

f:A/I →Bdéfini par ¯

f(x+I) = f(x)(c’est le théorème fondamental

des homomorphismes).

c) Soient Aune algèbre commutative, Iun idéal bilatère propre de A. Alors Iest maximal ssi A/I =k.

Preuve. du c) : (i) Soit A/I 6=kalors il existe a∈A−I, non inversible, car sinon A/I est une algèbre à division

et donc A/I =kpar la proposition 1.1. Maintenant I1:= I+aA est un idéal bilatère propre de A, car I1ne

contient pas 1A, et I⊂I1donc In’est pas maximal.

(ii) Si A/I =k, on a, par définition, A=I+k1Adonc Iest maximal propre.

Une algèbre peut se définir par sa présentation autrement dit la donnée d’un ensemble Sde générateurs et de

relations que ceux-ci doivent vérifier. Si les générateurs de Sne vérifient aucune relation, l’algèbre AL(S)engendrée

par Sest dite algèbre libre engendrée par S. Elle est formée de toutes les combinaisons formelles sur kde

monômes sur S, c’est-à-dire des mots formels x1x2. . . xn, où xi∈S, i ∈ {1,2,...,n}et du mot vide 1. La

multiplication associative dans cette algèbre est engendrée par la concaténation des mots.

En général, les générateurs de Svérifient certaines relations : il existe un certain ensemble Pd’éléments de AL(S)

qui doivent être égaux à 0dans notre algèbre. Plus formellement, on considère l’idéal bilatère minimal I(P)de

AL(S)engendré par P, et on quotiente AL(S)par cet idéal : A(S, P ) := AL(S)/I(P).

D’habitude, la présentation (S, P )d’une algèbre Ase note en écrivant entre crochets une liste des générateurs de

Set une liste des combinaisons formelles de mots en ces générateurs.

Exemples 2.1. -

a) k[X, Y ] = < X, Y |XY −Y X >.

b) M2(k) = < eij |eij ekl −δj,keil >, où i, j, k, l ∈ {1,2}et δi,j est le symbole de Kronecker.

2.2 Modules et algèbres semi-simples.

Définition 2.2. Soit Aune algèbre. On dit qu’un A-module (à gauche ou à droite) est semi-simple s’il est

égal à une somme directe de A-modules simples.

Par conséquent, une somme directe de A-modules semi-simples est un A-module semi-simple.

Proposition 2.1. -

(i) Dans A=Mn(k), les ensembles Ni(i∈ {1,2,...,n})de matrices lignes (resp., colonnes) forment des idéaux

à droite (resp., à gauche) minimaux.

(ii) Ad=⊕n

i=1Nien tant que A-modules à droite.

(iii) Les A-modules à droite simples Niet Njsont isomorphes pour tous iet j.

(iv) A=Mn(k)est simple (i.e. ne contient pas d’idéaux bilatères non triviaux).

Preuve.

Université de Caen Basse Normandie 5/30 c

Leonid Vainerman

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

1

/

30

100%