Apprentissage de concepts

Apprentissage de concepts 2

Apprentissage de concepts

•Définitions

•Espace de recherche : du général au spécifique

•L’algorithme d’élimination des candidats

•Biais inductifs

Apprentissage de concepts 3

Définition

Problème : apprendre une fonction de mapping

d’exemples vers deux classes : positive & négative.

Input : Un ensemble d’exemples déjà classifiés

comme positifs or négatifs.

Apprendre un concept : processus d’induction d’une

fonction de mapping des exemples vers un ensemble

Booléen.

Exemples :

Classifier des objets dans des images

astronomiques comme des étoiles ou des galaxies

Classifier des animaux comme vertébrés ou

invertébrés

Apprentissage de concepts 4

Exemple : Champignons

Tâche : Prédire si des champignons sont vénéneux

Performance : Taux d’exactitude de la classification

Expérience :

:

Une base de données décrivant des

champignons et leurs classes.

Connaissance à apprendre :

Fonction de mapping des champignons vers {0,1}

où 0:non vénéneux et 1: vénéneux

Représentation de la connaissance à apprendre :

Conjonction de valeurs d’attributs.

Mécanisme d’apprentissage :

Élimination des candidats

Apprentissage de concepts 5

Représentation des exemples

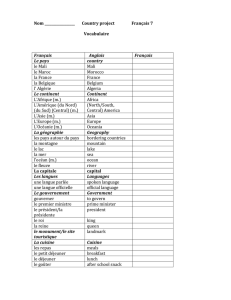

Attributs / Caractéristiques :

• color : {red, brown, gray}

• size : {small, large}

• shape : {round,elongated}

• land : {humid,dry}

• air humidity : {low,high}

• texture : {smooth, rough}

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

1

/

35

100%