Texte de la 225e conférence de l`Université de tous les

Texte de la 225e conférence de l’Université de tous les savoirs donnée le 12 août 2000.

Comment les révolutions de l'information et des communications ont-elles été

possibles ? Les semi-conducteurs

par Claude Weisbuch

Introduction

Les révolutions de l'information et des communications, issues des découvertes sur les

semi-conducteurs, sont un des faits marquants du siècle passé et vont continuer à bouleverser

dans ce nouveau siècle tous les domaines de l'activité humaine.

Le comité Nobel a rendu hommage en cette année 2000 aux pionniers qui ont rendu

possible ces révolutions : après le prix Nobel de Bardeen, Brattain et Shockley en 1956 pour

l'invention du transistor, c'est Kilby d'une part, Alferov et Kroemer d'autre part, qui sont

récompensés respectivement pour l'invention du circuit intégré, à la base de l'explosion de la

micro électronique, et pour celle des hétérostructures semi-conductrices, qui permettent, entre

autres, d'obtenir des lasers pour télécommunications. Ce prix Nobel est remarquable à plus

d'un titre, en particulier parce qu'il récompense des inventions, qui ont été signifiées par des

brevets (pour Kilby et Alferov), et non des découvertes scientifiques au sens habituel du

terme, annoncées dans des revues scientifiques évaluées par les pairs.

Les semi-conducteurs, et leur mise en œuvre dans les transistors, les lasers et les

circuits intégrés, tiennent ainsi une place particulière dans les grandes découvertes du XXe

siècle, à cause de leur impact jusque dans nos modes de vie. Il y a bien d'autres raisons qui

ajoutent à la place essentielle du domaine dans l'histoire des sciences et des techniques :

C'est un domaine technologique complètement né de la compréhension fondamentale

de la matière solide. Aujourd'hui, les milliards de composants fabriqués chaque seconde

opèrent exactement comme prévu par les modèles physiques microscopiques utilisés dans les

programmes de conception de circuits.

Inversement, depuis quelques années, la technologie des circuits intégrés permet

d'explorer de nouveaux champs fondamentaux. C'est ainsi que l'effet Hall quantique dans les

hétérostructures a déjà donné lieu à deux prix Nobel. Il y en aura certainement encore d'autres

basés sur les semi-conducteurs et leurs structures.

Le domaine est né d'une recherche fondamentale à long terme, effectuée dans un

laboratoire industriel. Cette expérience a longtemps été à la base du paradigme, accepté

jusqu'au début des années 80, selon lequel l'industrie devait faire elle-même de la recherche

fondamentale.

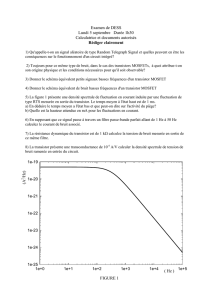

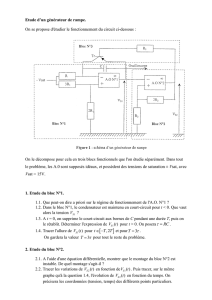

Il y a un étonnement renouvelé devant le progrès exponentiel ininterrompu (fig.1), à la

fois en performance et en coût.

Le domaine a ouvert de nouveaux champs industriels menant à un renouvellement des

entreprises industrielles les plus importantes, et a donné naissance à ce qu'on appelle la

nouvelle économie. De plus, son impact se retrouve dans tous les secteurs d'activité,

industriels ou de service, à cause de son caractère de technologie diffusante, transverse.

Le domaine a été à l'origine de nouvelles formes d'organisations et dynamiques

industrielles. La Silicon Valley tire son nom des entreprises de microélectronique en Silicium,

basées autour de San Francisco et de l'Université de Stanford. Ces entreprises ont défini un

nouveau paradigme industriel, basé sur l'essaimage et la mobilité des personnes (la première

entreprise, celle de Shockley est née des laboratoires Bell; des transfuges de Shockley ont

créé Fairchild, puis Intel). On peut tracer des liens d'hérédité entre des centaines d'entreprises

de la Silicon Valley. Une autre caractéristique est la rapidité de développement des nouveaux

produits et des entités industrielles de la nouvelle économie.

Ces révolutions de l'information et des communications sont nées du codage de

l'information sous forme de paquets d'électrons (les « grains » d'électricité) ou de photons (les

« grains » de lumière) (quelques dizaines de milliers de chaque pour l'élément d'information,

le « bit »), et la capacité de manipuler et transmettre ces paquets d’électrons ou de photons de

manière de plus en plus efficace et économique.

On nous annonce une société passant de biens matériels à l'immatériel, la « société de

la connaissance ». Cela peut être discuté, mais du point de vue physique il est vrai que les

quantités portant l'information sont très petites : La plus grande bibliothèque du monde, celle

du Congrès à Washington, a vingt millions de volumes. Si on considère qu'un livre est

codable sur 50 millions de bits, il faut 1015 bits pour coder tous les livres1. Si on code chaque

bit par la présence ou l'absence de la charge électrique de 10 000 électrons, la bibliothèque est

portée par 1019 électrons, soit les électrons qui sont transportés dans un courant de 1 ampère

en une seconde ! À notre échelle de tous les jours, le codage de l'information nécessite

effectivement une quantité infime de matière. C’est pour cela que la manipulation en est facile

et efficace. La capacité de communiquer l’information, grâce aux télécommunications, n’est

pas en reste : une seule fibre optique, alimentée par des lasers à semi-conducteurs, transmet

aujourd'hui 3 1012 bits (3 terabits) par seconde. Il faut donc 300 s pour transmettre toute la

librairie du Congrès ! Pour prendre la réelle mesure de la révolution de l'information, il suffit

de considérer la quantité d'informations produites chaque année2 sous forme de livres et

journaux, images fixes ou animées (films), données sur CD-Rom ou disques magnétiques

(c'est ce dernier type d'archivage qui est le plus important) : 2 attobytes (1 byte = 8 bits)( dont

0,003 % seulement sous forme imprimée), soit 350 gigabytes par habitant de la terre !

Tout cela a été rendu possible par les progrès des composants et systèmes semi-

conducteurs, liés aux deux démarches simultanées d'intégration des éléments actifs sur un

même support, la « puce », et de miniaturisation. Une des immenses surprises aura été le

caractère « vertueux » de la miniaturisation : plus les composants sont petits, meilleur est leur

fonctionnement ! On a pu ainsi gagner en 35 ans simultanément plusieurs facteurs de 100

millions à 1 milliard, en termes de complexité des circuits, en réduction de coût (la puce de

plusieurs centaines de millions de transistors coûte le même prix qu'un transistor dans les

années 60), en fiabilité, en rendement de fabrication.

Ce type de progrès exponentiel ne peut pas continuer indéfiniment. Le problème des

limites physiques se pose de plusieurs manières : jusqu'où la miniaturisation peut-elle

continuer ? Combien d'atomes faut-il pour faire un transistor qui fonctionne encore ? Y-a-t-il

des matériaux autres que les semi-conducteurs qui permettraient d'aller au-delà des limites

physiques, ou bien encore existe-t-il d'autres moyens de coder l'information plus efficaces que

les électrons ou les photons ? Ce sont les questions que se pose aujourd'hui le physicien,

cherchant ainsi à "refonder" un domaine d'activité immense qu'il a contribué à créer.

Aux origines des révolutions de l'information et des communications : la

physique quantique des solides

1 La notation scientifique et les unités de longueur

Pour représenter des grandeurs extrêmes, on utilise la notation dite scientifique, comprenant le chiffre

10 et un exposant: ce chiffre en exposant signifie le nombre de zéros à mettre dans une notation normale après le

chiffre 1 : 103 = 1 000 ; 106 = 1 000 000. Si l'exposant est négatif, il faut prendre l'inverse du nombre avec le

même exposant positif : 10-3 = 1/103 = 1/1 000.

Les préfixes : Méga dénote la puissance +6, Giga la puissance +9, ainsi 20 Gigabit valent 20 milliards

de bits ; le préfixe Téra dénote la puissance +12, soit 1 000 Giga-- ; Petta la puissance +15, atto la puissance

+18.

-Unités de longueur : le micromètre (ou micron) = un millionième de mètre. On le note 10-6 m, symbole

µm (un cheveu a un diamètre de 100 µm). L’angström, symbole Å, vaut un dix millionième de millimètre, soit

10-10 m Il représente l'ordre de grandeur de la distance entre atomes dans les cristaux solides, typiquement 3 Å.

2 voir http://www.sims.berkeley.edu/how-much-info/index.html

À la base de la capacité à stocker, manipuler et transmettre l'information se trouvent

les matériaux semi-conducteurs. Rien ne prédisposait ces matériaux à un tel destin : ils ont

des propriétés « classiques » médiocres, que ce soit mécaniques, thermiques, optiques ou

électriques. Comment en est-on arrivé à définir une catégorie de matériaux, les semi-

conducteurs, qui ne sont ni « bons » conducteurs (métalliques), ni « bons » isolants ! Ces

matériaux ont longtemps mystifié ceux qui s'intéressaient à eux : contrairement aux métaux,

leur conductivité s'améliore avec la température; de plus, et là aussi contrairement aux

métaux, leur médiocre conductivité à l'état pur s'améliore grandement si on leur ajoute des

impuretés chimiques choisies (les « dopants »).

C'est justement les propriétés conductrices moyennes des semi-conducteurs, basées sur

des quantités faibles de charges mobiles, qui les rendent « commandables ». Leur capacité à

changer de conductivité électrique, devenue « contrôlée » par la compréhension physique des

phénomènes et l'insertion locale d'impuretés chimiques, permet de commander le passage de

courant par des électrodes. On a alors les effets d'amplification et d'interrupteur du transistor,

à la base de la manipulation électronique de l'information. La sensibilité des semi-conducteurs

aux flux lumineux en fait aussi les détecteurs de photons dans les communications optiques,

et le phénomène inverse d'émission lumineuse les rend incontournables comme sources de

photons pour les télécommunications.

La compréhension de ces phénomènes a constitué le grand triomphe de l'application

de la mécanique quantique au mouvement des électrons dans les solides cristallins : la

résolution des équations de la mécanique quantique pour des électrons se propageant dans

l'arrangement périodique des ions d'un cristal a montré que leurs énergies possibles se

répartissaient en bandes d'énergie ayant une certaine mémoire des niveaux d'énergie des

atomes constituant le cristal. Chaque bande dans un cristal comportant N atomes aura vN

places pour des électrons (« états quantiques » dans le langage de la mécanique quantique)

dans chaque bande, si v est le nombre de niveaux permis dans le niveau de l'atome de départ

(fig. 2a). Suivant les positions de ces bandes d'énergie et le nombre d'électrons des atomes, en

particulier ceux des électrons les moins liés au noyau (les électrons de « valence », assurant

donc les propriétés chimiques) on va remplir entièrement ou non les bandes d'énergie

permises par les électrons disponibles, à partir de l'énergie la plus basse (fig. 2b). Si les

derniers électrons sont dans une bande où il reste dans le voisinage des places vides à plus

haute énergie, un champ électrique appliqué pourra donner une impulsion et une énergie

cinétique aux électrons. Il y aura conductivité électrique métallique. Si les électrons de

valence du matériau remplissent complètement les bandes, ils ne peuvent pas prendre de

l'énergie sous l'action d'un champ électrique appliqué. On a donc affaire à un isolant. On

conçoit bien que pour des espèces chimiques différentes, ayant de très petites différences

entre les niveaux d'énergie des atomes isolés de départ, on aura au final des matériaux solides

isolants ou conducteurs, donc avec des propriétés électriques très différentes.

Les semi-conducteurs, dans cette description, sont en fait des isolants à faible « bande

interdite » entre les derniers niveaux occupés de la bande de valence et les niveaux

immédiatement supérieurs de la prochaine bande d'énergie permise, appelée bande de

conduction. Du coup, certains électrons peuvent être excités de la bande de valence, dans

laquelle ils laisseront un « trou », vers la bande de conduction (fig. 2b, 3d). Plus la

température est élevée et plus il y a de tels électrons et trous, qui donc assurent une

conductivité plus grande. Ainsi s'explique le mystère de la conductivité des semi-conducteurs

qui augmente avec la température (celle des métaux baisse à cause de l'agitation thermique

des ions du cristal qui empêche la propagation des électrons, phénomène aussi présent dans

les semi-conducteurs mais dont l'effet est masqué par la bien plus importante augmentation du

nombre de charges conductrices). Le trou laissé dans la bande de valence a une conductivité

qui semble être due à une charge positive, car le déplacement apparent dans un champ

électrique a lieu en sens inverse de celui des électrons (figure 3c). Cette explication de la

conductivité apparente de certains matériaux par le « trou » de charge apparemment

« positive » dans une bande d'énergie presque pleine résout un des grands mystères des

solides, car on savait depuis J. J. Thomson que les charges légères et mobiles étaient des

électrons négatifs !

La propriété supplémentaire qu'ont les semi-conducteurs est leur conductivité

« commandable» par incorporation d'impuretés choisies : comme le Silicium, matériau de

base pour la microélectronique, a quatre électrons de valence, le fait d'incorporer des atomes

ayant trois ou cinq électrons de valence (le bore ou le phosphore respectivement) va entraîner

un manque ou un excès d'électrons par rapport au nombre qui remplit exactement la bande de

valence pour du Silicium pur. Ceci se traduit par des niveaux d'énergie « permis » dans la

bande « interdite », près de la bande de valence ou de conduction, qui vont relâcher des trous

ou des électrons, en nombre exactement égal au nombre d'atomes dopants que l'on aura

introduits. (fig. 3e, 3f) On imagine sans peine à quelles erreurs cet effet de dopage a pu

donner lieu : pour des métaux, la conductivité augmente avec la pureté, car il y a moins d'ions

étrangers pour s'opposer au passage du courant. Dans des semi-conducteurs, au contraire, la

conductivité augmente avec les impuretés dopantes ! Tel chercheur croyait avoir un matériau

pur parce qu'il conduisait bien alors qu'il était fortement dopé. Tel autre purifiait son matériau,

s'attendant à le voir mieux conduire, et il devenait quasiment isolant !

Avec cette compréhension des semi-conducteurs dès 1930, fondée sur la mécanique

quantique des solides cristallins, on avait les bases pour faire des composants électroniques. Il

faudra cependant attendre 1947 pour que le transistor voie le jour.

Du semi-conducteur au transistor et au circuit intégré

Le transistor

On a eu l'idée d'interrupteur (relais électrique) solide commandé par une tension

électrique appliquée dès le début du siècle, avec des brevets décrivant correctement le

fonctionnement du transistor à effet de champ dès 1923 (fig. 4). Cet effet « transistor », c’est-

à-dire le contrôle d'un courant à travers un morceau de matériau semi-conducteur par une

tension appliquée sur une grille de commande, a cependant nécessité de longs travaux dans

les années 30 et 40. Il a fallu maîtriser la purification des semi-conducteurs, et l'incorporation

contrôlée de dopants. Plus fondamentalement, il a fallu comprendre les barrières d'énergie

existant dans les semi-conducteurs dopés de manière inhomogène, ou bien encore celles qui

sont situées aux interfaces métal/semi-conducteur, ainsi que les effets de surface, qui

tendaient à masquer tous les autres phénomènes.

C'est par une démarche délibérée de recherche d'un tel relais solide que les

laboratoires Bell, d'American Telegraph and Telephone (ATT), monopole américain des

télécommunications, se sont lancés dans l'aventure du transistor dès 1936. Leur analyse

montrait que l'accroissement du trafic téléphonique serait tel que les réseaux seraient

constamment en panne vu leur taille et la mauvaise fiabilité des commutateurs, qu'ils soient à

relais électromécaniques ou à tubes à vide. Il fallait des interrupteurs hautement fiables basés

sur un nouveau concept physique. Le transistor a donc été inventé dans une entreprise de

télécommunications grâce à un programme de recherche à long terme et à haut risque, pour

satisfaire ses besoins, en lançant une recherche fondamentale de très grande ampleur puisqu'il

a fallu comprendre complètement nombre de nouveaux phénomènes en physique et en chimie

des matériaux semi-conducteurs. Il ne pouvait être inventé dans une entreprise d'ordinateurs

tout simplement parce qu'ils n'existaient pas à l'époque.

Le transistor et l'ordinateur

Le domaine où les progrès induits par les transistors, puis les circuits intégrés, ont été

le plus spectaculaires est sans doute celui des ordinateurs. Ce n'était pas clairement un impact

attendu, les grands patrons de l'industrie se trompant parfois lourdement : Thomas Watson,

PDG d'IBM, déclarait en 1943 que le marché mondial des ordinateurs serait de cinq unités.

Ken Olsen, PDG de Digital, l'entreprise phare des Miniordinateurs, déclarait en 1977 qu'il ne

voyait pas pourquoi les gens auraient des ordinateurs chez eux.

Ce sont les progrès de la microélectronique qui ont généralisé les ordinateurs dans un

premier temps, puis rendu accessibles l'ordinateur personnel, et les services associés comme

le courrier électronique ou le web. Ces progrès ont été rendus possibles par la physique des

composants. C'est qu'elle est particulièrement bien adaptée à la réalisation des fonctionnalités

indispensables dans un ordinateur : rappelons que pour faire un ordinateur, il faut à la fois de

la mémoire (pour stocker les programmes, les données d'entrée et les résultats de calcul) et

une capacité de logique combinatoire (pour effectuer des calculs)(fig. 5). Le transistor permet

de construire à la fois la fonction mémoire et la capacité logique nécessaires, car il peut

fonctionner comme un bon interrupteur. Comme on le démontre à partir de l'algèbre de Boole,

c’est-à-dire la combinatoire d'opérateurs logiques comme la porte « ET » de la figure 5, des

interrupteurs associés à des résistances permettent de réaliser toute opération logique. Associé

à un condensateur, un transistor fonctionnant en interrupteur permet aussi de réaliser un

élément mémoire : c'est le principe des mémoires « dynamiques » DRAM (fig. 5).

Pourquoi dit-on que la physique des composants à semi-conducteurs est bien adaptée ?

C'est que l'on peut réaliser cette fonctionnalité d' interrupteur de manière quasi-parfaite, c’est-

à-dire en consommant peu d'énergie et en isolant le courant contrôlé par l'interrupteur de la

commande de cet interrupteur : on dit que la « sortie » du composant ne réagit pas sur

l' « entrée ». Pour cela, le matériau isolant entre grille de commande et canal conducteur (fig.

4) est déterminant pour la qualité du transistor. Il a fallu attendre 1960 pour enfin avoir un

isolant de la qualité voulue, alors que les essais de fabrication des transistors à « effet de

champ » avaient débuté dès 1930. Une autre propriété très importante des transistors est que

chacun d'eux peut commander plusieurs autres transistors, avec une tension qui est référencée

à la tension d'alimentation (cf. la tension de « sortie » de la porte « ET » de la figure 5), et

non pas à la tension de commande (« 0 » ou « 1 »). On peut donc mettre en cascade des

milliers de composants sans dégradation du signal de commande.

Le circuit intégré

Le circuit intégré n’est pas un concept aussi fondamental que le transistor : son

invention résulte de l'association d’éléments déjà connus, sinon maîtrisés, en réponse à un

besoin pratique. Kilby, prix Nobel 2000, l'a décrit dans un brevet et des conférences, pas dans

une revue scientifique.

Dès l'invention du transistor, celui-ci remplace le tube à vide dans les appareillages

électroniques, et les ingénieurs utilisent ses propriétés remarquables : miniaturisation, grâce à

des techniques de micro fabrication, conception de très grands systèmes grâce à une meilleure

fiabilité des composants, à leur petite taille et surtout à leur faible consommation énergétique.

Cette course à la miniaturisation est suscitée par des besoins, comme ceux des grands

centraux téléphoniques, des très grands ordinateurs, ou encore le besoin des militaires de

disposer d'électronique « portable » pour les communications, les missiles ou les satellites.

Pour toutes ces applications, on tente d'assembler, de façon compacte, le plus grand

nombre de composants possible, par des techniques dites « hybrides » : chaque composant

(résistance, diode, condensateur, transistor, inductance) est fabriqué dans un matériau

différent, et ils sont reliés, mécaniquement et électriquement, par d'autres matériaux encore.

Cette approche hybride rencontre toutefois une limitation importante. Tandis que la fiabilité

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%