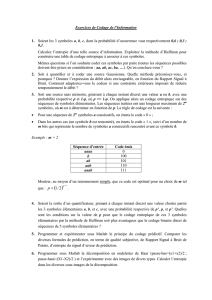

Examen de « Théorie de l`Information » Exercice I [8 points]: Débits

PHELMA/filière Sicom 2° année Octobre 2013

2 heures, documents de cours et calculatrice autorisés 2 pages

Examen de « Théorie de l’Information »

Exercice I

[8 points]

: Débits d’Information maximum transmissible de

manière fiable dans un modem quaternaire

• On suppose une source discrète simple S d’alphabet As = {s1, s2, …, s8} de taille N =

8 lettres, d’entropie H(S) = 2 Sh/lettre. Les lettres doivent être transmises en temps

réel à un débit littéral réglable D(S) lettre/sec.

• La source S subit un procédé de codage quaternaire qui la transforme en source X

(d’alphabet A

X

= {0, 1, 2, 3} de taille Q = 4 symboles élémentaires après codage).

• En sortie de codage, la source résultante de symboles quaternaires X, est envoyé dans

un modem quaternaire modélisé par un Canal Quaternaire paramétré par Pe

∈

∈∈

∈

[0 ;

1] de sortie Y et de matrice de transition du canal P(Y | X) donnée par :

P(Y| X) = 1− 0 0

0 1− 0

0 0 1−

0 0 1−

Le débit littéral dans le canal sera noté Dc, en symboles (quaternaires)/sec, de valeur

maximale Dc_max = 1 Msymb/sec. On désire transmettre le maximum d’information (soit

un débit d’information Ht (Sh/sec) maximum) de manière fiable et le but de l’exercice est de

donner les limites théoriquement atteignables pour 2 scénarios (sans et avec erreur).

1) Quelle est la redondance de la source, R(S) ?

2) Proposer, à titre d’exemple, un jeu de probabilité P

S

= {1/2, 1/4, 1/8, ?, ?, ?, ?, ?} tel que

H(S)= 2, en remplaçant les « ? » par des probabilités di-adiques (forme (1/2)

k

où k entier).

Dans la suite, on ne présupposera pas de jeu de probabilité particulier.

A) Scénario canal SANS ERREUR: on suppose d’abord que Pe = 0, et Y=X.

3) Quelle est la Capacité C (Sh/symb) de ce canal et le jeu de probabilité des symboles de X

qui permettent de maximiser l’Information mutuelle I(X,Y). Commenter.

4) En déduire la Capacité par unité de temps, Ct_max (Sh/sec), en supposant Dc = Dc_max.

Quel est le débit d’information maximal de la source, Ht_max, pour qu’il existe

théoriquement un procédé de codage assurant la transmission fiable à volonté (justifier) ?

5) Dans ce scénario, quel est le rôle et caractéristique (redondance, longueur moyenne) du

procédé de codage « ideal » (c’est-à-dire assurant le débit d’information maximal) ?

6) Quel est finalement, pour cette source redondante, le Débit littéral maximum D(S)_max

(en lettre/sec) pour qu’une transmission fiable soit possible.

B) Cas canal AVEC ERREUR: on suppose ici que Pe = 1/2.

Répondre aux mêmes questions que précédemment, en les numérotant de 3’) à 6’)

NB: pour la question 5’), décomposer le procédé de codage en 2 procédés successifs dont on précisera

objectifs et caractéristiques (redondance, nombre moyen de symboles de sortie/élément d’entrée).

Exercice II

[7 points] :

Codage de source

Soit une Variable Aléatoire S qui peut prendre N états dans As = {s

1

, s

2

, … , s

N

}, avec les

probabilités respectives Ps = { p

1

, p

2

, …, p

N

}.

1) Un code binaire dit « de Shannon » est un code tel que les longueurs li des mot-codes

sont choisies telles que :

li = plus petit entier égal ou supérieur à { log

2

( 1 / pi ) }, pour i = 1, …, N

1a- Montrer qu’il est possible de construire un code instantané avec ces longueurs.

1b- En procédant de la sorte, est-on assuré d’obtenir une longueur moyenne du code

binaire L égale à Lmin = H(S) ? Peut-on garantir sinon une valeur maximum pour L ?

Pour la suite de l’exercice, on fixe N = 4, et Ps = {1/12 ; 1/3 ; 1/3 ; 1/4 }.

2) Codage binaire

2a- Proposer un code binaire « de Shannon » de la V.A., et calculer son efficacité.

2b- Existe-t-il un code instantané plus efficace que le code « de Shannon » ? Justifier.

2c- Montrer qu'il existe deux ensembles différents (que l’on précisera) de longueurs {l

1

,

l

2

, l

3

, l

4

} de mot-codes, qui permettent de construire des codes instantanés optimaux

(codes dont l’efficacité ne peut être dépassée).

3) Codage ternaire de la source simple S ou de son extension d'ordre k :

3a- Donner un encadrement a priori de la longueur moyenne du code de Huffman ternaire

(en nombre de symboles élémentaires ternaires par états de la source) en fonction de k.

3b- Donner un code de Huffman ternaire pour k = 1, et vérifier l’encadrement précédent.

Exercice III

[5 points]

: Capacité de canal

Soit une Variable Aléatoire Discrète (V.A.D.) X à 3 états

∈

∈∈

∈

A

X

= {x1 ; x2

; x3} de distribution

de probabilité P

X

= {p

1

; p2

; p3 } injectée dans un canal dont la sortie est la V.A.D. Y à 4

états

∈

∈∈

∈

A

Y

= {y1 ; y2 ; y3 ; y4

} de probabilités P

Y

= { p(y

1

) ; p(y2) ; p(y3) ; p(y4) }

1) Donner la matrice de canal P(Y|X) complète, ainsi que le diagramme de transition,

sachant que : Pr(Y = y1 | X = x1) = Pr(Y = y2 | X = x2) = Pr(Y = y3 | X = x3) = 1-p;

et Pr(Y = y4 | X = xi) = p pour i =1,2,3. Note : p

∈

∈∈

∈

[0 ; 1] est un paramètre du canal.

2) Exprimer en fonction de p, ainsi que des probabilités d’entrée (p1, p2, p3) si nécessaire :

a- les probabilités de sortie P

Y

b- l’entropie conditionnelle H(Y|X).

c- l’expression de l’entropie H(Y). On arrangera l’expression sous la forme :

H(Y) = H

2

(p) + f

1

(p)×f

2

(p1,p2,p3), où H

2

(p) = -p.log

2

(p) – (1-p).log

2

(1-p),

et f

1

(p) et f

2

(p1, p2, p3) sont deux fonctions dont on précisera les expressions.

3) En déduire la capacité du canal en fonction de p, et le jeu de probabilité (p1,p2,p3) qui

permet de maximiser l’information mutuelle I(X,Y). Commenter les cas p = 0 et p = 1.

%------------------------------- Eléments de réponse

------------------------------------

Exercice I: Débits d’Information maximum transmissible de manière fiable

dans un modem quaternaire

Source discrète S de taille N = 8 lettres, au débit littéral réglable D(S) lettre/sec.

Procédé de codage quaternaire (alphabet A

X

= {0, 1, 2, 3} de taille Q=4).

Canal Quaternaire paramétrée par Pe

∈

[0 ; 1] de sortie de matrice de transition du canal:

P(Y| X) = 1− 0 0

0 1− 0

0 0 1−

0 0 1−

Débit littéral dans le canal Dc, en symb (quaternaires)/sec, avec Dc_max = 1 Msymb/sec.

1) Redondance de la source, R(S) = 1 – H(S)/lb(8) = 1 -2/3 = 1/3

2) Exemple de jeu de probabilité P

S

= {1/2 , 1/4, 1/8, 1/16, 1/64, 1/64, 1/64, 1/64} amènerait

à H(S) = ½ + (¼).2 + (1/8).3 + (1/16).4 + (1/64).6.4 = 2 Sh/lettre.

Autres jeux possibles P

S

= {1/2 , 1/4, 1/8, 1/32, 1/32, 1/32, 1/64, 1/64}

Ou P

S

= {1/2 , 1/4, 1/8, 1/16, 1/32, 1/64, 1/128, 1/128}, …

A Cas canal SANS ERREUR: on suppose d’abord que Pe = 0, et Y=X.

3) capacité C = lb(4)= 2 Sh/symb pour un canal quaternaire (N=M=4) sans erreur,

l’Information mutuelle I(X,Y) étant maximisée pour des symboles de X équiprobables

p(xi) =1/4, i= 0,1,2,3.

4) Capacité du canal par unité de temps est ainsi Ct = C.Dc soit Ct_max = 2MSh/sec.

Selon 2° th. Shannon, Débit d’information maximal (pour S ou X, car trans sans perte

temps réel) Ht max= Ct_max = 2 MSh/sec.

5) Dans ce scénario (canal sans bruit), le codeur idéal est un codage de source idéal (ou

compression) permettant de supprimer toute la redondance : Redondance du code = 0.

Longueur moyenne Lmin = H(S)/lb(Q) = 2/2 = 1 symb/lettre.

6) Nombreuses manières d’obtenir le résultat :

Conservation du Débit d’information : Htmax(S)= Htmax(X) = Htmax = 2Msh/sec.

Or Ht(S) = D(S).H(S) d’où D(S)max = Htmax/H(S) = Htmax/2 = 1Mlettre/sec.

Annexe : Autres manières de calculer ou vérifier, selon 2°theoreme de Shannon :

- La relation entre la redondance, le débit d’information et le débit littéral de la source peut

être donnée par : R(S) = 1 – H(S)/lb(Q) = 1 – H(S)D(S)/(D(S)lb(Q)), Soit R(S) = 1 –

Ht(S)/(D(S)lb(Q)) on en D(S)lb(Q) = Ht(S)/(1 – H(S)), Et ainsi D(S) = [ Ht(S)/(1 –

R(S))] / lb(Q). Donc D(S)max = [ Ct/(1 – R(S)] / lb(Q) = [2M/(1-1/3)]/3 = 1 Mlettre/sec

- l’Entropie à l’entrée du canal doit être au maximum égale à C, soit H(X) ≤ C = 2

Sh/symb. On peut en déduire une entropie de source H(S) = H(X)/Lmin egale au

maximum à 2Sh/lettre, et donc un débit d’information Ht = 2.D(S) au maximum égal à

Htmax = 2D(S)max, soit D(S)max = Htmax /2 = 1 Mlettre/sec.

- Ou encore, en X, on a Débit littéral Dc_max = 2Msymb/sec, ce qui entraine en moyenne

un débit littéral avant codage (idéal) de D(S)_max = Dc_max/Lmin = 1Mlettre/sec.

Cas canal AVEC ERREUR: on suppose la présence d’erreur dans le canal, tel que Pe = 1/2.

3’) Canal doublement Uniforme. D’après le cours,

C = lb(M) – H(Y|X = xi) = lb(4) – H2(Pe), obtenu avec la loi uniforme en entrée p(xi) =1/4,

i= 0,1,2,3..

Soit C = 2 – H2(1/2) = 1 Sh/symb.

Commentaire : Capacité divisée par 2 par apport au cas sans bruit.

A noter que malgré Pe = 0.5, la capacité n’est pas nulle dans le canal quaternaire. Une

manière fiable de transmettre pourrait d’ailleurs être de n’utiliser que x1 et x3 en entrée, avec

ainsi un canal binaire sans bruit en regroupant en sortie y1,y2 d’une part, et y3,y4 d’autre part.

4’) D’où Ct_max = C.Dc_max = 1 MSh/sec.

Selon 2° th. Shannon, Débit d’information maximal (pour S ou X, car trans sans perte

temps réel) Ht max= Ct_max = 1 MSh/sec.

5’) D’après C. Shannon, le procédé de codage peut-être décomposé, sans perte d’optimalité en

1 codeur de source suivi d’un codeur de canal.

• Caractéristiques du codeur de source idéal (idem codeur scénario précédent),

soit Redondance = 0 ; Longueur Moyenne : Lmin = 1symb/lettre.

• Caractéristiques du codeur de canal idéal,

soit Redondance minimum = 1 – C/lb(Q) = 1 -1/2 = 50% (qui correspond aussi au taux

de codage pcc = 1-k/n, d’où k/n = 1/2)

Longueur Moyenne : n/k = 2 symb quaternaire de sortie /symb quaternaire d’entrée.

6’) On a toujours D(S)max = Htmax/H(S) = Htmax/2 = ½ Mlettre/sec.

- ou autre manière par la redondance :

D(S)lb(Q) = Ht(S)/(1 – H(S))

Et ainsi D(S) = [ Ht(S)/(1 – R(S))] / lb(Q)

Donc au maximum :

D(S)max = [ Ct/(1 – R(S)] / lb(Q) = [1M/(1-1/3)]/3 = 1/2 Mlettre/sec

- Annexe : ou encore par les débits :

S (dim N=8) -> c. source -> S’ (dim Q=4) -> c. canal (dim Q=4) -> X -> canal -> Y

D’où Dc = D(X) = (n/k).Lmin.D(S) soit Dc = 2D(S) et

donc D(S)_max = Dc_max / 2 = ½ Mlettre/sec

Exercice II Codage de source

Soit une Variable Aléatoire S qui peut prendre N états dans As = {s

1

, s

2

, … , s

N

}, avec les

probabilités respectives Ps = { p

1

, p

2

, …, p

N

}.

1) Un code binaire « de Shannon » est tel que li = arrondi sup { log

2

( 1 / pi ) },

1a- Cf cours si li* = log2(1/p1) on sature l’inégalité de Kraft (CNS d’existence de codes

instantanés) , d’où Kraft vérifié avec des longueurs idem ou plus longues.

.

1b- En procédant de la sorte, on est assuré d’obtenir H(S) ≤ L < H(S) + 1 (Cf cours).

Pour la suite de l’exercice, on fixe N = 4, et Ps = {1/3 ; 1/3 ; 1/4 ; 1/12}.

2) Codage binaire

2a- Proposer un code binaire « de Shannon » de la V.A., et calculer son efficacité.

P par ordre décroissant : 1/3, 1/3, ¼, 1/12

Log2(1/pi) 1.58 1.58 2 3.58

Li*= entier ≥{ Log2(1/pi)} 2 2 2 4

Exemple de code 00 01 10 1100

Lmin = H(S) = 1.855 Sh

L = 2.17 d’où une efficacité de 85%

2b- existe-t-il un code instantané plus efficace que le code de Shannon ? oui, il suffit de

prendre un mot-code plus court pour la probabilité 1/12. On peut prendre 11 et on a toujours

un code instantané (condition de préfixe OK) de longueur moyenne L = 2.

2c- Montrer qu'il existe deux ensembles différents de longueurs (l

1

, l

2

, l

3

, l

4

) de mots de code

optimaux. En faisant le code binaire de Huffman qui est optimal , on trouve le code

1 00 010 011, de jeu de longueur {1, 2, 3, 3} et de longueur moyenne

L= 1/3.1 + 1/3.2 + ¼.3 + 1/12.3 = 2. D’où ce jeu de longueur et le jeu de longueur {2, 2, 2,

2} sont optimaux.

4) Codage de Huffman ternaire de la source simple S ou de son extension d'ordre k.

3a- encadrement a priori de la longueur moyenne du code ternaire (en nombre de

symboles élémentaires ternaires par états de la source) en fonction de k, selon le cours :

H(S)/lb(Q) ≤ L < H(S) /lb(Q) + 1/k soit ici 1.855/1.58 ≤ L < 2.855/1.58 +1/k

1.174 ≤ L < 1.174 + 1/k

3b- code de Huffman ternaire pour k = 1 : 0, 1, 20, 21,

Attention, voir qu’il faut rajouter au départ 1 message de probabilité nulle pour pouvoir

regrouper à chaque étape Q = 3 éléments jusqu’à la racine et obtenir le code de Huffman

optimum (sinon facile de voir que le code obtenu peut être raccourci …).

Soit L= 1/3.1 + 1/3.1 + ¼.2 + 1/12.2 = 4/3

On vérifie bien : 1.174 ≤ 1.33 < 1.174 + 1/1 = 2.174

Exercice III

[6 points]

: Capacité de canal

Soit une Variable Aléatoire Discrète (V.A.D.) X à 3 états

∈

∈∈

∈

A

X

= {x1 ; x2

; x3} de distribution

de probabilité P

X

= {p

1

; p2

; p3 } injectée dans un canal dont la sortie est la V.A.D. Y à 4

états

∈

∈∈

∈

A

Y

= {y1 ; y2 ; y3 ; y4

} de probabilités P

Y

= {p(y

1

) ; p(y2) ; p(y3) ; p(y4) }

1) On connait une partie des probabilités conditionnelles, dépendant de p

∈

∈∈

∈

[0 ; 1] :

Pr(Y = y1 | X = x1) = Pr(Y = y2 | X = x2) = Pr(Y = y3 | X = x3) = 1-p;

6

6

1

/

6

100%