@let@token Apprentissage de Données Massives @let@token

Introduction

Environnements technologiques

Cas d’usage

Conclusion

Apprentissage de Donn´

ees Massives

Trois cas d’usage avec R, Python et Spark

Philippe Besse, Brendan Guillouet et Jean-Michel Loubes

Universit´

e de Toulouse

INSA – Dpt GMM

Institut de Math´

ematiques – ESP

UMR CNRS 5219

Besse et al. — JES 2016 Grosses Data

Introduction

Environnements technologiques

Cas d’usage

Conclusion

Objectif

Nouvelle Science des Donn´

ees

Contenu

Objectif

Question : Quelle (meilleure) technologie utiliser pour

l’apprentissage sur donn´

ees massives ?

Grosses data ? RAM, DD ?

Mat´

eriel : Poste personnel, serveur, Cloud ?

Donn´

ees distribu´

ees (Hadoop) ?

Comparaisons de difficiles `

a impossibles

Point de vue du ”statisticien”

Prototype puis passage `

a l’´

echelle du mˆ

eme code

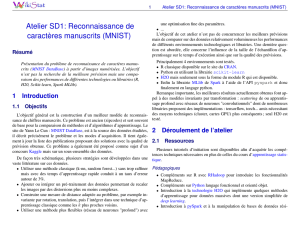

Trois cas d’usage : MNIST, MovieLens, Cdiscount

M´

ethodes et algorithmes : pr ´

eparation, RF, NMF, Logit

Trois environnements : R `

a Python, Python `

a Spark ?

Scripts dans http://github.com/wikistat

Besse et al. — JES 2016 Grosses Data

Introduction

Environnements technologiques

Cas d’usage

Conclusion

Objectif

Nouvelle Science des Donn´

ees

Contenu

Nouvelle ( ?) Science des Donn ´

ees

1995 Data Mining : Gestion de la Relation Client, suites

logicielles (Friedman, 1997)

2010 Data Science : Publicit´

e en ligne, Hadoop, cloud

computing (Donoho, 2015 ;

beamergotobuttonBesse et Laurent, 2016)

Donn´

ees pr´

ealables (fouille), dimensions (omiques) p>> n,

Pas de nouvelles m´

ethodes, seules celles ´

echelonnables

Data pas toujours Grosses mais datification du quotidien

´

Ethique et virtualisation / transparence de la d´

ecision

Science des donn´

ees : nouveau terme d’erreur

Erreur d’optimisation + Compromis biais / variance

Optimisation stochastique (Robbins Monro) ; non

diff´

erentiable

Parall´

elisation des librairies de calcul

Nouveau mod`

ele ´

economique

Besse et al. — JES 2016 Grosses Data

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

1

/

38

100%