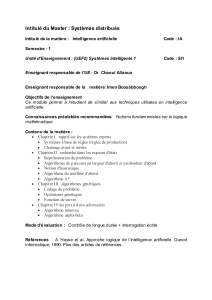

Intelligence artificielle : implémenter l`éthique dans une machine

1

ira91

Intelligence artificielle : implémenter l’éthique dans une

machine intelligente

2

Démarche :

Les mathématiques et l’informatique ont toujours suscité en moi une vive curiosité qui

m’a conduit, sans surprise, à étudier de plus près le monde de l’intelligence artificielle (IA).

C’est au cours de mes expériences professionnelles dans le développement

informatique que j’ai pu constater, à mes dépends, toute la puissance et l’ampleur de cette

technologie. Mais c’est en apprenant à la fin de mon stage que mes algorithmes de

simplification des processus avaient provoqué le départ d’un employé de l’entreprise que la

notion de morale vint frapper à ma porte. A l’époque inconscient des problèmes éthiques

impliqués dans l’IA, ce n’est que par la transversalité de ma formation en école de commerce

que ma réflexion morale s’est affinée sur ce sujet. A titre personnel, cet essai fut l’opportunité

de creuser une réflexion trop souvent mise de côté autour d’un sujet qui me passionne.

Devant toute l’ingéniosité humaine de ce monde, je ne peux être qu’admiratif envers

de telles avancées et c’est d’un œil attentif que je suis de près cette évolution passionnante.

Sans être alarmiste, cet essai est avant tout une prise de conscience des enjeux futurs

de notre société conduit par l’IA. Une civilisation qui connaitra une avancée technologique

incroyable mais ou les questions éthiques seront remis au centre de tous les débats.

Résumé :

Dans cet essai il sera question, dans un premier temps, de faire l’état de l’art de

l’intelligence artificielle, de ses bénéfices à ses menaces, et d’introduire les notions éthiques

engagées à ce domaine.

Puis la seconde partie portera sur les grands dilemmes éthiques provoqués par l’arrivée

d’une telle technologie dans notre société. Les questions de déontologie, d’éthique sociale et

économique ou encore de roboéthique seront levées

Enfin pour conclure, je tenterai d’apporter des axes de réponses à sur les enjeux

d’implémenter l’éthique dans les machines intelligentes de demain ou du moins d’en donner

mes recommandations.

Bibliographie indicative :

Asimov J. 1968 - I, Robot, collection “Club du livre d’anticipation”.

Barrat J. 2015 - “Why Stephen Hawking and Bill Gates Are Terrified of Artificial

Intelligence”, The Huffington Post.

Bostrom N. 2014 - Superintelligence: Paths, Dangers, Strategies, OUP Oxford.

Bostrom N. 2015 - What happens when our computers get smarter than we are ? [en

ligne], consultable sur : https://www.ted.com/ , [consulté le 19/01/2016].

Howard J. 2014 - The wonderful and terrifying implications of computers that can learn

[en ligne], consultable sur : https://www.ted.com/, [consulté le 01/02/2016].

Lanier J. 2014 - Who Owns the Future, Simon & Schuste.

Moore G. 1965 - Cramming More Components Onto Integrated Circuits, McGraw-Hill.

Müller V., Bostrom N., 2014, Future progress in artificial intelligence: A Survey of Expert

Opinion, Berlin, Springer.

Naughton J., 2016, “Can Google’s AlphaGo really feel it in its algorithms?”, The

Guardian.

3

Rield M. et Harrison B. 2015 – “Using Stories to Teach Human Values to Artificial

Agents”, School of Interactive Computing, Georgia Institute of Technology.

Rotman D. 2013 – “How Technology Is Destroying Jobs”, MIT Technology Review.

Shannon C. 1950 – “Programming a Computer for Playing Chess”, Philosophical

Magazine, Ser.7, Vol. 41, No. 314

Von Neumann J. 1966 - The Theory of Self-reproducing Automata, Urbana & London

Introduction

A l’été 2015 de célèbres scientifiques se réunissent au siège sociale de Google pour

discuter sereinement d’une possible fin de l’humanité d’ici la fin du siècle. Si cette scène parait

tout droit tirée d’un roman de science-fiction, elle s’est en réalité bien produite. Une telle

hypothèse, par ailleurs loin d’être sans fondements, inscrit l’humanité au bord d’une nouvelle

ère majeure qui ne saurait tarder.

Face à de tels enjeux, il semble important de se préparer à accueillir ce changement.

Or dans un monde où la machine deviendra l’entité la plus intelligente, il est primordial qu’elle

bénéficie d’une morale. La lourde tâche d’implémenter l’éthique dans l’intelligence artificielle

s’inscrit d’ores et déjà comme le défi cette nouvelle ère.

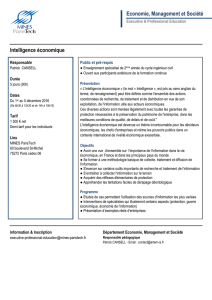

I. L’IA aujourd’hui et demain

Aujourd’hui, une technologie séduisante …

L’intelligence artificielle est une science consacrée à donner à un système informatique

des capacités cognitives comparables au raisonnement humain pour améliorer notre qualité

de vie. A l’inverse des machines programmées à prendre des décisions précises paramétrées

à l’avance, l’IA est en capacité d’apprendre de ses expériences et d’adapter son comportement

en conséquence à la manière de la réflexion humaine. Pour mieux comprendre ce procédé,

prenons comme exemple un jeu d’échec en ligne. Les ingénieurs en charge de développer le

programme du joueur virtuel peuvent avoir deux approches différentes : développer une partie

des combinaisons de déplacements possibles pour chaque pièce du jeu, qui peuvent

représenter jusqu’à 10120 combinaisons (nombre de Shannon

1

) à paramétrer. Ou bien, ils

peuvent décider de créer un algorithme d’apprentissage, par une approche statistique, qui

permet aux systèmes d’apprendre progressivement à mesure de ses déplacements aléatoires.

Ainsi, après plusieurs parties, l’algorithme a identifié quelles combinaisons ont la plus grande

probabilité d’aboutir au succès en adaptant leur jeu. On dira de la deuxième solution qu’elle

utilise une intelligence artificielle. Depuis sa création, estimée en 1956, cette science a suscité

bien des controverses, mais accuse aujourd’hui des résultats pour le moins prometteurs.

Le 28 janvier 2016, le champion d’Europe du jeu de Go se voit battre par l’intelligence

artificielle AlphaGo

2

, conçu par Google. Une performance encore jamais réalisée jusqu’ici tant

le jeu de Go représente le jeu de plateau le plus complexe au monde (10600 combinaisons

possibles). Mais cette technologie ne se contente pas seulement de battre des records dans

les jeux vidéo, elle excelle aussi dans bien d’autres domaines. On la retrouve notamment dans

nos systèmes de prêts bancaires, dans les drones militaires, ou encore dans nos smartphones

avec la reconnaissance vocale.

1

Le nombre de Shannon n’est qu’une estimation de la complexité du jeu d’échec. À titre de comparaison,

la physique actuelle donne une estimation du nombre d'atomes dans l'univers observable de 1079

2

AlphaGo représente une amélioration significative par rapport aux précédents programmes de go. Sur 500

parties jouées AlphaGo n’en a perdu qu’une.

4

… demain, une puissance effrayante…

Le contexte chronologique selon les experts aide à comprendre la situation dans laquelle

s’inscrit l’Intelligence Artificielle en découpant cette dernière en 3 états d’avancements :

- L’intelligence artificielle étroite (ANI) : représente les algorithmes aussi

performant et compétents que l’homme (voire plus dans certains domaines) mais

qui ne peut se concentrer que sur une tâche étroite (gagner une partie d’échec par

exemple). Aujourd’hui les scientifiques considèrent cette première catégorie

comme atteinte et devrait dans les prochaines années se décliner dans plusieurs

domaines (automobile, musique…)

- L’intelligence artificielle générale (AGI) : est un algorithme capable de devenir

aussi performant que l’homme dans tous les domaines. Cette dernière se

différencie de l’ANI par sa capacité à dépasser sa fonction principale. De cette

façon en élargissant ses domaines de connaissance, elle s’élève au niveau de

l’intelligence humaine. Aujourd’hui cette technologie ne relève plus de la science-

fiction, pour autant, il n’existe pas à ce jour de solution de type AGI.

- La Superintelligence artificielle (ASI) : Enfin l’ASI, qui préoccupe les plus grands

savants de ce monde

3

, serait l’aboutissement de l’intelligence artificielle. Une fois

l’intelligence humaine égalée (AGI), il semblerait logique que ce procédé dépasse

bien largement les compétences humaines.

Malgré la transparence de ces recherches, la société actuelle a tendance à sous-estimer le

temps que prendra cette nouvelle ère à arriver. En effet, d’après un sondage sérieux réalisé

auprès de 550 experts en IA, 90% affirment que les avancées scientifiques accèderont à l’AGI

d’ici 2075 et à la Superintelligence d’ici 2100. Cette étude s’appuie notamment sur la loi de

Moore qui indique que la puissance des processeurs de nos ordinateurs double tous les 18

mois

4

.

… et l’éthique dans tout ça

Avant de mieux comprendre l’éthique appliquée à l’IA, revenons à la propre définition

de l’éthique qui vise à réfléchir les fondements de la morale. On peut également définir

l’éthique comme une réflexion sur les comportements à adopter pour rendre le monde

humainement habitable. C’est à partir de cette approche que l’on comprend rapidement la

complexité de définir l’éthique appliquée aux machines.

Les questions éthiques appliquées à l’intelligence artificielle relèvent de la roboéthique.

Cette science ne concerne le robot qu’indirectement, elle est en réalité centrée sur l’homme

de sa conception à son utilisation des machines. La roboéthique, malgré sa complexité et son

étendu, peut être synthétisée par les 3 lois d’Isaac Asimov

5

:

- Un robot ne peut porter atteinte à l'humanité, ni, restant passif, laisser l'humanité

exposée au danger.

3

Stephen Hawking, Bill gates et Elon Musk voient en l’avènement de ces technologies un danger pour la race

humaine

4

Sans démonstration scientifique à cette conjecture, la loi de Moore, depuis 1970, s’est globalement vérifié

5

Malgré les controverses, les 3 lois d’Asimov sont aujourd’hui considérées comme étant les 3 lois de la

robotique contemporaine.

5

- Un robot doit obéir aux ordres donnés par les êtres humains, sauf si de tels ordres

sont en contradiction avec la première loi.

- Un robot doit protéger son existence dans la mesure où cette protection n'est pas

en contradiction avec la première ou la deuxième loi.

Conscient que ces lois ne soient pas suffisantes à une définition précise de cette philosophie,

elles sont cependant précieuses dans l’application de l’intelligence artificielle aux bénéfices de

l’humanité.

II. Quand la machine rencontre la morale

L’IA face à des décisions morales

Le propre de l’IA est d’exercer un apprentissage, à la manière de l’Homme, afin de

pouvoir prendre les meilleures décisions concernant son domaine d’activité. Or en lui attribuant

des responsabilités jusqu’ici humaines, l’IA s’expose à prendre des décisions morales. La

« Google Car », par exemple, se donne pour objectif de transporter, en toute sécurité et sans

chauffeur, des passagers à l’intérieur d’une voiture munis d’une intelligence artificielle.

Imaginons qu’un jour, dans des conditions particulières, un enfant traverse soudainement la

route, la distance est trop courte pour s’arrêter. Le système se retrouve donc en face d’un

dilemme éthique : percuter l’enfant à pleine vitesse ou l’éviter et foncer dans un mur. Quelle

décision fera le moins de dégâts humains ? La vie des passagers est-elle plus importante que

celle de l’enfant ? Cet exemple illustre parfaitement toute l’importance de l’existence d’une

moralité algorithmique dans ces machines.

Mais alors, quel statut moral doit-on attribuer à l’IA ? Définir à qui ou quoi s’adresse le

statut moral semble être la première étape de cette réflexion. D’après la Stanford Encyclopedia

of Philosophy, une entité à un statut moral si et seulement si son propres intérêt moral a une

certaine importance pour le bien-être de l'entité, de sorte qu’il puisse être lésé. Par exemple,

une pierre peut être lancée, cassée, sans que cela puisse avoir de l’importance pour elle. A

l’inverse l’Homme possède un statut moral et ne peut être traité de la sorte à partir du moment

où il va ressentir de la douleur. En revanche les machines ne bénéficient pas de morale depuis

que l’on peut modifier, copier, supprimer son programme sans que celui-ci éprouve de

l’importance dans ces faits. Bien que cette idée soit largement répandue dans notre société,

l’évolution de l’intelligence artificielle vient remettre en question cette conjecture. Philosophes

et scientifiques sont d’accord sur deux critères fortement liés au statut moral :

Sentience : désigne la capacité d'éprouver des choses subjectivement, d'avoir des

expériences vécues, des qualias.

Sapience : désigne la capacité liée à la haute intelligence, tel que la conscience de soi,

la tempérance ou la sincérité.

Or l’Homme attribue un statut moral aux animaux capables d’éprouver de la souffrance et donc

de la sentience. Les jeunes enfants, ou encore les adultes atteint de retard mental sévère, ne

satisfont pas les critères de la sapience, pour autant, ils sont de toute évidence, considérés

comme des personnes morales. Une machine sentiente capable de qualia serait donc

considérée comme une entité possédant un statut moral au même titre que les animaux. Or

l’intelligence artificielle aura bien vocation à se doter de ces deux critères de la morale. Cette

nouvelle ère hisserait l’IA à devenir une entité ayant le même statut moral que l’être humain

adulte. Une telle évaluation morale est appuyée par le Principe du Substrat de Non-

6

6

7

7

8

8

9

9

1

/

9

100%