L`information active, la signification et la forme

L'information active, la signification et la forme

F. David Peat – source: http://www.fdavidpeat.com/bibliography/essays/fzmean.htm

Résumé

Il est suggéré, dans l'esprit d’une réflexion ouverte, que la science est maintenant

prête à s’adapter à un nouveau principe, celui d'information active, qui prendra sa place à

côté des concepts d'énergie et de matière. L'information est reliée aux concepts tels que la

forme et la signification, qui actuellement sont discutés dans une variété de domaines de la

biologie à la neurologie, dans les études sur la conscience et la nature du dialogue. Elle

peut fournir le facteur d'intégration entre l'esprit et la matière.

Le principe d'information a un potentiel considérable, il soulève une foule de

questions dont la clarification et la résolution peut aider à améliorer notre compréhension

dans d'autres domaines.

Introduction

Vers la fin des années 80, David Bohm a présenté la notion d'information active dans

son interprétation ontologique de la théorie quantique. Son idée était d'employer l'activité de

l'information comme manière d'expliquer la nature réelle des processus quantiques et, en

particulier, la manière avec laquelle des résultats physiques simples émergent d'une

multitude de possibilités. Initialement cette idée d'information comme activité physique, a été

attachée à la théorie particulière de Bohm, mais, comme cet article le propose, il est possible

d'aller plus loin et d'élever l'"information" au niveau d'un nouveau concept physique, qui peut

être placé à côté de celui de matière et d'énergie.

L'information se relie aux faisceaux d’idées fertiles discutées en physique, en

biologie, en recherche sur la conscience et en neurosciences. Celles-ci sont groupées autour

des notions d'information, de forme et de signification, dont chacune est abordée ci-dessous.

Actuellement, nous ne savons pas clairement comment ces idées s’intégreront

finalement ensemble, mais la résonance entre elles est frappante et devrait fournir un noyau

propice pour plus de recherches et de spéculations. C’est en physique que la notion

d'information est bien établie, pourtant elle a une application immédiate dans l’étude de la

conscience, par exemple. De telles idées sont également particulièrement riches par la

manière dont elles se relient à de nouvelles approches dans les domaines de la santé, de la

thérapie, du dialogue et de la cohésion sociale.

Quand les idées commencent à affluer ensemble de cette façon, ceci suggère qu'une

percée fondamentale dans la connaissance est sur le point d’arriver. Pensons à

l'enchaînement des approches et des notions abordées dans les premières années de ce

siècle et comment elles se sont finalement fusionnées dans la théorie de la relativité et la

théorie quantique. De semblables discussions non définies abondent aujourd'hui au sujet de

la nature de l'esprit, de la fonction de la conscience et du cerveau, du pré-espace et des

algèbres qui sous-tendent la théorie quantique, et de la nature de la santé et de la thérapie.

L'information est quelque chose qui pourrait jouer un rôle significatif dans la compréhension

de la nature de l'univers physique et, en même temps, pourrait avoir un rôle principal dans

les opérations réalisées par la conscience. Les concepts de signification, de forme et

d'information pourraient jouer un plus grand rôle d'intégration en apportant une unification de

secteurs entiers de la recherche.

Les différents concepts d'information, de forme et de signification, ainsi que leurs

interconnexions, sont discutées ci-après. Des questions sont ensuite posées et des

directions pour des travaux futurs sont suggérées.

L'information

À première vue, l'"information" ne joue aucun rôle dans le monde de la physique. Les

faits, les données et l'information sont contenus dans les livres, ou assemblés par des

scientifiques, mais n'ont aucune existence indépendante et objective dans le monde

physique indépendamment de leur interprétation par les humains. La "théorie de

l'information" de Shannon et Weaver, par exemple, concerne la manière dont les données

sont transmises : voyages des bits d'information le long d'une ligne téléphonique ou dans

d'autres systèmes de transmission. La "signification" d'un message particulier est non

pertinente, ce qui est significatif est seulement le mécanisme de son codage et du décodage,

plus les rôles relatifs joués par le bruit et la redondance.

Pourtant une recherche plus profonde suggère que les choses sont plus subtiles et

moins évidentes. La notion de l'entropie, par exemple, est présente en théorie de

l'information et en thermodynamique. C'est un autre concept qui a commencé par une

ontologie incertaine. D'un côté en thermodynamique, l'entropie est liée à des variables bien

définies, comme la température et l’énergie thermique, d’un autre côté, le mot entropie

désigne de façon subjective un degré de "désordre" dans un système, ou une décomposition

de l'ordre et de l'information, ou la dégradation de la teneur en information d'un message.

Il y a la question de la quantité d’informations exigée pour définir un système. Un

système apparemment "ordonné", montrant un comportement strictement périodique, exige

peu d'informations pour sa définition. Des systèmes fortement complexes ou aléatoires,

d'autre part, sont définis par une quantité d'informations potentiellement infinie. Mais est-ce

que ces mesures sont purement objectives ou dépendent-elles toujours d'un certain sujet

humain qui leur attribue une signification ? Prigogine essaye de replacer le concept de

l'entropie dans une base objective plus claire mais le débat continue toujours.

Le mystère de l'information s’approfondit encore avec la découverte de Beckenstein

de la relation entre la quantité d'information passant par un horizon d'événements, la teneur

en entropie, et le rayon d'un trou noir. Voici une définition totalement objective et quantitative

de l'information dans la physique. (Dans ce cas-ci, cependant, c'est la quantité d'information

plutôt que son contenu ou sa signification réelle qui est significative.) La section ci-dessous,

sur la forme, discute également des façons dont la forme (reliée à l'in-form-ation) joue un rôle

significatif dans la physique quantique.

La percée théorique qui a donné à l'information plus de rôle "physique" est venue

avec la proposition de Bohm, disant que l'information joue un rôle actif dans des

systèmes quantiques. Les écrits de Bohm de 1952 sur les variables cachées ont proposé

une approche alternative à la théorie quantique dans laquelle l'électron est une vraie

particule guidée par un nouveau genre de force, le potentiel quantique. Tandis qu'à

première vue la théorie de Bohm semble légèrement "classique" - les électrons ont de vrais

chemins - le potentiel quantique est entièrement nouveau. À la différence de tous les

autres potentiels dans la physique, ses effets ne dépendent pas de la force ou de la

"taille" du potentiel mais seulement de sa forme. C'est pour cette raison que les objets

éloignés peuvent exercer une influence forte sur le mouvement d'un électron.

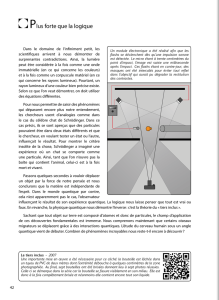

Dans l’ expérience de la double fente, une expérience de changement de paradigme

dans la théorie quantique, les effets des fentes sont subits par des électrons localisés à

plusieurs centimètres de distance. C'est très difficile à expliquer en termes conventionnels

mais ça devient tout à fait naturel une fois qu'un potentiel quantique a été introduit. En effet,

c'est ce potentiel quantique qui est responsable de tous les effets nouveaux montrés par la

théorie quantique. La forme du potentiel quantique est extrêmement complexe et reflète le

déploiement physique entier d'une mesure quantique. La complexité de sa forme est

également ce qui provoque l’apparence aléatoire des processus du monde quantique, tels

que la désintégration d'un noyau radioactif, ou la nature duelle onde-particule de l'électron.

L'approche de Bohm dans sa propre théorie est devenue de plus en plus subtile au

cours des années et il a commencé à parler non seulement de la forme du potentiel

quantique mais également de l’"information" qu’elle contient. L'action du potentiel quantique

n’est pas de pousser ou de tirer l'électron le long de son chemin. Bohm l’a comparée plutôt à

un signal de radar qui guide un bateau approchant un port. L'information dans le signal de

radar agit, par l'intermédiaire d'un ordinateur ou d'un dispositif de direction automatisé, sur le

changement de direction du bateau. L'information elle-même ne pousse pas le bateau, elle

"informe" plutôt l'énergie brute des moteurs.

L'information permet donc une distinction entre ce qui pourrait s'appeler énergie pure

ou "non formée" et une énergie plus subtile, une activité qui peut être identifiée avec de

l'information. Cette information agit sur l'énergie pure pour lui donner la forme.

Les versions postérieures de la théorie de Bohm ont décrit l'électron pas tellement

comme une vraie particule physique mais plutôt comme un processus, une vague

s'effondrant continuellement vers l'intérieur dans une région localisée et s’étendant alors à

l'extérieur. Ce processus est guidé par un potentiel super-quantique. Une activité de

l'information est responsable de l’existence des particules quantiques et des événements

quantiques.

En discutant le problème de la mesure quantique, Bohm et ses collègues ont un peu

plus développé la notion "d'information active". Prenez l’expérience de la double fente

comme exemple. Dans la théorie de Bohm, un électron a la potentialité pour prendre une

multiplicité de chemins qui traversent l'une ou l'autre des deux fentes. Dans la réalité, un

électron prend seulement un chemin simple. Bohm a suggéré que le potentiel quantique

contient des informations sur l'installation expérimentale. Cette information est

potentiellement en activité, mais une fois que l'électron "a choisi", et à commencé à se

déplacer le long d'un chemin particulier, alors les informations sur les chemins alternatifs

deviennent inactives.

Pour des raisons d'espace, c'est une simplification exagérée de l'approche de Bohm,

mais l'idée essentielle devrait être claire. Des informations, dans ce cas-ci sur le contexte

d'une installation expérimentale, sont diffusées dans une sorte de forme active, au niveau

quantique. Cette information agit directement sur la matière, (par exemple par l'intermédiaire

de la forme qu'elle impose au "non formé"). L'information est employée d’une manière

objective. Elle n'est pas quelque chose qui dépend du point de vue d'un observateur humain.

La nature réelle de l'information et la manière dont elle est portée n'est pas encore

entièrement claire. Est-il vraiment correct, par exemple, de parler d'un "champ" d'information,

puisque l'information ne diminue pas avec la distance, et n'est pas liée non plus à l'énergie

dans le sens habituel. Probablement la notion de champ devrait être élargie ou, au niveau

quantique, nous devrions parler des structures du pré-espace, ou au sujet des relations

algébriques qui précèdent la structure de l'espace et du temps.

La notion de Bohm "d'information active" est attachée à son "interprétation

ontologique" (autrefois l'interprétation de la variable causale ou cachée). Je propose que ce

ne soit plus limité à une théorie particulière mais que cela soit élevé au niveau d'un principe

général. Bohm n'a jamais considéré que son interprétation ontologique était le dernier mot

sur la théorie quantique, mais il a suggéré plutôt des pistes pour les recherches ultérieures.

Je crois qu'une des plus valables est cette notion d'information.

La physique newtonienne a été concernée par les mouvements de la matière sous

les forces et le contact mécanique. La physique du dix-neuvième siècle a généralisé la

notion d'énergie, en tant que cause des transformations, des réarrangements et des

mouvements de la matière. Je propose que l'information soit l'élément final dans une triade

- l'information est ce qui donne sa forme à l'énergie. (c'est l'énergie "subtile" selon la science

orientale.) L'information aurait une nature objective. Elle jouerait un rôle actif en donnant la

"forme" à l'énergie et serait responsable des processus quantiques. Comme un "champ"

d'information active, elle fourni une forme collective et globale pour un supraconducteur ou

un super-fluide. L'information serait un aspect des lois physiques, mais serait également

corrélée à des éléments plus subjectifs tels que le signe et la signification. En particulier,

l'information peut être responsable des processus globaux dans le cerveau et avoir un rôle à

jouer dans la nature de la conscience.

On peut avancer que, en donnant à l'information un rôle actif dans la science, le

visage de la physique changera. Mais ceci s'est déjà produit plusieurs fois avant. À chaque

occasion, des notions plus subtiles ont été présentées. La thermodynamique, par exemple,

est née de la transformation calorique d'un fluide en un concept immatériel : l’énergie.

L'électromagnétisme s'est avéré ne pas être le résultat des vibrations mécaniques dans un

éther mais la manifestation de la notion plus subtile de champ. Dans notre siècle actuel, la

notion "des éléments indépendants de la réalité" a été abandonnée au niveau quantique, les

propriétés physiques ont été découvertes comme n’étant pas intrinsèques aux objets mais

dépendantes du contexte. La force de la pesanteur s’est fondue dans la géométrie. Dans

chaque cas, le mouvement est allé du matériel et mécanique vers le subtil. L'information

pourrait être la prochaine étape dans cette évolution des idées. Son rôle d'intégration

s’étendrait au-delà de la physique, la biologie et l'étude de la conscience.

Dans les deux sections ci-dessous, les relations de l'information à la forme et à la

signification sont discutées.

Forme

La Forme est un concept-clé en biologie. Toute fonction, depuis l'activité d'une

enzyme jusqu’à celle d’une cellule ou d’un organe est liée à sa forme matérielle. La

croissance de la cellule fécondée jusqu’à l'adulte est un processus de différentiation et de

transformation de forme ; par conséquent les biologistes, d'Aristote à Waddington, en

passant par Sheldrake et Goodwin ,ont postulé des notions de « champs morphiques ».

La nature universelle de la forme et de sa transformation était, dans les années 60, le

sujet d'une nouvelle branche des mathématiques : la théorie des catastrophes de René

Thom. La forme a été associée à l'idée de Gestalt, de configuration, de modèles

globaux, de perception et de non-localité ; de telles notions se relient au

fonctionnement de la conscience et au système immunitaire.

La forme a son rôle à jouer dans la physique. Dans la physique classique, c'est la

forme d’un hamiltonien qui reste invariable sous des transformations canoniques. De cette

façon, la mécanique newtonienne peut être transformée de l'interaction mécanique de

différentes particules en processus de préservation globaux. De même, la relativité générale

concerne l’invariance de la forme sous toutes les transformations coordonnées possibles.

Dans ce sens, le mouvement sous la pesanteur s’exerce avec la conservation de la forme.

On pourrait peut-être généraliser le concept d'inertie à celui de "loi de persistance de la

forme".

La forme apparaît le plus nettement sous le couvert de la fonction d’onde. C'est la

forme globale de la fonction d’onde qui (symétrique ou antisymétrique) est responsable de

l'existence des statistiques de Fermi-Dirac ou de Bose-Einstein. Le fait que de telles formes

soient non-factorisables (dans des composants de l'espace indépendants) est la raison

profonde de la non-localité quantique (la corrélation mystérieuse de Bell entre les particules

éloignées). La forme de la fonction d’onde est finalement responsable des modes

collectifs dans la physique - plasma, super-fluide, supraconducteur et systèmes

hypothétiques de Frohlich. (cf http://fr.wikipedia.org/wiki/Th%C3%A9orie_BCS). La forme de

la fonction d’onde orchestre chacune des particules (en nombre astronomique) dans une

danse fortement coordonnée.

Le potentiel quantique de Bohm est unique parce que l'importance de ses effets sur

le mouvement des électrons, ne résulte pas de sa force ou de son intensité mais de la

"forme" du potentiel, c.-à-d., sa forme complexe particulière. C'est pour cette raison que les

effets du potentiel quantique ne diminuent pas avec l’augmentation de la distance et

que les objets quantiques bien séparés peuvent demeurer fortement corrélés. (cf aussi

http://trans-science.cybernetique.info/fr/pilofut.htm)

Il est fortement probable que la forme puisse également être responsable des

propriétés quantiques globales du cerveau qui provoquent la conscience. La Forme, une

propriété globale par opposition aux locales, peut avoir quelque chose à faire avec l'évolution

de la structure de l'espace-temps à partir d’un pré-espace primitif quantique. Penrose, par

exemple, propose que « l'effondrement de la fonction d’onde » de la mécanique quantique

soit un phénomène global lié aux propriétés géométriques de l'espace-temps. Il soutient

également que les processus quantiques globaux ont un rôle à jouer dans la liaison entre la

conscience et la structure du cerveau.

Elles sont spéculatives, mais cohérentes, les hypothèses qui tournent autour du

même faisceau d’idées et relient différents centres d'intérêt, tels que la conscience, la vie et

la physique fondamentale. Elles soulèvent la question: Comment la nature globale de la

forme se relie-t-elle à l'information active ? L'information est-elle un nouveau principe du

monde physique qui s'applique dans une grande variété de domaines ? La réponse à cette

question doit commencer par une période de "tri", de clarification des idées fondamentales et

de leurs multiples interconnexions.

Signification

Si la forme commence avec la biologie (et mène à la théorie quantique), la

signification commence sûrement en psychologie. C'était Carl Jung qui avait souligné le rôle

de la signification dans la Synchronicité, un lieu où la forme et le modèle se rejoignent au-

dessus des frontières entre l'esprit et la matière. Pour Jung, la clef était la signification

interne profonde liée à une expérience des modèles synchronistiques, une signification qui

ne s’arrête pas aux frontières de la conscience personnelle. La signification était subjective

6

6

7

7

1

/

7

100%