La cosmologie: un laboratoire de l`infiniment petit 1 2 - IPhT

La cosmologie: un laboratoire de l’infiniment petit

12

Longtemps l’univers ne fut le sujet que de diverses cosmogonies. Dans la tradition occidentale, le

poète Hésiode puis Apollodore nous donnèrent accès à un aperçu mythologique de l’histoire de

l’univers depuis le chaos originel. Ce ne fut qu’avec Thalès et ses successeurs à Milet que le

questionnement scientifique sur l’univers prit son essor. Cependant, il a fallu attendre Einstein et sa

théorie de la relativité générale pour que l’étude du cosmos ne devienne une discipline centrale en

physique, au même titre que la physique des phénomènes subatomiques. De nos jours, les questions

sur l’infiniment grand à des échelles bien plus importantes que la distance qui nous relie aux galaxies

les plus proches et sur l’infiniment petit comme il est mis en évidence par les expériences menées

au CERN se rejoignent. C’est cette convergence qui est l’objet du présent texte.

1. Une description effective de l’univers

La relativité générale écrite par Einstein pendant la première guerre mondiale permet de réconcilier

la relativité restreinte de 1905 et la gravité comme elle était connue depuis Newton. En particulier,

elle repose sur un principe fondamental d’équivalence entre inertie et gravité. Dans sa version dite

faible, ce principe stipule que tout corps soumis à la gravité a un mouvement indépendant de sa

composition. Sa forme forte rajoute que le résultat de toute expérience non-gravitationnelle ne

dépend ni de la vitesse du laboratoire ni de sa position. Evidemment cette deuxième partie du

principe d’équivalence est un postulat sur la nature de la physique en tout point de l’univers. En

particulier, il nécessite que les lois de la physique doivent être les mêmes partout, même hors de

portée de nos dispositifs expérimentaux.

L’étude physique des propriétés de l’univers repose sur la relativité générale qui donne le cadre

géométrique pour décrire l’évolution de l’univers. La relativité générale nous apprend aussi que la

forme géométrique de l’univers dépend de son contenu en énergie. Il y a une correspondance entre

la courbure de l’espace-temps (comprenant a la fois les degrés de liberté spatiaux mais aussi la

variable temps) et la densité d’énergie de la matière en chaque point de l’univers. Ainsi de façon

presque naïve, nous voyons apparaître un premier lien intrinsèque entre matière et géométrie,

c'est-à-dire entre la physique de l’infiniment petit et l’infiniment grand. D’autres liens plus subtils

apparaitront plus tard dans le cours de la discussion.

Nous venons de décrire deux des trois piliers sur lesquels repose la cosmologie

3

: la relativité

générale pour la géométrie et la physique des particules pour le contenu en matière. En principe, ceci

1

Philippe Brax, Institut de Physique Théorique, CEA Saclay, 91191 Gif sur Yvette Cedex.

2

3

Nous considérerons uniquement la cosmologie relativiste. Il est possible d’étudier la cosmologie

Newtonienne : elle n’est pas adéquate pour décrire l’ère de radiation de l’univers.

pourrait être suffisant pour avoir une compréhension globale de l’histoire de l’univers

4

. En pratique,

un autre postulat est utilisé afin de simplifier l’analyse : il s’agit du principe cosmologique. Celui-ci

généralise au cosmos le principe de Copernic qui stipule que la terre n’a pas de position privilégiée

dans le système solaire. Le principe cosmologique énonce que l’univers est isotrope et homogène sur

de grandes échelles de distance. L’isotropie concerne l’absence de direction privilégiée quand

l’homogénéité impose l’absence de position privilégiée.

Ces trois piliers de la cosmologie théorique sont et doivent être confrontés aux observations. Ceci est

le cas de la relativité générale et du principe d’équivalence depuis les expériences du baron Eötvös

jusqu'à la physique des pulsars binaires. Le principe cosmologique est plus difficile à confronter aux

expériences. Néanmoins, sous la pression des données qui ont mené à la découverte de

l’accélération récente de l’univers, celui-ci fait l’objet d’un débat très actif.

Armé des trois hypothèses que je viens de décrire, une des premières applications de la théorie de la

relativité générale fut la découverte par Einstein de solutions qui décrivent un univers statique et

sphérique. En effet, rien ne semblait indiquer à la fin des années 1910 que l’on doive remettre en

cause la staticité de la sphère céleste, vision qui remontait aux fondements Aristotéliciens de

l’univers

5

. Ces solutions mettent en jeu un fluide de matière non-relativiste qui modélise la

répartition de la matière observable de l’univers et un terme d’origine physique plus mystérieuse

qu’Einstein baptisa constante cosmologique. Cette constante dans les équations de la relativité a

pour effet de contrebalancer l’attraction gravitationnelle et donc de rendre possible l’existence d’un

univers statique. Ce qu’Einstein n’avait pas entrevu mais qui fut remarqué peu de temps après par

de Sitter, c’est qu’un univers soumis à cette constante cosmologique se trouve être en expansion

accélérée sans présence de matière. Cette violation du principe de Mach

6

si cher à Einstein continue

de poser de grands problèmes de nos jours depuis la mise en évidence de l’accélération récente de

l’expansion de l’univers.

En fait nous savons depuis Friedmann et Lemaître que la plupart des solutions cosmologiques des

équations de la relativité générale décrivent des univers non-statiques. Leur évolution temporelle

dépend intrinsèquement du contenu matériel de l’univers. Avant de nous plonger dans la

description des différentes ères de l’histoire de l’univers, nous allons revenir sur la description

physique de la matière telle qu’elle est comprise depuis une vingtaine d’années.

Il est particulièrement important d’insister sur une propriété fondamentale de la matière : la notion

de découplage d’échelle. Celle-ci paraît si naturelle qu’elle apparaît très peu dans l’enseignement de

la physique. Il semble en effet évident que la physique puisse se décrire en termes de couches

successives. Vient en premier lieu la physique macroscopique du mouvement des corps dans

l’atmosphère par exemple, puis à des échelles de l’ordre de quelques nanomètres se révèlent les

4

Modulo la structure topologique globale de l’univers qui ne peut pas être comprise à partir des seules

équations de la relativité générale. En effet, celles-ci sont des équations aux dérivées partielles qui ne tiennent

compte que des propriétés locales de la géométrie et de la matière.

5

Les observations de Slipher dans les années 1912 semblaient cependant indiquer que l’univers n’était pas

statique puisque ses résultats montraient que ces galaxies souffraient d’un décalage vers le rouge.

6

Le principe de Mach est une idée issue des travaux du philosophe et physicien Ernst Mach. Mach argumentait

que l’inertie d’un corps était dû a la distribution de toutes les masses de l’univers. Einstein généralisa ce

principe et postula que la géométrie de l’espace lui-même dépend uniquement de la distribution des masses de

l’univers.

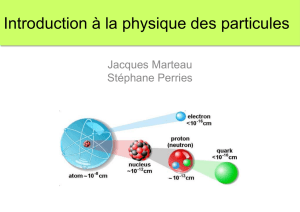

molécules, elles mêmes composées d’atomes. Puis en allant encore explorer des échelles beaucoup

plus petites, les atomes eux-mêmes ont un cœur composé d’un noyau a l’échelle du Fermi

7

. Chaque

noyau contient des protons et des neutrons qui sont faits de quarks et de gluons qui jusqu'à présent

apparaissent comme des objets ponctuels. Chaque couche de cette description peut être séparée de

celles intervenant sur des échelles plus courtes : la chimie des molécules ne dépend que très peu de

la physique nucléaire. En fait, le lien entre les différentes théories qui décrivent la nature à

différentes distances est plus subtile et plus intéressant. Pour bien s’en rendre compte, utilisons un

exemple de physique très classique aux multiples applications et à la portée universelle : la

mécanique des fluides. En un sens la mécanique des fluides est un triomphe de la physique du

19ème siècle et de la description Newtonienne de la nature. En effet, l’étude de l’écoulement des

fluides depuis les cours d’eau jusqu’aux tornades peut se comprendre grâce à une seule équation de

la dynamique dite de Navier-Stokes

8

:

qui décrit l’évolution temporelle du champ de vitesse v d’un fluide en chaque point de l’espace et en

chaque instant en fonction du champ de pression p et de la densité du fluide ρ. Cette équation d’une

concision remarquable contient un seul paramètre : la viscosité ν. Ce paramètre phénoménologique

doit être mesuré et caractérise chaque fluide. Une fois ce nombre mesuré, il est possible de prédire

l’écoulement d’un fluide dans n’importe quelle circonstance. Cette démarche est à la base de

l’approche effective de la nature utilisée en particulier en physique des hautes énergies. La

description effective des phénomènes naturels à une échelle donnée s’effectue grâce à des champs

9

dépendant de l’espace et du temps. Le modèle mathématique décrivant le comportement de ces

champs dépend d’un petit nombre de paramètres dits pertinents qui doivent être mesurés

expérimentalement. Une fois cette mesure effectuée, il est possible de prédire les résultats de toutes

les expériences analysant la physique à cette échelle caractéristique.

Cette approche phénoménologique utilisant des théories effectives est appliquée à toutes les

échelles de la physique connue jusqu'à l’infiniment petit comme il est décrit par le modèle standard

de la physique des particules. Une autre propriété fondamentale des théories effectives est la

possibilité de calculer

10

les paramètres pertinents à une échelle donnée en fonction de ceux à une

échelle plus petite

11

. Revenons sur l’exemple de la viscosité afin d’illustrer notre propos. Une

meilleure compréhension de l’origine physique de la viscosité fut donnée par la théorie cinétique qui

nous apprend que les gaz et les fluides sont composés de molécules ayant un mouvement

désordonné de vitesse moyenne V et de libre parcours moyen

12

λ. La viscosité devient alors :

7

Quinze ordres de grandeur plus petits que le mètre.

8

Il s’agit de la version simple pour des fluides dits incompressibles.

9

En physique des particules, chaque particule est décrite par un champ. Ceci est la version relativiste de la

dualité onde-particule en mécanique quantique.

10

Ceci est vrai pour les théories décrites dans le régime dit perturbatif. Dans le cas non-perturbatif comme le

passage de l’échelle des quarks a l’échelle des nucléons, le modèle effectif des nucléons n’est pour l’instant pas

calculable mathématiquement en fonction de la théorie des quarks et des gluons (la chromodynamique

quantique).

11

Ceci correspond à l’idée de groupe de renormalisation formulé par K. Wilson.

12

La distance moyenne entre deux chocs de molécules.

.

C’est un premier pas vers une compréhension microscopique de la viscosité. Le pas suivant vient du

fait qu’il est possible de calculer le libre parcours moyen à partir de la physique atomique. En effet,

celui-ci dépend de la densité n des molécules et de la section efficace d’interaction entre molécules

σ :

Ainsi la mécanique quantique non-relativiste qui régit la physique atomique permet de calculer une

propriété de la matière comme la viscosité qui avait été introduite de manière purement

phénoménologique.

Cette démarche utilisant des théories effectives jouit de grands succès puisqu’elle rend compte de la

physique atomique, puis nucléaire et enfin des particules. Le modèle standard de la physique des

particules est une théorie effective décrivant le comportement des quarks, des leptons et des bosons

de jauge. Il dépend de vingt paramètres, ce qui est beaucoup même pour une théorie effective. Ces

paramètres caractérisent l’énergie du vide, les masses des particules et leurs constantes de couplage.

Bien évidemment, une activité théorique intense a conduit à de nombreuses extensions du modèle

standard. Nous verrons leur importance pour la cosmologie un peu plus tard.

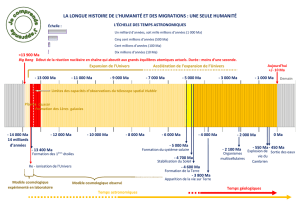

2. Les succès de la physique des particules en cosmologie

Le succès de la physique des particules dans la description des phénomènes cosmologiques vient

d’une observation cruciale. Dans un univers en expansion, la température des espèces en équilibre

thermodynamique tels que le bain de photons fossiles est inversement proportionnelle au facteur

d’échelle de l’univers. Ce facteur mesure l’accroissement des distances dû à l’expansion de l’univers.

Ainsi lorsque l’univers était plus petit

13

, sa température était plus élevée. Or la température d’un

plasma caractérise la densité d’énergie de ses constituants. Nous sommes donc amenés à considérer

que l’univers a explore de façon dynamique toutes les phases de la matière depuis des temps

extrêmement courts. En extrapolant cette régression temporelle vers des températures de plus en

plus élevées, on rencontre une singularité initiale de densité infinie appelée Big Bang

14

. Bien

évidemment les lois de la physique qui régissent les premiers instants ne sont pas encore connues. La

physique du modèle standard des particules nous donne une image de l’univers à un instant un

dixième de milliardième de seconde après ce Big Bang. Avant cet instant, il existe de nombreuses

théories spéculatives au delà du modèle standard.

Quelles sont les observations que l’on peut espérer avoir de ces premiers instants de l’univers ? Il se

trouve qu’il existe une limitation fondamentale à notre connaissance de ces premiers instants. En

effet, ce n’est qu’au bout de 300 000 ans après le Big Bang que l’univers cesse d’être opaque et

13

La taille de l’univers est une image, en effet dans un univers aux sections spatiales plates celui-ci est infini. Il

s’agit en fait de la croissance des distances relatives entre points de l’espace.

14

Pour une description de l’histoire thermique de l’univers, voir le texte de Julien Lesgourgues dans ce volume.

libère les photons. Il est impossible d’obtenir une image optique de l’univers plus jeune que 300 000

ans

15

. Il existe aussi une autre difficulté observationnelle qui est liée à l’unicité de l’univers et

l’impossibilité apparente de réaliser une étude statistique des propriétés de l’univers. En fait, il se

trouve que des points qui sont éloignés de plus d’un degré sur une carte du ciel au moment où

l’univers devient transparent n’ont jamais été en contact causal

16

. Il est donc possible de sectionner

une carte du ciel primordial en blocs et de considérer ces blocs comme des univers indépendants.

Alors les outils statistiques d’analyse des données expérimentales peuvent être utilisés en

cosmologie.

Le meilleur accord entre la physique des particules et la cosmologie est obtenu dans l’étude de

l’abondance des éléments légers comme l’hélium ou le deutérium. Ces éléments furent crées

pendant la nucléosynthèse primordiale quand l’univers avait moins de 3 minutes après le Big Bang.

Cet événement ayant eu lieu bien avant l’instant où les photons deviennent observables, nous en

avons une connaissance qui ne provient que de l’évolution jusqu'à nos jours de la densité des

éléments légers. Il se trouve que la nucléosynthèse met en jeu à la fois la physique nucléaire et

l’interaction faible entre particules car elle dépend de façon cruciale de la désintégration du neutron

en proton. L’abondance de l’hélium est estimée être proche de vingt quatre pour cent. Ceci est en

très bon accord avec les observations. La nucléosynthèse donne aussi accès à un paramètre

fondamental appelé η. En effet, l’abondance du deutérium ou de l’hélium 3 dépendent du rapport

du nombre de particules de matière appelées baryons sur le nombre de particules de lumière

appelées photons. Ce rapport est constant pendant l’histoire de l’univers et permet de déterminer la

densité de la matière visible maintenant. Il se trouve que seuls cinq pour cent de la densité d’énergie

totale de l’univers sont sous forme baryonique. Ceci est un petit nombre sur lequel nous reviendrons

plus tard. Concentrons nous d’abord sur le nombre de baryons par rapport au nombre de photons.

Ce rapport est de dix ordres de grandeur plus petit que l’unité (un dixième de milliardième).

Au moment de la nucléosynthèse, ce rapport est fixé. Il trouve son origine dans la phase précédente

dans l’histoire de l’univers que l’on appelle baryogenèse. Pendant cette période, les protons et les

neutrons se forment à partir des briques fondamentales que sont les quarks. Or en physique des

particules, chaque particule est associée à une antiparticule de même masse mais de charge

électrique opposée. Ainsi chaque quark possède son antiquark. Il peut donc se former à la fois des

baryons et des antibaryons. Or nul n’a jamais observé de quantité importante d’antimatière dans

l’univers. Il est possible d’en créer aux accélérateurs comme au CERN. Les rayons cosmiques qui nous

bombardent de particules continûment en provenance du cosmos peuvent aussi être porteurs

d’antiparticules. Mais de l’antimatière stable en contact avec la matière, ceci est impossible. En effet,

il se produit une désintégration explosive de la matière quand elle entre en contact avec

l’antimatière. Notre univers est ainsi fait de matière. Ceci pose un problème ardu : comment se fait-il

que l’univers a préféré évoluer vers un état ou la matière domine sur l’antimatière ? Et comment

expliquer la petitesse du nombre de baryons par rapport au nombre de photons ? Pour ce problème

de la baryogenèse, la physique des particules énonce trois conditions dites d’Andreï Sakharov

17

Il doit exister des interactions entre particules qui ne conservent pas le nombre de baryons.

15

Il est possible d’imaginer que les neutrinos ou les ondes gravitationnelles permettraient de s’affranchir de

cette borne.

16

Aucun signal lumineux n’a pu mettre en contact des observateurs des deux régions.

17

Le physicien et prix Nobel de la paix Russe.

6

6

7

7

8

8

9

9

10

10

1

/

10

100%