Chapitre 4 : Les rapprochements entre les approches

1

Chapitre 4 : Les rapprochements entre les approches

macroéconomiques par l’offre et par la demande.

Il y a deux grandes approches qui concerne la même entité qui est le produit national

réelle qui partent l’une par la demande globale avec la théorie général de Keynes et une

approche par l’offre qui est en fait plus ancienne puisque elle remonte à Turgot et Adam

Smith mais qui s’est trouvé rénové récemment, et à l’évidence que se soit en micro ou macro,

on devrait disposer un modèle qui permettrait d’intégrer ces deux approches, en micro, le prix

se forme entre le rapprochement entre l’offre et la demande et il semblerait logique en macro

que le produit national se forme par rapprochement en l’offre globale et la demande globale.

Pourtant ce n’est pas le cas même si on pense que les choses sont entrain d’évoluer, pour

l’essentiel le rapprochement entre ces deux types d’approches se fait plutôt par l’intégration

de certaines considération de l’offre dans un modèle de demande globale.

Section 1 : L’intégration d’élément d’offre dans une approche par la demande

globale.

Cette intégration s’est faite à partir du début des années 60 quand on s’est préoccupé

du rôle des effets prix sur la formation du produit national réelle à partir d’un certain montant

de la demande globale. En effet si la demande globale augmente de manière importante, elle

va déterminer un accroissement du produit national réel mais si cette augmentation de la

demande globale entraine aussi une forte hausse de prix, l’augmentation du produit national

réel sera réduite et l’essentiel de l’impact de l’accroissement de la demande globale aura été

sur les prix. Or le modèle Keynésien répond très mal à cette question qui reste essentiel, en

effet l’approche de la théorie général et les principaux développements de la part des

keynésiens laissaient entendre qu’il y avait deux situations tout à fait différentes, une situation

de sous emplois et tant que ce sous emploi dure alors l’augmentation de la demande globale

provoque un accroissement de l’emploi et de la production réelle sans hausse de prix. En

revanche quand le seuil de plein emploi est atteint, toute augmentation de la demande globale

se traduit par une augmentation des prix sans augmentation du produit réel. Ceci explique la

distinction chez Keynes entre l’écart déflationniste et inflationniste. Ce que les keynésiens

appelle l’écart déflationniste c’est l’insuffisance de la demande globale qui se traduit par une

baisse du produit national et l’écart inflationniste qui traduit l’excès de la demande globale sur

le produit de plein emploi sur une hausse de prix. Il y a là une conception du tout ou rien. Il y

a une absence de prise en compte de phénomène de l’offre dans leur complexité et on a la

conviction qu’il n’est pas utile de s intéresser aux mécanismes de l’offre et que la macro peut

rester cantonner par une approche de la demande globale.

Le premier choc subit par cette approche et l’établissement de la courbe de Philips qui

met en cause ce mécanisme Keynésien du tout ou rien à partir du marché du travail.

1§ : L’établissement de la courbe de Philips.

Ce que constate Philips c’est qu’il y a toujours un certain taux de chômage dans

l’économie mais contrairement à la thèse Keynésienne qui est implicite, la rémunération des

salariés va varier selon le taux de chômage et Philips constate que cette rémunération salariale

peut même baiser quand le taux de chômage atteint des niveaux élevé. On a donc une courbe.

2

âge

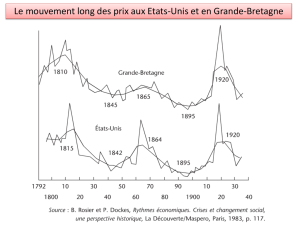

Cette courbe s’établit à travers des données statistiques par les années à

l’augmentation des produits agricoles restent intérieur à 2,5%.

Si les prix des produits agricoles de plus de 2,5%, la croissance des salaires va être en

partie déterminé par cette hausse de prix car les salariés vont demander un rattrapage de

pouvoir d’achat et la hausse de salaire ne dépend plus de manière unique du taux de sous

emplois. Dans ce cas, le mécanisme de la courbe de Philips se déplace vers le haut. Il

intervient alors la croissance annuelle de la productivité qu’il estime à plus de 2%. Le résultat

sur le niveau intérieur des prix est que si l’on est en situation de sous emploi de 2,5 %, les

salaires augmentent de 2% mais les gains de productivité qui sont en moyenne de 2% font que

les prix à la production restent stable et si le taux de chômage atteignait 5,5% on devrait avoir

une baisse des prix des produits manufacturés puisque les salaires nominaux n’augmente pas

et donc les prix devraient baisser de 2%. On a là la fameuse interprétation de la courbe de

Philips, on a l’impression que la courbe de Philips est un menu pour la politique économique

permettant d’opter pour la stabilité des prix avec un taux de chômage élevé ou une situation

de taux de chômage réduit mais avec une hausse importante des prix.

2§ : La controverse de la courbe de Philips.

Le principe même de la courbe a été critiqué et rejeté brutalement par la plupart des

Keynésiens qui n’admettait pas la possibilité d’une hausse des salaires en dehors d’une

situation de plein emploi. Puis à la réflexion, les keynésiens ont admis quelque chose qui

ressemble à la courbe de Philips considérant que cette fonction donnait un peu de souplesse au

modèle Keynésien et permettait notamment d’introduire des options de politiques

économiques justifiant par exemple un certain taux d’inflation pour favoriser le plein emploi

ce qui est devenu une sorte de solution standard de la part des Keynésiens qui souligne

d’ailleurs que la hausse de prix qui va accompagner une tendance de plein emploi à toute une

série d’avantage notable. Elle permet de réajuster les salaires nominaux de façon modifier les

salaires relatifs en faveur des secteurs en expansion alors qu’on ne pouvait pas baisser les

salaires nominaux dans les secteurs qui sont en contraction d’effectif car selon la doctrine

keynésienne une baisse du salaire nominal n’est jamais accepté par les salariés. Dans le cas

d’une hausse des salaires nominaux, il peut y avoir des hausses plus rapides dans les secteurs

en expansion et des hausses faibles dans les secteurs en contraction.

3

Par ailleurs, en phase de hausse de prix, les salariés vont demander une hausse de

salaire compensatrice et ne tiendront pas tellement compte de l’augmentation de la

productivité qui permettrait une augmentation plus forte des salaires ce qui favorisent

l’emploi puisque le coût réel du travail est alors sous évalué.

Il y a cependant une objection majeur qui est la situation de stagflation, il s’agit d’une

situation qui cumule une hausse rapide des prix et un niveau important de sous emploi. A

priori une telle situation semble incompatible avec la courbe de Philips si on admet que la

hausse des salaires est le résultat d’une réduction de sous emplois, cette hausse des salaires

déterminant à son tour la hausse des prix. En réalité cela ne pose aucun problème à la courbe

puisqu’elle est juste une anticipation de la hausse des prix qui est général et qui touche les

salariés.

La courbe de Philips ne fait que se déplacer en fonction des prix anticipés. Vers la fin

des années 70, la courbe de Philips est devenu une composante de tous les modèles

macroéconomiques et quand un modèle cherche à prévoir ou à expliquer la hausse des

salaires, elles utilisent deux composantes, la hausse des salaires s’explique par la hausse des

prix et un certain coefficient appliquer au taux de chômage (w = p + a Txcho). L’aspect le

plus spectaculaire est l’utilisation de cette courbe dans les modèles des principaux adversaires,

les monétaristes de l’école de Milton Friedman qui ont intégré la courbe de Philips dans leur

modèle économique.

3§ : L’intégration de la courbe de Philips dans le cadre néo-keynésien et la politique d’action

sur les prix.

Du point de vue des néo-keynésien on a le modèle IS-LM.

Variation des prix en %

4

La hausse des prix s’explique par deux raisons, il y a l’inflation des prix anticipé par

les agents économiques puis il y a l’inflation de la demande qui correspond à la pression

exercée par la demande globale sur la formation du produit intérieur réel et il faut y ajouter

l’inflation du choc qui correspond à une variation du coté de l’offre. L’inflation de choc peut

être positive ou négative et peut pousser à une augmentation des prix relativement forte mais

peut aussi ramener le prix à un prix inférieur tout est une question de circonstance.

P° = p°noyau + p°demande + p°choc.

Ce qui est intéressant ce sont les aspects de politique économique. On peut partir d’une

situation initiale ou la détermination du produit national.

a) rééquilibrage rapide en cas de poussée de la demande : soit un relèvement de la courbe IS

exprimant un choc inflationniste ! Il se produit un déplacement de l’équilibre en Y1, avec

poussée des prix, le long de la courbe de Phillips H ; mais cette hausse de prix contracte la

masse monétaire réelle, avec une rétraction de LM en LM2, ce qui provoque une disparition

des tensions inflationnistes, et un retour à Yf, à un niveau de prix certes plus élevé, mais sans

apparition d’un noyau d’inflation !

5

b) un rééquilibrage très lent en cas de contraction de la demande : soit une rétraction de IS,

provoquant une baisse du produit et une faible baisse des prix ; le relèvement très limité du

niveau de l'encaisse réelle n'entraîne qu'un déplacement lent et progressif de LM : le retour à

Yf ne peut se faire spontanément que sur de nombreuses périodes.

La dissymétrie dans l’autorégulation résultant de la « courbe de Phillips », justifie le

thème keynésien (ici “néo”) : il faut une action de politique économique pour retrouver

l’équilibre de plein-emploi qui ne se rétablira pas de lui-même, en cas de contraction. C’est

particulièrement nécessaire dans le sens de la contraction.

En cas d’insuffisance de la demande globale seule une politique d’action de la

demande globale permettra un retour d’équilibre. Il y a une forte implication entre la courbe

de Philips et la doctrine traditionnelle des keynésiens. Mais la principale question est l’impact

de cette dissymétrie. L’action économique à entreprendre en cas de hausse des prix provoquée

initialement par une augmentation de la demande globale.

La puissance de l’autorégulation des prix face à une poussée de la demande, est très

souvent neutralisée par l’action « validante » de la poussée inflationniste par l’autorité

monétaire : elle peut maintenir LM1, grâce au gonflement de l’offre de monnaie nominale,

Dès lors l’inflation de noyau s'installe et s’élève de période en période, tant que l’équilibre

macro-économique s'établit au-delà du produit potentiel.

Cas envisagé : au départ stabilité des prix, survient un “choc” qui déplace la courbe IS

de IS1à IS2, l'équilibre du revenu se fait en Y1 et avec une hausse des prix au rythme p°1 ;

l'autocorrection par les prix ne se produit pas car la Banque centrale « valide » l'équilibre

macroéconomique en maintenant la courbe LM en LM1, c'est à dire qu'elle compense par une

offre de monnaie supplémentaire la baisse de sa valeur réelle.

a) progression rapide de l'inflation de noyau :

Dès lors les agents économiques constatent que l'inflation est durable, ils intègrent à leurs

anticipation une inflation de noyau positive, ce qui se traduit par le relèvement de la courbe H.

Le maintien du même équilibre macroéconomique entraîne alors une hausse de prix plus

forte, donc un relèvement de l'inflation de noyau et de la courbe H. L'économie peut alors

entrer assez rapidement dans une inflation à deux chiffres.

b) lenteur de la réduction de l’inflation de noyau :

Pour lutter contre cette forte inflation en progression rapide, revenir à l'équilibre du produit

potentiel ne fit que stabiliser l'inflation de noyau. Or elle est considérée comme trop rapide.

La seule solution pour la réduire consiste à faire passer le produit réel en dessous du produit

potentiel et de l'y maintenir tant que l'inflation n'est pas suffisamment résorbée. Soit une

politique budgétaire d’action sur IS : contraction de IS1 en IS3 (on pourrait aussi agir par

LM).

Malheureusement une telle politique va se heurter à la dissymétrie de la courbe de Philips,

c’est ce que l’on constate.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

1

/

14

100%