PROJET IV2 Bis

PROJET IV2 Bis

Jihène Bannour, Jean-Luc Dugelay, Caroline Mallauran, Federico Matta, Usman Saeed.

WP1 : Annotations

En vue de rendre la base de données, produite par IV2, exploitable, il est nécessaire de l’enrichir

de métadonnées. En effet, il semble important pour chaque modalité de se pencher sur les

annotations à apporter à la base. Certaines annotations sont indispensables pour permettre des

évaluations variées à partir des données disponibles. Dans ce sous-projet, la mise en place

d’algorithmes d’annotations semi-automatiques, voire automatiques, est envisagée. Les résultats

seront contrôlés afin de valider les annotations lors de la constitution de la vérité terrain.

1. Visages 2D:

Pour les visages 2D, il est important en vue d’exploiter correctement la base d’indexer quelques

points sur le visage pour offrir la possibilité de normaliser les visages. Pour la plupart des

algorithmes de référence en reconnaissance et en détection de visage, des informations

concernant la position des yeux (la pupille) et du nez (le bout) sont nécessaires lors de la

normalisation des images. En effet, la segmentation du visage est une étape de grande importance

dans un système de reconnaissance de visage d’où la nécessité d’annoter les images. La méthode

de normalisation la plus utilisée consiste à effectuer, dans un premier temps, une rotation de

l’image de visage de telle sorte que les yeux soient alignés sur une même ligne horizontale.

Ensuite, l’image est découpée de telle sorte que le nez soit centré et que la taille de l’image une

fois normalisée soit égale à deux fois la distance interoculaire. D’autres informations semblent

nécessaires dans la communauté de la biométrie et notamment celle concernant la pose et

l’orientation du visage. Suite aux diverses expériences menées en reconnaissance de visages 2D,

une des grosses difficultés rencontrées est le changement de pose du visage. En effet, peu

d’algorithmes semblent robustes aux changements de pose. Pour une campagne d’évaluation,

cette information, en tant que métadonnée, est utile afin de mener à bien les tests.

2. Séquence:

Eurecom s’engage à travailler sur la vidéo sans se préoccuper de l’audio. On parlera donc de

séquences d’images. Faire de la reconnaissance de visage en se basant sur l’aspect dynamique du

visage implique une détection du visage dans la vidéo et la donnée de quelques points de

référence. Pour permettre l’utilisation de cette base par les algorithmes de reconnaissance de

visages par la vidéo, certains points caractéristiques doivent être fournis. En effet, la connaissance

des coordonnées des yeux, du bout du nez ainsi que de la bouche, et plus particulièrement les

extrémités de la bouche, fait partie des prérequis de nombreux systèmes. Dans cette partie, des

algorithmes d’annotation semi-automatiques peuvent être implémentés en vue de faire de la

détection de visage par le suivi de quelques points caractéristiques de référence dans le visage.

On peut distinguer la détection (étape d’initialisation sur la première image de la vidéo) du suivi

temporel.

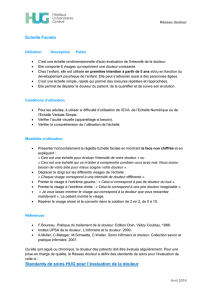

3. Visage 3D:

Dans la base de données produite dans le cadre d’IV2, les visages 3D fournis sont au format

VRML. Ce format fournit des informations importantes et nécessaires dans le monde des objets

3D. Parmi ces données, le nombre de sommets, le nombre de facettes, c’est à dire le maillage,

ainsi que la texture font partie intégrante des données disponibles. Certaines méthodes nécessitent

un recalage du modèle 3D. Pour ce faire, certains points caractéristiques du modèle sont

nécessaires. 9 points de référence seront annotés : 4 pour les yeux (les coins de chaque œil), 2

pour la bouche (les extrémités de la bouche) et 3 pour le nez. Cependant, est-ce suffisant ? Une

des grosses difficultés rencontrées par les algorithmes de reconnaissance de visages 2D est d’être

robustes aux expressions. Pour ce faire, travailler avec une dimension supplémentaire, c'est-à-dire

avec des modèles 3D, nous apporte plus d’informations et les algorithmes tendent à être plus

stables quant aux variations de pose et d’expression. Dans le domaine de l’émotion, les

expressions sont répertoriées en 6 catégories: Joie, tristesse, colère, dégoût, surprise et peur. En

vue de d’entraîner des algorithmes en générant certaines expressions à partir d’un modèle 3D, il

est peut-être utile de se référer à MPEG 4, et plus particulièrement aux différents points

d’animation du visage (cf figure 1). Travailler avec des modèles 3D nous approche

indéniablement du monde de l’animation, en l’occurrence ici d’animation faciale d’où la

référence à MPEG4.

Figure 1 : Points de contrôle

De plus, dans la littérature, certains systèmes de reconnaissance 2D/3D font également appel à

quelques points de référence issus de la figure ci-dessus.

4. Compatibilités 2D, 2D+t et vidéo

Il nous semble important de prévoir quelques annotations communes aux trois modalités afin

d’ouvrir des passerelles entre les 3 modalités. Essentiellement, on retrouve systématiquement, les

yeux et le nez.

1

/

2

100%