Université Rennes 2

Master de Statistique

Année 2012/2013

Premier Semestre

Régression linéaire

Arnaud Guyader

Ce cours est tiré des quatre premiers chapitres du livre de Pierre-André Cornillon et Eric Matzner-

Løber, Régression avec R, paru chez Springer en 2010.

Table des matières

1 La régression linéaire simple 1

1.1 Modélisation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2

1.2 Moindres Carrés Ordinaires ............................... 2

1.2.1 Calcul des estimateurs de β1et β2....................... 3

1.2.2 Quelques propriétés des estimateurs ˆ

β1et ˆ

β2. . . . . . . . . . . . . . . . . 4

1.2.3 Calcul des résidus et de la variance résiduelle . . . . . . . . . . . . . . . . . 7

1.2.4 Prévision ..................................... 8

1.3 Interprétations géométriques ............................... 9

1.3.1 Représentation des variables ........................... 9

1.3.2 Le coefficient de détermination R2....................... 10

1.4 Cas d’erreurs gaussiennes ................................ 11

1.4.1 Estimateurs du maximum de vraisemblance . . . . . . . . . . . . . . . . . . 11

1.4.2 Rappels sur les lois usuelles ........................... 12

1.4.3 Lois des estimateurs et régions de confiance . . . . . . . . . . . . . . . . . . 13

1.4.4 Prévision ..................................... 15

1.5 Exemple . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

1.6 Exercices . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

1.7 Corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

2 La régression linéaire multiple 29

2.1 Modélisation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

2.2 Estimateurs des Moindres Carrés Ordinaires . . . . . . . . . . . . . . . . . . . . . . 31

2.2.1 Calcul de ˆ

β.................................... 31

2.2.2 Quelques propriétés ............................... 33

2.2.3 Résidus et variance résiduelle . . . . . . . . . . . . . . . . . . . . . . . . . . 35

2.2.4 Prévision ..................................... 36

2.3 Interprétation géométrique ................................ 37

2.4 Exemple . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

2.5 Exercices . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

2.6 Corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 42

3 Le modèle gaussien 49

3.1 Estimateurs du Maximum de Vraisemblance . . . . . . . . . . . . . . . . . . . . . . 49

3.2 Lois des estimateurs ................................... 50

3.2.1 Quelques rappels ................................. 50

3.2.2 Nouvelles propriétés ............................... 51

3.2.3 Intervalles et régions de confiance . . . . . . . . . . . . . . . . . . . . . . . . 53

3.2.4 Prévision ..................................... 54

3.3 Tests d’hypothèses .................................... 56

3.3.1 Introduction .................................... 56

i

ii Table des matières

3.3.2 Tests entre modèles emboîtés . . . . . . . . . . . . . . . . . . . . . . . . . . 56

3.3.3 Test de Student de signification d’un coefficient . . . . . . . . . . . . . . . . 60

3.3.4 Test de Fisher global ............................... 60

3.3.5 Lien avec le Rapport de Vraisemblance Maximale . . . . . . . . . . . . . . . 60

3.4 Estimation sous contraintes ............................... 62

3.5 Exemple . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62

3.6 Exercices . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63

3.7 Corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 74

4 Validation du modèle 81

4.1 Analyse des résidus .................................... 81

4.1.1 Résidus et valeurs aberrantes . . . . . . . . . . . . . . . . . . . . . . . . . . 81

4.1.2 Analyse de la normalité ............................. 84

4.1.3 Analyse de l’homoscédasticité . . . . . . . . . . . . . . . . . . . . . . . . . . 85

4.1.4 Analyse de la structure des résidus ....................... 85

4.2 Analyse de la matrice de projection ........................... 88

4.3 Autres mesures diagnostiques .............................. 90

A Annales 93

B Rappels d’algèbre 131

B.1 Quelques définitions . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

B.2 Quelques propriétés .................................... 131

B.2.1 Les matrices n×p................................ 131

B.2.2 Les matrices carrées n×n. . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

B.2.3 Les matrices symétriques . . . . . . . . . . . . . . . . . . . . . . . . . . . . 132

B.2.4 Les matrices semi-définies positives . . . . . . . . . . . . . . . . . . . . . . . 132

B.3 Propriétés des inverses .................................. 132

B.4 Propriétés des projections ................................ 133

B.4.1 Généralités .................................... 133

B.4.2 Exemple de projection orthogonale . . . . . . . . . . . . . . . . . . . . . . . 133

B.4.3 Trace et éléments courants . . . . . . . . . . . . . . . . . . . . . . . . . . . . 133

B.5 Dérivation matricielle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 134

C Rappels de probabilité 135

C.1 Généralités . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 135

C.2 Vecteurs aléatoires gaussiens . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 135

C.3 Tables des lois usuelles .................................. 137

C.3.1 Loi Normale X∼ N(0,1) . . . . . . . . . . . . . . . . . . . . . . . . . . . . 137

C.3.2 Loi de Student X∼ Tν.............................. 138

C.3.3 Loi du Khi-deux à νddl X∼χ2

ν. . . . . . . . . . . . . . . . . . . . . . . . 139

C.3.4 Loi de Fisher à ν1, ν2ddl X∼ Fν1

ν2. . . . . . . . . . . . . . . . . . . . . . . 140

D Quelques données 141

Bibliographie 143

Arnaud Guyader - Rennes 2 Régression

Chapitre 1

La régression linéaire simple

Introduction

Commençons par un exemple afin de fixer les idées. Pour des raisons de santé publique, on s’in-

téresse à la concentration d’ozone O3dans l’air (en microgrammes par millilitre). En particulier,

on cherche à savoir s’il est possible d’expliquer le taux maximal d’ozone de la journée par la

température T12 à midi. Les données sont :

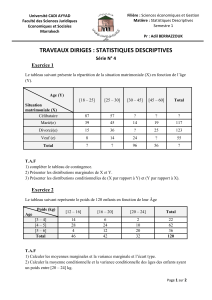

Température à 12h 23.8 16.3 27.2 7.1 25.1 27.5 19.4 19.8 32.2 20.7

O3max 115.4 76.8 113.8 81.6 115.4 125 83.6 75.2 136.8 102.8

Table 1.1 – 10 données journalières de température et d’ozone.

D’un point de vue pratique, le but de cette régression est double :

— ajuster un modèle pour expliquer O3en fonction de T12 ;

— prédire les valeurs d’O3pour de nouvelles valeurs de T12.

Avant toute analyse, il est intéressant de représenter les données, comme sur la figure 1.1.

10 15 20 25 30

80 90 100 110 120 130

T12

O3

Figure 1.1 – 10 données journalières de température et d’ozone.

Pour analyser la relation entre les xi(température) et les yi(ozone), nous allons chercher une

fonction ftelle que :

yi≈f(xi).

Pour préciser le sens de ≈, il faut se donner un critère quantifiant la qualité de l’ajustement de la

fonction faux données. Il conviendra aussi de se donner une classe de fonctions Fdans laquelle

est supposée vivre la vraie fonction inconnue.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

145

145

146

146

147

147

1

/

147

100%