1

1TABLE DES MATIÈRES

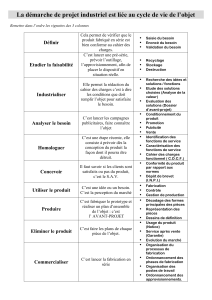

Introduction générale

Chapitre 1 : Introduction aux Systèmes Informatiques Temps Réel

1. Introduction ________________________________________________________ 7

2. Les systèmes temps réel _______________________________________________ 7

2.1. Présentation générale____________________________________________________7

2.2. Structure d’un système de contrôle ________________________________________8

2.3. Les tâches ____________________________________________________________10

2.4. La problématique de l’ordonnancement ___________________________________10

2.5. Les algorithmes d’ordonnancement_______________________________________11

2.5.1. Préemptif/non Préemptif _____________________________________________________11

2.5.2. Hors ligne/en ligne__________________________________________________________11

2.5.3. Conduits par la priorité ______________________________________________________11

3. Les réseaux de communication temps réel _______________________________ 12

3.1. Architecture __________________________________________________________12

3.2. Les messages temps réel_________________________________________________13

3.3. Ordonnancement des messages temps réel _________________________________13

4. Cadre du travail ____________________________________________________ 14

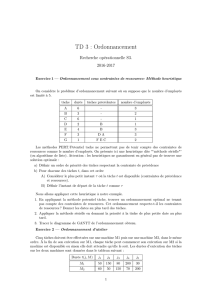

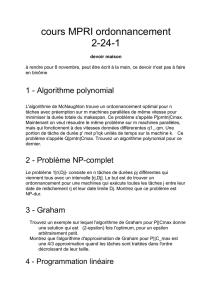

Chapitre 2 : Ordonnancement des tâches

1. Introduction _______________________________________________________ 17

2. Modélisation des tâches ______________________________________________ 18

3. Représentation d’une séquence________________________________________ 19

3.1. Durée de validation ____________________________________________________20

3.2. Condition nécessaire de validation________________________________________20

4. Classification des tâches _____________________________________________ 21

5. Les tâches indépendantes_____________________________________________ 21

5.1. Les tâches périodiques__________________________________________________21

5.1.1. Les algorithmes d’ordonnancement à priorité fixe _________________________________21

5.1.2. Les algorithmes d’ordonnancement à priorité dynamique____________________________24

5.2. Les tâches apériodiques_________________________________________________27

5.2.1. Le serveur à scrutation_______________________________________________________27

5.2.2. Le serveur ajournable________________________________________________________28

1

5.2.3. Autres méthodes ___________________________________________________________ 28

6. Les tâches dépendantes _______________________________________________29

6.1. Prise en compte des relations de précédence ________________________________29

6.1.1. Précédence avec l’algorithme RM _____________________________________________ 29

6.1.2. Précédence avec l’algorithme DM _____________________________________________ 30

6.1.3. Précédence avec l’algorithme ED______________________________________________ 30

6.2. La prise en compte du partage de ressources _______________________________32

6.2.1. Le protocole à priorité héritée_________________________________________________ 33

6.2.2. Le protocole à priorité plafond ________________________________________________ 36

6.2.3. Le protocole d’allocation de la pile (PAP) _______________________________________ 38

7. Conclusion _________________________________________________________41

Chapitre 3 : Les Principaux Protocoles MAC Adaptés aux

Communications Temps Réel

1. Introduction ________________________________________________________43

2. Classification des protocoles MAC ______________________________________45

3. Les techniques d’accès _______________________________________________45

4. Protocoles à accès aléatoire____________________________________________46

4.1. Le protocole CAN______________________________________________________46

4.2. Le protocole CSMA/DCR _______________________________________________49

4.2.1. Principe__________________________________________________________________ 49

4.2.2. Calcul de l’époque _________________________________________________________ 50

5. Protocoles d’accès à contrôle centralisé: exemple de FIP____________________50

6. Protocoles d’accès à contrôle distribué___________________________________53

6.1. Le protocole FDDI _____________________________________________________53

6.2. Le protocole TDMA____________________________________________________55

7. Conclusion _________________________________________________________56

Chapitre 4 : Environnements Temps Réel Répartis

1. Introduction ________________________________________________________59

2. Quelques exécutifs temps réel répartis ___________________________________59

2.1. Le projet MARS_______________________________________________________59

2.1.1. Architecture matérielle de MARS______________________________________________ 60

2.1.2. Le système d’exploitation de MARS ___________________________________________ 60

2.1.3. Conclusion _______________________________________________________________ 62

2.2. Le projet SPRING _____________________________________________________63

2.2.1. Classification et caractérisation des tâches _______________________________________ 63

2.2.2. Architecture de SPRING: Springnet ____________________________________________ 64

2.2.3. L’ordonnancement des tâches_________________________________________________ 64

2.2.4. Conclusion _______________________________________________________________ 65

1

2.3. Le système CHORUS___________________________________________________66

2.3.1. Les objets dans CHORUS ____________________________________________________66

2.3.2. L’ordonnancement des tâches _________________________________________________67

3. Outils et méthodes de validation _______________________________________ 68

3.1. L’outil PERTS ________________________________________________________69

3.1.1. Editeur de tâches ___________________________________________________________69

3.1.2. Editeur de ressources________________________________________________________69

3.1.3. L’ordonnanceur ____________________________________________________________70

3.2. Une méthode de validation d’applications temps réel réparties ________________72

3.2.1. Hypothèses générales________________________________________________________72

3.2.2. Description de l’exemple d’application__________________________________________72

3.2.3. Description du réseau utilisé __________________________________________________74

3.2.4. Analyse temporelle _________________________________________________________74

3.2.5. Conclusion________________________________________________________________75

4. Conclusion ________________________________________________________ 76

Chapitre 5 : Une méthodologie de Validation Basée sur une Analyse

d’Ordonnançabilité

1. Introduction _______________________________________________________ 79

2. Le modèle général __________________________________________________ 80

2.1. Modèle structurel______________________________________________________80

2.2. Le modèle temporel de tâches____________________________________________81

2.3. Le modèle temporel de messages _________________________________________82

3. Principe de la méthodologie___________________________________________ 83

3.1. Modélisation de l’application ____________________________________________84

3.1.1. Calcul du temps de propagation d’un message ____________________________________84

3.1.2. Calcul du délai de transmission d’un message_____________________________________86

3.1.3. Calcul des dates d’insertion des messages________________________________________95

3.2. Prise en compte de la précédence _________________________________________99

3.2.1. Mise à jour des dates de réveil des tâches réceptrices _______________________________99

3.2.2. Mise à jour des dates de réveil des tâches successeurs _____________________________100

3.3. Ordonnancement des tâches et des messages ______________________________105

4. Exemples d’applications temps réel réparties____________________________ 106

4.1. Exemple du producteur/consommateur___________________________________106

4.1.1. Calcul des paramètres temporels des messages ___________________________________107

4.1.2. Prise en compte de la précédence globale _______________________________________108

4.1.3. Ordonnancement des tâches et des messages_____________________________________108

4.2. Exemple de l’ascenseur ________________________________________________109

4.2.1. Cahier des charges_________________________________________________________110

4.2.2. Étude de l’application ______________________________________________________111

4.2.3. Application de la méthodologie d’analyse_______________________________________114

5. Conclusion _______________________________________________________ 118

1

Chapitre 6 : Analyse des Performances

1. Introduction _______________________________________________________121

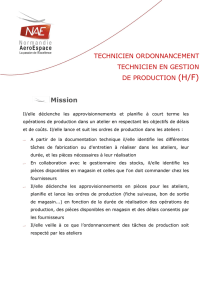

2. MOSARTS : un outil de validation d’applications temps réel réparties ________121

2.1. Description de l’application_____________________________________________122

2.1.1. Description d’un site_______________________________________________________ 122

2.1.2. Description du réseau ______________________________________________________ 123

2.2. Le noyau fonctionnel de MOSARTS _____________________________________124

3. Les critères de performance mesurés ___________________________________125

3.1. Pour les tâches _______________________________________________________125

3.2. Pour les messages _____________________________________________________130

3.3. Pour l’application globale ______________________________________________132

4. Résultats de simulation ______________________________________________133

4.1. Premier exemple______________________________________________________133

4.2. Deuxième exemple ____________________________________________________138

4.2.1. Analyse temporelle des sites_________________________________________________ 138

4.2.2. Analyse temporelle du réseau ________________________________________________ 142

4.2.3. Analyse temporelle de bout en bout ___________________________________________ 146

5. Conclusion________________________________________________________146

Conclusion Générale

Bibliographie

Annexes

1

Introduction Générale

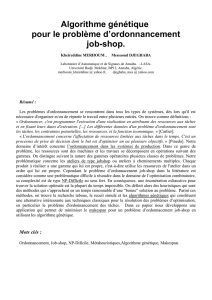

L’évolution technologique de ces dernières années, en particulier, dans les réseaux

locaux de communication, a permis le développement à grande échelle des systèmes

distribués temps réel dans de nombreux domaines du secteur industriel (aéronautique,

militaire, transport, industries des procédés, télécommunications ...). Ces applications

très variées par leurs caractéristiques (taille, environnement, contraintes, etc.) vont des

centrales nucléaires aux simples distributeurs de billets ou caisses enregistreuses. Mais

ces applications possèdent un point commun : elles sont soumises à des contraintes

temporelles.

L’augmentation de la complexité des applications impose de faire appel à des méthodes

de conception de plus en plus élaborées. En même temps que des outils de

développement, il est nécessaire de développer des outils qui servent à modéliser et à

valider ces applications.

Partant du constat qu’il n’existe presque pas de méthodes d’analyse pour vérifier qu’un

système atteint ses spécifications temps réel et afin de mesurer les paramètres de

performance, il nous a paru important de réfléchir à ce problème et d’apporter une

réponse même partielle. Dans ce travail, nous définissons les applications temps réel

réparties comme des applications composées de tâches réparties sur différents sites, qui

communiquent uniquement par échange de messages via un réseau local. Et nous

proposons une méthodologie de modélisation, de simulation et de validation de ce type

d’applications c’est-à-dire de vérification du respect des contraintes temporelles en

fonction d’une part de l’algorithme d’ordonnancement utilisé (à priorité fixe ou

dynamique) localement au niveau des sites et d’autre part du protocole de

communication temps réel utilisé sur le réseau.

Notre méthodologie étant basée sur une analyse d’ordonnançabilité, nous avons jugé

important de rappeler les études faites sur l’ordonnancement des tâches et des messages.

Ce mémoire présente six chapitres, les quatre premiers rappellent les bases essentielles à

ce travail et synthétisent les travaux existants en matière d’algorithmes

d’ordonnancement et de protocoles adaptés aux communications temps réel ; les deux

derniers décrivent le travail proprement dit:

♦ le premier chapitre rappelle les concepts de base et les définitions essentielles

des systèmes temps réel et des réseaux locaux temps réel,

♦ le deuxième chapitre a pour objectif de présenter les principales techniques

d’ordonnancement monoprocesseur de tâches temps réel ainsi que les

protocoles d’allocation de ressources intégrés à ces algorithmes pour minimiser

le temps d’attente des tâches sur l’acquisition de ressources critiques,

♦ le troisième chapitre décrit les principaux réseaux locaux temps réel utilisés

comme support de communication pour les applications temps réel

considérées. Il met l’accent sur les protocoles de communication de la couche

MAC car ils correspondent aux stratégies d’ordonnancement des messages,

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

145

145

146

146

147

147

148

148

149

149

150

150

151

151

152

152

153

153

154

154

155

155

156

156

157

157

158

158

1

/

158

100%