Cours - SVM.

Les SVM :

Séparateurs à Vastes Marges

(Support Vector Machines)

Antoine Cornuéjols

IIE & CNRS - Université de Paris-Sud, Orsay

[email protected] http://www.lri.fr/~antoine

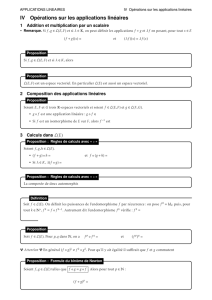

2

Les SVMs

• Séparateurs

linéaires

• Le pb

d’optimisation

• Espace de

redescription

• Illustration

• Mise en œuvre

Applications

Bilan

(01-04)Les SVMs (A. Cornuéjols)

Hyperplans séparateurs

Tâche de classification

Cas de la séparation linéaire

- On cherche hsous forme d’une fonction linéaire : h(x) = w.x+ b

- La surface de séparation est donc l’hyperplan :

- Elle est valide si

-L’hyperplan est dit sous forme canonique lorsque

ou encore

w.x b 0

i uih(xi) 0

min

iw.x b 1

i ui(w.xib) 1

3

Les SVMs

• Séparateurs

linéaires

• Le pb

d’optimisation

• Espace de

redescription

• Illustration

• Mise en œuvre

Applications

Bilan

(01-04)Les SVMs (A. Cornuéjols)

Hyperplan de plus vaste marge

Marge

maximale

Hyperplan

optimal

Hyperplan

valide

4

Les SVMs

• Séparateurs

linéaires

• Le pb

d’optimisation

• Espace de

redescription

• Illustration

• Mise en œuvre

Applications

Bilan

(01-04)Les SVMs (A. Cornuéjols)

Optimisation de la marge

5

Les SVMs

• Séparateurs

linéaires

• Le pb

d’optimisation

• Espace de

redescription

• Illustration

• Mise en œuvre

Applications

Bilan

(01-04)Les SVMs (A. Cornuéjols)

Optimisation de la marge

La distance d’un point à l’hyperplan est :

L’hyperplan optimal est celui pour lequel la distance aux points les

plus proches (marge) est maximale. Cette distance vaut

Maximiser la marge revient donc à minimiser ||w|| sous contraintes:

2

w

d(x) w.x w0

w

min 1

2w2

i ui(w.xiw0) 1

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

1

/

53

100%