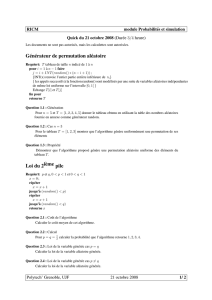

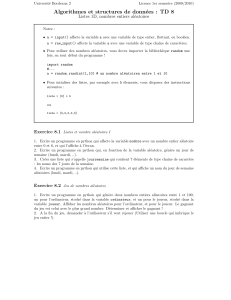

Rappels de cours (vecteurs de variables aléatoires)

X2015 – MAP 311 – PC 3

RAPPELS : Vecteurs de variables al´eatoires

Igor Kortchemski – igor.ko[email protected]olytechnique.fr

1 M´ethode de la fonction muette

Il s’agit d’une m´ethode tr`es efficace pour d´eterminer la loi d’une variable al´eatoire `a

valeurs dans n’importe quel espace (mais dans MAP 311 on se limitera `a des variables

al´eatoires `a valeurs dans Rn). Il s’agit en quelque sorte de la r´eciproque du th´eor`eme de

transfert.

Plus pr´ecis´ement, soit X= (X1, . . . , Xn) une variable al´eatoire `a valeurs dans Rn(sa

loi PXest donc une probabilit´e sur Rn). Alors, d’apr`es le th´eor`eme de transfert, pour

toute fonction h:Rn→Rcontinue born´ee, on a

E[h(X1, . . . , Xn)] = ZRn

h(x1, . . . , xn)PX(dx1, . . . , dxn).

La m´ethode de la fonction muette consiste `a utiliser le fait que, r´eciproquement, s’il

existe une probabilit´e µsur Rtelle que pour toute fonction h:Rn→Rcontinue born´ee

on

E[h(X1, . . . , Xn)] = ZRn

h(x1, . . . , xn)µ(dx1, . . . , dxn),

alors la loi de Xest µ.

Cas particulier (variable al´eatoire r´eelle `a densit´e) : Soit Yune variable

al´eatoire r´eelle et fune fonction positive. On suppose que pour toute fonction continue

born´ee h:R→Ron a

E[h(Y)] = ZR

h(x)f(x)dx.

Alors Yest une variable al´eatoire r´eelle `a densit´e et f(x) est une densit´e de Yau

point x.

Cas particulier (v.a. `a densit´e dans Rn) : Soit X= (X1, . . . , Xn) une variable

al´eatoire `a valeurs dans Rnet f:Rn→Rune fonction positive. On suppose que pour

toute fonction continue born´ee h:Rn→Ron a

E[h(X)] = ZRn

h(x1, . . . , xn)f(x1, . . . , xn)dx1· · · dxn.

Alors X= (X1, . . . , Xn) est `a densit´e, et f(x1, . . . , xn) est une densit´e de Xau point

(x1, . . . , xn).

Attention. En pratique, on utilise presque toujours la m´ethode de la fonction muette

pour d´eterminer des lois de variables al´eatoires qui ne sont pas discr`etes (sauf typi-

quement dans le cas de variables al´eatoires r´eelles d´efinies avec des minimums ou des

maximums, etc.)

Pour des questions, demande de pr´ecisions ou explications, n’h´esitez pas `a m’envoyer un mail.

1

2 Ind´ependance de variables al´eatoires

Soit (Ω,A,P) un espace probabilis´e. Si X1: (Ω,A)→(E1,E1), . . . , Xn: (Ω,A)→

(En,En) sont des variables al´eatoires, on dit qu’elles sont (mutuellement) ind´ependantes

(sous P) si

pour tous B1∈ E1, . . . , Bn∈ En,P(X1∈B1, . . . , Xn∈Bn) =

n

Y

i=1

P(Xi∈Bi).

Si Iest un ensemble quelconque, on dit que des variables al´eatoires (Xi)i∈Isont

ind´ependantes si pour tout J⊂I, avec Card(J)<∞, les variables al´eatoires (Xj)j∈J

sont ind´ependantes.

Attention. En pratique, dans MAP 311, on prendra les espaces d’arriv´ee Eide la forme

R(variable al´eatoire r´eelle) ou de la forme Rn(vecteurs de variables al´eatoires r´eelles).

On utilise tr`es souvent les principes suivants, qui construisent d’autres familles de

variables al´eatoires ind´ependantes :

Principe de composition. Soient X1: (Ω,A)→(E1,E1), . . . , Xn: (Ω,A)→

(En,En) des variables al´eatoires ind´ependantes. Si (fi:Ei→E0

i)1≤i≤nsont des fonc-

tions mesurables, alors les variables al´eatoires f1(X1), . . . , fn(Xn) sont ind´ependantes.

(Par exemple, si X, Y, Z sont des variables al´eatoires r´eelles ind´ependantes, alors

X2,1/Y, e−Zsont ind´ependantes).

Principe des coalitions. Soient X1: (Ω,A)→(E1,E1), . . . , Xn: (Ω,A)→

(En,En) des variables al´eatoires ind´ependantes. Soient 1 = i1< i2<· · · < ip−1< n

des nombres entiers. On pose

Y1= (Xi1, . . . , Xi2−1), Y2= (Xi2, . . . , Xi3−1), . . . , Yp−1= (Xip−1, . . . , Xn).

Alors Y1, . . . , Yp−1sont ind´ependantes.

(Par exemple, si X, Y, Z sont des variables al´eatoires r´eelles ind´ependantes, alors

(X, Y ) et Zsont ind´ependantes).

Attention. En pratique, on combine tr`es souvent les deux principes. Par exemple

si X, Y, Z sont des variables al´eatoires r´eelles ind´ependantes, alors X2Yet Zsont

ind´ependantes. En effet, (X, Y ) et Zsont ind´ependantes (principe des coalitions), puis

X2Yet Zsont ind´ependantes (principe de composition appliqu´e `a (X, Y ) avec la fonction

f(x, y) = x2yet `a Zavec la fonction identit´e).

Cas des variables al´eatoires r´eelles `a densit´e.

Soient X1, . . . , Xndes variables al´eatoires r´eelles `a densit´e. On note fiune densit´e

de Xi. Les variables al´eatoires X1, . . . , Xnsont ind´ependantes si et seulement une

densit´e de (X1, . . . , Xn) au point (x1, . . . , xn) est (presque partout) f1(x1)· · · fn(xn).

2

Version fonctionnelle de l’ind´ependance. Dans les calculs, on utilise tr`es souvent

le r´esultat suivant.

Soient X1, . . . , Xndes variables al´eatoires r´eelles ind´ependantes. Alors

∗(Cas positif) On suppose que P(Xi≥0) = 1 pour tout 1 ≤i≤n. Alors

E"n

Y

i=1

Xi#=

n

Y

i=1

E[Xi]∈R+∪ {+∞}.

∗(Cas de signe quelconque) Si X1, . . . , Xnsont int´egrables, alors X1X2· · · Xn

est int´egrable. Dans ce cas, on a alors E[Qn

i=1 Xi] = Qn

i=1 E[Xi].

Informellement, l’esp´erance transforme les produits (de variables al´eatoires r´eelles

ind´ependantes) en produit d’esp´erances.

3 Propri´et´es g´en´erales de l’esp´erance

On utilise tr`es souvent les propri´et´es suivantes de l’esp´erance pour des variables al´eatoires

r´eelles.

Cas positif. Soient Xet Ydeux variables al´eatoires r´eelles telles que P(X≥0) =

P(Y≥0) = 1.

∗(Lin´earit´e) On a E[X+Y] = E[X] + E[Y]∈R+∪ {+∞}.

∗(Positivit´e) On a E[X]≥0. De plus E[X] = 0 si et seulement si P(X= 0) =

1.

∗(Croissance) Si P(X≤Y) = 1, alors E[X]≤E[Y].

Ainsi, si Xest une variable al´eatoire de signe quelconque et Yune variable al´eatoire po-

sitive int´egrable telle que P(|X| ≤ Y) = 1 (c’est-`a-dire |X(ω)| ≤ Y(ω) presque sˆurement),

alors Xest int´egrable.

En particulier, si Xest une variable al´eatoire r´eelle born´ee (c’est-`a-dire qu’il existe

M > 0 tel que P(|X| ≤ M) = 1), alors Xest int´egrable.

Cas de signe quelconque. Soient Xet Ydeux variables al´eatoires r´eelles.

∗(Lin´earit´e) Si Xet Ysont int´egrables, alors X+Yest int´egrable et on a

E[X+Y] = E[X] + E[Y].

∗(Croissance) Si P(X≤Y) = 1 et si X, Y sont int´egrables, alors E[X]≤E[Y].

∗(In´egalit´e triangulaire) Si Xest int´egrable, alors |E[X]| ≤ E[|X|].

3

4 Utilisation des fonctions indicatrices

Soit (Ω,A,P) un espace probabilis´e. Si A∈ A, on note

A

la variable al´eatoire d´efinie par

A(ω) = (1 si ω∈A

0 si ω6∈ A.

Calcul d’une probabilit´e avec le th´eor`eme de transfert.

On a P(A) = E[A]. En particulier, si Xest une variable al´eatoire `a valeurs dans

Rnet Best un bor´elien de Rn, on a

P(X∈B) = E[X∈B].

Cas particulier. Si X= (X1, . . . , Xn) a une densit´e f(x1, . . . , xn) au point

(x1, . . . , xn), on peut calculer P(X∈B) avec le th´eor`eme de transfert par une int´egrale

multiple :

P(X∈B) = E[X∈B] = ZRn

(x1,...,xn)∈Bf(x1, . . . , xn)dx1· · · dxn.

Petites astuces. Soit Xune variable al´eatoire r´eelle.

∗Si X≥0 (c’est-`a-dire X(ω)≥0 pour tout ω∈Ω), on a XA≤X(en particulier

E[XA]≤E[X]).

∗Si A1, . . . , Ansont des ´ev´enements disjoints qui forment une partition de Ω, on a

1 = A1+· · · +An

(c’est-`a-dire que pour tout ω∈Ω on a 1 = A1(ω) + · · · +An(ω)). En particulier,

si Xest int´egrable, on a

E[X] =

n

X

i=1

E[XAi],

ce qui permet de calculer des esp´erances en faisant des disjonctions de cas.

4

1

/

4

100%