Télécharger la page en version PDF

Vous êtes ici :

Accueil> Soutenabilité

> 9 QUESTIONS PIÈGES DU DÉVELOPPEMENT DURABLE (Archives)

9 QUESTIONS PIÈGES DU DÉVELOPPEMENT

DURABLE (Archives)

La biodiversité est-elle réellement menacée ? Si oui, est-ce

si grave ?

La biodiversité ne désigne pas seulement la diversité des espèces

mais également la diversité des gènes, c'est-à-dire des patrimoines

génétiques au sein d'une même espèce, et la diversité des

écosystèmes, c'est-à-dire des ensembles formés par les plantes,

animaux, micro-organismes qui interagissent entre eux et avec le

milieu dans lesquels ils vivent. Bien sûr, ces 3 niveaux sont

inter-dépendants : une modification d'un écosystème peut favoriser

certaines espèces au détriment d'autres. Certaines espèces seront

plus à même de s'adapter à cette modification en raison de la

diversité de leurs gènes et de leur transmission au sein de l'espèce. Alors, qu'en est-il des menaces pesant

sur la biodiversité ? La situation est-elle dramatique ou bien considérablement exagérée par les défenseurs

de l'environnement ?

La diversité biologique n'a-t-elle pas toujours évolué au cours de l'histoire ?

La biodiversité actuelle est le résultat d'une longue évolution naturelle : gènes, espèces et écosystèmes

s'adaptent constamment, ou non, au monde changeant. Certains disparaissent, d'autres apparaissent. On

estime actuellement que les espèces identifiées (1,7 million) ne représentent qu'environ 1% de toutes les

espèces ayant vécu sur Terre... Mais comme les paléontologues, il nous faut distinguer les périodes

d'évolution normale durant lesquelles les espèces apparaissent et disparaissent sans cesse sur des temps

longs et les périodes de ruptures où les extinctions sont rapides et massives. La dernière extinction remonte à

DOSSIER

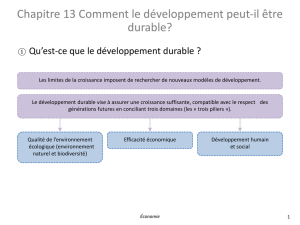

Les débats sur le changement climatique, ses menaces pour

notre planète, et l'impératif de développement durable conduisent

invariablement aux mêmes interrogations : la biodiversité est-elle

réellement menacée ? Sommes-nous vraiment responsables du

changement climatique ? Peut-on concilier croissance

économique et protection de l'environnement ? Sommes-nous

trop nombreux sur Terre ? Etc. Certes, le sujet est

particulièrement complexe, mais ces questions récurrentes ne

révèlent-elles pas aussi nos difficultés à envisager notre part de

responsabilité et des changements de nos modes de vie ? Afin de

tordre le cou aux idées reçues et au scepticisme persistant,

revenons sur quelques questions pièges du développement

durable...

la fin du Crétacé, il y a 65 millions d'années. Elle serait due à un bouleversement majeur de l'écosystème

terrestre et a entrainé notamment la disparition des dinosaures. Depuis, un nouvel équilibre s'est constitué,

mais aujourd'hui, certains spécialistes l'estiment menacé...

Quelles menaces nouvelles pèsent sur la biodiversité ?

Montrant du doigt les activités humaines, certains spécialistes de la biodiversité n'hésitent pas à annoncer les

prémices d'une nouvelle extinction. Toute espèce a une durée de vie limitée de l'ordre de 5 à 10 millions

d'années. Or, le rythme actuel de disparition des espèces est très largement supérieur au rythme de

disparition « naturel », estime le CNRS. Cette accélération du rythme des disparitions inquiète

particulièrement car l'extinction d'espèces en entraîne d'autres, en cascade. Les causes principales de la

perte de biodiversité sont majoritairement dues à l'activité humaine. Jugez plutôt la liste établie par le groupe

de scientifiques du Millenium Ecosystem Assessment (2005) : la destruction ou la dégradation des

écosystèmes et des habitats en raison de la déforestation, de l'urbanisation, de la fragmentation des habitats,

etc. ; le changement climatique, du notamment aux rejets des gaz à effet de serre ; la surexploitation de la

diversité via des activités de chasse, de pêche et d'exploitation forestière qui excèdent les capacités de

régénération des espèces ; la prolifération d'espèces invasives, sur-cultivées, importées ou encore introduites

accidentellement ; la pollution de l'air, de l'eau ou des sols. En outre, ces facteurs interagissent et tendent à se

renforcer.

Pourquoi vouloir préserver la biodiversité ?

Certaines raisons relèvent de la morale ou de l'éthique. Le grand public y est souvent très sensible et se

montre prêt à « reconnaître un droit de vie aux autres espèces, attribuer à cette biodiversité une valeur

intrinsèque » ou à « léguer aux générations futures un monde dont la diversité biologique est intacte, au nom

de la solidarité intergénérationnelle » comme le résume Aurélien Boutaud.

Mais d'autres raisons, plus utilitaristes, sont utilisées notamment lorsque la biodiversité est considérée comme

une richesse. Les services rendus par la biodiversité sont difficiles à chiffrer, mais leur disparition pourrait

s'avérer catastrophique pour l'économie humaine. On peut citer par exemple les services rendus par les

insectes pollinisateurs, indispensables dans de nombreuses cultures et estimés à plus de 150 milliards

d'euros chaque année, les services rendus par les organismes contribuant au traitement et à la dépollution

des écosystèmes, ou encore les services « culturels » (spirituels, esthétiques, récréatifs, etc.). La biodiversité

constitue aussi une source potentielle d'informations et de connaissances. Entamer la biodiversité équivaut à

brûler des bibliothèques entières d'informations, pour reprendre l'image du biologiste Edward O. Wilson

(2007). Et plus grave, « nous n'avons aucune idée de la valeur pour l'humanité de ce que nous perdons en

termes d'information » (E.O.Wilson). En d'autres termes, des molécules disparaissent alors qu'elles auraient

pu avoir une grande utilité pour l'humanité et cette perte est irréversible.

Le changement climatique est-il vraiment dû aux activités

humaines ?

Le (Groupe d'Experts Intergouvernemental sur l'Evolution du GIEC

Climat) affirme que l'évolution de la température terrestre au 20ème

siècle est due aux émissions de gaz à effet de serre anthropiques,

c'est-à-dire relevant des activités humaines. Pourtant, des experts

sont encore sceptiques et jugent cette explication peut crédible...

Le changement climatique n'est-il pas un phénomène naturel ?

Bien-sûr et depuis 4 milliards d'années, le climat de la Terre évolue

constamment. Les prélèvements de glace réalisés dans l'Antarctique

le prouvent, au moins pour les 400.000 dernières années. L'ère quaternaire, période géologique débutant il y

a environ 2 millions d'années et qui se poursuit encore actuellement, se caractérise par l'alternance environ

tous les 100.000 ans de longues périodes glaciaires et de périodes de réchauffement plus courtes. Nous

sommes actuellement dans une période interglaciaire avec une température plus élevée que la moyenne des

400.000 dernières années. Ce passage à une période interglaciaire s'explique par plusieurs facteurs naturels :

la position de la Terre par rapport au soleil, les fluctuations de l'activité solaire, les modifications de la

composition de l'atmosphère et l'effet de serre.

Mais un net réchauffement est observé depuis le début du 20ème siècle, et plus encore depuis 1970...

Si les experts ne s'entendent pas sur l'importance du phénomène et s'il y a eu ou non des précédents au

cours de l'Histoire, tous s'accordent sur l'importante augmentation de température depuis le début du 20ème

siècle et particulièrement entre 1970 et 2000. Ensuite, les avis divergent quant il s'agit d'expliquer cette

augmentation de température. La grande majorité de la communauté scientifique impute le réchauffement

actuel au renforcement de l'effet de serre, du fait de l'augmentation des concentrations de gaz à effet de serre

dans l'atmosphère (vapeur d'eau, CO2, méthane...). Mais certains scientifiques pensent que les facteurs

naturels, l'influence du soleil en particulier, jouent un rôle plus important et estiment que l'influence du CO2 a

été surestimée dans les modèles utilisés.

L'augmentation de l'effet de serre est majoritairement due à l'activité humaine

Cette explication est largement admise par la communauté scientifique et très documentée. Les émissions de

CO2 ont augmenté de plus de 30% depuis la fin du 19ème siècle, le méthane de 150%. Cette augmentation

s'explique par la combustion de carburants fossiles toujours plus grande, par la déforestation et certaines

pratiques agricoles (bétail et rizicultures notamment).

Un réchauffement climatique certain... mais aux explications encore incertaines

En bref, le réchauffement climatique ces dernières années est avéré et les modélisations pour l'avenir, bien

qu'incertaines, sont alarmantes. Selon les scénarios, la température moyenne augmenterait de + 1,8 à + 4°C

pour la fin du 21ème siècle, soit des niveaux jamais atteints dans l'histoire de l'humanité. Le réchauffement

climatique s'explique par la hausse des concentrations des gaz à effet de serre dans l'atmosphère. Mais

l'augmentation de l'effet de serre fait encore débat : est-elle due aux activités humaines du 20ème siècle

induisant une plus forte production de gaz à effet de serre ? Ou bien, est-elle due au soleil, comme cela a été

le cas précédemment au cours de l'ère quaternaire ? Quelle est la part de notre responsabilité ?

Pouvons-nous agir et enrayer le phénomène ? Le sujet est encore loin d'être clos...

Le développement durable et le principe de précaution

sont-ils des freins au « progrès »?

Les enjeux du développement durable ont mis au jour notre pouvoir

sur la nature (les activités humaines allant jusqu'à changer notre

climat, éteindre des espèces, ou pour le moins y contribuant), mais

aussi notre incapacité à mesurer précisément notre rôle dans ces

phénomènes et à y apporter des solutions concrètes et efficaces.

Dans ce contexte d'incertitude, le principe de précaution est né.

Certains voient dans son application une menace pour le

développement technologique. D'autres soulignent au contraire

combien le principe de précaution constitue une opportunité

d'améliorer la recherche et l'innovation.

Naissance du principe de précaution

Plus que la remise au goût du jour du bon sens, d'une certaine sagesse ou d'un appel à la prudence, le

principe de précaution prend en compte le renversement du rapport de force entre l'Homme et la Nature. Le

philosophe allemand Hans Jonas, un des principaux artisans du principe de précaution, constate que les

progrès de la technique ont permis à l'Homme de développer une puissance sans précédent mais

potentiellement menaçante pour la pérennité de la vie humaine sur Terre. Cette puissance inédite implique

également une responsabilité nouvelle pour l'homme, notamment à l'égard des générations futures. Jonas

appelle donc à une forme de maîtrise de la technique, conditionnée par un principe éthique visant à assurer «

la permanence d'une vie authentiquement humaine sur Terre ». On parle alors de principe de prévoyance en

Allemagne dans les années 1970. Ce principe, enrichi et précisé, sera à l'origine du principe de précaution

introduit dans (1992) : « pour protégerla Déclaration de Rio sur l'environnement et le développement

l'environnement, des mesures de précaution doivent être largement appliquées par les Etats selon leurs

capacités. En cas de risque de dommages graves ou irréversibles, l'absence de certitude scientifique absolue

ne doit pas servir de prétexte pour remettre à plus tard l'adoption de mesures effectives visant à prévenir la

dégradation de l'environnement » (article 15). En France, (1995) sur les espaces naturels intègrela loi Barnier

la notion de principe de précaution pour la 1ère fois.

Précaution, prévention ou prudence ?

Le principe de précaution s'applique dans un contexte marqué par un risque qui est à la fois incertain (le

risque est supposé, mais pas démontré) et potentiellement grave et/ou irréversible. Cette dimension est bien

souvent oubliée dans les médias et par le grand public : la précaution est relative à des risques potentiels (ex.

les OGM, les ondes de téléphones portables, les nanotechnologies...) et la prévention à des risques avérés

(ex. conduire en état d'ébriété, jouer à la roulette russe, s'exposer au virus de la grippe...). A titre d'illustration,

c'est au nom du principe de précaution que l'utilisation de l'amiante aurait pu être évitée dès 1910, au moment

où les risques liés à son usage ont commencé à être évoqués. A partir des années 1960, le risque de l'usage

de l'amiante étant avéré, on se situe dans le champ de la prévention.

La prudence, dans le sens où cités par Aurélien Boutaud, l'envisagent, fait figure deKourilsky et Viney,

dénominateur commun puisqu'elle implique de « réfléchir à la portée et aux conséquences de ses actes et

prendre ses dispositions pour éviter de causer des dommages à autrui » (1999).

Le principe de précaution s'oppose à une certaine vision du progrès...

Si l'on considère le progrès comme une démarche totalement libre, sans aucune régulation, alors la principe

de précaution peut être vu comme un obstacle. Mais si le progrès est envisagé comme un processus visant

de nouvelles connaissances et une meilleure adéquation au monde dans lequel nous vivons, alors le principe

de précaution est un remarquable allié. Car son application appelle à davantage de connaissances, même si

pour certains, il pousse à « en faire trop » : les opposants exagèreraient les risques, les décideurs

chercheraient à « se couvrir » au maximum, etc.

Le principe de précaution invite à l'action dans un contexte d'incertitudes

Le principe de précaution ne vise pas l'inaction ou l'abstention. Il s'agit bel et bien d'un principe d'action visant

la prise de décisions dans un contexte d'incertitudes. Pour cela, différentes procédures sont développées afin

d'améliorer la connaissance du risque, d'assurer l'existence et la transparence du débat public entre experts,

décideurs et société civile et de prendre des mesures proportionnées et révisables en fonction de l'avancée

des connaissances... L'application du principe de précaution est donc loin de s'opposer au changement ou au

progrès.

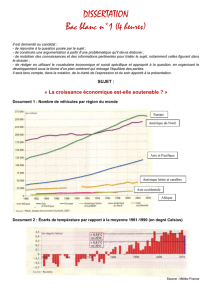

La croissance économique est-elle compatible avec la

protection de l'environnement?

Pour certains, la croissance est incompatible avec la protection de

l'environnement puisqu'elle nécessite de consommer des ressources

finies. D'autres, au contraire, considèrent que la croissance est le

meilleur moyen pour une société de protéger l'environnement.

Comme le relate Aurélien Boutaud, la controverse est ancienne,

perdure encore à l'heure actuelle et nous amène à réfléchir à la

notion même de croissance.

Dans les années 1970, la croissance est remise en cause pour des raisons écologiques

Au début du 19ème siècle déjà, des économistes évoquaient la perspective, inévitable à leurs yeux, d'un

« état stationnaire », dû aux facteurs naturels qui limiteraient à terme la croissance économique. Certains y

voient même l'aboutissement d'un long processus d'émancipation qui permettrait à l'homme de travailler

moins et de profiter davantage des plaisirs immatériels.

Les progrès technologiques ont ensuite contribué à donner l'illusion qu'il serait possible de s'affranchir des

limites naturelles et de poursuivre sans limite la croissance. Mais dès la fin des années 1960, on observe la

montée en puissance des préoccupations écologiques : dégrader l'environnement n'est pas sans danger pour

l'homme. Le dogme dominant de la croissance est alors remis en cause par de nombreux intellectuels. Une

croissance infinie est-elle possible dans un monde aux ressources finies ? La controverse éclate au grand jour

au début des années 1970 avec la publication du rapport du sur les limites de la croissance.Club de Rome

Ce rapport sera vivement critiqué mais son principal message marque les esprits : la recherche d'une

croissance continue ne peut mener à terme qu'à l'épuisement de nos ressources et donc, à notre perte.

La croissance améliore certains aspects de l'environnement « local » mais augmente les pressions

sur les ressources « globales »

Dans les années 1990, le bilan environnemental s'affine. (1992)Le Sommet de la Terre de Rio de Janeiro

contribue à sa diffusion au sein du grand public : changement climatique, extinction de la biodiversité,

désertification, épuisement des ressources fossiles et de certaines ressources renouvelables font désormais

les gros titres des journaux. Les hypothèses sur les corrélations entre la croissance économique et les

facteurs environnementaux se multiplient. Celles de l'économiste américain suggèrent que laSimon Kuznets

dégradation de l'environnement n'est qu'une phase primaire du développement économique. Passé un certain

stade, la pression sur l'environnement naturel serait obligatoirement amenée à diminuer, si bien qu'à terme la

croissance économique pourrait être le meilleur allié de l'environnement.

Mais il semble que les diminutions portent essentiellement sur des paramètres locaux. Par exemple, la part

des surfaces d'aires naturelles protégées augmente généralement à partir d'un certain niveau de revenus et

d'éducation, des réductions d'émissions de certains gaz polluants sont enregistrées dans les pays riches en

raison de la mise en place de normes ou de la délocalisation des industries vers d'autres pays. Quant aux

impacts globaux (émissions de CO2, consommations d'énergie), ils restent étroitement corrélés au niveau de

richesse puisque l'empreinte écologique d'une nation est proportionnelle à son PIB.

Viser la stabilité, l'épanouissement des personnes et le respect des limites écologiques plutôt que la

croissance ?

Ces constats alarmants ont conduits plusieurs auteurs à questionner la notion de croissance : est-elle

nécessaire et dans quelle mesure ? Passé un certain seuil de richesses, la croissance n'augmente plus le

bien-être : pourquoi dans ce cas, continuer à la rechercher dans les pays riches ? Vers quels modèles

économiques se tourner ?

La décroissance est défendue par certains auteurs mais elle pourrait générer des instabilités profondes dans

nos économies et nos sociétés, très attachées au travail, à la consommation, etc. Quant au découplage,

c'est-à-dire le fait d'allier une croissance économique et la diminution de l'impact écologique, il implique pour

les pays riches de diviser par 2 ou 3 leur empreinte écologique...

Plusieurs auteurs proposent d'inventer une forme d'économie de prospérité post-croissance. Il s'agit de viser

la stabilité et le bien-être et de rejeter le consumérisme en privilégiant l'épanouissement des personnes dans

le respect des limites écologiques, l'investissement dans des actifs écologiques (investir pour absorber du

carbone et non en expulser) et une politique de temps de travail adapté. Localement, des modèles de

développement économique durable peuvent s'appliquer et faire système afin de passer d'une « économie de

biens » à une « économie de liens ».

L'alimentation biologique peut-elle aucontribuer

développement durable ?

L'alimentation représente environ 30% de l'empreinte écologique d'un

Français (Hails, 2008). Les pratiques agricoles, les circuits de distribution,

les emballages, les pollutions entrainées par certaines pratiques, etc.

pèsent sur l'environnement. Si l'agriculture biologique apparaît souvent

comme une alternative, elle reste encore minoritaire et son coût empêche

de nombreux consommateurs d'en bénéficier.

Le bio : plus cher et réservé aux « bobos » ?

Les enquêtes réalisées en France sur le sujet montrent toutes que les

produits alimentaires issus de l'agriculture biologique sont plus chers que

ceux issus de l'agriculture intensive : de 50 à 70% en moyenne. Le profil

type des consommateurs bio correspond à des personnes un peu plus

aisées que la moyenne et plutôt issues des catégories

socioprofessionnelles supérieures. Mais quelques nuances doivent être apportées.

Si l'on s'intéresse aux non-consommateurs de bio, on s'aperçoit que les raisons financières n'expliquent pas

tout. Des raisons socioculturelles expliquent aussi cette non-consommation : le poids des habitudes

alimentaires tout d'abord, deux tiers des non consommateurs avouent ne pas avoir le réflexe d'acheter des

produits bio, et le manque d'information ou d'intérêt ensuite (d'après l' ).Agence BIO

Il faut ensuite relativiser ces écarts de prix car les comparaisons sont parfois difficiles. Certes, le label Bio

entraîne des surcoûts : la moindre productivité de l'agriculture biologique (plus d'emplois pour moins de

volumes), mais aussi le coût de la période de conversion des terres (durant laquelle l'agriculture ne peut

bénéficier du label) et les coûts liés à la certification et au contrôle. Soulignons aussi que le système de

subventions de l'agriculture favorise les systèmes de culture à forte productivité, donc très peu d'exploitations

pratiquant l'agriculture biologique. En revanche, l'agriculture intensive a de nombreux coûts cachés, car pris

en charge par l'ensemble de la société : la dépollution de l'eau, des sols, le traitement des conséquences des

pesticides sur la santé, etc. Le consommateur n'en a donc pas forcément conscience. Enfin, des observateurs

ont dénoncé les pratiques des grands distributeurs profitant de l'engouement pour les produits bio pour

augmenter leurs marges.

Pourquoi manger bio ?

Rappelons tout d'abord que « l'agriculture biologique se définit comme un mode de production agricole

exempt de produits chimiques de synthèse et d'OGM. C'est aussi et surtout un mode de production durable et

. Pour cela, il s'appuie sur une approche globale derespectueux des hommes et de leur environnement

l'exploitation et de son milieu, aussi bien dans ses composantes technico-économiques que sociales,

environnementales ou historiques. L'agriculture biologique est basée sur l'équilibre entre le sol, les animaux et

6

6

7

7

8

8

9

9

10

10

1

/

10

100%