Quand l`Univers... ...fait boum - IPPOG

É

LÉMENTAÍRE

De l’infiniment petit à l’infiniment grand

Solstice d’été 2009

Revue d’information scientifique

Quand l’Univers...

Numéro 7

...fait boum !

Revue d’information paraissant deux fois par an, publiée par : Élémentaire, LAL, Bât. 200, BP 34, 91898 Orsay Cedex

Tél. : 01 64 46 85 22 - Fax : 01 69 07 15 26. Directeur de la publication : Sébastien Descotes-Genon

Rédaction : N. Arnaud, M.-A. Bizouard, S. Descotes-Genon, L. Iconomidou-Fayard, H. Kérec, G. Le Meur, P. Roudeau, J.-A. Scarpaci, M.-

H. Schune, J. Serreau, A. Stocchi.

Illustrations graphiques : S. Castelli, B. Mazoyer, J. Serreau. Maquette : H. Kérec.

Ont participé à ce numéro : J.-L. Bobin, S. Digel (SLAC).

Remerciements : S. Plaszczynski, F. Cavalier (LAL) et nos nombreux relecteurs.`

Site internet : C. Bourge, N. Lhermitte-Guillemet, http://elementaire.web.lal.in2p3.fr/

Prix de l’abonnement : 3 euros pour le numéro 8 (par site internet ou par courrier)

Imprimeur : Imprimerie Louis Jean - 05300 Gap . Numéro ISSN : 1774-4563

É

LÉMENTAÍRE

De l’infiniment petit à l’infiniment grand

Pour ce septième numéro, nous quittons cette bonne

vieille planète Terre pour nous embarquer dans un voyage

à travers l’espace et le temps. En effet, Élémentaire se pen-

che aujourd’hui sur... notre Univers tout entier, son histoi-

re et ses grandes caractéristiques. C’est l’objet d’une vaste

discipline, appelée cosmologie, qui est parvenue au cours

des dernières années – et ce n’est pas un petit succès – à

élaborer une vision cohérente de ces sujets, vision que

vous allez découvrir au fil de ces pages, en commençant

par notre « Apéritif » !

Ainsi que nous vous le rappelons dans « Histoire », cette

volonté d’expliquer le cosmos, l’ordre céleste qui nous

entoure, est profondément enracinée dans la nature hu-

maine. Mais ce n’est qu’avec l’avènement d’une astrono-

mie de précision et de la théorie de la relativité générale

que la cosmologie moderne prend son envol au début du

vingtième siècle. Elle a ensuite bénéficié des avancées de

la physique des constituants élémentaires de la matière

pour donner naissance à son propre modèle standard, que

nous décrivons dans « Théorie ». Tout commence il y a

environ 14 milliards d’années, avec le « Big Bang », une

période où l’Univers très dense et très chaud connaît une

expansion rapide. À mesure qu’il se refroidit et se dilue,

les premiers noyaux se forment , puis les premiers atomes,

et enfin des nuages de gaz qui seront les berceaux des

premières étoiles, galaxies, amas de galaxies.. pour fina-

lement aboutir à l’Univers que nous connaissons. Mais si

ce modèle décrit de façon satisfaisante les observations

accumulées au fil des décennies, il possède aussi sa part

d’ombre. En particulier sa composition énergétique com-

prendrait environ 23% d’une matière sombre, assez mys-

térieuse et 72% d’une déroutante « énergie noire », que

nous examinons en détail dans la « Question Qui Tue ».

Fort heureusement, pour nous aider dans cette quête

de notre passé lointain, il existe un témoin privilégié de

l’Univers primordial. En effet, nous sommes en mesure de

détecter un rayonnement fossile, remontant à 380 000 ans

après le Big Bang. Si ce dernier (ou CMB) a été observé

dans les années 1960, comme nous vous le rappelons

dans « Découverte », il est loin d’avoir livré tous ses se-

crets, et il continue à fournir des informations précieuses

sur la structure de l’Univers primordial. Ainsi, la mission

Planck, lancée le 14 mai 2009 et décrite dans « Expérience

», va s’intéresser à des aspects encore méconnus du rayon-

nement fossile qu’elle captera grâce à des appareils d’une

grande sensibilité, les bolomètres, que nous décrivons dans

« Détection ». On pourra ainsi tracer des cartes du ciel très

précises décrivant les caractéristiques de ce rayonnement.

Pour tirer de ces cartes des informations supplémentaires

concernant les caractéristiques de l’Univers primordial, il

faut le plus souvent passer par des méthodes inspirées de

la transformation de Fourier, un outil mathématique pré-

senté dans « Analyse ». À l’heure où la mission Planck

vient d’être envoyée dans l’espace, nous avons demandé

à Jean-Loup Puget, l’un des chefs d’orchestre de ce projet,

de nous parler dans l’ « Interview » de ce travail de longue

haleine, rassemblant des communautés très différentes de

physiciens et d’ingénieurs.

Nous aborderons aussi d’autres aspects de la cosmologie

au fil de ce numéro. « Icpackoi » reviendra sur l’actualité

de deux autres satellites d’observation, Fermi et Pamela,

tandis que « Centre » évoquera les différents sites où l’on

cherche actuellement à détecter des signaux d’un type

nouveau : les ondes gravitationnelles. Enfin, vous retrouve-

rez les deux rubriques récurrentes d’Élémentaire : « LHC »

vous parlera du démarrage mouvementé de la machine en

septembre 2008, tandis qu’ « Énergie nucléaire » évoquera

le projet ITER dont l’objectif, à terme, est la production

d’énergie par fusion thermonucléaire.

Du haut de ce numéro, 14 milliards d’années nous con-

templent ! De quoi vous laisser le temps de savourer votre

lecture, d’ici à la parution de notre prochain (et dernier)

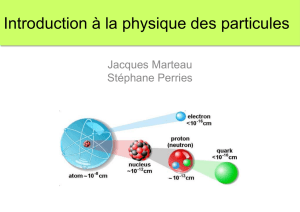

numéro. Il sera à nouveau consacré à la physique des par-

ticules, et plus particulièrement, aux phénomènes (atten-

dus, espérés, supposés...) au-delà de notre vision actuelle

de la physique des particules. D’ici là, bonne lecture !

Analyse p. 42

Transformée de Fourier et

applications au CMB

Interview p. 14

Jean-Loup Puget

Détection p. 34

Bolomètres

Accélérateurs p. 47

Un sujet très sérieux :

les accélérateurs co(s)miques

Histoire p. 9

Petite histoire de la cosmologie

É

LÉMENTAÍRE

De l’infiniment petit à l’infiniment grand

Retombées p. 37

Le GPS

La question qui tue

p. 77

Combien pèse le vide ?

ICPACKOI p. 71

GLAST : une nouvelle « star »

dans le ciel

PAMELA : alerte aux positrons !

Le LHC p. 67

Démarrage du LHC : le 10 septem-

bre 2008

Apéritif p. 4

L’archéologie cosmique :

reconstruire l’histoire de

notre univers

Centre de

recherche p. 19

Observatoires d’ondes gravita-

tionnelles

Théorie p. 59

Le modèle cosmologique standard

Expérience p. 29

La mission Planck

Découvertes p. 53

Le rayonnement fossile

Abonnement : faites votre demande d’abonnement sur le

serveur : http://elementaire.web.lal.in2p3.fr/ ou à l’adresse : Groupe

Élémentaire LAL, Bât 200, BP 34, 91898 Orsay cedex. Numéro 8 (port

inclus) : 3 euros, chèque libellé à l’ordre de «AGENT COMPTABLE

SECONDAIRE DU CNRS». Pour les administrations les bons de

commande sont bienvenus.

Contact : elemen[email protected]

Énergie nucléaire p. 81

ITER : vers une future source

d’énergie ?

page 4

É

LÉMENTAÍRE

Apéritif

Le modèle standard de la cosmologie

La cosmologie est la science qui étudie l’Univers dans son ensemble.

Tels des archéologues cosmiques, les cosmologues tentent de retracer

son histoire à partir de ce qu’ils peuvent en observer aujourd’hui. Si l’être

humain s’est toujours interrogé sur l’origine et l’histoire de l’Univers, l’ère de

la cosmologie moderne, c’est-à-dire de la cosmologie quantitative, basée

sur des observations et des mesures précises, a commencé seulement au

cours du siècle dernier, dans les Années Folles.

Deux évènements marquent son avènement. En 1929, Edwin

Hubble et Milton Humason découvrent la loi de l’expansion

universelle : toutes les galaxies s’éloignent de nous avec une

vitesse proportionnelle à leur distance. Le principe cosmologique,

socle de la cosmologie moderne hérité des astronomes du passé

comme Giordano Bruno ou Galilée, suppose que notre position

dans l’Univers n’a rien de particulier : nous sommes situés, non

pas au centre de l’Univers, mais plutôt en un point comme

n’importe quel autre. On doit donc en conclure que les galaxies

s’éloignent, non pas de « nous », mais les unes des autres,

remettant en question l’idée séculaire d’un Univers statique.

Quelques années auparavant, au début des années 1920, certains

théoriciens, comme Georges Lemaître ou Alexander Friedmann,

avaient, eux aussi, fait une découverte importante. À partir de la

toute nouvelle théorie de la relativité générale d’Albert Einstein,

ils avaient déduit des lois régissant la dynamique de l’Univers

dans son ensemble et montré que les solutions génériques des

équations correspondaient, non pas à un Univers statique, mais

à un Univers en expansion ! Cette vision, corroborée par la

théorie et l’observation, marque la naissance de la cosmologie

moderne.

La progression des observations cosmologiques, permettant des

mesures de plus en plus précises concernant l’Univers à grande

échelle, et le développement conjoint des idées théoriques

ont donné lieu à une description cohérente de l’histoire de

notre Univers remontant de nos jours jusqu’à environ 13,7

milliards d’années dans le passé : c’est le « modèle standard »

de la cosmologie. Celui-ci inclut le modèle connu sous le nom

de « Big Bang », mais aussi une phase d’expansion accélérée

durant les tous premiers instants de l’Univers, appelée « inflation

cosmique ». Il repose sur le principe cosmologique ainsi que

sur certaines hypothèses de base comme, par exemple, celle

d’homogénéité et d’isotropie à grande échelle. Les propriétés

globales de l’Univers sont caractérisées par un certain nombre

de paramètres, comme son contenu énergétique, la quantité

relative de matière et d’antimatière, l’époque de formation des

L’archéologie cosmique : reconstruire

À grande échelle

En astronomie, il existe plusieurs unités pour exprimer les

distances des objets observés, qui sont adaptées à l’ordre

de grandeur de cette distance. Par exemple, pour les

planètes du système solaire, on emploie comme unité le

km. Ainsi Pluton, l’ex-planète la plus éloignée du Soleil est

à 9,5 milliards de kilomètres (km). Pour une étoile de notre

Galaxie, on utilise plutôt l’année-lumière qui est la distance

que parcourt la lumière dans le vide pendant un an, soit 9 460

milliards de km. Le diamètre de notre Galaxie est d’environ

100 000 années-lumière. Au-delà des échelles galactiques,

il est d’usage d’employer une autre unité : le parsec, qui est

la distance à laquelle on observe la distance Terre-Soleil

sous un angle d’une seconde d’arc, c’est-à-dire 3,26 années-

lumière. Ainsi le Groupe Local, qui forme un ensemble de 30

galaxies les plus proches de nous, a un diamètre de 3 millions

de parsec. Au-delà de la centaine de millions de parsec, on

parle de distance à grande échelle ou d’échelle cosmologique.

Il s’agit donc de distances largement supérieures à celles

entre galaxies. On est capable d’observer des objets à de

telles distances cosmologiques. Par exemple la galaxie la plus

éloignée jamais observée est à environ 4 milliards de parsecs

de nous.

1 année-lumière = 9460 milliards de km.

1 parsec = 3,26 années-lumière = 30 800 milliards de km.

Ex-planète

Selon la dernière définition de l’Union Astronomique

Internationale (août 2006), une planète est un corps céleste

qui est en orbite autour du Soleil, qui possède une masse

suffisante pour que sa gravité l’emporte sur les forces de

cohésion de corps solide pour lui donner une forme presque

sphérique, et qui a éliminé tout corps se déplaçant sur une

orbite proche. Cette définition implique que le système

solaire possède actuellement huit planètes : Mercure, Vénus,

la Terre, Mars, Jupiter, Saturne, Uranus et Neptune.

Cette nouvelle définition a nécessité dix jours de discussion

entre 400 scientifiques de l’UAI. En effet, certains

rechignaient à faire perdre à Pluton son statut de planète.

En lot de consolation, l’UAI a créé une nouvelle classe

d’objets, les planètes naines, trop petites pour avoir « fait

le ménage » sur leur orbite. Les premiers membres de ce

club sont l’ancienne planète Pluton et les anciens astéroïdes

Cérès et Éris.

page 5

É

LÉMENTAÍRE

l’histoire de notre univers

Pluton et ses trois satellites connus :

Charon, Nix et Hydra, vus par le téléscope

spatial Hubble.

premières étoiles, etc. Au total 21 paramètres indépendants permettent

de rendre compte de l’Univers observé à ce jour dans le cadre du modèle

standard de la cosmologie (voir « Théorie »).

La Terre est ronde... mais l’Univers est plat !

Une caractéristique importante de l’Univers est son contenu énergétique,

qui détermine son évolution. De façon remarquable, il est possible de

déterminer la densité d’énergie totale de l’Univers sans pour autant avoir

une compréhension précise du détail de son contenu. On utilise pour cela

un aspect fondamental de la théorie de la relativité générale : la présence

d’énergie déforme l’espace-temps. C’est cette déformation, appelée

« courbure », qui est responsable de la force de gravitation dont nous

observons les effets dans l’Univers tout entier.

La quantité totale d’énergie par unité de volume de l’Univers est directement

reliée à la courbure de l’espace, c’est-à-dire la partie spatiale de l’espace-

temps. Selon que cette dernière est positive, négative ou nulle, on parle

d’un univers « fermé », « ouvert », ou « plat ». Pour faire une analogie

entre notre espace tridimensionnel et des objets bidimensionnels, ces trois

cas correspondraient respectivement à un ballon, une chips, ou une table

qui se dilate avec le temps du fait de l’expansion. Si les deux premières

situations sont les plus génériques, le cas d’un univers plat correspond à

une valeur particulière de la densité d’énergie, appelée « densité critique »

et donnée par la formule :

ρc = 3H2c2/8πG ~ 9 x 10-10 J/m3,

où H est la constante de Hubble, c la vitesse de la lumière dans le vide et

G la constante de Newton. Elle équivaut à la densité énergétique d’un gaz

d’hydrogène contenant environ 6 atomes par m3.

Pendant longtemps, il fut difficile de déterminer expérimentalement à quel

cas correspond notre univers, étant donné qu’il est nécessaire d’observer

des objets extrêmement lointains pour mettre en évidence une courbure

(comme il est difficile pour une fourmi à la surface de la Terre de se rendre

compte qu’elle est ronde). Un des résultats majeurs des satellites COBE

dans les années 1990, et WMAP 10 ans plus tard, qui mesurèrent avec

précision le rayonnement fossile, mis en évidence en 1965 par Penzias

et Wilson (voir « Découverte »), fut de déterminer que l’Univers est

(spatialement) plat à grande échelle, et donc que la densité totale d’énergie

est égale à la densité critique au pour cent près.

Si l’espace est plat, qu’en est-il de l’espace-temps ? Sa courbure est reflétée

par le taux d’expansion. Pour mesurer ce dernier, la bonne vieille méthode

de Hubble et Humason reste encore la meilleure : on mesure la distance

et la vitesse d’éloignement d’objets aussi lointains (c’est-à-dire anciens)

que possible et on en déduit le taux d’expansion. Facile à dire, pas si

facile à faire, notamment à cause du fait que les mesures de distances sont

difficiles pour des objets lointains. On utilise pour cela des « chandelles

standard », objets astrophysiques dont on connaît la luminosité intrinsèque.

13,7 milliards d’années

Ce chiffre, souvent appelé, par abus de

langage, « âge de l’Univers » est en fait le

temps jusqu’auquel les mesures et la théorie

permettent de remonter. Il correspond à une

époque où l’Univers était si dense que les lois

de la physique que nous avons découvertes

au cours de notre histoire ne constituent plus

une description cohérente. En particulier si

on remonte plus avant le temps, on se heurte

à la « barrière de Planck », échelle d’énergie

au-delà de laquelle les effets gravitationnels

et quantiques devraient être d’importance

comparable et où une théorie quantique de

la gravitation, encore manquante, devient

nécessaire.

Homogénéité et isotropie

L’hypothèse d’un Univers parfaitement

homogène, sans grumeaux, tel une

sauce béchamel réussie n’est sûrement

pas vraie aux échelles galactiques ou

intergalactiques (les galaxies jouant

le rôle de grumeaux), mais s’avère

relativement bonne aux très grandes

échelles (cosmologiques). Il en va de

même pour l’hypothèse d’isotropie qui

stipule qu’il n’existe a priori aucune

direction privilégiée dans l’Univers... à

grande échelle.

© Hubble

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

1

/

88

100%