magazine scientifique - Université Paul Sabatier

magazine scientifique

PAUL

SABATIER

www.ups-tlse.fr

Délégation

Midi-Pyrénées

Avec la

participation de

Délégation régionale

Midi-Pyrénées, Limousin

www.ups-tlse.fr

DOSSIER

La planétologie

N°24

février 2012

Paul Sabatier

N° 24 • Février 2012

Illustration

de couverture :

Représentation du Rover

Curiosity (mission MSL)

en action sur Mars, avec

un tir laser de ChemCam

en premier plan.

(©NASA/JPL-Caltech).

Directeur

de la publication :

Gilles Fourtanier

Rédacteur en chef :

Daniel Guedalia

Comité de rédaction :

Jean-François Arnal

Patrick Calvas

Daniel Guedalia

Guy Lavigne

Fréderic Mompiou

Aude Olivier

Martine Poux

Carine Desaulty

Nathalie Boudet

Valeria Medina

(délégation Midi-Pyrénées

du CNRS)

Christine Ferran

(délégation régionale

Midi-Pyrénées de l’Iserm)

Conseillère de rédaction :

Anne Debroise

Diffusion :

Joëlle Dulon

Coordination

du dossier Planétologie

Michael Toplis

Conception graphique

et impression :

Ogham-Delort

05 62 71 35 35 n° 1347

dépôt légal :

Février 2012

ISSN : 1779-5478

Tirage : 2 000 ex.

Université Paul Sabatier

118, route de Narbonne

31 062 Toulouse cedex 9

magazine scientifique

PAUL

SABATIER

www.ups-tlse.fr

Délégation

Midi-Pyrénées

Avec la

participation de

Délégation régionale

Midi-Pyrénées, Limousin

DOSSIER

La planétologie

N°24

février 2012

Vos encouragements,

vos critiques, vos suggestions,

une seule adresse :

revue-paulsabatier@

adm.ups-tlse.fr

Vous pouvez consulter et télécharger ce

magazine et les numéros antérieurs

sur le site www.ups-tlse.fr

(rubrique « diffusion des savoirs/

le magazine scientifique »)

a

Infos en

Dossier

La planétologie

Vie des laboratoires

Innovation

p. 4

p. 12

p. 22

Peau neuve…

L

e magazine scientifique Paul Sabatier fait peau neuve…

Après huit ans

d’existence sous sa jaquette initiale qui datait de juin 2004, il méritait en

effet un « lifting ». La couverture a été retravaillée pour la rendre plus attractive.

Pour les pages intérieures un format à trois colonnes a été adopté. Ce nouveau

format permet d’améliorer la place réservée aux graphiques et aux photos, répondant

ainsi à de nombreuses demandes de lecteurs, tout en gardant le même volume de texte.

Vous noterez l’apparition d’une image sur la quatrième de couverture offrant un autre

regard sur la recherche dans nos laboratoires. Tous ces changements s’appuient sur de

nouveaux codes de couleurs pour mieux identifier les différentes rubriques.

Sur le fond, les modifications sont aussi importantes. Depuis sa première parution,

chaque numéro du magazine comportait deux dossiers scientifiques. Ce sont 46 dossiers

qui ont été ainsi publiés depuis 2004, balayant les différentes disciplines scientifiques.

Désormais, chaque numéro ne contiendra qu’un seul dossier. Chaque dossier pourra

être préparé avec plus de temps et d’autre part, les actualités scientifiques, de plus en

plus nombreuses, auront une plus grande place. On notera aussi une modification de

la fréquence de parution du magazine, qui passe de 3 à 4 par an.

Nous espérons que ces changements rendront ce magazine encore plus accessible,

plus proche de l’actualité scientifique, sans rien perdre de sa rigueur et de son sérieux.

Que le comité de rédaction à l’origine de cette nouvelle maquette soit ici remercié

pour son implication. Rappelons également que ce magazine existe et se développe

grâce au soutien de la présidence de l’Université Paul Sabatier et des délégations

régionales du CNRS et de l’Inserm, associées à cette aventure.

Le dossier présenté dans ce numéro concerne la planétologie. Un dossier sur ce sujet

avait été publié dans le premier numéro de juin 2004. Au cours des dix dernières

années, l’exploration du système solaire a connu un essor sans précédent. Des

sondes et des rovers travaillant in situ de plus en plus perfectionnés sont envoyés

vers Mars, Vénus et Saturne, sans oublier notre propre Lune. Cette période intense

et riche en données scientifiques, a permis de réaliser d’immenses progrès quant

à notre perception de la planétologie, allant d’une vision nouvelle de l’histoire de

l’eau à la surface de Mars, à la découverte de paysages étrangement familiers

sur Titan, lune glacée de Saturne dont la surface est façonnée par des pluies de

méthane.

Les chercheurs toulousains ont eu une contribution significative à ces avancées.

Je vous souhaite, au nom du comité de rédaction, une très bonne année 2012 et

une agréable lecture, en espérant que vous serez encore plus nombreux à être

séduits par le nouveau format du magazine.

Daniel Guédalia

Rédacteur en chef du magazine

© S. Chastanet

Édito

4PAUL SABATIER février 2012

Dossier

La planétologie

La planétologie : la quête

des origines

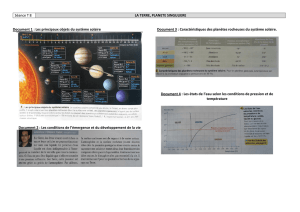

Les sondes envoyées à la rencontre des planètes du système

solaire bouleversent notre vision de l’histoire de la Terre et de

l’origine de la vie.

Depuis l’antiquité, philosophes et scienti-

fi ques ont scruté le ciel, directement ou

indirectement, animés par la question

de notre place dans l’univers. L’invention de la

lunette astronomique et la découverte des lunes

de Jupiter par Galilée en 1610 annonçaient une

ère nouvelle, où la combinaison d’observations

et d’études théoriques permettait de repousser

les limites de nos connaissances. Cependant,

malgré des télescopes de plus en plus puissants,

les planètes et leurs satellites sont longtemps

restés des objets mystérieux et lointains.

Cette situation a brusquement évolué dans la

seconde moitié du XXe siècle, avec le développe-

ment de sondes capables de voyager à travers

l’espace interplanétaire, pour scruter de près nos

voisins célestes. Le début des années soixante a

vu les premiers survols de Vénus et depuis cette

date une centaine de missions spatiales ont été

envoyées vers les principaux corps du système

solaire, de Mercure à Neptune.

Un essor sans précédent

Au cours des dix dernières années, l’exploration

du système solaire a connu un essor sans précé-

dent, avec des orbiteurs et atterrisseurs de plus

en plus perfectionnés envoyés vers Mars, Vénus

et Saturne, sans oublier notre propre Lune.

Cette période, intense et riche en données

scientifi ques, a permis de réaliser d’immenses

progrès dans notre perception de l’origine et de

l’évolution du système solaire et des objets qui

le constituent. Depuis une vision nouvelle de

l’histoire de l’eau à la surface de Mars, jusqu’à la

découverte de paysages étrangement familiers

sur Titan, lune glacée de Saturne dont la surface

est façonnée par des pluies de méthane.

Des équipes techniques et scientifi ques de

l’Observatoire Midi-Pyrénées ont participé acti-

vement à un très grand nombre de ces aventures

à dimension internationale en se trouvant en

première ligne, que ce soit dans la conception,

Contacts

u

Michael Toplis, directeur de recherche

CNRS et Pierre-Louis Blelly, directeur de

recherche CNRS, à l’Institut de recherche en

astrophysique et planétologie (IRAP, unité

mixte UPS/CNRS)

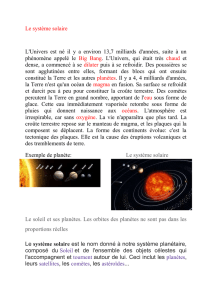

Photo prise par la sonde Galileo de la surface de

Europa, lune de Jupiter. Sous la surface glacée se

trouve un océan d’eau liquide.

© Galileo propject, JPL, NASA, retravaillée par Ted

Stryk

5

février 2012 PAUL SABATIER

La planétologie

Les formations associées :

Les recherches en planétologie couvrent un large panel de compétences allant de la conception

et la réalisation de l’instrumentation spatiale, au déploiement et l’entretien de réseaux de

sismomètres, en passant par la réalisation d’expériences de laboratoire et le développement de

modèles et de simulations numériques dans les domaines aussi divers que la thermodynamique,

les interactions rayonnement-matière, la physique des plasmas et la dynamique des fl uides

d’intérêt géophysique en général. Sur Toulouse, un grand nombre de formations permettent

d’accéder à ces compétences, en particulier les Masters de recherche en Sciences de la Terre et en

astrophysique (M2R STPS et M2R ASEP), le Master Pro Techniques spatiales et instrumentation,

ainsi que la formation assurée par le département « mesures physiques » de l’IUT.

Les formations associées :

dans la construction d’instruments embarqués,

ou bien dans l’exploitation scientifi que des don-

nées acquises par les instruments. Ces nombreux

succès ont été le fruit de collaborations effi caces,

non seulement entre équipes techniques et

scientifi ques, mais également entre chercheurs

de disciplines différentes.

En effet, la planétologie est une science pluridis-

ciplinaire par excellence depuis ses débuts, quand

astronomes, mathématiciens et physiciens per-

çaient les mystères des mouvements des astres

dans le ciel. Ce caractère pluridisciplinaire s’est

renforcé avec l’ère spatiale et la nécessité de

développer une ingénierie de pointe capable de

répondre aux contraintes de la mesure toujours

plus précise dans les environnements extrêmes.

Par ailleurs, les questionnements scientifi ques

posés par cette exploration planétaire ont sus-

cité un dialogue croissant entre planétologues,

géophysiciens et géologues.

Pluridisciplinarité

Peut-être plus qu’ailleurs, la planétologie à Tou-

louse s’inscrit totalement dans cette démarche,

caractérisée à la fois par des liens étroits entre

science et instrumentation, et par la constitution

d’équipes scientifi ques transdisciplinaires, héri-

tage de la création visionnaire, en 1995, du pôle

de planétologie à l’Observatoire Midi-Pyrénées.

Le rapprochement de spécialistes de différents

laboratoires a été une initiative déterminante

dans la création du groupe Géophysique pla-

nétaire et plasmas spatiaux (GPPS) au sein du

nouvel Institut de recherche en astrophysique et

planétologie (IRAP), créé en janvier 2011.

Le groupe GPPS est riche d’une centaine de cher-

cheurs, ingénieurs, doctorants et post-docs et

il bénéfi cie de liens forts avec le CNES. Comme

ce dossier l’illustre bien, les membres du groupe

s’intéressent à l’ensemble des enveloppes pla-

nétaires, des plus internes (noyau/manteau),

aux plus externes (magnétosphère/ionosphère),

cherchant à comprendre les processus physiques

et chimiques à l’œuvre.

La constitution du groupe GPPS ouvre la voie

à une vision intégrée des corps planétaires, qui

permettra de reconstruire leur histoire géolo-

gique, mettant ainsi en avant la grande variété

des spécifi cités de chaque objet, et contribuant

dès lors à une meilleure compréhension de l’his-

toire du système solaire dans son ensemble.

Missions

Cette décennie, riche d’une récolte excep-

tionnelle de résultats pour les équipes tou-

lousaines, par exemple la mission Cassini/

Huygens autour de Saturne ; Cluster qui

étudie l’interaction du vent solaire avec la

magnétosphère terrestre, ou les missions améri-

caines et européennes vers Mars (Mars Odyssey,

Mars Exploration Rovers, Mars Express), devrait

faire place à un avenir tout aussi prometteur.

En effet, de nombreux projets d’envergure sont

engagés pour les années à venir, dans lesquels

notre contribution instrumentale est impor-

tante : la mission Mars Science Laboratory de la

NASA lancée en décembre 2011, la mission MA-

VEN qui va partir vers Mars en 2013, la mission

BepiColombo de l’agence spatiale européenne

(ESA) qui va partir vers Mercure en 2017 ou la

mission Solar Orbiter de l’ESA prévue pour un

lancement vers le soleil en 2017.

Les principaux corps du

système solaire : les planètes,

la Lune, les astéroïdes et les

comètes.

© NASA

Le groupe participe également à la préparation

d’autres missions ambitieuses, en particulier

vers les lunes de Jupiter (mission JUICE de l’ESA)

et l’envoi du premier sismomètre vers Mars (mis-

sion InSight de la NASA).

Diffi cile de prévoir de quoi sera fait l’avenir,

car; aujourd’hui encore, la découverte de nom-

breuses planètes autour d’autres étoiles et

l’éternelle question de l’origine de la vie font

que la planétologie se diversifi e, tissant des liens

nouveaux avec d’autres disciplines, de l’astro-

physique à la biologie. Le brassage d’idées et de

cultures scientifi ques est plus que jamais néces-

saire pour explorer le contexte de notre planète

et la vie qui y est apparue. ■

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

1

/

24

100%