4 Le langage de balise

L’Encodage

Selon l’encodage des pages visualisées, le lecteur peut avoir des problèmes de

lecture des documents. Pour palier ces difficultés, il faut :

• Enregistrer dans le ”bon” encodage

• Fournir suffisamment d’infos au logiciel de visualisation pour que l’affichage de

mon texte soit correct

• Ne pas mélanger les encodages

1 Bases

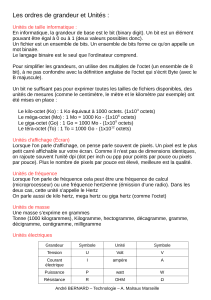

Il n’existe pas de texte en informatique. Un ordinateur ne comprend, en effet, que

le langage binaire, c’est-a-dire une suite de 0 et de 1. Un bit est une unité

élémentaire de l’information et peut donc prendre la valeur de 0 ou 1. Par

exemple les processeurs manipulent des paquets de 8 bits appelés octets. On

peut ainsi coder valeurs sur 1 seul octet. Ce qui est amplement

suffisant pour l’alphabet latin par exemple.

Ainsi, l’ordinateur fonctionne sur la base du déchiffrage d’octet : Il faut donc un

traducteur pour que notre texte soit codé puis décodé proprement et de manière

standard : c’est la qu’interviennent les tables de conversion, ou les encodages et

les normes.

2 Normes

Au début de l’informatique, on pensait que coder sur 7 bits était suffisant

puisque ̧ca permet de représenter 128 caractères différents. C’est ainsi que fut

créée la table ASCII (American Standard Code for Information Interchange), en

1968. Ce fut la table référence en informatique, elle devint même une norme :

ISO-646.

Néanmoins, on avait besoin de différents caractères en fonction de la langue

utilisée et la table ASCII fut déclinée de plusieurs façons.

D’ou l’apparition de problèmes d’incomplétude ou d’affichage pour certaines

langues. Ou par exemple de problèmes d’erreurs dues à la quasi-superposition

de certains encodages ($ se transformant en £).

3 Unicode

En 1988 est élaboré un projet: recenser tous les caractères de toutes les langues

écrites et mettre au point une table de référence universelle capable de coder

tout ça. Il doit être universel, uniforme, efficace, simple.

Plusieurs unicodes (UTF) sont crées :

• UTF-32 (4 octets) est de longueur fixe, mais il prend de la place.

• UTF-16 (2+2 octets) est parfois plus délicat à manipuler, mais il prend moins

de place et permet un bonne efficacité.

• UTF-8 (de 1 `a 4 octets) est le plus optimal pour un usage occidental, mais il

prend beaucoup de place pour coder certains caractères. Il est délicat à

manipuler.

4 Le langage de balise

Le langage de balise type est le HTML (HyperText Markup Language), c’est :

• Un langage informatique de textuel, structuré, non extensible

• Son langage ne peut pas être redéfini

• Syntaxe assez souple : une balise ouverte n’a pas toujours à être fermée.

1

/

2

100%