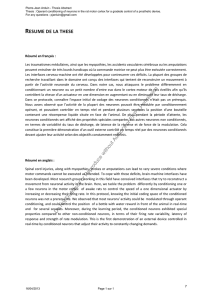

Une première vague de potentiels d`action, une première vague

Une premi`ere vague de potentiels d’action, une premi`ere

vague id´ee de la sc`ene visuelle - rˆole de l’asynchronie

dans le traitement rapide de l’information visuelle.

Rufin Vanrullen

To cite this version:

Rufin Vanrullen. Une premi`ere vague de potentiels d’action, une premi`ere vague id´ee de la sc`ene

visuelle - rˆole de l’asynchronie dans le traitement rapide de l’information visuelle.. Neurosciences

[q-bio.NC]. Universit´e Paul Sabatier - Toulouse III, 2000. Fran¸cais. <tel-00078702>

HAL Id: tel-00078702

https://tel.archives-ouvertes.fr/tel-00078702

Submitted on 7 Jun 2006

HAL is a multi-disciplinary open access

archive for the deposit and dissemination of sci-

entific research documents, whether they are pub-

lished or not. The documents may come from

teaching and research institutions in France or

abroad, or from public or private research centers.

L’archive ouverte pluridisciplinaire HAL, est

destin´ee au d´epˆot et `a la diffusion de documents

scientifiques de niveau recherche, publi´es ou non,

´emanant des ´etablissements d’enseignement et de

recherche fran¸cais ou ´etrangers, des laboratoires

publics ou priv´es.

Université Paul Sabatier

Thèse

présentée pour l'obtention du doctorat de

Sciences Cognitives

UNE PREMIERE VAGUE DE POTENTIELS D'ACTION,

UNE PREMIERE VAGUE IDEE DE LA SCENE VISUELLE.

Rôle de l'asynchronie dans le traitement rapide de l'information visuelle.

Par

Rufin VANRULLEN

M. Michel Imbert Président

M. Jeanny Herault Rapporteur

M. Francisco Varela Rapporteur

M. Bernard Doyon

M. Andrew James

M. Simon Thorpe Directeur de Thèse

Centre de Recherche Cerveau et Cognition UMR 5549 CNRS-UPS

Faculté de Médecine de Rangueil, 133 Route de Narbonne, 31062 Toulouse

1

TABLE DES MATIERES

I. INTRODUCTION __________________________________________________________________ 1

1. Anatomie du système visuel______________________________________________________ 3

1.1 Architecture hiérarchique ______________________________________________________ 3

1.2 Différentes voies, différentes propriétés___________________________________________ 8

1.2.1 Voie ventrale: traitement de la forme et identification des objets ____________________ 9

1.2.2 Voie dorsale: traitement de l'information spatiale et de mouvement ________________ 10

1.3 Connexions cortico-corticales, feed-back_________________________________________ 11

2. Les premiers modèles neuronaux du traitement visuel _______________________________ 13

2.1 Description structurelle ou représentation par vues ? _______________________________ 14

2.2 Implémentation neuronale ____________________________________________________ 15

3. Décours temporel d'activation des aires visuelles, catégorisation visuelle rapide (150 ms). 18

3.1 Electrophysiologie chez le singe _______________________________________________ 18

3.2 Psychophysique chez l'homme ________________________________________________ 20

3.3 Implications théoriques ______________________________________________________ 22

4. Les modèles de "Spiking Neurons" _______________________________________________ 24

5. Catégorisation visuelle en 50 ms? Implications pour les modèles. _____________________ 28

5.1 Résultats expérimentaux _____________________________________________________ 29

5.2 Implications théoriques fondamentales __________________________________________ 31

5.3 Catégorisation visuelle: 50 ou 150 ms? __________________________________________ 32

5.3.1 Seeck et al.: erreur conceptuelle de 1er ordre... ________________________________ 32

5.3.2 Mêmes paradigmes, résultats contradictoires: erreur conceptuelle de 2ème ordre? _____ 33

6. Résumé, formulation des objectifs _______________________________________________ 33

II. LA DUREE DU TRAITEMENT VISUEL _______________________________________________ 34

1. Catégorie "animal": un cas particulier?____________________________________________ 34

1.1 Le problème_______________________________________________________________ 34

1.2 Article n° 1 : VanRullen & Thorpe, 2000. Is it a bird, is it a plane? Ultra-rapid visual

categorization of natural and artifactual categories. Perception. _____________________________ 34

1.3 Résumé __________________________________________________________________ 52

2. Séparation des mécanismes visuels de bas- et haut-niveau___________________________ 52

2.1 Un nouveau paradigme ______________________________________________________ 53

2.2 Article n° 2 : VanRullen & Thorpe, 2000. The time course of visual processing: from

early perception to decision-making. Journal of Cognitive Neuroscience. ______________________ 53

2.3 Activité précoce: interprétation_________________________________________________ 62

2.3.1 La métaphore de l'ordinateur ______________________________________________ 62

2.3.2. La sortie de la rétine différe selon la catégorie, mais la catégorisation ne

s'effectue pas dans la rétine ______________________________________________________ 63

2.3.3 Le stimulus différe selon la catégorie, mais la catégorisation ne s'effectue pas

avant la rétine! _________________________________________________________________ 65

2.4 Activité de haut-niveau: interprétation ___________________________________________ 67

2.4.1 Relation entre l'activité électrique et la réaction motrice _________________________ 67

2.4.2 Décision ou attention? ___________________________________________________ 71

2.4.3 Conscience visuelle _____________________________________________________ 72

2.5 Deux mécanismes distincts : bases neuronales ___________________________________ 73

2.5.1 Méthode______________________________________________________________ 74

2.5.2 Activité précoce : bases neuronales ________________________________________ 74

2.5.3 Activité à 150 ms : bases neuronales _______________________________________ 77

3Synthèse: la durée du traitement visuel ___________________________________________ 79

2

III. THEORIE: CONTRAINTES, MODELES, SIMULATIONS________________________________ 82

1. Contraintes biologiques:________________________________________________________ 82

1.1 Traitement feed-forward______________________________________________________ 82

1.2 Un spike par neurone________________________________________________________ 83

2. Coder l'information avec un spike par neurone _____________________________________ 84

2.1 Article 3 : VanRullen & Thorpe, 2000. Rate coding vs. Temporal Order Coding: What

the retinal ganglion cells tell the visual cortex. Neural Computation.__________________________ 85

2.2 Complements_____________________________________________________________ 112

2.3 Le décodage de l'ordre _____________________________________________________ 114

2.4 Synchronie et oscillations: un épiphénomène? ___________________________________ 115

2.4.1 Synchronie___________________________________________________________ 117

2.4.2 Oscillations___________________________________________________________ 119

2.4.3 Codage d'information par synchronie_______________________________________ 120

2.4.4 La synchronie seule ne peut encoder l'information spatiale dans la rétine__________ 122

2.4.5 Une succession de vagues de potentiels d'action explique les observations

expérimentales de synchronie et oscillations_________________________________________ 124

2.4.6 Codage par la synchronie, ou codage par l'asynchronie? _______________________ 127

2.5 Synthèse ________________________________________________________________ 129

3Transmettre l'information en feed-forward ________________________________________ 129

3.1 Que peut-on faire de façon “feed-forward”?______________________________________ 129

3.2 Article 4 (en préparation) : VanRullen, Delorme & Thorpe. Feed-forward contour

integration based on asynchronous spike propagation. NeuroComputing _____________________ 130

3.3 Attention: précédence temporelle pour les régions d'intérêt _________________________ 136

3.3.1 L'hypothèse: Article 5. VanRullen & Thorpe, 1999. Spatial attention in

asynchronous neural networks. NeuroComputing _____________________________________ 136

3.3.2 Les arguments ________________________________________________________ 145

3.3.3 Résumé _____________________________________________________________ 164

4. Une solution pour le traitement visuel rapide?_____________________________________ 164

4.1 Article 6 : VanRullen, Gautrais, Delorme & Thorpe, 1998. Face processing using one

spike per neurone. BioSystems. ____________________________________________________ 164

4.2 Détection de visages à plusieurs tailles _________________________________________ 176

4.3 Une représentation de haut-niveau de l'entrée visuelle _____________________________ 181

IV. SYNTHESE ET PERSPECTIVES _________________________________________________ 183

1. Une théorie du traitement visuel rapide_____________________________________________ 185

2. Questions en suspens___________________________________________________________ 188

3. Conclusion ____________________________________________________________________ 191

1

I. INTRODUCTION

Le monde visuel est probablement la source d'informations la plus riche de notre

expérience sensorielle. Une large majorité des tâches que nous réalisons quotidiennement

se trouvent grandement simplifiées par notre capacité à percevoir des objets distants, et

c'est certainement pourquoi l'évolution a favorisé le développement chez bon nombre

d'espèces animales d'un système neuronal de traitement d'information entièrement dédié à

cette finalité.

Alors que des disciplines comme la philosophie ou la psychologie se sont intéressées

à cette capacité de voir depuis plusieurs millénaires, ce n'est qu'au début du XXème siècle,

avec la découverte des neurones par Santiago Ramon y Cajal (1852-1934) et Camillo Golgi

(1843-1926), couronnée par un Prix Nobel en 1906, que la discipline des Neurosciences a

pu voir le jour. Cette discipline à part entière constitue aujourd'hui une source majeure de

nos connaissances sur le fonctionnement du système visuel.

Peu avant la seconde Guerre Mondiale se sont développées les techniques

d'enregistrement sur les fibres du nerf optique, puis dans les années cinquante au niveau

cellulaire. Ceci a permis de comprendre le mécanisme de traitement neuronal de

l’information visuelle, et plus tard d'introduire la notion de champ récepteur, tout d'abord au

niveau de la rétine (Hartline, 1938; 1940a; 1940b; Kuffler 1953; Lettvin, et al. 1959; Rodieck

1965; Barlow, Hill et Levick, 1964; Barlow et Levick, 1965), puis dans le cortex visuel

primaire (Hubel et Wiesel, 1959; 1962; 1968). Ce n'est sans doute pas un hasard si ces

découvertes, qui furent permises par des avancées techniques importantes, telles les micro-

électrodes, se sont produites à un moment de l'Histoire scientifique qui voyait également

l'avènement d'une nouvelle ère technologique: la révolution informatique.

Des premiers "super-calculateurs" à l'invention des transistors, qui permit une

miniaturisation progressive des ordinateurs, le concept d'Intelligence Artificielle a servi de

moteur sous-jacent au développement de l'Informatique. La puissance computationnelle des

ordinateurs laissait envisager la possibilité de reproduire, égaler ou dépasser le cerveau

humain. Si de nombreux scientifiques aux débuts de l’ère cybernétique se sont tournés vers

une approche symbolique de l’Intelligence Artificielle, une autre approche tout aussi

importante, guidée par les travaux de Warren McCulloch et Walter Pitts (1943) et dénommée

"connexionniste", a cherché à s'inspirer des principales propriétés connues du cerveau : une

capacité de calcul globale distribuée sur un large ensemble d’unités ou de processeurs à

capacité relativement limitée : les neurones.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

145

145

146

146

147

147

148

148

149

149

150

150

151

151

152

152

153

153

154

154

155

155

156

156

157

157

158

158

159

159

160

160

161

161

162

162

163

163

164

164

165

165

166

166

167

167

168

168

169

169

170

170

171

171

172

172

173

173

174

174

175

175

176

176

177

177

178

178

179

179

180

180

181

181

182

182

183

183

184

184

185

185

186

186

187

187

188

188

189

189

190

190

191

191

192

192

193

193

194

194

195

195

196

196

197

197

198

198

199

199

200

200

201

201

202

202

203

203

204

204

205

205

206

206

207

207

208

208

209

209

210

210

211

211

212

212

213

213

214

214

215

215

216

216

217

217

218

218

219

219

220

220

221

221

1

/

221

100%