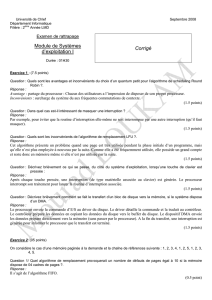

Systmes d`exploitation - Ingénierie Système et Réseaux Informatique

Institut Supérieur des Etudes

Technologiques

Mahdia - ISETMA

Systèmes d'exploitation I

Version: Cours Complet.

Année Universitaire 2009-2010

La Table Des matières

Introduction .............................................................................................................6

I. Qu'est-ce qu'un système d'exploitation? ................................................................6

II. Problématique................................................................................................................7

1) Utilisation du contrôleur de lecteur de disquettes NEC PD765 ...........7

2) Partage d'imprimante .............................................................................................8

III. Historique des systèmes d'exploitation ...............................................................9

1) Première génération (1936-1955).....................................................................9

2) Deuxième génération (1955-1965) ..................................................................9

3) Troisième génération (1965-1980).................................................................10

4) Quatrième génération (1980-2000) ...............................................................11

5) Et après?....................................................................................................................12

IV. Fonctionnalités d'un système d'exploitation....................................................12

V. Catégories des Systèmes d’exploitation............................................................14

1) SYSTEMES MULTI-TACHES.................................................................................14

2) SYSTEMES PARALLELES.......................................................................................15

3) SYSTEMES EMBARQUES ......................................................................................15

4) SYSTEMES TEMPS REEL.......................................................................................16

5) SYSTEMES DISTRIBUES ......................................................................................16

VI. Types de systèmes d'exploitation........................................................................16

1) Mono-utilisateur......................................................................................................17

2) Contrôle de processus..........................................................................................17

3) Serveurs de fichiers...............................................................................................17

4) Transactionnel .........................................................................................................18

5) Général.......................................................................................................................19

VII. Structure interne des systèmes d'exploitation généraux...........................19

1) Systèmes monolithiques......................................................................................19

2) Systèmes en couches ...........................................................................................20

3) Machines virtuelles ................................................................................................21

4) Systèmes client-serveur......................................................................................22

VIII. Principes des systèmes d'exploitation............................................................24

ISET MAHDIA Page -2-

1) Appels système .......................................................................................................24

2) Processus...................................................................................................................26

3) Système de fichiers ...............................................................................................26

Les Processus .........................................................................................................28

I. Modèle ................................................................................................................................28

1) Notion de processus..............................................................................................28

2) Relations entre processus...................................................................................30

3) États d'un processus .............................................................................................30

II. Mise en œuvre.............................................................................................................32

1) Gestion des processus..........................................................................................32

2) Gestion des interruptions....................................................................................33

a. Le traitement des interruptions.......................................................................33

b. La commutation du contexte (commutation du mot d'état)...........36

III. Communication inter-processus...........................................................................39

IV. Sections critiques .......................................................................................................40

1) Masquage des interruptions...............................................................................41

2) Variables de verrouillage.....................................................................................42

3) Variable d'alternance ............................................................................................43

4) Variables d'alternances de Peterson...............................................................44

5) Instruction TSL........................................................................................................45

6) Primitives sleep et wakeup.................................................................................46

7) Sémaphores..............................................................................................................48

8) Moniteurs...................................................................................................................50

9) Échange de messages ..........................................................................................53

V. Problèmes classiques de communication inter-processus .........................56

1) Le problème des philosophes ............................................................................56

2) Le problème des lecteurs et des rédacteurs................................................59

VI. Ordonnancement des processus ..........................................................................60

1) Introduction..............................................................................................................61

2) Types d’ordonnanceurs........................................................................................62

3) Objectifs de l'ordonnanceur d'un système multi-utilisateur..................62

4) Ordonnanceurs non préemptifs ........................................................................63

5) Ordonnanceurs préemptifs.................................................................................66

a. Ordonnancement du plus petit temps de séjour .......................................67

b. Ordonnancement circulaire ................................................................................67

c. Ordonnancement avec priorité .........................................................................71

d. Files multiples (quantum variable)..................................................................73

6) Ordonnancement à deux niveaux....................................................................74

7) Cas d'étude...............................................................................................................75

a. MS-DOS......................................................................................................................75

b. Unix..............................................................................................................................75

c. Linux............................................................................................................................76

d. Windows.....................................................................................................................81

La Mémoire............................................................................................................84

I. Mémoire sans va-et-vient ni pagination................................................................84

1) Monoprogrammation.............................................................................................85

2) Multiprogrammation..............................................................................................87

3) Multiprogrammation avec partitions fixes....................................................88

4) Translation de code et protection ....................................................................89

II. Le va-et-vient ..............................................................................................................91

1) Multiprogrammation avec partitions variables ...........................................91

2) Gestion de la mémoire.........................................................................................93

III. La mémoire virtuelle .................................................................................................97

1) Pagination..................................................................................................................98

2) Algorithmes de remplacement de pages.....................................................103

3) Modélisation des systèmes paginés..............................................................108

Les Fichiers ..........................................................................................................113

I. Structuration des fichiers..........................................................................................114

1) Types de fichiers...................................................................................................115

2) Fichiers ordinaires................................................................................................115

3) Catalogues ..............................................................................................................116

II. Structure physique des systèmes de fichiers................................................118

1) Stockage des fichiers..........................................................................................118

2) Stockage des catalogues...................................................................................122

3) Organisation de l'espace disque.....................................................................122

4) Service des requêtes...........................................................................................127

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

1

/

130

100%