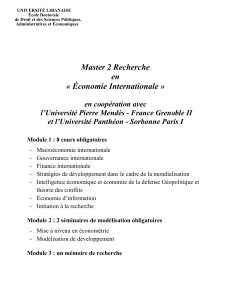

Evaluation et donnees longitudinales : quelles relations ?

111

L’évaluation en sciences sociales est-elle un mythe?

Le cas des politiques éducatives

Philippe Lemistre*

L’évaluation des politiques publiques est au cœur d’un débat que l’on peut vulgariser à l’extrême par

l’opposition constructivisme/positivisme. Opposition étroitement liée au très vieux débat sociologique

relatif au positivisme d’Auguste Comte, depuis longtemps remis en cause (ou au moins discuté) dans

cette discipline et très à la mode en économie, la croyance dans des lois économiques étant le pendant du

positivisme Comtien. L’objectif pour Auguste Comte était, comme pour les économistes néoclassiques

actuels, « d’élever » les sciences sociales au même rend que les sciences dites dures, le recours aux

mathématiques est censé parfaire ici l’analogie aux autres sciences fondamentales.

À l’opposé, une approche constructiviste mise en œuvre par de nombreux sociologues s’appuie sur les

éléments de contexte et l’histoire, ceci en mettant en œuvre des analyses qualitatives fondées sur des

entretiens ou en développant des analyses statistiques longitudinales en mobilisant des méthodes plus

descriptives. Il n’y a pas ici de prétention à l’expérimentation, mais une observation assumée au service

d’une interprétation historiquement située. En ce qui concerne les statistiques, la simplicité des méthodes

peut néanmoins limiter la portée d’interprétations qui reposent sur le passé pour en inférer le futur, ceci à

travers le choix et l’observation de catégories collectives : groupe sociaux le plus souvent, soit un

regroupement d’individus au sein des données longitudinales. À l’opposé de la précédente approche celle-

ci peut alors surdéterminer les effets de contexte. Toutefois, un garde fou important réside dans les

enquêtes qualitatives souvent associées qui permettent de mieux appréhender l’influence du contexte.

Nous proposons dans cette communication dans une première partie d’expliciter quelles sont les origines

et les outils de l’approche économique en matière d’évaluation des politiques publiques. La seconde

partie en souligne les limites et, en s’appuyant notamment sur un exemple, l’approche longitudinale de

l’expansion scolaire, met en exergue la nécessité d’associer approche quantitative (économétrie et

expérimentation sociale) et qualitative (variables d’enquête et entretien de terrain) pour prendre en

compte les évolutions du contexte et notamment des normes sociales. Il s’agit également de mettre en

regard les interprétations théoriques et/ou disciplinaires. La conclusion resitue les enjeux de l’évaluation

des politiques publiques via des données longitudinales en rappelant la nécessaire articulation entre

théorie et empirie.

1. Longitudinale, positivisme et « impérialisme » des économistes

Le réalisme du modèle néoclassique, actuellement dominant en économie, a fait l’objet et fait encore

l’objet de très nombreuses critiques et d’une polémique récurrente. Elle concerne la position de Milton

Friedman sur le réalisme des hypothèses selon laquelle « les hypothèses sont d’autant plus fécondes au

plan scientifique, dans leur capacité à ouvrir la voie à des conjectures pertinentes, qu’elles ne sont pas

réalistes » (Friedman 1953)1. Si produire de la connaissance exige de se dégager de la complexité du réel

pour construire une abstraction, toute théorie doit faire des hypothèses simplificatrices. Friedman va plus

loin car « simplificatrices » ne signifie pas « irréalistes ». L’objectif de Friedman est alors avant tout de

défendre le modèle néoclassique de concurrence pure et parfaite dont les hypothèses sont pour le moins

irréalistes (rationalité substantive, libre entrée sur le marché, libre fixation des prix, etc.). Aujourd’hui

encore l’argumentation de Friedman sert nombre de théoriciens dont ceux de l’école de Chicago, parmi

lesquels « l’inventeur de la théorie du capital humain » Gary Becker.

* Centre associé au Céreq de Toulouse, lemistre@univ-tlse1.fr.

1 « Truly important and significant hypotheses will be found to have "assumptions" that are wildly inaccurate

descriptions of reality, and, in general, the more significant the theory, the more unrealistic the assumptions »

(p. 14).

112

Dans les années 90, le constat d’une distance entre la réalité et les conclusions de nombreuses

investigations économétriques, pourtant conformes à des modèles théoriques, a conduit certains

économistes à souhaiter davantage intégrer à l’analyse des faits sociaux le contexte changeant de

l’expérimentation ou plutôt de l’observation en sciences sociales. Afin de mieux rapprocher les modèles

économiques du réel, ces économistes suggéraient de revenir à une économie plus littéraire où les

« inférences interprétatives » compléteraient l’approche mathématique théorique et empirique. Ces

dernières sont « des assertions non formalisées, suggérées par l’examen de l’histoire économique, des

événements économiques contemporains, d’activités économiques particulières, voire des résultats de

parties de la recherche économique... » (Malinvaud 1996, p. 940).

Dix ans après ce souhait, la sophistication des méthodes semble avoir résolu le problème. Ainsi, selon

Eric Maurin (2007), « L’économie empirique est une discipline aujourd’hui en plein essor au sein des

sciences économiques, particulièrement dans le domaine de l’éducation. Ce courant de recherche

accorde la primauté à l’analyse méticuleuse des faits et traque, dans les ruptures et discontinuités de

l’histoire institutionnelle et économique des sociétés, les traces des lois fondamentales qui les régissent…

En imposant une grande rigueur dans l’interprétation des données d’enquêtes disponibles, cette nouvelle

discipline est de nature à renouveler une partie des débats traditionnels sur l’école » (Maurin 2007,

p. 13-14).

À l’inverse, voire en opposition à cette posture très empirique, selon Jean Tirole l’économie s’est

longtemps adossée sur la tradition empirique, reléguant ainsi la théorie à la seule catégorie « des moyens

d’expliquer les résultats statistiques ou de privilégier certaines positions intellectuelles plutôt que la

concevoir comme un outil d’investigation systématique et rigoureux » (Tirole 1993, p. 3). Une telle

posture rejoint l’épistémologie de Karl Popper qui s’opposait assez vigoureusement à toute démarche

scientifique inductive. La prédominance des modèles théoriques est appliquée au marché du travail

(Malgrange, Rullière, Villeval 2004), c’est l’économie des ressources humaines (personnel economics)

dont Lazear a fait une première synthèse en 1995. « L’économie des ressources humaines est une

application de l’économie et des approches mathématiques aux thèmes habituels du management des

ressources humaines » (Lazear et Oyer 2007, p. 1). Toutefois dans ce domaine la validation empirique

des modèles reste importante et Lazear (1995) postule que si les hypothèses sont simplificatrices, elles

n’en restent pas moins réalistes puisque directement tirées de l’observation des pratiques au sein des

entreprises. Il ne s’agit pas de la seule contradiction avec la perspective de Friedman (op. cit.) dont la

vision de l’économie est « positive », la valeur scientifique d’une théorie économique reposant sur sa

capacité à prédire le monde tel qu’il est et non tel qu’il devrait être2. Toutefois, pour certains, reconnaitre

l’irréalisme des hypothèses et néanmoins la pertinence des modèles c’est « prétendre fournir un

"benchmark", un idéal par rapport auquel (le modèle de concurrence pure et parfaite pour Friedman) les

situations concrètes de concurrence imparfaite devraient être jaugées » (Ménard 2005, p. 167). En ce

sens l’économie est implicitement normative, par opposition ou en complément d’une économie positive,

soit explicative du réel (Perroux 1970). Finalement ce qui était implicite est peut-être devenu explicite, de

telle sorte que le réalisme des modèles est nécessaire aux objectifs affichés par les économistes des

ressources humaines, car « l’économie des ressources humaines est largement normative » (Lazear 1995,

p. 2). Ainsi, des ouvrages tout ou en partie inspirés des modèles économiques sont directement destinés

aux praticiens. Leurs titres traduisent bien la normativité du propos : Personnel Economics for Managers

(Lazear 1998), Stratégic Human Resources (Baron et Kreps 1999).

Concernant la formation, les travaux de l’économie des ressources humaines s’appliquent quasi

exclusivement à la formation postscolaire. Le « réalisme » des modèles, contesté par certains néanmoins,

est facilité par leur multiplicité qui s’applique aux diverses situations de travail (possibilité d’évaluation

des performances, travail en équipe, perspectives de long terme, etc.), situations qui vont déterminer le

choix d’un mode d’incitation au travail. En d’autres termes la perspective microéconomique faciliterait

une approche normative « réaliste ». Qu’en est-il pour l’économie de l’éducation appliquée à la formation

initiale ? Il est clair que la perspective est ici beaucoup plus macroéconomique. Cela explique sans doute

une approche plus empirique évoquée plus haut. Approche que les théoriciens modélisateurs pourraient

2 Rappelons néanmoins que les hypothèses du cadre général retenu peuvent traduire une certaine « normativité »

(Perroux 1970).

113

bien qualifier de scientifiquement peu rigoureuse, quelle que soit la sophistication des méthodes

économétriques. En effet, il n’y a pas ici de modèle théorique explicite, ou plutôt souvent une allusion à

un corpus théorique. Toutefois, depuis peu en économie de l’éducation, se développe une approche

économétrique plus « structurelle », soit une modélisation statistique directement associée et articulée

avec une modélisation théorique. L’économie empirique appliquée à l’économie de l’éducation a été

largement initiée par le Nobel James Heckman qui a évolué vers ce type de modélisation structurelle

(Carneiro et Heckman 2002 notamment).

L’apport d’une telle démarche serait de sortir d’une approche empirique qui est celle de l’économie (ou

économétrie) appliquée, où l’empirie produit des résultats qui peuvent être interprétés à l’aune de

plusieurs théories, confrontées alors pour tester leur réalisme. Une approche médiane très fréquente,

critiquée par la précédente (structurelle), est de ne pas produire de modèle empirique structurel, mais

d’opter pour une entrée théorique unique qui sous-tend, a minima, le choix des variables expliquées et

explicatives. Que le modèle soit structurel ou non, la difficulté est le traitement d’un problème

macroéconomique avec une perspective théorique unique. La réduction du nombre des hypothèses et

surtout leur application à une population très étendue conduit alors à nouveau à invoquer la rhétorique

Friedmanienne pour justifier les options théoriques. Or, ce type d’étude produit très fréquemment des

recommandations (quasi systématique dans les articles empiriques qui traitent d’économie de

l’éducation), alors que la normativité des modèles nous semble moins assurée par un réalisme des

hypothèses que dans le cadre de l’économie des ressources humaines.

Les économistes dit néoclassiques invoquent néanmoins souvent une certaine rigueur dont seraient

dépourvues d’autres approches économiques et surtout d’autres disciplines des sciences sociales,

notamment car la mathématisation des modèles légitime, selon certains, un rapprochement avec les

sciences dites dures. Ainsi, les hypothèses simplificatrices limitent le champ d’investigation mais donnent

aux modèles une certaine irréfutabilité qui légitime leur rôle normatif. Quant aux sociologues et

psychologues, leur vision moins simplificatrice ou plus globale leur permet de poser les bonnes questions,

mais l’absence de rigueur dans leurs méthodes ne leur permet pas d’apporter les bonnes réponses, qui

seront évidemment apportées par les rigoureux économistes… Une telle présentation peut paraître

caricaturale, mais il n’en est rien puisqu’elle n’est que la retranscription du passage suivant de l’ouvrage

de Lazear (1995, p. 2) : « The strength of economic theory is that it is a rigorous and analytic. It follows

the scientific method, much like physics and biology. But the weakness of economics is that rigorous,

simplifying assumptions must be made that constrain the analysis and narrow the focus of researcher. It

is for this reason that the broader-thinking industrial psychologist and sociologist are better at

identifying issues but worse at providing answers. »

De telles postures ne sont évidemment pas pour rien dans l’animosité que l’on peut percevoir entre

certains auteurs de disciplines distinctes, notamment la sociologie et l’économie notamment en ce qui

concerne l’analyse de l’expansion scolaire (Lemistre 2010). Cette opposition qui va de pair avec une

certaine radicalité des positionnements des uns et des autres, peut être finalement inhérente à tout

positionnement théorique. Ainsi, Lakatos (1994) souligne que les scientifiques acceptent difficilement le

résultat des expériences cruciales qui réfutent leurs constructions théoriques. Le plus souvent, face à un

résultat qui remet en cause leurs conjectures, les scientifiques commencent par développer des stratégies

immunisatrices. Or, selon Lakatos, une démonstration est davantage une invitation à la contestation

qu'une vérité absolue. Dans cette perspective, la stratégie immunisatrice de certains économistes semble

passer par la virtuosité (indéniable) dans l’utilisation des mathématiques et la sophistication des méthodes

empiriques.

Quel positionnement adopter en regard de ce qui précède ? Tout d’abord, il est important de rappeler les

différences, selon nous irréductibles, entre sciences sociales et sciences dures. Nous nous appuierons pour

cela, pour partie, sur les travaux de Jean Fourastié (1986). En physique ou en chimie, l’homme

n’intervient que pour réaliser l’expérience et observer le résultat. On observe ce qui se passe dans la

matière et non dans l’esprit de l’observateur. Au contraire, en économie, on observe les relations des

hommes avec les choses : ce qui compte c’est l’importance que l’homme accorde aux éléments, la

manière dont il les modifie, et dont il les consomme. L’homme est observé en même temps que la

matière. Il est à la fois observateur et observé : cela distingue fortement les sciences économiques et

physiques. Ainsi, « l’homme projette sa croyance (qu’il prend pour la vérité) sur le monde, sensible au

114

point de ne plus percevoir que difficilement, les faits qui sont en opposition avec elle » (Fourastié 1986).

C’est cette normativité de l’économie qu’évoquait François Perroux (1970). Il serait donc bien difficile

voir impossible d’atteindre, la « neutralité axiologique » prônée par Max Weber (1917), soit une attitude

du chercheur en sciences sociales n'émettant pas de jugement de valeur dans son travail. Surtout en

économie, car au sein de la sociologie de Weber, la neutralité axiologique consistait à ne pas projeter ses

propres valeurs dans l’analyse sociologique de groupes sociaux. Les valeurs étant un objet d’études, le

respect de la neutralité est donc consubstantiel à l’objet d’étude, ce qui n’est pas le cas en économie où les

croyances à la rationalité, au marché, par exemple, sont un préalable à la recherche.

La principale limite de la recherche en économie se situe peut-être sur le plan empirique. Le critère

fondamental de la science est, en effet, que des expériences identiques dans leurs éléments, les facteurs,

doivent être aussi identiques dans leurs résultats. Une expérience c’est l’observation que l’on peut

recommencer identiquement (en tout temps et en tout lieu). Or, en sciences économiques, on peut

seulement observer. On ne peut reconstituer un système identique à la première expérimentation, qui

évoluerait de la même manière. L’identité d’évolution prouve l’identité de constitution du système, et

prouve qu’aucun élément, aucun des facteurs qui interviennent dans le réel n’a été oublié ou sous-estimé

par la rationalité du théoricien. Si nous voulions essayer de reconstituer un phénomène économique, il

faudrait non seulement avoir affaire au même contexte matériel, mais aussi à des hommes qui auraient le

même état d’esprit, la même mentalité, les mêmes sentiments psychologiques, sociaux, culturels que lors

de la première expérience. « Les conséquences de ce fait sont catastrophiques : nous manquons d’une

procédure de recherche et de vérification fondamentale et cela de manière définitive. Il ne reste que

l’observation » (Fourastié 1986).

On peut néanmoins objecter, à juste titre, que l’expérimentation n’est pas impossible au niveau

microéconomique. Par exemple, dans le domaine de l’économie des ressources humaines, il existe des

organisations assez similaires qui permettent d’observer successivement des mises en œuvre de modes de

gestion de main-d’œuvre dans des contextes proches, qui ne sont certes jamais exactement similaires.

L’argumentation précédente porte plus spécifiquement sur l’analyse de phénomènes macroéconomiques,

tels que la hausse du niveau d’éducation et ses incidences. Celle-ci s’analyse sur des données empiriques

ex post, en postulant des relations de causalité à partir de telle ou telle théorie. Dans ce domaine

l’évolution de l’économétrie a fait progresser considérablement la qualité des observations qui néanmoins

restent soumises aux critiques précédentes. Pour se rapprocher d’un procédé expérimental, l’économétrie

appliquée sollicite des données synchroniques sur des pays distincts. Là encore, les contextes

expérimentaux sont bien différents et compte tenu de ce qui précède, la prétention à en induire des lois

générales, nous semble pour le moins excessive.

Conscients de certaines limites, surtout en qui concerne l’évaluation des politiques publiques, les

économistes statisticiens mobilisent de nouvelles méthodes. Il s’agit à nouveau d’aborder les sciences

sociales comme des sciences dures sur le plan empirique et plus spécifiquement de mobiliser pour évaluer

l’efficacité de dispositifs publics, des méthodes inspirées des expérimentations en médecine, type

placébo – médicament testé. Ainsi, groupes test et témoin sont tirés au hasard dans une population choisie

au départ, pour évaluer un dispositif sur une sous-population avant généralisation du dispositif. L’intérêt

de cette méthode par rapport à la précédente est de calibrer en amont les échantillons (tests et témoins)

pour assurer une variation « potentiellement » significative du phénomène observé. La méthode est donc

robuste pour montrer qu’une politique publique fonctionne indépendamment du contexte. C’est là la

grande nouveauté, alors que l’économétrie classique effectue des analyses « toutes choses égales par

ailleurs », l’économie expérimentale appliquée aux politiques publiques raisonne « toutes choses inégales

par ailleurs », excepté les données générales qui qualifient la population et le contexte, telle que le pays et

les caractéristiques des populations cible du dispositif. Par exemple, les expérimentations de dispositifs

publics menées dans des « Pays en développement » par Esther Duflot (2010) – qui fondent le « succès »

de la méthode en France – s’effectuent dans un même pays au sein, par exemple, d’écoles différentes dont

certaines sont soumises au dispositif et pas d’autres. Les unes et les autres sont tirées au hasard pour

constituer les groupes tests et témoins. Peu importe les situations locales (institutionnelles,

sociodémographiques, présence d’ONG), la force de la méthode est justement de montrer l’efficacité d’un

dispositif indépendamment des éléments de contexte. La généralisation du dispositif est préconisée

justement compte tenu de ses effets positifs sur des populations tests et témoins tirées au hasard parmi les

bénéficiaires potentiels. Il est clair, en effet, qu’un dispositif qui ne fonctionnerait que dans un contexte

115

donné ne pourrait être généralisé. L’efficacité de la méthode est également de pouvoir être mise en œuvre

sur des échantillons de taille limitée contrairement à l’économétrie classique.

2. Pour une approche longitudinale constructiviste : l’exemple des effets de

l’expansion scolaire

La « nouvelle méthode » d’évaluation des politiques publiques n’est, par définition, absolument pas

explicative. De plus, l’hypothèse implicite est que la généralisation se déroulerait dans les conditions de

l’expérimentation sans évolution ni du contexte ni des normes et représentations sociales. Or, un nouveau

dispositif public généralisé peut faire évoluer ces éléments et annihiler alors en partie les effets supposés

du dispositif. Nous allons reprendre ici un exemple précis pour argumenter les limites des méthodes

économétriques ou expérimentales à la faveur d’une approche longitudinale associant qualitatif et

quantitatif. L’exemple retenu concerne l’expansion scolaire facilitée par les pouvoirs publics, expansion

qui a pu modifier la norme de correspondance entre diplômes et emplois, gommant une partie des

bénéfices supposés de l’augmentation du nombre de jeunes accédants à un plus haut niveau d’études. En

matière de dispositif public, on peut invoquer ici les programmes mis en œuvre dans les années 90,

« Université 2000 » et U3M, qui, en créant des filières et surtout des établissements de proximité ont

favorisé l’expansion scolaire. Ces dispositifs publics étaient destinés à augmenter le niveau d’éducation

afin de favoriser une qualification plus importante des individus sur le marché du travail, facteurs

supposés déterminants pour demeurer compétitif sur le plan international en générant de la croissance.

Cette hypothèse et les politiques publiques qu’elle a générées sont directement inspirées des attendus du

traité de Lisbonne mettant en avant l’émergence aussi nécessaire que supposée inéluctable de

« l’économie de la connaissance ». Ainsi, en France, le taux de sortants possédant un diplôme de

l’enseignement supérieur a-t-il augmenté de cinq points de 1992 à 1998, passant de 33 % à 38 % en 6 ans.

Toutefois, au cours de cette période où la conjoncture économique s’est améliorée et l’expansion scolaire

a été particulièrement forte, Giret et Lemistre (2005) suggèrent que ses effets positifs supposés ex ante ont

été en partie gommés par un changement de norme sociale. L’argumentation repose sur une comparaison

entre deux types de déclassement. Le premier « normatif » suppose une correspondance entre niveau

d’études et qualification de l’emploi identique à chaque période et conforme à une représentation

« institutionnelle ». Pour cette dernière, par exemple, un diplômé de BTS doit occuper un emploi de

technicien et un détenteur de Master un emploi de cadre, ceci pour tous les niveaux de diplômes, s’il

occupe un emploi de qualification inférieur il est déclassé au sens « normatif » (Affichard 1981). En

comparant les générations sorties du système éducatif en 1992 et 1998 le pourcentage de jeunes déclassés

selon cette norme est passé de 50,4 % à 53 %. Peut-on en déduire que les politiques publiques mises en

œuvre ont échoué ? À court terme, manifestement en partie, mais l’objectif est plutôt à long terme où la

structure des qualifications est susceptible d’évoluer pour permettre notamment aux déclassés de se

reclasser. Cette dernière conjecture peut être contestée en regard des délais d’ajustement des systèmes

productifs (Lemistre 2010) qui peuvent générer des « générations sacrifiées » (Chauvel 2006). Ces

contestations en regard de données du passé et des prévisions en termes de qualification ne pourront

néanmoins être retenues que si des tests empiriques ultérieurs les valident. Plus qu’une réfutation, les

arguments contradictoires sont donc surtout une invitation au suivi longitudinal.

Dans ce domaine, il existe des indices d’une certaine déperdition des bénéfices de l’expansion scolaire à

long terme. En effet, le rendement moyen d’une année d’études supplémentaire n’a cessé de décroître de

1970 à 1993 (Baudelot et Glaude 1989 ; puis Goux et Maurin 1994). Or, à nouveau et logiquement vu

l’évolution du déclassement, ce rendement est décroissant entre les deux Générations 92 et 98 (Lemistre

2010). On peut objecter que les effets positifs l’auraient nettement emporté sur les effets négatifs (Maurin

2007) et que la valeur du diplôme est peu affectée par l’expansion scolaire. Ce serait, au contraire le

renforcement du rôle du diplôme, indéniable lui, qui conduirait les générations sorties récemment du

système éducatif à une « peur du déclassement » en grande partie injustifiée (Maurin 2009). Fort de cet

argument et d’une certaine croyance, relayée par les institutions européennes, en la « croissance

endogène », soit à l’existence d’un lien entre croissance des niveaux d’éducation et croissance du PIB,

certains sont tentés de rejeter immédiatement l’hypothèse d’une inefficacité, même relative, de dispositifs

tels que U3M et Université 2000.

6

6

7

7

8

8

9

9

10

10

11

11

1

/

11

100%