06. IFIPS- Archi et programmes parallèles

Accélération

• Accélération (p processeurs) =

• Pour un problème de taille fixe (entrées fixées),

performance = 1/temps

•

Accélération à problème fixé

Performance (p processeurs)

Performance (1 processeur)

IFIPS-2

Calcul parallèle D. Etiemble 2

•

Accélération à problème fixé

– (p processeurs) = Temps (1 processeur)

Temps (p processeurs)

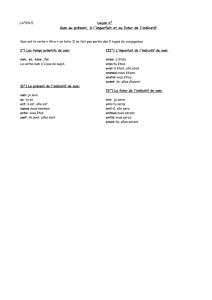

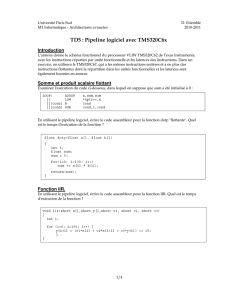

Amdahl et Gustafson

( )

S P

Acc n

P

S

+

=

+

S: Temps séquentiel

P: Temps parallélisable

Amdahl Gustafson

P = a*n

Application extensibleApplication fixe

IFIPS-2

Calcul parallèle D. Etiemble 3

( ) 1/

n s

Acc n f

→∞

→

( )

Acc n

P

S

n

=

+

.

( )

S a P

Acc n

S P

+

=+

P = a*n

Ts = S+P = fs + (1-fs)

Tp = S+P/n = fs +(1-fs)/n Ts = S+P = fs + n (1-fs)

Tp = S+P/n = fs +(1-fs)

( ) 1

s

s

f

E n f

n

= + −

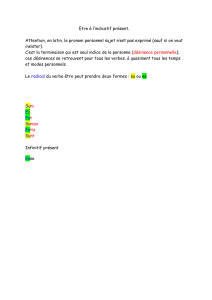

Classification de Flynn

• Flot d’instructions x Flot de données

– Single Instruction Single Data (SISD)

– Single Instruction Multiple Data (SIMD)

– Multiple Instruction Single Data

– Multiple Instruction Multiple Data (MIMD)

•

“Tout est MIMD” !

IFIPS-2

Calcul parallèle D. Etiemble 4

•

“Tout est MIMD” !

SIMD

• Modèle d’exécution

– CM2

– Maspar

• Modèle obsolète pour machines parallèles

Contrôleur

Réseau d’interconnexion

PE PE PEML ML ML

Lancement instructions

IFIPS-2

Calcul parallèle D. Etiemble 5

– Processeurs spécifiques différents des CPU standards

– Lancement des instructions incompatible avec les fréquences

d’horloge des microprocesseurs modernes

– Synchronisation après chaque instruction : les instructions

conditionnelles sont synchronisées

• SPMD

• Extensions SIMD dans les microprocesseurs

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

1

/

30

100%