Apprentissage automatique

Pr A. MAJDA

MASTER SIR FSTF

2014 -2015

1

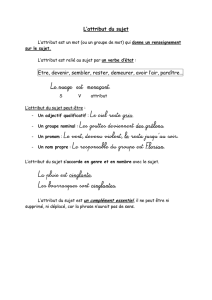

Les Arbres de Décision

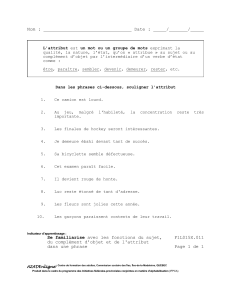

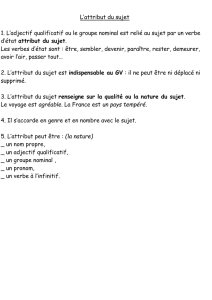

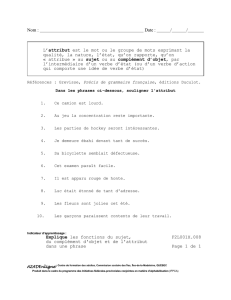

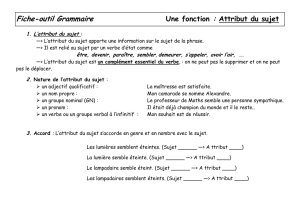

Arbre de décision

2

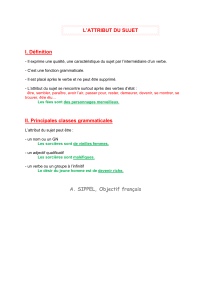

Exemple 1 : Aide au diagnostic

Arbres de décision

3

Ce sont des structures de données utilisée pour la classification

Méthode récursive basée sur diviser-pour-régner pour créer

des sous-groupes purs appartenant à une même classe

Objectif : Construction du plus petit arbre de décision

possible

Nœud = Test sur un attribut (douleur, fièvre, toux)

Une branche pour chaque valeur (abdomen, gorge,…) d’un attribut

Les feuilles désignent la classe de l’objet à classer (appendicite, mal de

gorge,…). Il existe au moins deux classes

Problèmes: Choix de l’attribut

Arbre de décision

4

Exemple 1 :

Un ensemble de tests :

Origine de la douleur ?

Est-ce qu’il y a de la fièvre ?

Est-ce que le patient tousse?

….

Si aucune erreur n’est commise dans ces réponses, l’identification est

réalisée.

Le principe de cette règle de décision est d’organiser l’ensemble des

tests possibles comme un arbre

Une feuille de l’arbre désigne une des C classes , mais une classe peut

correspondre à plusieurs feuilles

Problème : comment réaliser l’apprentissage de telles structures de

décision à partir d’exemples ?

5

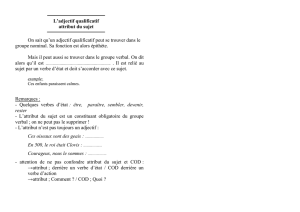

Exemple 2 : Vais-je sortir le chien ou non ?

Les attributs suivants :

Quel temps fait –il? A nominal (pluvieux, ensoleillé, couvert)

Quelle est la température extérieure? A numérique

Est-ce que le jardin est ouvert ? A binaire

Selon mon expérience (Expert) si le temps est pluvieux je reste

chez moi quelque soit les valeurs des autres attributs

l’expérience m’a prouvé que si le jardin est fermé la

promenade devient désagréable.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

1

/

32

100%