Acquisition et évaluation sur corpus de propriétés de sous

Revue. Volume X – n° x/année, pages 1 à X

Acquisition et évaluation sur corpus

de propriétés de sous-catégorisation

syntaxique

Didier Bourigault*, Cécile Frérot*†

* Equipe de Recherche en Syntaxe et Sémantique

CNRS et Université Toulouse Le Mirail

5, allées Antonio Machado

F-31058 Toulouse cedex 1

{prenom.nom}@univ-tlse2.fr

† Synomia

3, rue Nationale

F-92100, Boulogne Billancourt

gaelle.recou[email protected]

RÉSUMÉ. Syntex est un analyseur syntaxique de corpus. Pour résoudre les ambiguïtés de

rattachement prépositionnel, il exploite un lexique de probabilités de sous-catégorisation

(que telle unité lexicale - verbe, nom ou adjectif - se construise avec telle préposition), qui a

été construit automatiquement à partir d’un corpus de 200 millions de mots. Pour évaluer ce

lexique, nous utilisons 4 corpus de test de genres variés. Nous testons plusieurs stratégies de

désambiguïsation, et montrons qu’une stratégie mixte, utilisant à la fois des probabilités de

sous-catégorisation spécifiques acquises à partir du corpus en cours de traitement et les

probabilités de sous-catégorisation génériques acquises à partir du corpus de 200 millions

de mots, donne les meilleurs résultats : les performances en précision de l’analyseur sur la

tâche de désambiguïsation des rattachements prépositionnels varient selon les corpus de

79.4 % à 87.2 %.

ABSTRACT. We carry out an experiment aimed at using subcategorization information into a

syntactic parser for PP attachment disambiguation. The subcategorization lexicon consists of

probabilities between a word (verb, noun, adjective) and a preposition. The lexicon is

acquired automatically from a 200 million word corpus, that is partially tagged and parsed.

In order to assess the lexicon, we use 4 different corpora in terms of genre and domain. We

assess various methods for PP attachment disambiguation : an exogenous method relies on

the sub-categorization lexicon whereas an endogenous method relies on the corpus specific

ressource only and an hybrid method makes use of both. The hybrid method proves to be the

best and the results vary from 79.4 % to 87. %

MOTS-CLÉS : analyse syntaxique automatique, ambiguïté de rattachement prépositionnel,

probabilité de sous-catégorisation, évaluation.

KEYWORDS:. Parsing, pp-attachment, sub-categorization, evaluation

2 Revue. Volume X – n° x/année

1. Introduction

Dans leur grande majorité, les nombreux travaux sur le développement de

parseurs statistiques concernent la langue anglaise et tendent à utiliser comme corpus

d’apprentissage et comme corpus de test des portions de la section du Wall Street

Journal du Penn TreeBank (Charniak, 1997). Outre qu’elle permet d’éviter la tâche

laborieuse de construction de corpus annotés, cette démarche présente l’avantage de

pouvoir comparer les parseurs entre eux (Ratnaparkhi et al., 1994 ; Pantel et Lin,

1998). Cette exploitation mono-corpus pose cependant la question de la stabilité des

performances en fonction du type de corpus, comme le mentionnent Kilgarriff et

Grefenstette (2003 :341) : « there is little work on assessing how well one language

model fares when applied to a text type that is different from that of the training

corpus ». Par ailleurs, il est maintenant bien connu que, dans tout corpus, certaines

unités lexicales ont des propriétés syntaxiques de sous-catégorisation spécifiques,

qui peuvent donc varier d’un domaine à l’autre (Roland, Jurafsky, 1998 ; Basili et

al., 1999). Or peu de travaux relatent des expériences sur la variation des

performances de l’analyseur en fonction du type de corpus à traiter, sur le problème

de la possible variation inter-corpus et sur celui de la nécessaire adaptation des

règles ou ressources de l’analyseur à un corpus donné. On peut néanmoins citer

(Sekine, 1997 ; Gildea, 2001 ; Slocum, 1986).

Dans cet article, nous nous intéressons à l’acquisition et à l’évaluation sur corpus

de données de sous-catégorisation syntaxique. Cette étude est menée dans le cadre

du développement de l’analyseur syntaxique de corpus Syntex. Dans la section 2,

nous présentons de façon succincte les principes qui sont à la base du développement

de l’analyseur, et nous décrivons comment l’analyseur exploite des données de sous-

catégorisation syntaxique se présentant sous la forme de probabilités de sous-

catégorisation (que telle unité lexicale - verbe, nom ou adjectif – se construise avec

telle préposition) pour résoudre les ambiguïtés de rattachement prépositionnel. Dans

la section 3, nous décrivons comment ces données sont acquises automatiquement à

partir d’un corpus de 200 millions de mots, étiqueté et partiellement analysé

syntaxiquement. La section 4 est consacrée à l’évaluation de ces données sur 4

corpus de test de genres variés, pour lesquels nous avons annoté à la main plusieurs

centaines de cas de rattachements prépositionnels ambigus. Dans la section 5, nous

présentons plusieurs stratégies de désambiguïsation : une stratégie de base, une

stratégie endogène qui exploite des propriétés de sous-catégorisation spécifiques,

acquises à partir du corpus en cours de traitement, une stratégie exogène qui exploite

des propriétés de sous-catégorisation génériques, acquises à partir du corpus de 200

millions de mots, et enfin une stratégie mixte qui utilise les deux types de ressources.

Dans la section 6, nous dressons un bilan de cette expérience.

Acquisition et évaluation sur corpus de propriétés de sous-catégorisation syntaxique 3

2. Syntex, un analyseur syntaxique de corpus

2.1. De Lexter à Syntex

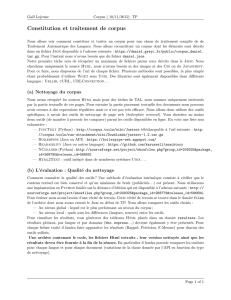

L’analyseur Syntex a été développé à l’origine (Bourigaut et Fabre, 2000) pour

remplacer le logiciel Lexter, un analyseur syntaxique robuste dédié au repérage des

syntagmes nominaux dans les corpus spécialisés et utilisé dans des applications de

construction de terminologies ou d’ontologies spécialisées (Bourigault, 1994). Les

diverses expérimentations réalisées avec Lexter avaient mis en évidence la nécessité

d’étendre la couverture du logiciel à l’extraction des syntagmes verbaux. A partir de

ce constat, nous avons décidé d’entreprendre la réalisation d’un nouvel analyseur,

avec l’objectif d’en faire un outil opérationnel d’analyse syntaxique de corpus,

utilisable dans différents contextes applicatifs, dont la construction de ressources

lexicales spécialisées pour des systèmes de traitement de l’information (Bourigault et

al., 2004). Syntex traite des corpus de phrases réelles, de taille importante (de

quelques centaines de milliers à plusieurs millions de mots). Ceci impose des

contraintes d’efficacité (temps de traitement), de robustesse (tolérance aux

malformations syntaxiques et aux mots ou structures inconnus, possibilité de rendre

des analyses partielles et incomplètes) et d’adaptabilité (prise en compte de certaines

propriétés syntaxiques particulières des mots dans des corpus spécialisés). Les

principes de base sont les suivants : Syntex analyse des corpus préalablement

étiquetés (section 2.2) ; c’est un analyseur en dépendance, organisé sous la forme

d’un enchaînement de modules de reconnaissance de relations syntaxiques (section

2.3) ; il exploite de façon combinée des procédures d’apprentissage endogène et des

ressources lexico-syntaxiques de sous-catégorisation (section 2.4).

2.2. Etiquetage préalable

Syntex analyse des corpus préalablement étiquetés. L’organisation du partage des

tâches entre étiquetage morphosyntaxique (attribution d’une étiquette

morphosyntaxique aux mots de la phrase) et analyse syntaxique (identification de

constituants syntaxiques ou de relations de dépendance syntaxique) est un problème

délicat (Voutilaïnen, 1998 ; Prins et Van Noord, 2003). Disposer des étiquettes

morphosyntaxiques des mots pour identifier les relations syntaxiques est évidemment

très pratique. Mais, dans certains cas, la levée d’ambiguïtés catégorielles exige une

analyse syntaxique partielle du contexte large, et la présence d’étiquettes erronées à

l’entrée de l’analyseur rend a priori impossible une analyse correcte. Essentiellement

pour des raisons de disponibilité des forces, nous avons choisi de concentrer nos

efforts sur l’analyse syntaxique proprement dite et, comme cela était le cas avec

Lexter, de confier la tâche préalable d’étiquetage à un outil extérieur. Syntex prend

en entrée les résultats du Treetagger1, développé à l’Université de Stuttgart.

1 http://www.ims.uni-stuttgart.de

4 Revue. Volume X – n° x/année

Treetagger est un étiqueteur efficace et robuste. Il présente l’intérêt d’être ouvert, en

ce sens qu’il est possible de faire en amont, à sa place, une partie du travail de

segmentation en mots et d’étiquetage. Nous avons développé un ensemble de

procédures de reconnaissance de mots et d’unités syntaxiques complexes qui

viennent poser sur le corpus des étiquettes sur lesquelles le Treetagger s’appuie pour

étiqueter les mots environnants. Nous avons aussi introduit dans la chaîne de

traitement la possibilité pour l’utilisateur d’intégrer un fichier de règles de

segmentation et de pré-étiquetage, données sous la forme d’expressions régulières,

spécifiques au corpus à analyser. Cette fonctionnalité est essentielle quand il s’agit

de traiter des corpus comportant des mots inconnus ou des structures « bizarres »

(codes de produits, nomenclature d’éléments chimiques, etc.). La frontière entre

étiquetage et analyse n’est pas étanche. Dans certains contextes syntaxiques,

l’analyseur effectue des retours en arrière sur l’étiquetage en venant modifier des

étiquettes attribuées par le Treetagger, par exemple pour la forme que (Jacques,

2005).

2.3. Architecture modulaire

Syntex ne s’appuie sur aucune grammaire formelle. C’est un analyseur

incrémental organisé en « couches » (Constant, 1991 ; Abney, 1996 ; Aït-Moktar et

al., 2002). Nous décomposons le problème de l’analyse syntaxique d’une phrase en

sous-problèmes élémentaires du type : soit m un mot de catégorie C dans la phrase

étiquetée et partiellement analysée S, quel est le recteur syntaxique de m dans S ?

L’analyse s’effectue par un enchaînement en cascade d’une suite de modules qui

prennent en charge chacun une relation syntaxique. Chaque module prend en entrée

les sorties du module précédent. Cette organisation séquentielle des traitements

impose de choisir un ordre dans l’analyse. On est face à un dilemme du type de celui

du partage entre étiquetage et analyse. Par exemple, faut-il reconnaître les relations

Sujet avant de chercher à identifier les relations de coordination, ou faire l’inverse,

ou répartir le traitement à deux moments de la chaîne ? Le choix de l’ordre est un

choix difficile qui a un impact fort sur la programmation des différents modules. A

l’intérieur de la chaîne d’analyse, les retours en arrière sont possibles. Il peut arriver

qu’un module vienne détruire et remplacer une relation syntaxique posée par un

module antérieur. Les modules sont constitués d’un ensemble d’heuristiques de

parcours de la chaîne étiquetée et partiellement analysée, qui partent d’un régi (resp.

recteur) potentiel à la recherche de son recteur (resp. régi). Ces heuristiques

exploitent deux contraintes classiques : les liens de dépendance ne se croisent pas,

un régi n’a qu’un seul recteur. Les modules sont développés « à la main » par des

linguistes informaticiens (dans le langage Perl), selon une méthode empirique qui

met en œuvre le recours à la connaissance grammaticale et la réalisation de tests

nombreux sur des corpus diversifiés.

Acquisition et évaluation sur corpus de propriétés de sous-catégorisation syntaxique 5

2.4. Ressources lexicales limitées

L’analyseur Syntex est peu lexicalisé. Nous avons fait le choix initial de la table

rase. Contrairement aux approches qui choisissent de développer au préalable un

lexique syntaxique très riche recensant les propriétés syntaxiques des mots de la

langue2, nous avons choisi de commencer sans aucune information de ce type. Cette

approche est possible à partir du moment où l’on a choisi de s’appuyer sur les

résultats d’un étiqueteur (on bénéficie indirectement des ressources lexicales

exploitées par celui-ci). Des informations lexicales sont intégrées dans l’analyseur au

fur et à mesure des besoins : liste de locutions prépositionnelles, liste des verbes

transitifs, liste des verbes se construisant avec des compléments en que, en de, etc.

Pour résoudre les ambiguïtés de rattachement prépositionnel, l’analyseur exploite

des informations de sous-catégorisation associées aux couples (mot, préposition).

Depuis l’origine de nos travaux sur l’analyse syntaxique, ces informations sont

acquises de façon endogène sur le corpus en cours de traitement (Bourigault, 1993).

Les expériences menées sur de nombreux corpus spécialisés ont montré que ces

corpus renferment des spécificités lexicales, en particulier que certains mots,

fréquents dans le corpus, manifestent des comportements syntaxiques spécifiques et

imprédictibles. C’est pourquoi, nous avons porté nos efforts depuis une dizaine

d’années sur le développement de procédures d’apprentissage endogène sur corpus

qui permettent à l’analyseur d’acquérir lui-même, par analyse du corpus à traiter, des

informations de sous-catégorisation spécifiques à ce corpus. Devant les limites

inhérentes à l’exploitation exclusive d’informations de sous-catégorisation

endogènes, nous travaillons à l’élaboration de ressources générales, susceptibles

d’être exploitées pour tout corpus (Frérot et al., 2003). Nous avons expérimenté

l’utilisation d’un lexique de sous-catégorisation construit à partir des tables du

Lexique Grammaire (Frérot, 2005). Dans la section suivante, nous présentons une

expérience d’acquisition d’un lexique de probabilités de sous-catégorisation à partir

d’un corpus de 200 millions de mots, utilisé par le module de Syntex en charge du

rattachement des prépositions.

Le rattachement des prépositions à leur recteur s’effectue en deux passes sur le

corpus : (1) recherche des candidats recteurs, (2) choix d’un recteur. Un premier

module (rechercher-candidats) traite l’ensemble des phrases du corpus, et

recherche, pour chaque préposition, le ou les mots susceptibles de régir cette

préposition. Ce module est constitué de règles qui reconnaissent un certain nombre

de configurations linéaires de mots et de catégories morphosyntaxiques à gauche de

la préposition, au sein desquelles sont identifiés des mots susceptibles de régir la

préposition. Ces règles s’appuient sur les relations de dépendance placées par les

modules antérieurs, et sont capables d’aller chercher des candidats recteurs dans des

configurations relativement complexes, incluant par exemple des structures

2 Le projet LexSynt, animé par S. Kahane, et auquel nous participons, vise à rassembler et à

coordonner les efforts des différentes équipes qui travaillent sur le français.

www.lexsynt.inria.fr

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

1

/

14

100%