Télécharger en pdf

NOSQL

Programme formation

Date d'impression : 24/05/2017

1

BEST NoSQL : découverte des solutions et architecture de la

donnée

Séminaire

NOSQL

Code :

SQLNO

Durée :

2 jours (14 heures)

Exposés :

60%

Cas pratiques :

20%

Échanges d'expérience :

20%

Sessions à venir :

19 - 20 oct. 2017

Casablanca / 9 500 DHS HT

19 - 20 oct. 2017

Paris / 2 010 € HT

Tarif & dates intra :

Sur demande

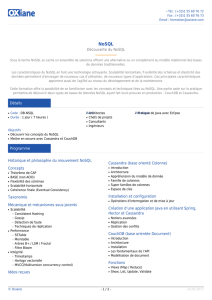

DESCRIPTION

Les avancées technologiques de ces dernières années permettent

d’accompagner l’augmentation des volumes de données structurées et non

structurées. Les limites techniques auxquelles les systèmes relationnels

étaient une réponse ne sont plus d’actualité : volume de données en ligne

(Transactional Processing), disponibilité des systèmes, temps réel,

démocratisation du cloud, etc. Par ailleurs, la donnée qui était hier une

commodité opérationnelle est devenue un enjeu business pour de nouvelles

opportunités : exploration de la donnée, data science, etc. Nous vous

proposons de découvrir l’écosystème des nouvelles architectures de la

donnée bâties autour des solutions dites NoSQL afin d’en appréhender leurs

caractéristiques propres et cas d’usage associés : Couchbase, MongoDB,

ElasticSearch, Cassandra, etc.

OBJECTIFS PÉDAGOGIQUES

Appréhender les notions relatives aux systèmes distribués et à la donnée

(cohérence, théorème de CAP, etc.)

Découvrir l’écosystème NoSQL

Parcourir les caractéristiques des différentes solutions NoSQL (MongoDB,

Cassandra, Couchbase, ElasticSearch, etc.)

Identifier les différents cas d’usage de la donnée

Observer les plateformes de streaming de la donnée (Storm, Spark, etc.) et

l’écosystème Hadoop

PUBLIC CIBLE

DSI

Directeur de projet

Chef de projet

Architecte (Logiciel/Entreprise/Technique)

Développeur

PRÉ-REQUIS

• Connaissance des architectures applicatives traditionnelles avec SGBDR.

MÉTHODE PÉDAGOGIQUE

Formation avec démarche pratique, échanges sur les contextes des

participants et retours d’expérience pratique du formateur, complétés de

démonstrations.

PROFILS DES INTERVENANTS

Toutes nos formations sont animées par des consultants-formateurs

expérimentés et reconnus par leurs pairs.

MODALITÉS D’ÉVALUATION

L’évaluation des acquis se fait tout au long de la session au travers des

Programme formation "NOSQL"

Date d'impression : 24/05/2017

2

ateliers et des mises en pratique. Une évaluation à chaud est réalisée

systématiquement en fin de session.

POUR ALLER PLUS LOIN :

• Toutes nos formations NoSQL

• Formation officielle "Programmer avec Apache Spark de Databricks"

• Formation officielle "Déployer et gérer un cluster Couchbase" (Couchbase

NoSQL Server Administration) (CS300)

• Formation officielle Couchbase "Requêtes, modélisation de données,

optimisation et migration via N1QL" (Querying, Modeling, Tuning, and

Migrating Data using N1QL) (CD210)

• Formation "Gérer efficacement ses logs avec la stack ELK : ElasticSearch –

Logstash – Kibana" (ELK01)

• Formation "Concevoir un moteur de recherche avec Elasticsearch :

Dimensionnement - Administration - Recherche" (ELAS2)

Programme formation "NOSQL"

Date d'impression : 24/05/2017

3

Programme pédagogique détaillé par journée

Jour 1

HISTORIQUE DE LA BASE DE DONNÉES JUSQU'À L’APPARITION DU NOSQL

• Forme normale des bases de données relationnelles

• Baisse des coûts hardware

• Notion de "Transaction"

• Systèmes distribués et disponibilité prennent le dessus sur la cohérence (CAP)

• Introduction au NoSQL : "Not only SQL"

• Définition "Réplication"

• Définition "Sharding"

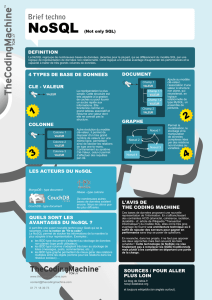

LES FAMILLES DE BASE DE DONNÉES NOSQL

• Key-value

• Document

• Graph

• Colonne

LE MONDE HADOOP

FOCUS SUR L’OFFRE COLONNE AVEC CASSANDRA

• Présentation générale, architecture et cas d’utilisation

• Séries temporelles, objets connectés

• Frameworks de traitement distribué

• Cas pratique d’application : "Cassandra et Spark streaming"

Jour 2

FOCUS SUR L’OFFRE CLÉ-VALEUR ET DOCUMENT AVEC COUCHBASE ET MONGODB

• Présentation générale, architecture et cas d’utilisation

• Cas pratique d’application : "Couchbase et MongoDB"

SEARCH - FÉDÉRATION DE DONNÉES

• Présentation de l’offre Elasticsearch

• Cas pratique d’application : "Elasticsearch"

BILAN ET PERSPECTIVES

• Feedback des participants

• Recommandations et élaboration du plan d’action individuel

• Conclusion

• Questions / Réponses

Programme formation "NOSQL"

Date d'impression : 24/05/2017

4

EXCLU Programmer avec Apache Spark de Databricks

Formation officielle Databricks « Apache® Spark™ Programming SPARK 105 »

Stage pratique

NOSQL

Code :

SP105

Durée :

3 jours (21 heures)

Exposés :

40%

Cas pratiques :

50%

Échanges d'expérience :

10%

Sessions à venir :

2 - 4 oct. 2017

Paris / 2 300 € HT

Tarif & dates intra :

Sur demande

DESCRIPTION

Cette formation de 3 jours propose un panorama pratique de la solution

Apache Spark en alternant des présentations et des exercices pratiques. Elle

couvre les APIs de base de Spark, les fondamentaux et les mécanismes du

framework, mais aussi les outils plus haut-niveau dont SQL, ainsi que ses

capacités de traitement en streaming et l’API de machine learning.

Chaque sujet couvert comprend une partie d’exposé couplée à une mise en

pratique de Spark au travers d’un environnement type notebook web. Inspiré

d’outils tels IPython/Jupyter, les notebooks permettent aux participants de

développer des jobs, des requêtes d’analyse et des représentations visuelles

s’appuyant sur leur propre cluster Spark, le tout depuis leur navigateur web.

A l’issue du cours, les notebooks peuvent être conservés et être réutilisés

dans le service cloud gratuit Databricks Community Edition, pour lequel la

compatibilité est garantie. Il est également possible d’exporter le notebook

sous forme de code source pour exécution sur n’importe quel environnement

Spark.

OBJECTIFS PÉDAGOGIQUES

Décrire les fondamentaux de Spark

Exploiter les APIs de base de Spark pour manipuler des données

Concevoir et implémenter des cas d’usage typiques de Spark

Construire des pipelines de données et requêter de larges jeux de données

grâce à Spark SQL et aux DataFrames

Analyser les jobs Sparks à l’aide des interfaces d’administration et des logs au

sein des environnements Databricks

Créer des jobs de type Structured Streaming et Machine Learning

Découvrir les bases du fonctionnement interne de Spark

PUBLIC CIBLE

Data engineers et data analysts ayant l’expérience des traitements Big Data,

qui souhaitent apprendre à utiliser Apache Spark pour effectuer leurs

traitements Big Data, construire des jobs Spark à destination de la production

et comprendre mais aussi déboguer des applications Spark.

PRÉ-REQUIS

• Une première expérience avec Apache Spark est conseillée

• Avoir utilisé les Spark DataFrames dans des cas simples est souhaitable

• Une expérience de programmation en langage objet ou fonctionnel est

nécessaire

MÉTHODE PÉDAGOGIQUE

Formation avec apports théoriques, échanges sur les contextes des

participants et retours d’expérience du formateur, complétés de travaux

pratiques et de mises en situation.

Programme formation "NOSQL"

Date d'impression : 24/05/2017

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%