Parallélisme ou multitâche?

Parallélisme ou multitâche? i

Parallélisme ou multitâche?

Parallélisme ou multitâche? ii

INDEXATION DU DOCUMENT

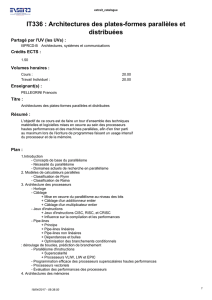

TITRE :

Parallélisme ou multitâche?

ACTION NOM DATE SIGNATURE

RÉDIGÉ PAR 25 novembre 2015

SUIVI DU DOCUMENT

INDICE DATE MODIFICATIONS NOM

Parallélisme ou multitâche? iii

Table des matières

1 Dans l’ordinateur... 1

2 Multitâche 1

2.1 Multitâchecoopératif................................................. 2

2.2 Multitâchepréemptif ................................................. 2

2.3 Préemptifoucoopératif? ............................................... 2

3 Parallélisme 2

3.1 Pipelines........................................................ 3

3.2 Multi-processeurs................................................... 4

3.3 Multi-cœurs...................................................... 4

3.4 Casparticuliers .................................................... 4

3.4.1 Coprocesseurs ................................................ 4

3.4.2 Systèmesàplusieursmachines........................................ 4

3.4.2.1 BOINC............................................... 4

3.4.2.2 SETI@home............................................ 5

Parallélisme ou multitâche? 1/5

Attention

Ce texte est extrait d’un cours de L3 MIASHS. Vous pouvez en retrouver l’intégralité à cette adresse :

http://grappa.univ-lille3.fr/~gonzalez/enseignement/2015-2016/l3miashs/

calendrier.php?x=CM-5.php.

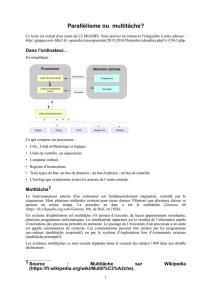

1 Dans l’ordinateur...

En simplifiant :

Architecture simplifiée d’un ordinateur

Ce qui compose un processeur :

— UAL, Unité arithmétique et logique.

— Unité de contrôle, ou séquenceur.

— Compteur ordinal.

— Registre d’instructions.

— Trois types de bus:

— un bus de données ;

— un bus d’adresse ;

— un bus de contrôle.

— L’horloge qui synchronise toutes les actions de l’unité centrale.

2 Multitâche 1

Le fonctionnement interne d’un ordinateur est fondamentalement séquentiel, contrôlé par le séquenceur. Mais plusieurs méthodes

existent pour (nous donner l’illusion) que plusieurs choses se passent en même temps. La première en date a été le multitâche

(Gamma 60, de Bull, en 1958).

Un système d’exploitation est multitâche s’il permet d’exécuter, de façon apparemment simultanée, plusieurs programmes in-

formatiques. La simultanéité apparente est le résultat de l’alternance rapide d’exécutions des processus présents en mémoire. Le

passage de l’exécution d’un processus à un autre est appelé commutation de contexte. Ces commutations peuvent être initiées

par les programmes eux-mêmes (multitâche coopératif) ou par le système d’exploitation lors d’événements externes (multitâche

préemptif).

Les systèmes multitâches se sont ensuite répandus dans le courant des années 1960 dans une double déclinaison :

1. Source : Multitâche sur Wikipedia.

6

6

7

7

8

8

9

9

1

/

9

100%