PDF (631,7 Kio) - Zeste de Savoir

LES SYSTÈMES D’EXPLOITATION

Mewtow, Ezenku

02 mai 2016

Table des matières

1 Introduction 5

2 Mécanismes d’abstraction des périphériques 7

2.1 Pourquoi utiliser un OS ? .............................. 7

2.1.1 Programmes systèmes et applicatifs ..................... 7

2.1.2 Appels système ............................... 9

2.2 Noyau d’un OS ................................... 10

2.2.1 Espace noyau et espace utilisateur ...................... 10

2.2.2 Principaux types de noyaux ......................... 11

3 Systèmes de chiers 17

3.1 Fichiers et répertoires ............................... 17

3.1.1 Formats de données ............................. 17

3.1.2 Répertoires ................................. 18

3.2 Gestion des fichiers par l’OS ............................ 18

3.2.1 Stockage ................................... 19

3.2.2 Utilisation .................................. 21

4 Allocation mémoire 23

4.1 Mono-programmation ............................... 23

4.1.1 Chargement d’un programme ........................ 24

4.1.2 Protection mémoire ............................. 24

4.2 Multi-programmation ............................... 25

4.2.1 Gestion des partitions libres ......................... 26

4.2.2 Choix de la partition ............................. 26

4.2.3 Protection mémoire ............................. 27

4.2.4 Relocation .................................. 28

4.2.5 Allocation mémoire ............................. 28

4.3 Mémoire virtuelle ................................. 29

4.3.1 Segmentation ................................ 30

4.3.2 Pagination .................................. 33

5 Processus et threads 41

5.1 Vie et mort des processus .............................. 41

5.1.1 Création de processus ............................ 41

5.1.2 Destruction de processus ........................... 41

5.2 Ordonnancement .................................. 42

5.2.1 États d’un processus ............................. 42

5.2.2 Sélection ................................... 44

5.2.3 Changements d’états ............................ 46

3

1 Introduction

Vous utilisez tous les jours un système d’exploitation sans forcément savoir ce qui se cache der-

rière. Vous avez certainement l’habitude de Windows, de Linux, de Mac OS, ou d’un autre système

d’exploitation moins courant. Ce cours va vous expliquer ce qu’est un système d’exploitation, à

quoi il sert, ce qu’il fait et comment il est fabriqué.

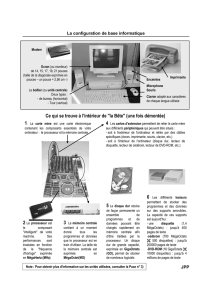

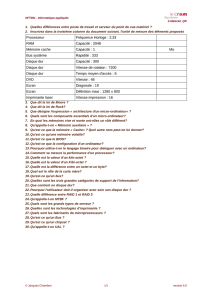

[[attention]] | Pré-requis : des connaissances minimales concernant le fonctionnement d’un or-

dinateur sont requises pour suivre ce cours. Vous devez savoir des choses comme ce qu’est la mé-

moire, le processeur, les entrées-sorties, etc. Les notions d’adresse, de registres, d’instructions

machine, et d’autres notions de cet acabit seront notamment utilisées dans ce cours.

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

1

/

55

100%