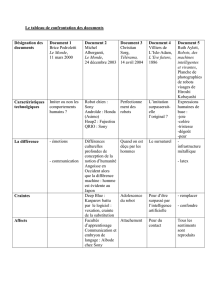

position de thèse - Université Paris

1

Ecole doctorale V Membre de l’Académie Louvain

Concepts et langage Ecole doctorale

Unité de Recherche de philosophie (ED1)

Rationalités Contemporaines près le FNRS

Cotutelle Internationale de Thèse

En vue de l’obtention du grade de Docteur en Philosophie

Intitulée

Problèmes éthiques posés par le remplacement de l'humain

par des robots.

Le cas des systèmes d'armes autonomes

.

Présentée par :

Marie-des-Neiges RUFFO de BONNEVAL de la FARE des COMTES de SINOPOLI de CALABRE

Sous la direction des:

Professeur Jean-Michel BESNIER, Université Paris-Sorbonne, Paris IV, France

et

Professeur Dominique LAMBERT, Université de Namur, Belgique

Membres du jury :

Professeur Jean-Michel BESNIER, Université Paris-Sorbonne, Paris IV, France

Professeur Nathalie COLETTE-BASECQZ, Université de Namur, Belgique

Professeur Jean-Gabriel GANASCIA, Université Pierre et Marie Curie, Paris VI France

Professeur Dominique LAMBERT, Université de Namur, Belgique

Professeur Alain RENAUT, Université Paris-Sorbonne, Paris IV, France

Professeur Renaud RONSSE, Université Catholique de Louvain, Belgique

Paris, Université Paris-Sorbonne, 19 janvier 2016.

2

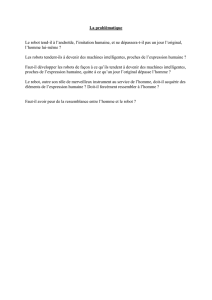

Fin 2014, les journaux s’alarment. D’après une étude de Roland Berger, 3 millions

d’emploi devraient disparaître en France d’ici 2025. En cause : l’usage des robots. La

progression écrasante de leur usage tend à rendre l’humain obsolète sur le marché du travail.

Tant la rapidité de l’évolution technologique que les craintes de ses effets sur l’humain

nécessitent que l’on s’interroge sur les rapports entre l’homme et la machine : sont-ils

adversaires, concurrents, complémentaires, subordonnés l’un à l’autre, indifféremment

substituables, ou nécessairement interdépendants? Face aux affirmations des prédicateurs de

la Singularité et du transhumanisme, l’homme et la machine semblent avant toute chose en

compétition : qui, de la créature ou de son créateur, dépassera l’autre ? Pour certains la

question n’est guère « qui » mais bien plutôt « quand ». Depuis Deep Blue battant Kasparov

aux échecs jusqu’à Watson remportant le Jéopardy, la machine joue sur le terrain des humains

et l’emporte. Est-ce à l’homme de s’incliner à son tour, non plus devant la force physique de

la machine mais devant ce qu’il considéra pendant des millénaires comme son exclusive

singularité, l’intelligence de celle-ci ?

Plutôt que d’envisager une reddition immédiate de la race humaine, nous pouvons

pointer la représentation du champ dans lequel s’inscrit la relation entre l’homme et la

machine afin de déterminer quel type de rapport serait préférable, puisque les robots font déjà

partie de notre monde. Le remplacement de l’humain par une machine pourrait s’avérer être

une bonne chose. Par exemple, si l’on considère la conquête spatiale, il est plus indiqué de

remplacer l’homme par le robot s’il s’agit d’explorer Mars sans oxygène.

En l’an 2000, le Congrès américain prenait la décision qu’un tiers des véhicules

terrestres de l’armée américaine devaient être inhabités en 2015. Alors que cette échéance est

là, quels types de robots existent-ils, quelles conséquences cette robotisation du champ de

bataille a-t-elle sur la manière de mener la guerre et plus encore de la gagner ? Est-ce pour un

mieux ? On espère beaucoup des capacités robotisées aujourd’hui, mais les robots sont-ils

déjà prêts à être autonomes ? Entre science-fiction et réalité, quel est l’état de l’art

aujourd’hui ? Dotés de capacités de visées supérieures par exemple, on attend des robots

qu’ils soient plus efficaces qu’un sniper. Privée d’affects, leur programmation devrait les

rendre plus respectueux des règles d’engagements et du droit de la guerre que ne le seraient

des humains soumis au stress.

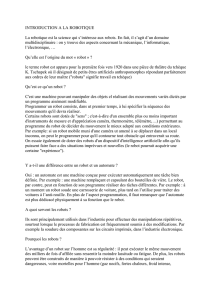

Les automates ou « robots » ont progressivement soulagé les hommes de la

pénibilité du travail ; aujourd’hui c’est du danger de mourir à la guerre en montant en

première ligne qu’ils le préservent, garantissant au soldat qu’il sera hors de portée de

l’ennemi. Dès lors que nous armons des robots, que l’on redoute que les machines ne soient

un jour capables de nous dépasser jusqu’à provoquer notre extinction, penser dès maintenant

comme Nick Bostrom à les programmer à être « amicales » envers nous semble en effet une

sage précaution. Dans cette optique, doter les machines de programmes leur permettant d’agir

moralement est un projet urgent.

Cette urgence procède pourtant d’une révolution. S’il est manifeste que les objets

techniques possèdent un degré d’habileté supérieur à l’humain sur bien des plans, c’est

aujourd’hui d’un nouveau champ de compétences que l’on tente de doter les systèmes

autonomes en adjoignant à leurs effecteurs des programmes d’aide à la décision. Il s’agit non

plus d’une habileté « physique » supérieure, mais bien de la question de la qualité d’une

action. Qualité qui dépend non seulement de la bonne réalisation, mais aussi de l’adéquation

de l’action choisie à la situation donnée. S’il est ici toujours question d’efficacité et de

sécurité selon le contexte, la science reine en ce qui concerne la qualité d’une action reste

l’éthique. C’est donc notamment sur l’aspect de l’efficacité et en particulier de l’efficacité

éthique, que se porte notre attention. Quelles conséquences le remplacement de l’humain par

un robot peut-il avoir sur la morale et son respect ? Le robot sera-t-il un soldat plus vertueux

que sa version biologique ? Ceci implique que nous justifiions la pertinence du lien entre

3

conduite éthique et action militaire, la simple existence de « l’éthique militaire » semblant à

certains n’être qu’un oxymore. Mais d’une machine ou d’un humain, lequel est effectivement

le plus moral, d’une part dans son comportement, d’autre part dans l’évaluation qui peut être

faite de sa présence sur le terrain ?

La question du jugement et de la prise de décision dans le cadre spécifique de la

guerre constitue un « cas limite » d’application de la toute-puissance des machines. Le choix

du militaire est aussi celui d’un agent pour qui la prise de décision implique parfois la vie ou

la mort. Pas simplement la mort qu’il donne ou la vie qu’il laisse, mais bien la vie ou la mort

de ses hommes qui dépendent de la pertinence de sa décision. Pour cet agent, la question du

choix, de la décision qu’il faut bien prendre au risque sinon de mourir certainement, et surtout

de la responsabilité qui en découle, n’est pas cruciale, elle est vitale. Nous opérerons un

rapprochement entre l’agissement de cet agent et le jugement prudent chez Aristote.

Au demeurant, si les systèmes d’armes létaux autonomes (ou SALA) sont capables

de décider de tirer, et par conséquent de remplacer le soldat sur le champ de bataille pour

certains, il reste à prouver que l’humain doive en être évacué. Il s’agit justement du jugement

moral, de l’application de l’éthique. Nous entendons par « éthique » la conduite d’une action

qui ne se limite pas au seul respect des règles de droits qui s’y appliquent, à savoir ici le droit

de la guerre international et les règles d’engagements qui diffèrent suivant les juridictions

nationales. Ce respect du droit, même scrupuleux, ne constitue pas une éthique mais un simple

légalisme. La position du Professeur Ronald Arkin, « roboéthicien » américain, soutient

pourtant que les robots militaires peuvent être plus éthiques que les humains en vertu de leur

application inconditionnelle du droit. Puisque l’éthique n’est pas le droit, comment un

homme, ici, le soldat, et particulièrement l’officier, peut-il prendre des décisions,

éventuellement différemment d’une machine, si tant est qu’elle en soit capable ?

En guise de « champ clos » où nous arbitrerons s’il existe une différence entre

décision humaine ou robotique, nous avons opté pour le champ d’honneur, terme exact à la

fois moral et guerrier puisque les deux doivent être associés, et comme champions en lice les

officiers d’une part contre les SALA. L’enjeu du duel concernait leur droit à décider et à agir,

mais toujours moralement. Ayant déterminé un contexte, un objet technologique et un type

d’homme dans l’arène, nous avons pu analyser les problèmes éthiques posés par le

remplacement de l’humain par des robots. En un mot comme en cent, peut-il être moral de

remplacer l’humain par des robots, particulièrement à la guerre ?

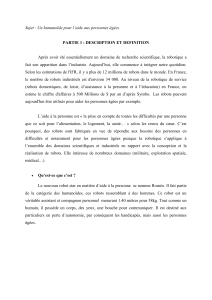

Une telle joute ne pouvait se faire en une seule manche, la thématique du

remplacement de l’humain par des robots, même plus particulièrement en contexte militaire,

ne saurait être envisagée dans tous ses aspects moraux sans croiser différents angles d’attaque.

Cette diversité s’avérait nécessaire car la dimension saisissante des « robots tueurs », comme

les journalistes les présentent, si elle n’était traitée engendrerait une frustration

compréhensible au lecteur qui chercherait une réflexion d’éthique appliquée. Tandis qu’à

celui qui souhaiterait une réflexion méta-éthique sur les robots moraux, la dimension

appliquée ne suffirait guère. C’est pourquoi d’une part il nous fallait établir un état des lieux

de la robotique militaire récente et préciser les difficultés langagières et conceptuelles

qu’induisent ces technologies. D’autre part, l’aspect moral et éthique de ces robots présuppose

une réflexion ontologique sur les qualités requises pour bénéficier d’un statut moral et pour

être reconnu tel un agent moral. Pour le dire autrement, nous avons déployé notre

problématique en nous attachant aux liens existants entre robotique et éthique. La première

étape visait à répondre à la question si « le robot pouvait-il être moral ? », c'est-à-dire dans un

premier temps s’il pouvait être un agent moral. Une fois les capacités robotiques comparées à

ces exigences, nous pouvions considérer de clore notre recherche, mais c’eût été oublier la

question pratique à laquelle certains auteurs tels qu’Allen et Wallach tentent de répondre

indépendamment de l’analyse ontologique, à savoir : « pouvons-nous construire un robot

4

moral ? », sous-entendu indépendamment de sa nature, peut-on reproduire le jugement moral

dans un robot ?

Ces deux questions, ontologiques et pratiques, une fois traitées nous disent encore

fort peu du contexte d’application particulier qui nous intéresse : le cadre militaire. Ce dernier

est régi juridiquement par un ensemble de lois et une longue tradition éthique issue de la

théorie de la guerre juste et de l’enseignement des officiers en France notamment, que nous

avons dû présenter dans leurs grandes lignes. Ceci permettait de répondre en substance au

troisième temps de notre analyse, à savoir « comment un soldat peut-il être moral à la

guerre ? ».

Il était enfin temps d’envisager les effets de l’irruption de ces technologies à la

guerre, autrement dit ce qui advient au point de vue éthique lorsque le robot remplace

l’humain, et ce qui pourrait en résulter à l’avenir. Aucune technologie n’est neutre, et nous

avons analysé la mutation politique qui en est issue en suivant l’herméneutique donnée par

Grégoire Chamayou à ce propos. L’analyse éthique et pratique des robots actuels, avec les

drones en particulier et à venir avec les SALA, nous a permis de juger s’il était permis

d’utiliser des robots à la guerre. Toutes ces voies ayant été explorées, nous avons finalement

pu analyser comparativement les actions des hommes ou des robots à la guerre, et ce qui peut

être dit du projet de création de « robot moral » dans son ensemble.

S’il était nécessaire de se garder des clichés de la science-fiction, la question de la

bonne ou mauvaise action poursuivie par un robot dépourvu d’une supervision humaine et

doté d’une prétendue « autonomie » se posera toujours. Si les robots acquièrent une

« autonomie » ce sera d’abord grâce aux programmeurs humains plutôt que par l’émergence

d’une volonté propre, comme le pensent les partisans de la Singularité, même si rien

n’indique que la Singularité aura, ou n’aura pas, lieu. La programmation du robot constitue un

enjeu moral et éthique dès l’instant où nous ne pouvons plus intervenir directement sur son

fonctionnement. Implicitement, la démarche de Ronald Arkin de programmer les règles

d’engagement et le droit international relatif aux conflits laissait supposer que cette voie était

la seule possible pour éviter deux maux sur les champs de bataille. Sa proposition devait

constituer une solution au dilemme entre devoir utiliser soit un robot sans supervision

« éthiquement aveugle », soit un humain sanguinaire et fragile. Cependant, la manière dont

Arkin présentait son projet ne nous semblait pas neutre dans ses prémisses. Nous nous

sommes donc attachés à reprendre les éléments techniques, éthiques, moraux, mathématiques,

légaux, politiques, psychologiques et méta-éthiques impliqués dans le projet de créer des

robots « moraux » afin d’en mesurer les effets avant de suggérer de faire un choix radical

entre « le robot ou le roseau »

1

à la guerre.

Nous avons vu l’importance du phénomène de la robotisation, brièvement au point

de vue civil et plus particulièrement au point de vue militaire. Nous avons vu les modèles

robotiques existants, en quoi consistait leur autonomie, et pourquoi cette dernière devrait

continuer de s’accroître. Nous avons exposé que l’autonomie robotique recouvre des tâches

différentes, qu’elle est à situer graduellement - la pleine autonomie n’étant pas encore réalisée

voire réalisable - et qu’elle présuppose du robot des senseurs, des capteurs, des actionneurs et

donc une certaine mobilité, ce qui ne disait encore rien de la supervision humaine des

systèmes. L’importance de la supervision humaine efficace dans le débat laisse entendre que,

plus que l’autonomie prétendue des robots, l’enjeu sous-jacent à toute l’évolution technique et

robotique à venir concernera l’attribution du pouvoir de décision. Si jusqu’ici les machines

pouvaient produire mieux, plus vite, et moins cher, désormais, remplacer l’humain dans sa

capacité de décision entraînera des enjeux éthiques importants, notamment l’attribution de la

1

Expression de Mireille Delmas-Marty extrait du titre d’une de ses conférences au Collège de France.

5

responsabilité. C’est pourquoi, une fois les aspects techniques évoqués, nous avons pu nous

consacrer à la moralité des robots.

Nous sommes confrontés à une difficulté majeure dans l’analyse actuelle des robots

moraux. En effet, l’objet que nous cherchons à étudier est absent, ou, du moins, seuls les

fragments qui, mis ensemble, permettront peut-être de le construire, s’offrent à nos yeux.

Opposants et adversaires à cette réalisation en sont réduits à des hypothèses sur les capacités

réelles et les effets qui seront produits par un robot qui « déciderait à notre place ». Il nous a

fallu contourner ce « lieu vide » -ou du moins flou-, source de tous les fantasmes, en adoptant

une interrogation ontologique sur ce qui serait nécessaire à un robot pour avoir d’une part un

statut moral, c’est-à-dire des droits, et d’autre part les qualités requises pour être un agent

moral. Nous avons dû nous rendre à l’évidence : le robot a irréductiblement une valeur

d’usage pour nous. Son « existence » n’est qu’une durée d’exploitation. Ce dernier terme lui-

même détermine encore à quel point le robot demeure servile et asservi à nos propres fins.

Quant à sa capacité à être un agent moral « comme nous », l’objection de Searle demeure un

horizon indépassable, le robot échoue à comprendre le sens de son action, élément

indispensable pour l’attribution de la responsabilité. Pour la même raison, il serait difficile à

un robot d’opérer un jugement qui tiendrait pleinement compte du contexte. Un contexte non

pas entendu comme la simple variation de données empiriques mesurables par la machine,

mais une situation porteuse d’une signification particulière qui modifie par exemple le blâme

encouru pour une mauvaise action. Le robot n’a accès à aucun sentiment, indépendamment

des tentatives pour lui faire simuler des comportements « empathiques ». Sa programmation

rend stérile tout espoir de liberté, en dépit de la confusion langagière que nous avons décriée

sur sa prétendue autonomie. L’imagination et la créativité, éléments nécessaires à l’homme

prudent pour répondre aux situations imprévues et aux défis éthiques découlant de facto de la

confrontation des règles avec la réalité, fait cruellement défaut au robot. Comme Ada

Lovelace l’avait déjà montré, le robot ne peut rien produire de radicalement neuf qui ne lui

soit pas donné par sa programmation. Contrairement à l’esclave antique, le robot ne peut

« s’affranchir » de sa servitude. La qualité de « full moral agent » demeurera ainsi

inaccessible au robot tant que la quasi mythique Singularité qui le dotera d’une conscience ne

se sera pas produite. La possibilité de lui faire endosser une protomorale comme les animaux

ne s’est pas avérée plus concluante, le robot n’étant pas - jusqu’ici - un être vivant dont la

survie lui imposerait de suivre cet ensemble de règles pour résister à la pression de la

sélection naturelle. En résumé, pour qu’un robot soit un agent moral, il aurait dû être.

Puisqu’en dépit de la simulation perfectionnée de nos comportements le robot ne

peut pas nous imiter au niveau de notre être, il s’ensuivrait qu’il ne peut pas agir moralement

et donc nous remplacer. Mais Colin Allen et Wendell Wallach proposaient de prendre acte de

cette impossibilité ontologique. Tout comme les ordinateurs sont dotés d’une intelligence

artificielle, autrement dit simulée, le robot devait seulement être considéré comme un « agent

moral artificiel » selon eux. Si le but de la machine est d’imiter, peu importe ce qu’elle est, il

lui suffit de savoir faire. La mesure de ce savoir-faire serait le Moral Turing Test, ou sa

version plus complète, le comparative Moral Turing Test. Ce point de vue induisait un

questionnement pratique sur la programmation de la morale et du raisonnement éthique. Nous

avons dès lors évoqué différentes possibilités de programmation morale, le kantisme,

l’aristotélisme, l’utilitarisme, la programmation du droit et des règles d’engagement dans

l’architecture proposée par Arkin, les principes de Constant, et enfin les trois lois de la

robotique d’Asimov. Chacune de ces propositions se heurtait au constat que tout comme

« traduire, c’est trahir », programmer, c’est réduire. En l’absence de robots agissant d’après

ces principes, nous n’avons pas même pu leur faire passer le cMTT. Nous nous sommes donc

attachés à décrire les difficultés qui continueront à peser sur leur réalisation.

6

6

7

7

8

8

9

9

10

10

1

/

10

100%