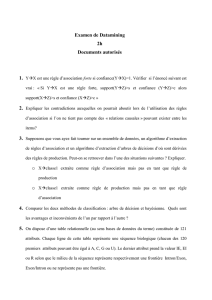

Dataminig - C4.5

14-16 rue Voltaire

94270 Kremlin Bicˆetre

Benjamin DEV `

EZE

Matthieu FOUQUIN

PROMOTION 2005

SCIA

DATAMINING

C4.5 - DBSCAN

Mai 2004

Responsable de sp´

ecialit´

e SCIA : M. Akli Adjaoute

Table des mati`eres

Table des mati`eres

1 Introduction 1

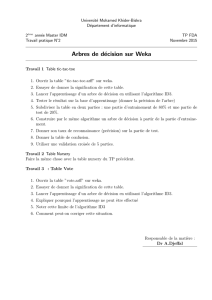

2 L’algorithme C4.5 2

2.1 Petit rappel concernant le datamining . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2

2.1.1 D´

efinition ........................................ 2

2.1.2 Quelquesapplications ................................. 2

2.1.3 Aperc¸u g´

en´

eral des techniques classiques . . . . . . . . . . . . . . . . . . . . . . 3

2.2 L’algorithmeID3 ........................................ 4

2.2.1 Arbres de d´

ecision ................................... 4

2.2.2 Introduction....................................... 5

2.2.3 Quelques d´

efinitions de th´

eorie de l’information . . . . . . . . . . . . . . . . . . 6

2.2.4 L’algorithmeID3 .................................... 7

2.3 L’algorithmeC4.5........................................ 8

2.3.1 Les limites de l’algorithme ID3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

2.3.2 Les extensions de l’algorithme C4.5 . . . . . . . . . . . . . . . . . . . . . . . . . 8

3 L’algorithme DBSCAN 11

3.1 Les syst`

emesdeclustering................................... 11

3.1.1 LesClusters....................................... 11

3.1.2 Propri´

et´

esd’uncluster................................. 11

3.1.3 Etapes d’un syst`

emedeclustering .......................... 12

3.1.4 Les m´

ethodesdeclustering .............................. 12

3.1.5 Propri´

et´

es des techniques de clustering . . . . . . . . . . . . . . . . . . . . . . . 14

3.2 DBSCAN............................................. 15

3.2.1 Int´

erˆ

etdeDBSCAN................................... 15

3.2.2 Notion de Cluster bas´

e sur la densit´

e ........................ 16

3.2.3 AlgorithmeDBSCAN ................................. 16

3.2.4 D´

eterminer les param`

etresEpsetMinPts ...................... 18

3.2.5 Evaluation de la performance de DBSCAN . . . . . . . . . . . . . . . . . . . . . 18

3.3 Autresapproches ........................................ 20

Bibliographie 21

Datamining - C4.5 - DBSCAN Page i

Table des figures

Table des figures

2.1 Arbre de classification des m´

ethodes de datamining . . . . . . . . . . . . . . . . . . . . 4

2.2 Donn´

ees d’apprentissage pour notre exemple . . . . . . . . . . . . . . . . . . . . . . . . 5

2.3 Arbre de classification obtenu pour l’exemple . . . . . . . . . . . . . . . . . . . . . . . . 8

2.4 Exemplesurunarbresimple ................................. 9

3.1 DistancedeMinkowski..................................... 12

3.2 Leclusteringsurunexemple ................................. 14

3.3 Une id´

ee intuitive de la densit´

e ................................ 16

3.4 AlgorithmeDBSCAN...................................... 17

3.5 Notions de points dense-accesibles et de dense-connexit´

e................. 18

3.6 Heuristique de fixation des param`

etres ........................... 18

3.7 Clusters trouv´

esparCLARANS................................ 19

3.8 Clusters trouv´

esparDBSCAN................................. 19

3.9 Temps d’ex´

ecution compar´

eensecondes .......................... 19

Datamining - C4.5 - DBSCAN Page ii

Chapitre 1. Introduction

Chapitre 1

Introduction

Le but du pr´

esent rapport est de pr´

esenter deux algorithmes utilis´

es dans le cadre du datamining.

Dans un premier temps nous pr´

esenterons l’algorithme classique qu’est C4.5. Celui-ci ´

etant une

extension naturelle de l’algorithme ID3 nous pr´

esenterons d’abord ID3 puis forts de cette ´

etude nous

aborderons plus en d´

etails C4.5 et ses am´

eliorations. Puis dans un second temps nous aborderons

l’algorithme DBSCAN qui est un algorithme de clusterisation non supervis´

e qui travaille sur les

densit´

es et qui comme nous allons le voir s’av`

ere extrˆ

ement basique.

Datamining - C4.5 - DBSCAN Page 1

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

1

/

25

100%