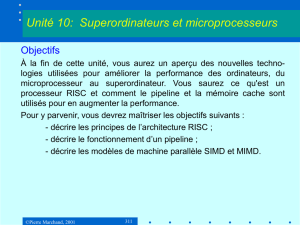

Unité 10: Superordinateurs et microprocesseurs Unité 10

1

©Pierre Marchand, 2001 311

Objectifs

À la fin de cette unité, vous aurez un aperçu des nouvelles techno-

logies utilisées pour améliorer la performance des ordinateurs, du

microprocesseur au superordinateur. Vous saurez ce qu'est un

processeur RISC et comment le pipeline et la mémoire cache sont

utilisés pour en augmenter la performance.

Pour y parvenir, vous devrez maîtriser les objectifs suivants :

- décrire les principes de l’architecture RISC ;

- décrire le fonctionnement d’un pipeline ;

- décrire les modèles de machine parallèle SIMD et MIMD.

Unité 10: Superordinateurs et microprocesseurs

©Pierre Marchand, 2001 312

9.1 Introduction

La performance des ordinateurs modernes couvre la gamme de celle

des superordinateurs tels que le Cray à celle des micro-ordinateurs

personnels à base de microprocesseurs.

Unité 10: Superordinateurs et microprocesseurs

Le plus puissant des Cray actuels,

le Cray T3E-1200, possède de 6 à

2048 proces-seurs, jusqu’à 2 Go

de mémoire centrale par proces-

seur (RAM statique!), et est capa-

ble d’atteindre 2458 milliards

d’opérations de virgule flottante

(Gigaflops) à la seconde.

La bande passante mémoire est de

l’ordre de 700 Go / s.

Les processeurs sont des Alpha

21164A de DEC.

2

©Pierre Marchand, 2001 313

9.1 Introduction

Ces performances sont nécessaires dans des disciplines ayant des

problèmes nécessitant d’énormes quantités d’opérations arithmétiques,

par exemple :

la météorologie,

la dynamique des fluides,

l’aérodynamique,

l’analyse des structures,

la micro-électronique,

la physique des particules,

la chimie et la biologie moléculaire,

les mathématiques appliquées,

la simulation numérique de systèmes,

Unité 10: Superordinateurs et microprocesseurs

©Pierre Marchand, 2001 314

9.1 Introduction

Le traitement d’images (en particulier, les images 3D),

la reconnaissance des formes, etc.

On résout ces problèmes d’abord en augmentant la vitesse du proces-

seur, puis en mettant plusieurs processeurs en parallèle.

Unité 10: Superordinateurs et microprocesseurs

3

©Pierre Marchand, 2001 315

9.1 Introduction

9.1.1 Accroissement de la puissance des ordinateurs

Une des limites à la vitesse des processeurs est le temps de

propagation des signaux.

Distance parcourue Vitesse

en 1 ns en km / s

Lumière dans le vide 30 cm 300 000

Signal électrique dans un 1 µm à 1 cm 1 à 100 000

Semiconducteur

On a donc intérêt à réduire les dimensions physiques des processeurs.

Unité 10: Superordinateurs et microprocesseurs

©Pierre Marchand, 2001 316

9.1 Introduction

Une façon de contourner ce problème est d’introduire du parallélisme :

pipelines, unités d’exécution multiples, processeurs auxiliaires spéciali-

sés : accélérateurs graphiques, transformée de Fourier rapide, etc.

Dans le cas de problèmes numériques, les machines vectorielles

s’avèrent souvent une bonne solution. Ces machines effectuent

simultanément la même instruction sur des données différentes au

moyen d’UAL multiples.

Unité 10: Superordinateurs et microprocesseurs

4

©Pierre Marchand, 2001 317

9.1.2 Technologie et performance

Loi d’Amdahl

On peut définir le «speed-up» comme le rapport entre les temps

d’exécution avant et après l’amélioration apportée au matériel.

Comme certains dispositifs ne sont pas nécessairement utilisés à

chaque instruction du programme, le gain obtenu par une

performance accrue, sur une partie de programme, diminue au fur

et à mesure qu’on ajoute des améliorations.

Par exemple, un additionneur dix fois plus rapide ne produira pas

un speed-up de 10 et une machine avec 1000 processeurs

n’exécutera pas chaque travail 1000 fois plus vite.

Unité 10: Superordinateurs et microprocesseurs

©Pierre Marchand, 2001 318

9.1.2 Technologie et performance

Loi d’Amdahl

Le temps d’exécution après une amélioration d’un aspect d’une

machine est donné par :

Exemple : Supposons que le temps d’exécution d’un certain

programme soit 100 sec et que les multiplications représentent 80

sec de ce temps. Quel sera le temps d’exécution après avoir

apporté une amélioration de 5 dans la vitesse de multiplication ?

Donc une amélioration globale de 2,77 seulement.

Unité 10: Superordinateurs et microprocesseurs

Temps d'exécution après amélioration

= Temps d'exécution affecté par l'amélioration

Facteur d'amélioration +Temps d'exécution non affecté

Temps d'exécution après amélioration= 80

5+20=36

5

©Pierre Marchand, 2001 319

9.1.2 Technologie et performance

Loi d’Amdahl

On ne peut donc pas s’attendre à ce qu’une amélioration d’un

aspect d’une machine apporte une amélioration proportionnelle au

facteur d’amélioration.

Unités de traitement

Les technologies ULSI (Ultra Large Scale Integration) et WSI

(Wafer Scale Integration),

les fréquences d’horloge ≥ 1 GHz,

la technologie RISC,

permettent aujourd’hui d’atteindre un cycle machine inférieur à 1

ns, donc plus de 1000 MIPS.

Unité 10: Superordinateurs et microprocesseurs

©Pierre Marchand, 2001 320

Mémoires

La capacité des DRAM augmente d’un facteur 4 tous les 3 ans.

La capacité des disques durs double tous les trois ans. Avec les

nouvelles têtes magnéto-résistives qui survolent la surface du

disque à 0,01 microns, on s’attend à ce que l’augmentation

annuelle de la densité passe de 30 à 60%.

Communications

Communications par câble, par satellite, etc. Transmission par

fibre optique. Communications par infra-rouge.

Parallélisme à tous les niveaux.

Parallélisme des actions et des opérations à tous les niveaux de

traitement, de stockage et de transmission des opérations.

Unité 10: Superordinateurs et microprocesseurs

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%