Fouille de données / Data Mining

Fouille de données / Data Mining

Julien VELCIN

Université Lumière Lyon 2

Master 2 parcours CEE

1 / 100

Remerciements

⌅Julien Jacques

Pr. de Statistique (ICOM, Lyon 2)

⌅Sabine Loudcher

Pr. d’Informatique (ICOM, Lyon 2)

⌅Julien Ah-Pine

MCF d’Informatique (ICOM, Lyon 2)

2 / 100

La fouille de données : qu’est-ce que c’est ?

Première définition

Ensemble de méthodes destinées à extraire d’un ensemble de données

celles qui ont le plus de valeur.

Deuxième définition

Ensemble d’approches statistiques permettant d’extraire de l’information

de grands jeux de données dans une perspectives d’aide à la décision.

Ma définition

Ensemble d’approches permettant d’extraire de l’information utile de

grands jeux de données, utile pouvant être une information qui :

⌅confirme un élément connu mais cette fois de manière rigoureuse,

systématique,

⌅apprend quelque chose de nouveau qui enrichit notre perception des

données (et du problème sous-jacent),

⌅peut être employée dans une perspective d’aide à la décision.

3 / 100

Les étapes du data mining1

1. Nettoyage des données (erreurs, données manquantes, outliers)

2. Transformation éventuelle des données (normalisation, linéarisation...)

3. Explicitation de l’objectif de l’analyse (recherche de motifs, régression,

classification, clustering...)

4. Choix de la méthode et mise en oeuvre informatique ( ...)

5. Test (validation de la qualité des résultats)

6. Exploitation

1P. Besse et al., Data Mining et Statistique, Journal de la Société Française de

Statistique, 142[1], 2001.

4 / 100

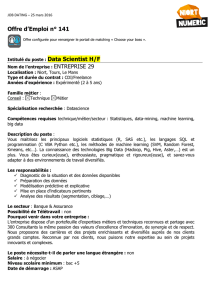

Data mining et informatique décisionnelle

5 / 100

La fouille de données : quelques références

(conseillées par J. Jacques)

6 / 100

La fouille de données : quelques références

⌅http://mediamining.univ-lyon2.fr/velcin/

⌅http://eric.univ-lyon2.fr/⇠ricco/data-mining/

⌅http://data.mining.free.fr

⌅http://eric.univ-lyon2.fr/⇠jjacques/

⌅http://larmarange.github.io/analyse-R/

7 / 100

La fouille de données : à quoi cela sert ?

⌅publicité ciblée sur internet

⌅identification des prospects les plus susceptibles de devenir clients

⌅reconnaissance faciale dans une image

⌅évaluer le risque d’un client (credit scoring)

⌅détection de fraudes bancaires

⌅analyse automatique de contenus textuels (text mining)

⌅reconnaissance de la parole

⌅recommandation automatique

⌅prévision de consommation d’électricité

⌅prévision de trafic routier

⌅tester l’efficacité d’un traitement médical

⌅etc.

8 / 100

D’où vient le data mining ?

Le data mining se nourrit de multiples influences

⌅Statistique (analyse des données)

⌅Intelligence artificielle (apprentissage automatique)

⌅Bases de données (on parle de KDD)

9 / 100

Un peu d’histoire2

⌅1875 : régression linéaire de Francis Galton

⌅1896 : formule du coefficient de corrélation de Karl Pearson

⌅1900 : distribution du 2de Karl Pearson

⌅1936 : analyse discriminante de Fisher et Mahalanobis

⌅1941 : analyse factorielle des correspondances de Guttman

⌅1943 : réseaux de neurones de Mc Culloch et Pitts

⌅1944 : régression logistique de Joseph Berkson

⌅1958 : perceptron de Rosenblatt

⌅1962 : analyse des correspondances de J.P. Benzécri

⌅1964 : arbre de décision AID de J.P. Sonquist et J.A. Morgan

⌅1965 : méthode des centres mobiles de E.W. Forgy

⌅1967 : méthode des k-means de MacQueen

⌅1972 : modèle linéaire généralisé de Nelder et Wedderburn

2Directement extrait des transparents de S. Tufféry: http://data.mining.free.fr

10 / 100

Un peu d’histoire (suite)

⌅1975 : algorithmes génétiques de Holland

⌅1975 : méthode de classement DISQUAL de Gilbert Saporta

⌅1980 : arbre de décision CHAID de KASS

⌅1983 : régression PLS de Herman et Svante Wold

⌅1984 : arbre CART de Breiman, Friedman, Olshen, Stone

⌅1986 : perceptron multicouches de Rumelhart et McClelland

⌅1989 : réseaux de T. Kohonen (cartes auto-adaptatives)

⌅vers 1990 : apparition du concept de data mining

⌅1993 : arbre C4.5 de J. Ross Quinlan

⌅1996 : bagging (Breiman) et boosting (Freund-Shapire)

⌅1998 : support vector machines de Vladimir Vapnik

⌅2000 : régression logistique PLS de Michel Tenenhaus

⌅2001 : forêts aléatoires de L. Breiman

11 / 100

Le data mining aujourd’hui

On parle plus volontiers de “data science” qui regroupe toutes les

activités autour des données, au-delà de l’aspect analyse :

12 / 100

Le data mining aujourd’hui

Ce qui a changé la donne :

⌅des capacités de stockage et de calculs en constante augmentation

⌅constitution de gigantesques bases de données, en particulier au

sein des entreprises

⌅l’accès à des logiciels de plus en plus performants pour traiter ces

données

⌅des technologies innovantes, par ex. issues de l’IA, qui “sortent des

laboratoires” (machine learning)

13 / 100

La fouille de données : panorama des méthodes

fouille de données

méthodes

prédictives

méthodes

descriptives

14 / 100

La fouille de données : panorama des méthodes

méthodes

prédictives

classification

supervisée

prédire

Y quali.

régression

prédire

Y quanti.

méthodes

descriptives

détections

de liens

recherche

d’associations

analyse

factorielle

ACP, AFC,

ACM

clustering

15 / 100

La fouille de données : panorama des méthodes

Ce qui n’est pas abordé dans ce cours :

⌅analyse factorielle (ACP, AFC, ACM...)

projection et visualisation de données dans un espace de dimension

faible

⌅régression

prédire une variable quantitative

⌅détections de liens

extraire des motifs fréquents ou des règles d’association

16 / 100

La fouille de données : panorama des méthodes

Ce qui est abordé dans ce cours :

⌅clustering (classification automatique, classification non supervisée,

segmentation, typologie...) :

regrouper des individus qui se ressemblent en catégories homogènes

⌅classification supervisée (discrimination, analyse discriminante,

scoring) :

classer des individus dans des classes définies a priori

Notations :

⌅les individus (observations) sont décrits par un ensemble de p

variables aléatoires explicatives X=(X1,...,Xp)2E(E=Rp,...)

⌅Xi=(Xi1,...,Xip)sont les variables explicatives pour l’individu i

(1 in)

⌅Zi2{1,...,K}est le numéro de la classe de l’individu i

17 / 100

Classification non supervisée vs supervisée

Classification non supervisée

⌅Ziinconnue (aucun à priori)

⌅objectif : à partir de l’observation de X1,...,Xn, trouver Z1,...,Zn

⌅les classes sont ensuite interprétées dans le but de leur donner une

signification concrète

Classification supervisée

⌅Ziconnue (signification connue a priori)

⌅objectif : à partir de l’observation de (X1,Z1),...,(Xn,Zn)construire

une règle de classement (classifieur) r:

r:X! r(X)=Z

⌅utiliser cette règle de classement pour classer de nouveaux individus

de classes inconnues

18 / 100

Apprentissage automatique inductif

Aristote

“La connaissance vient du monde”

Définition

Trouver des règles générales (voire des concepts) à partir d’un

ensemble d’observations particulières

Autres types d’apprentissage

⌅apprentissage par cœur

⌅apprentissage par renforcement

⌅apprentissage par abduction

19 / 100

Applications

Classification non supervisée

⌅analyse exploratoire : donner une représentation simplifiée des

données pour mieux les comprendre

⌅exemple : typologie clients en marketing (Gestion de la relation

clients / CRM - Customer Relationship Management)

Classification supervisée

⌅analyse prédictive : prédire une variable (Z) qualitative à partir de

variables explicatives (X)

⌅exemples : prédire si un prospect va acheter le produit qu’on lui

propose, prédire la probabilité qu’un patient soit atteint d’une certaine

maladie...

20 / 100

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

1

/

13

100%