Approche bayésienne pour la tomographie des temps de première

!""#$%&'()*+,-.'//'("$0#(1*(

2$3$4#*"&.'(5'-(2'3"-(5'(

"#'3.6#'(*##.7,'(

Jihane BELHADJ--------Thomas-ROMARY---------Alexandrine-GESRET--------Mark-NOBLE--

8$3$4#*"&.'( -.-3.90'

▪La-tomographie-des-temps-de-première-arrivée-a-pour-objectif-de-cartographier-le-modèle-de-

vitesse-de-propagation-des-ondes-sismiques-à-partir-des-temps-de-première-arrivée-mesurés

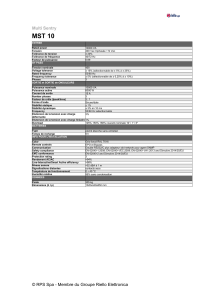

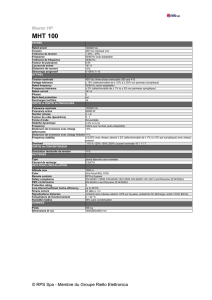

:.40#'; Les-problèmes- direct-et-inverse-en-tomographie-des-temps-de-première-arrivée-relient-un-

modèle-de-vitesse-aux-temps-de-première-arrivée-pointés- (en-ligne-rouge)-sur-un-sismogramme.

<2*"'-(5'(1*(2$3$4#*"&.'(-.-3.90'(

Étapes-de-la-résolution-du-problème-inverse

▪=*("*#*3,2#.-*2.$/ 50(3$561'(5'(7.2'--'; Définir-les-inconnues-du-problème

▪='("#$)163'(5.#'%2 ;((((Calculer-les-données-à-partir-du-modèle-de-vitesse

▪=>./7'#-.$/;((Trouver-un-ou-des-modèle(s)-qui-correspond(ent)-aux-données-observées

?*#*3,2#.-*2.$/

▪Détermination-d’un-nombre-minimal-de-paramètres-(paramètres-principaux)

▪Modèle approximé par une combinaison linéaire m(x) d’un nombre fini de fonctions de base !"

miParamètres du modèle

!"#$%& %'"#$%( )'*%+*"#$%

*

!

?#$)163'(5.#'%2

▪Temps-de-trajet-des-ondes-P-et-S-=>-Équation-Eikonal

Dans-le-cadre-asymptotique-haute-fréquence--

t temps-de-trajet-,s- lenteur

▪En-général,-il-n’existe-pas-de-solution-analytique-à-l’équation-Eikonal

=>-recourir-à-des-méthodes-de-résolution-numérique

Solveur-numérique-pour-un-modèle-de-vitesse--[Noble-et-al.,-2014]-

!𝜕𝑡

𝜕𝑥%2+!𝜕𝑡

𝜕𝑦%2+!𝜕𝑡

𝜕𝑧%2= 𝑠²(𝑥,𝑦,𝑧)!

!"#$ %$ &'( ) *

+"#$ %$ &'!

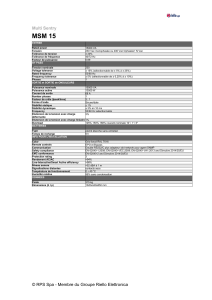

:.40#' Exemple-de-temps-de-trajet-calculés

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

1

/

21

100%