Manuel de calcul numerique applique

2

I

de la convergence des suites

Quelques algorithmes

accélérateurs

Au cours de ce chapitre, nous allons présenter quelques algorithmes très puissants qui ont pour

but d’accélérer la vitesse de convergence des suites. I1 s’agit de l’algorithme d’Aitken, du procédé

d’extrapolation de Richardson et de l’epsilon-algorithme, ce dernier ayant vu le jour en 1956

à

la suite des travaux de

P.

Wynn. Nous nous attacherons essentiellement

à

leur présentation et

à

leur mise en œuvre dans la mesure

où

nous ferons souvent appel

à

eux au cours des différents

chapitres.

Sans entrer dans des considérations théoriques de haut niveau, il est possible de dire que

d’une part l’epsilon-algorithme est une généralisation du procédé d’Aitken, et que d’autre

part il est relié aux approximants de Padé et aux fractions continues

(cf.

annexes

C

et

D).

I1

n’est pas question d’effectuer ici les justifications théoriques relatives

à

ces algorithmes et

nous limiterons nos ambitions

à

en apprendre le maniement. Cependant, le lecteur intéressé par

les fondements des techniques d’accélération de convergence pourra avoir recours

à

l’excellent

ouvrage de C. Brézinski

:

Algorithmes d’Accélération de la Convergence. Étude Numérique, aux

Éditions Technip, Paris (1978). Dans cet ouvrage figurent d’autres procédures d’accélération de

la convergence, de nombreux exemples d’applications et des programmes rédigés en Fortran. Pour

tout ce qui a trait aux procédures d’accélération de la convergence, il est nécessaire d’insister

sur le fait que les résultats proposés ne concernent que les nombres susceptibles de pouvoir être

effectivement calculés avec une précision suffisante.

1.

L’algorithme

A*

d’Aitken (1895-1967)

Supposons que nous connaissions une suite numérique convergente

So,

Si,.

. . ,

S,.

Par exemple

les

SI,

peuvent être constitués par les sommes partielles d’une série, ou encore par la suite des

approximations successives de la racine d’une équation

f(x)

=

O

obtenues par une méthode

itérative.

À

partir de cette suite de

(n

+

1)

termes, nous allons construire une autre suite de

n

termes et ainsi de suite. Nous définissons une procédure récurrente, et pour les besoins de

la cause, nous allons numéroter des suites ainsi formées au moyen d’un exposant placé entre

parenthèses. Ainsi, la suite initiale s’écrit

:

so“’,

$1,.

.

. ,

SF).

31

MANUEL

DE

CALCUL NUMÉRIQUE APPLIQUÉ

1.1.

Présentation de la méthode

Considérons une suite numérique

SF’,

s?),

S?’

.

.

.

,

si0)

dont la convergence est lente.

À

partir

de la suite des

Sf),

on forme une nouvelle suite

Sj

(1)

obtenue de la manière suivante

:

À

partir de la dernière suite formée, celle des

Sf),

on obtient une autre suite au moyen du

même procédé. On note qu’à chaque construction d’une nouvelle suite, le nombre d’éléments

de la suite diminue de deux unités. L’application successive de ce processus nous conduit

à

l’obtention de la suite qui n’est plus constituée que d’un seul terme

à

condition toutefois que le

nombre de termes de la suite initiale soit impair. Le terme général s’écrit alors

:

1.2.

Un exemple numérique

On se propose d’appliquer

sommation de la série

:

cet algorithme

à

la suite des sommes partielles obtenue par la

qui est bien connue pour sa convergence lente. En retenant les cinq premiers termes de la suite

on trouve

S

=

0,834920. L’usage de l’algorithme d’Aitken, avec les mêmes nombres, permet de

trouver

S

=

0,785 526. Autrement dit, l’erreur relative sur

T

passe de 6,3

lop2

à

5,l

On trouvera sur le Web

(*)

un programme

aitkenO.

c

mettant en œuvre cet algorithme.

2.

Le procédé d’extrapolation de Richardson

(1881-1953)

On désigne toujours par

S’y’,

avec

j

=

O,

1’2.

.

.

n,

la suite initiale que l’on désire voir converger

plus rapidement, et par

xk

une suite auxiliaire

((

choisie convenablement

».

Nous aborderons un

peu plus loin le problème du choix de la suite auxiliaire. La méthode de Richardson consiste

à

former une suite de

((

vecteurs

))

au moyen de la relation suivante

:

(k)

(k)

xm

-

Xm+k+l

’

(2.2)

sg+i)

=

xmSrn+i

-

xm+k+lSm

avec

m,

k

=

O,

1’2,.

.

.

n.

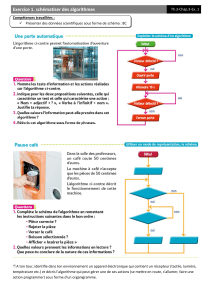

La succession des opérations est symbolisée par le tableau

2.1,

page

ci-contre.

Dans la mesure

où

les

x,

sont indépendants des

5’2)’

il est aisé de s’apercevoir qu’il s’agit

d’un algorithme en triangle et que

S“’)

est une combinaison linéaire de

Smfl

et

Sm

,

il s’ensuit,

alors, que le procédé de Richardson est une transformation linéaire de suites.

Remarque

:

Dans le cas particulier

où

l’on choisit comme suite auxiliaire la suite

:

(k)

(4

(0)

(0)

-

&O),

xm=

Sk+l-

sk

-

k

*

http://www.edpsciences.com/guilpin/

32

2.

QUELQUES

ALGORITHMES

ACCÉLÉRATEURS

DE

LA

CONVERGENCE

DES

SUITES

Tableau 2.1.

So“’

S?)

on obtient alors un algorithme qui n’est plus en triangle et qui n’est plus linéaire.

La

relation

générale est donnée par l’expression

:

2.1.

Quelques éléments de théorie

Revenons

à

la suite initiale SF’ qui converge vers

S

ainsi qu’à la suite auxiliaire

xk

indépendante

des

Sj

que l’on suppose d’une part strictement décroissante et d’autre part tendre vers zéro

lorsque

n

tend vers l’infini. Le procédé d’extrapolation de Richardson est fondé sur la formule de

Neville-Aitken qui donne une façon de construire les polynômes d’interpolation pour une valeur

du polynôme d’interpolation de degré

IC,

lequel, aux abscisses

xp,

prend les valeurs

SF)

pour

A présent nous allons énoncer quelques théorèmes importants, mais dont nous ne donnons

pas la démonstration.

a

-

Théorème

I

-

Pour que

Sjk)

tende vers

S

quel que soit

j

>

N,

il faut et il suffit que

s(“’

=

s

+

E,,’

aixi

quel que soit

rn

>

N.

ce qui constitue une autre expression de ce théorème

:

(0)

particulière de la variable

(cf.

chapitre

6

sur l’interpolation). En effet,

Sj

(k’

est la valeur

en

zéro

pTj,j+l,

...,j+

k.

k

Autrement dit, les

Sj

(k)

peuvent s’exprimer sous la forme d’un rapport de deux déterminants,

..............

1.;

...

x:+kl

33

1

/

3

100%