Chapitre II Les fissures de l`édifice de la physique classique I

11

Chapitre II

Les fissures de l'édifice de la physique classique

A la fin du 19ème siècle, les deux piliers de la physique que constituent la mécanique et

l'électromagnétisme semblaient capables de rationaliser l'ensemble des lois de la nature.

Cependant, l'examen critique des phénomènes liés à l'interaction entre la matière et un

rayonnement électromagnétique fit apparaître la nécessité de remettre en cause cet édifice.

L'analyse de plusieurs expériences (rayonnement du corps noir, effet photoélectrique,

expériences de diffraction d’électrons ou de neutrons ...) a mis en évidence le fait que les

particules élémentaires ne se conforment pas aux lois de la mécanique classique, et se

manifestent parfois selon des lois similaires à celles qui régissent les ondes. A l’opposé, les

ondes lumineuses se manifestent aussi sous forme corpusculaire. Ces phénomènes sont à

l'origine de la révolution de la physique au début du siècle, et sont décrits par les relations de

dualité onde - corpuscule.

I. Structure de l'atome

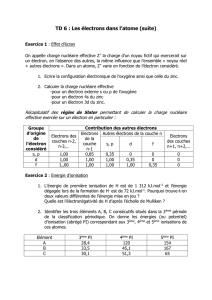

En 1897, le physicien anglais THOMSON observe que lorsqu'on établit une différence

de potentiel entre deux électrodes placées dans un tube en verre à l'intérieur duquel la pression

est très faible, un spot lumineux (appelé rayon cathodique) apparaît sur le verre derrière

l'électrode positive. Une étude détaillée des déviations subies par le rayon cathodique sous

l'effet de champs électriques et magnétiques montre qu'il s'agit d'un courant de particules

indépendantes du matériau et chargées négativement, les électrons. Quelques années plus

tard, MILLIKAN détermine la valeur de la charge de l'électron en étudiant les mouvements de

goutelettes d'huile électrisées entre les plaques d'un condensateur horizontal. Cette valeur,

notée conventionnellement e, constitue la plus petite charge électrique que puisse porter une

particule. Toute charge électrique ne peut être, en valeur absolue, qu'un multiple entier de

celle de l'électron :

e=1, 602177.10!19 C

Autre conclusion importante des observations de THOMSON: les électrons portant

une charge négative et étant émis par des métaux initialement neutres, une source de charges

positives doit exister dans les métaux. En 1911, RUTHERFORD montre expérimentalement

que presque toute la masse et toute la charge positive d’un atome sont localisées en son

centre, qu’il appelle le noyau. Il propose alors une structure de l’atome de type planétaire,

dans laquelle les électrons chargés négativement orbitent autour du noyau. Dans ce modèle, la

cohésion de l'édifice atomique résulte de la force de Coulomb, jouant pour l'atome le rôle de

la force de gravitation dans un système planétaire.

Ce modèle planétaire souffre cependant d'une incohérence liée aux lois de

l'électromagnétisme. En effet, les particules chargées en mouvement accéléré sont

susceptibles d'émettre un rayonnement lumineux. Le mouvement de rotation d'un électron

autour du noyau fait que le champ électrique créé par le dipôle que constituent les deux

particules chargées varie au cours du temps : ce dipôle électron-proton change d'orientation au

fur et à mesure que l'électron tourne autour du proton. L'atome crée donc un champ

électrique oscillant, c'est-à-dire une onde électromagnétique. Il perd donc continuement de

l'énergie sous forme électromagnétique.

12

La conservation de l'énergie totale implique que l'énergie rayonnée correspond à une

perte d'énergie mécanique de l'électron. Celui-ci doit perdre de "l'altitude". Le terme

inéluctable de sa trajectoire est la collision avec le noyau, avec pour l'atome une durée de vie

estimée de l'ordre de 10-8 seconde.

La réalité est évidemment tout autre ; les atomes sont stables et n'émettent pas

spontanément de lumière.

La physique classique est donc incapable de rendre compte de l’existence des

atomes et donc des molécules. L'existence de deux théories distinctes, la mécanique et

l'électromagnétisme, est à l'origine de cet échec.

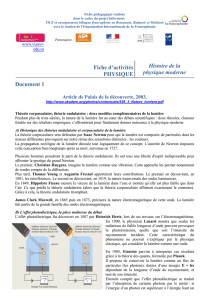

II. Aspect corpusculaire de la lumière

La nature de la lumière est un problème qui a suscité un grand nombre de controverses

scientifiques pendant plusieurs siècles. En 1704, NEWTON suggère qu’un faisceau lumineux

pourrait être constitué de corpuscules très fins. Cette hypothèse est en accord avec les lois de

l’optique géométrique : la conservation de la quantité de mouvement explique la propagation

rectiligne du flux lumineux, et le phénomène de réflexion provient des collisions élastiques

entre les corpuscules et le miroir, et apparaît donc comme une conséquence directe de la

conservation de l’énergie et de la quantité de mouvement.

Contemporain de Newton, le physicien néerlandais HUYGENS émet l’hypothèse que

la lumière est un phénomène ondulatoire. Cette hypothèse offre le moyen de décrire

parfaitement les rayons lumineux, mais se heurte à un problème insurmontable : à cette

époque, tous les phénomènes ondulatoires connus (ondes aquatiques, ondes sonores…)

nécessitent un milieu à travers lequel se propager. Dans ce cas, comment expliquer que la

lumière traverse le vide ? Pour contourner cette difficulté, on postula l’existence de l’éther,

milieu dans lequel toute onde lumineuse peut se propager.

Pendant un siècle, les descriptions ondulatoire et corpusculaire de la lumière

coexistent. Il faut attendre les travaux de YOUNG en 1801, et en particulier l’observation des

phénomènes de diffraction et d’interférences pour que soit abandonnée la description

corpusculaire de la lumière. Si un faisceau lumineux rencontre une fente très étroite percée

dans un écran opaque, la lumière qui traverse la fente se propage dans toutes les directions, de

manière analogue aux ondes aquatiques : c’est la diffraction. Si deux faisceaux diffractés qui

se recouvrent sont projetés sur un écran, il apparaît sur l’écran une alternance de bandes

lumineuses et de bandes sombres, appelée figure d’interférences. La théorie corpusculaire ne

permet pas d’expliquer ces deux phénomènes : ils prouvent le caractère ondulatoire de la

lumière. En 1862, MAXWELL montre que l’onde lumineuse est de nature électromagnétique

et propose une série d’équations décrivant sa propagation.

A la fin du 19ème siècle, il semble donc définitivement acquis que la lumière est une

onde. Mais une série d’expériences menées au début du 20ème siècle viennent remettre en

question cette description, et relancer la controverse.

13

II.1. Le rayonnement du corps noir

Un corps noir est un objet non réfléchissant qui émet de la lumière lorsqu'il est

chauffé. Lorsqu’un corps noir est porté à haute température, il émet un rayonnement appelé

rayonnement thermique, dont le taux d’émission R est proportionnel à la puissance 4 de la

température (loi de STEFAN, 1879). Si un rayonnement thermique à taux constant est envoyé

sur un corps noir, la température de ce dernier s’élève ; il émet alors à son tour un

rayonnement, dont le taux d’émission devient de plus en plus intense à mesure que la

température augmente. La température se stabilise lorsque le taux d’émission est égal au taux

d’absorption. Le système est alors dans un état d’équilibre thermodynamique.

A la fin du 19ème siècle, RAYLEIGH et JEANS proposent une loi de distribution

spectrale R(λ) du rayonnement à l’équilibre thermodynamique, à partir de la théorie cinétique

de la matière et des statistiques de BOLTZMANN. Dans ce modèle, les ions oscillent avec un

ensemble continu de fréquences autour de leur position moyenne ; ces oscillations sont

responsables de l’émission du rayonnement. Le spectre du corps noir est alors donné par :

R(

!

)=8

"

k

!

4T

où k est la constante de Boltzmann.

Comme le montre la figure, la loi de

RAYLEIGH-JEANS ne permet de rendre

compte de l'émission du corps noir qu'aux

grandes longueurs d'onde (faibles

fréquences). Pour des longueurs d'onde

inférieures, elle fait apparaître une

divergence dramatique par rapport à la

distribution expérimentale. Cette divergence

est appelée "catastrophe ultra-violette", car

la discordance devient particulièrement

marquée pour les longueurs d'onde

correspondant à l'ultra-violet.

En 1900, Max Planck propose une solution permettant de résoudre le problème posé

par la catastrophe UV et de décrire complètement l'ensemble du spectre du corps noir. Le

point central de la solution de Planck est que les ions oscillants ne se comportent pas comme

des oscillateurs classiques, et n'émettent pas une énergie variant de façon continue. Ils ne

peuvent émettre qu'une énergie égale à un multiple entier d'une quantité de base hν, (le

quantum d'énergie), où

ν

est la fréquence de l'oscillateur. La constante h fut proposée comme

nouvelle constante universelle. Sa dimension est celle d'une action (une énergie fois un

temps). Les déterminations expérimentales ultérieures de h conduisent à la valeur :

h = 6,6253. 10–34 J.s

L'échange d'énergie entre le rayonnement et la cavité est donc discontinu, ou quantifié.

L'introduction de la condition quantification dans la statistique de BOLTZMANN conduit à

une modification de la loi de distribution spectrale :

14

R(

!

)=8

"

hc

!

5#1

exp hc k

!

T

( )

$1

,

qui reproduit parfaitement la loi expérimentale.

En contradiction avec les lois classiques de la thermodynamique et de

l’électromagnétisme, la quantification de l'échange d'énergie entre matière et rayonnement

apparaît à l'époque comme une révolution. PLANCK lui-même émet des doute quant à la

validité de son postulat. Mais en 1905, EINSTEIN montre qu'une généralisation du postulat

de PLANCK permet de comprendre un autre phénomène que la physique classique ne peut

expliquer : l'effet photoélectrique.

II.2. L’effet photoélectrique

Sous irradiation ultraviolette, un métal émet spontanément des électrons. La première

observation expérimentale de ce phénomène, appelé effet photoélectrique, a été faite par

BECQUEREL en 1839. Les expériences de LENARD en 1900 en donnent les caractéristiques

principales :

- pour chaque type de métal, il existe une fréquence seuil v0 en deçà de laquelle on

n'observe pas d'émission de "photoélectrons".

- le nombre d'électrons émis par le métal dépend de l'intensité lumineuse, mais leur

vitesse ne dépend que de la fréquence du rayonnement UV.

- l'émission est un phénomène instantané, même pour de très faibles intensités.

Ces faits sont complètement incompréhensibles avec l'image classique d'un échange

continu d'énergie entre la matière et le rayonnement.

L'interprétation des lois expérimentales est due à Albert EINSTEIN en 1905. Sur la

base des travaux de PLANCK, EINSTEIN suppose qu'un rayonnement électromagnétique est

composé de corpuscules, baptisés photons par la suite. La relation liant l'énergie E portée par

les photons et la fréquence

ν

du rayonnement lumineux est appelée relation de Planck-

Einstein :

E=h

!

=h c

"

Pour extraire un électron d'un métal, il faut fournir une énergie minimale W. Lorsque

un photon est absorbé sur une surface métallique, il cède à l'électron un quantum

d'énergie

h

!

. Si la fréquence

ν

est suffisamment élevée, l'électron est arraché du métal.

L'excédent d'énergie permet à l'électron d'acquérir une certaine énergie cinétique. Ceci se

traduit par l'équation :

h

!

=1

2

mv2+W

où v est la vitesse du photoélectron. L'existence d'une valeur limite de la fréquence en dessous

de laquelle l'effet photoélectrique n'est plus observé se comprend alors facilement : si l'on

diminue la fréquence du rayonnement incident, l'énergie cinétique du photoélectron diminue

15

jusqu'à une fréquence seuil v0 correspondant à une énergie cinétique nulle. Le photon possède

alors juste assez d'énergie pour arracher l'électron du métal :

h

!

0=W

Appareil de Lenard pour étudier l’émission photoélectrique d’une cathode

C écalairée par une source lumineuse.

L'énergie d'ionisation W étant une caractéristique du métal utilisé, la fréquence seuil v0

ne dépend pas de l'intensité du rayonnement, conformément aux observations expérimentales.

L'effet photoélectrique et le rayonnement électromagnétique du corps noir montrent

que l'échange d'énergie entre la matière et le rayonnement est quantifié. La constante

universelle h découverte par PLANCK est liée à l'existence de ces échanges discontinus

d'énergie.

C'est la mise en évidence de la nature discontinue des échanges d'énergie et son

interprétation qui révèle en tant que conséquence l'aspect corpusculaire de la lumière.

III. Quantification du spectre de l'hydrogène

En 1885, BALMER étudie le spectre d’émission de l’atome d’hydrogène. Il obtient

une série de raies formant un spectre discontinu, et non pas le spectre continu prédit par les

lois classiques de l’électromagnétisme. RYDBERG établit en 1900 une loi empirique en 1/n2

(avec n entier) permettant de retrouver précisément les longueurs d'onde d'émission de cette

série de raies. Grâce au progrès des techniques spectroscopiques, Lyman découvre en 1906

une autre série de raies dans le domaine ultraviolet, puis Paschen détecte une série dans le

domaine infrarouge en 1909. On dénombre en tout 5 séries observées expérimentalement.

Elles peuvent être analysés par une formule empirique similaire à celle de RYDBERG,

énoncée par RITZ en 1908 :

1

!

=RH(1

nf

2"1

ni

2)

6

6

7

7

8

8

9

9

1

/

9

100%