APPROCHES VULGARISEES DE LA MECANIQUE QUANTIQUE

1

APPROCHES VULGARISEES DE LA

MECANIQUE QUANTIQUE

Fille de l'ancienne théorie des quanta, la mécanique quantique fixe un cadre mathématique

cohérent qui a permis de remédier à tous les désaccords entre certains résultats expérimentaux

mis en évidence à la fin du XIXe siècle et les prédictions théoriques correspondantes de la

physique classique. La mécanique quantique a repris et développé l'idée de dualité onde-

particule1 introduite par Louis de Broglie en 1924 consistant à considérer les particules de

matière non pas seulement comme des corpuscules ponctuels, mais aussi comme des ondes,

possédant une certaine étendue spatiale (voir Mécanique ondulatoire). Niels Bohr a introduit

le concept de « complémentarité » pour résoudre cet apparent paradoxe : tout objet physique

est bien à la fois une onde et un corpuscule, mais ces deux aspects, mutuellement exclusifs,

ne peuvent être observés simultanément2. Si l'on observe une propriété ondulatoire, l'aspect

corpusculaire disparaît. Réciproquement, si l'on observe une propriété corpusculaire,

l'aspect ondulatoire disparaît. En 2008, aucune contradiction n'a pu être décelée entre les

prédictions de la mécanique quantique et les tests expérimentaux associés. Malgré cela, la

théorie continue d'être mal comprise par le public car elle repose sur un formalisme

mathématique abstrait, qui rend son abord assez difficile pour le profane.

1 ) Introduction

Un des grands problèmes de la physique quantique est de donner des images. En effet,

l'être humain a besoin d'images pour réfléchir, pour retenir. À titre d'exemple, lorsqu'on ne

connaît quelqu'un que par la voix (on l'a eu au téléphone ou entendu à la radio) et que l'on voit

la personne pour la première fois, on se dit « c'est bien comme cela que je me l'imaginais » ou

bien au contraire « je ne me l'imaginais pas du tout comme cela » ; notre cerveau a donc

1 Dualité onde-particule

En physique, la dualité onde-particule ou dualité onde-corpuscule est un principe selon lequel tous les objets de l'univers

microscopique présentent simultanément des propriétés d'ondes et de particules. Ce concept fait partie des fondements de la

mécanique quantique. Cette dualité tente de rendre compte de l'inadéquation des concepts conventionnels de « particules » ou

d'« ondes », pris isolément, à décrire le comportement des objets quantiques. L'idée de la dualité prend ses racines dans un

débat remontant aussi loin que le XVIIe siècle siècle, quand s'affrontaient les théories concurrentes de Christiaan Huygens qui

considérait que la lumière était composée d'ondes et celle de Isaac Newton qui considérait la lumière comme un flot de

particules. À la suite des travaux de Albert Einstein, Louis de Broglie et bien d'autres, les théories scientifiques modernes

accordent à tous les objets une nature d'onde et de particule, bien que ce phénomène ne soit perceptible qu'à des échelles

microscopiques. Il est important de mentionner que c’est l’absence d’équivalent macroscopique sur quoi nous pourrions nous

référer qui nous force à penser les objets quantiques comme possédant des attributs contradictoires. Il serait inexact de dire

que la lumière (comme tout autre système quantique d’ailleurs) est à la fois une onde et à la fois une particule, ce n’est ni

l’un, ni l’autre. Le manque d'un vocabulaire adéquat et l'impossibilité de se faire une représentation mentale intuitive des

phénomènes à petite échelle nous font voir ces objets comme ayant une nature, par elle même, antinomique. Pour lever cet

apparent paradoxe et insister sur l'imperfection de nos concepts classiques d'onde et de corpuscule, les physiciens Jean-Marc

Lévy-Leblond et Françoise Balibar ont proposé d'utiliser le terme de « quanton » pour parler d'un objet quantique. Un

quanton n'est ni une onde, ni un corpuscule, mais peut présenter les deux aspects selon le principe de complémentarité de

Bohr. Cette terminologie a du mal à s'imposer dans l'enseignement français. Le principe de complémentarité fut introduit à

Copenhague par Niels Bohr suite au principe d'indétermination de Werner Heisenberg comme approche philosophique aux

phénomènes apparemment contradictoires de la mécanique quantique, par exemple : celui de la dualité onde-corpuscule.

Dans sa forme la plus simpliste, il stipule qu'un « objet quantique » ne peut se présenter que sous un seul de ces deux aspects

à la fois. Souvent associé à l'école de Copenhague, ce principe est à présent un des concepts fondamentaux de la mécanique

quantique. L'expérience des fentes de Young en a fait une démonstration simple et efficace.

2

construit une image pour désigner cette personne, bien que l'on ne l'ait jamais vue. Le

problème en physique quantique est que, pour se représenter les objets (particules

élémentaires), il faut faire appel à deux notions : les ondes et les particules solides. On ne

peut se construire des images que par analogie avec ce que l'on connaît, avec notre expérience

quotidienne. Ainsi, lorsque l'on s'imagine une onde sonore, il nous vient à l'esprit les vagues

sur l'eau ; lorsque l'on s'imagine une particule, il nous vient à l'esprit une bille. Les deux

notions sont donc opposées et incompatibles :

Propriétés macroscopiques des ondes et particules

Particule Onde

localisée, d'extension définie délocalisée (un son peut être entendu dans toute la pièce)

création et destruction

impossible1

création et destruction facile (pincer ou arrêter une corde de

guitare)

séparés, impossibles à

fusionner1 addition simple (interférences)

Ceci cause un grand trouble, une incompréhension, et entraîne fréquemment un blocage,

notamment lorsque l'on se pose la question : « si une particule est bien localisée lors d'une

interaction, comment se fait-il qu'elle ne le soit pas hors interaction ? »

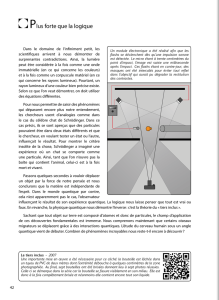

La métaphore du

cylindre

Métaphore du cylindre : objet ayant à la fois les propriétés

d'un cercle et d'un rectangle. La métaphore du cylindre est

l'exemple d'un objet ayant des propriétés apparemment

inconciliables. Il serait à première vue incongru d'affirmer

qu'un objet a à la fois les propriétés d'un cercle et d'un

rectangle : sur un plan, un objet est soit un cercle, soit un

rectangle. Mais si l'on considère un cylindre : une projection

dans l'axe du cylindre donne un cercle, et une projection

perpendiculairement à cet axe donne un rectangle. On a

donc bien un objet ayant les propriétés de l'un et de l'autre

(mais il n'est ni l'un, ni l'autre). « Onde » et « particule »

sont des manières de voir les choses et non pas les choses

en elles même.

Notons par ailleurs que dans la description mathématique de la physique quantique, le

résultat de la mesure est similaire à une projection géométrique (notion d'observable : l'état

de l'objet est décrit par des nombres que l'on peut voir comme des coordonnées dans une base

vectorielle, et en géométrie euclidienne, les coordonnées sont la projection de l'objet sur les

axes de référence).

2) Historique du concept Dualité onde-particule. La dualité onde-

particule s'est imposée au terme d'une longue histoire où les aspects purement ondulatoires et

corpusculaires ont été tour à tour privilégiés. Ces aspects ont tout d'abord été mis en évidence

avec les théories de la lumière, avant d'être étendus — au XXe siècle — à tous les objets

physiques.

3

Huygens et Newton La première théorie complète de la lumière a été établie par le physicien

néerlandais Christiaan Huygens au XVIIe siècle. Il proposait une théorie ondulatoire de la

lumière et a en particulier démontré que les ondes lumineuses pouvaient interférer de manière

à former un front d'onde se propageant en ligne droite. Toutefois, sa théorie possédait

certaines limitations en d'autres domaines et fut bientôt éclipsée par la théorie corpusculaire

de la lumière établie à la même époque par Isaac Newton. Newton proposait une lumière

constituée de petites particules, expliquant ainsi simplement les phénomènes de réflexion

optique. Au prix de complications considérables, cette théorie pouvait également expliquer les

phénomènes de réfraction à travers une lentille, et de dispersion d'un faisceau lumineux à

travers un prisme. Bénéficiant de l'immense prestige de Newton, cette théorie ne fut pas

remise en question pendant plus d'un siècle.

Fresnel, Maxwell et Young Au début du XIXe siècle, les expériences de diffraction faites

par Thomas Young et Augustin Fresnel ont démontré l'exactitude des théories de Huygens :

ces expériences prouvèrent que quand la lumière est envoyée sur un réseau de diffraction, on

observe un motif d'interférence caractéristique, très semblable aux motifs résultant de

l'interférence d'ondulations sur l'eau; la longueur d'onde de la lumière peut être calculée à

partir de tels motifs. Le point de vue ondulatoire n'a pas remplacé immédiatement le point de

vue corpusculaire, mais s'est imposé peu à peu à la communauté scientifique au cours du

XIXe siècle, surtout grâce à l'explication du phénomène de polarisation de la lumière que ne

pouvait expliquer l'autre approche. Ces équations furent vérifiées par maintes expériences et

le point de vue de Huygens devint largement admis.

James Maxwell, à la fin du XIXe siècle, expliqua la lumière en tant que propagation d'ondes

électromagnétiques avec les équations de Maxwell.

Einstein et photons En 1905, Albert Einstein réconcilia la théorie de Huygens avec celle de

Newton : il expliqua l'effet photoélectrique, un effet dans lequel la lumière n'agit pas en tant

qu'onde, en postulant l'existence des photons, quanta d'énergie lumineuse avec des qualités de

particules. Einstein postula que la fréquence ν de cette lumière, est liée à l'énergie E des

photons : E = hν où h est la constante de Planck (6,626×10-34J s).

De Broglie

En 1924, dans sa thèse2, Louis de Broglie affirma que toute matière (et pas seulement la

lumière) a une nature ondulatoire. Il associa la quantité de mouvement p d'une particule à

une longueur d'onde λ, appelée longueur d'onde de de Broglie :

h

p

λ

=

C'est une généralisation de la relation de Planck-Einstein indiquée ci-dessus, car la quantité de

mouvement (ou l'impulsion) d'un photon est donné par

E

p

c

=

où c est la vitesse de la lumière

dans le vide, et

c

λ

υ

=

(si on remplace p et ν dans l'équation de de Broglie, on retrouve

l'équation d'Einstein).

4

: Hypothèse de De Broglie. La formule exprimée par de Broglie fut confirmée trois ans après

par Clinton Joseph Davisson et Lester Halbert Germer. Ceux-ci dirigèrent un faisceau

d'électrons qui, contrairement aux photons, ont une masse vers un réseau de diffraction

cristallin : les motifs d'interférence attendus purent ainsi être observés. Des expériences

semblables ont été entreprises depuis avec des protons et même avec des molécules entières,

avec notamment l'expérience d'Estermann et Otto Stern en 1929, et la formule a été confirmée

dans tous les cas. De Broglie reçut en 1929 le prix Nobel de physique pour son hypothèse, qui

influença profondément la physique de cette époque. La confirmation la plus spectaculaire est

celle qui a été faite en 1999 par des chercheurs de l'Université de Vienne3, qui ont fait

diffracter du fullerène (molécule C60). Dans cette expérience, la longueur d'onde de de Broglie

était de 2,5 pm alors que la molécule a un diamètre d'environ 1 nm, soit 400 fois supérieur.

3) Mise en évidence de la dualité : fentes de Young

Figure 1 : Schéma de l'expérience.

Figure 2 : Figure

d'interférence observée.

Une des manières les plus claires de mettre

en évidence la dualité onde-particule est

l'expérience des fentes de Young. Cette

expérience est connue depuis le XIXe siècle,

où elle a d'abord mis clairement en évidence

l'aspect purement ondulatoire de la lumière.

Modifiée de manière adéquate, elle peut

démontrer de manière spectaculaire la dualité

onde-corpuscule non seulement de la

lumière, mais aussi de tout autre objet

quantique. Dans la description qui suit, il

sera question de lumière et de photons mais il

ne faut pas perdre de vue qu'elle est

également applicable - du moins en principe

- à toute autre particule (par exemple des

électrons), et même à des atomes et à des

molécules. L'expérience consiste à éclairer

par une source lumineuse un écran percé de

deux fentes très fines et très rapprochées. Ces

deux fentes se comportent comme deux

sources secondaires d'émission lumineuse.

Une plaque photographique placée derrière

l'écran enregistre la lumière issue des deux

fentes (⇐ voir figure 1). Ces deux sources

interfèrent et forment sur la plaque

photographique ce que l'on appelle une

figure d'interférence (voir figure 2 ⇒).

Cette figure est caractéristique d'un

comportement ondulatoire de la lumière

(voir l'article interférence). Si l'expérience en

reste à ce niveau, l'aspect corpusculaire

n'apparait pas.

5

Figure 3 : Expérience avec de "vraies"

particules, par exemple des micro-billes

Figure 4 : Figure d'interférence constituée

petit à petit

Force est donc de constater une dualité onde-

particule des photons (ou de tout autre objet

quantique), qui présentent simultanément les

deux aspects.

En fait, il est possible de diminuer l'intensité

lumineuse de la source primaire de manière à

ce que la lumière soit émise photon par

photon. Le comportement de la lumière

devient alors inexplicable sans faire appel à

la dualité onde-corpuscule. En effet, si on

remplace la source lumineuse par un canon

qui tire des micro-billes à travers les deux

fentes (par exemple), donc de "vraies"

particules, on n'obtient aucune figure

d'interférence, mais simplement une zone

plus dense, en face des fentes (

⇐

⇐⇐

⇐

voir figure

3). Or, dans le cas des photons, on retrouve

la figure d'interférence reconstituée petit à

petit, à mesure que les photons apparaissent

sur la plaque photographique (figure 4 ⇒).

On retrouve donc une figure d'interférence,

caractéristique des ondes, en même temps

qu'un aspect corpusculaire des impacts sur

la plaque photographique. L'interprétation

de cette expérience est difficile, car si on

considère la lumière comme une onde, alors

les points d'impacts sur la plaque

photographique sont inexplicables; on

devrait voir dans ce cas très faiblement, dès

les premiers instants, la figure

d'interférence de la figure 2, puis de plus en

plus intense. Au contraire, si on considère

la lumière comme étant exclusivement

composée de particules, alors les impacts

sur la plaque photographique s'expliquent

aisément, mais la figure d'interférence ne

s'explique pas : comment et pourquoi

certaines zones seraient privilégiées et

d'autres interdites à ces particules ?

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

1

/

76

100%