Architecture des ordinateurs - Groupe Calcul

Ecole d’Automne « Informatique Scientifique

pour le Calcul »

–

Architecture des ordinateurs

Françoise Berthoud1

Violaine Louvet 2

Françoise Roch 3

1Laboratoire de Physique et de Modélisation des Milieux Condensés - CNRS

2Institut Camille Jordan - CNRS

3Observatoire des Sciences de l’Univers de Grenoble

29/09/08 - 03/10/08

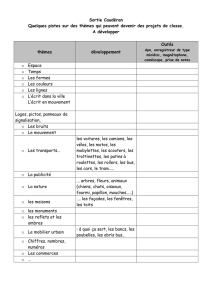

Sommaire

1Evolution des architectures

2Comment faire des processeurs plus rapides ?

Augmenter la fréquence d’horloge

Parallélisme interne des instructions et des données

Thread Level Parallelism

3La problématique de la mémoire

Les différentes technologies

Hiérarchisation de la mémoire

Organisation des caches

Notion de localité mémoire

Lecture/Ecriture des données

Mémoire virtuelle

Page faults

TLB, Translation Lookaside Buffer

4Communications CPU - Mémoire - IO

Bus mémoire

Bus d’extension

5Comment faire des architectures plus rapides ?

Les architectures multicœurs

Organisation des caches

6Les processeurs spécialisés

Les GPU

Le CELL

7Technologie réseau

8Conclusions

Outline

1Evolution des architectures

2Comment faire des processeurs plus rapides ?

Augmenter la fréquence d’horloge

Parallélisme interne des instructions et des données

Thread Level Parallelism

3La problématique de la mémoire

Les différentes technologies

Hiérarchisation de la mémoire

Organisation des caches

Notion de localité mémoire

Lecture/Ecriture des données

Mémoire virtuelle

Page faults

TLB, Translation Lookaside Buffer

4Communications CPU - Mémoire - IO

Bus mémoire

Bus d’extension

5Comment faire des architectures plus rapides ?

Les architectures multicœurs

Organisation des caches

6Les processeurs spécialisés

Les GPU

Le CELL

7Technologie réseau

8Conclusions

Evolution des architectures

Loi de Moore : nb de transistors par circuit intégré ×2 tous les 2 ans.

En 10 ans, la finesse de gravure est passée de 0,25 µm(Pentium III) à

0,045 µm(Core 2 Penryn).

Evolution de l’architecture des processeurs (pipeline, duplication des

unités fonctionnelles, exécution spéculative, exécution désordonnée ...).

Evolution des interactions architecture/applications : dans le cas de

l’Itanium, le compilateur fait partie intégrante de l’architecture.

Evolution des infrastructures vers un haut degré de parallélisme en

intégrant un grand nombre de processeurs.

Top 500 Bench

Linpack

Puissance

soutenue en

Gflops

Puissance

crête en

Gflops

Nombre de

processeurs

ou de cœurs

Juin 1993 59.7 131 1024

Juin 2008 1 026 000 1 375 780 122 400

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

1

/

76

100%