Structure des ordinateurs - Pages personnelles des membres de l

Structure des ordinateurs – Y. Mine – ESA

1 Bac Info 2015/2016

1

Structure des ordinateurs

Y. Mine / 2015-2016 / 1 Bac Info

Structure des ordinateurs – Y. Mine – ESA

1 Bac Info 2015/2016

2

Ecole Supérieure des Affaires - Namur

Cours de Hardware - 1è Bac en informatique 2015 - 1016

Y. Mine

L'informatique est une compétition commerciale et technologique dans laquelle l’évolution des

composants et des systèmes est quotidienne. Ce cours sera donc mis à jour en temps réel en

fonction de l'évolution des produits.

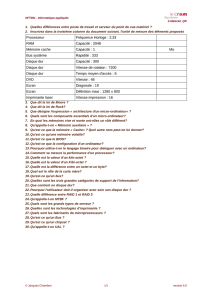

Sommaire

I – Les origines de l'informatique

II - Le codage de l’information: le système binaire

1 Le boîtier central

1.1 Les cartes en général

1.1.1 La carte mère - les formats

1.1.1.1 Architecture multitâches

1.1.1.2 Le disque virtuel

1.1.1.3 La mémoire virtuelle

1.1.2 Les cartes d’extension

1.1.3 Le refroidissement du pc

1.1.4 Le DRM

1.2 Le processeur

1.2.1 Définition du processeur

1.2.2 Fonctionnement du processeur

1.2.3 Fabrication des processeurs

1.2.4 Historique des processeurs

1.2.5 Les valeurs utilisées

1.2.6 Composition d'un processeur

1.2.7 Le refroidissement

1.2.8 Architecture super-scalaire

1.2.9 Les supports des processeurs

1.2.10 Les différents processeurs

1.2.10.1 Pentium

1.2.10.2 Xéon

1.2.10.3 Pentium2

1.2.10.4 Pentium4

1.2.10.5 Centrino

1.2.10.6 Athlon

1.2.10.7 Cell

1.2.10.8 Core2

1.2.10.9 Core 2 Quad

1.2.10.10 Core i7

1.2.10.11 Atom

1.2.10.12 AMD FX8150 Bulldozer

1.2.11 Rôle du processeur

1.2.12 La course à la miniaturisation

1.2.12.1 L'effet tunel

1.2.13 Les modes de transfert

1.3 Le chipset

1.3.1 Rôle du chipset

Structure des ordinateurs – Y. Mine – ESA

1 Bac Info 2015/2016

3

1.3.2 Conception du chipset

1.3.3 Les fonctions les plus importantes du chipset

1.4 Le bus

1.4.1 De quoi se compose le bus

1.4.2 Les connecteurs d’extension

1.4.3 Les types de bus

1.4.3.1 le bus ISA

1.4.3.2 le bus AT

1.4.3.3 le bus MCA

1.4.3.4 le bus EISA

1.4.3.5 le bus VESA (VLB)

1.4.3.6 le bus PCI

1.4.3.7 le bus AGP

1.4.3.8 le bus USB

1.4.3.9 l’interface SCSI

1.4.3.10 le bus AMR / CNR

1.4.3.11 le bus PCI Express

1.4.3.12 RedTacton

1.5 les interruptions

1.5.1 l’IRQ

1.5.2 répartition des interruptions

1.5.3 les déroutements

1.6 le canal DMA

1.7 les interfaces

1.7.1 l’interface RS 232 C

1.7.2 L'IEEE 1394 ou FireWire

1.7.3 l’interface centronics

1.7.4 L’IEEE 1284

1.7.5 Interfaces ATA ou IDE

1.7.6 Le Sata

1.7.7 Le Long LBA

1.7.8 Atapi

1.7.9 WiFi

1.7.10 Bluetooth

1.7.11 WiMax

1.7.12 La communication infrarouge

1.7.13 Les puces RFID

1.7.14 La 3G

1.7.15 La 4G

1.8 La mémoire cache

1.8.1 Le mode burst

1.8.2 Cache asynchrone

1.8.3 Cache synchrone

1.8.4 Cache pipeline burst

1.8.5 La taille de la cache

1.8.6 La vitesse de la cache

1.8.7 Contigüité

1.9 La mémoire virtuelle

1.10 Le bios

1.11 Le setup

1.12 Les mémoires

1.12.1 La rom

1.12.2 La ram

1.12.2.1 Les différentes sortes de ram

1.12.3 Aspects physique des barettes de mémoire

Structure des ordinateurs – Y. Mine – ESA

1 Bac Info 2015/2016

4

1.12.4 Le contrôle d’erreur

1.12.5 Mémoire avec correction d'erreur

1.12.6 Technologies ram en développement

1.12.7

1.13 Combien de Ram

1.14 Organisation de la mémoire vive

1.15 Gestion de la mémoire

1.15.1 Mémoire conventionnelle

1.15.2 Mémoire supérieure

1.15.3 Mémoire étendue XMS

1.15.4 Mémoire expansée EMS

1.16 La mémoire flash

1.16.1 Les types de cellules

1.16.2 Les mémoires Compact flash

1.16.3 Nanocristaux de silicium

1.16.4 Les SSD

1.17 L'alimentation électrique du système

1.17.1 La recharge par induction

1.18 Le disque dur

1.18.1 La mécanique du HD

1.18.2 Le format du HD

1.18.3 Défragmentation du HD

1.18.4 Partitionnement du HD

1.18.5 Les différentes structures de fichiers

1.19 l’architecture PCMCIA

1.20 le floppy FD

1.21 les streamers

1.22 -

1.23 les disques magnéto-optiques

1.24 les Cd et DVD Rom et Ram

1.24.1 Les graveurs

1.24.2 DVD – et + R/RW

1.24.3 Blue Ray

1.24.4 La stockage holographique

1.24.5 DVD-RAM

1.25 les cartes vidéo

1.25.1 Résolution et taux d’images

1.25.2 Les formats de fichiers

1.25.3 -

1.25.4 Les cartes accélératrices 3D

1.25.5 Les bibliothèques

1.25.6 La compression des données

1.25.7 Les normes graphiques

1.26 les bases de registres

2 Les périphériques

2.1 les écrans

2.1.1 écran cathodique

2.1.2 écran LCD

2.1.2.1 Les différents états des cristaux

2.1.2.2 La polarisation

2.1.3 écran plasma

2.1.4 écran électroluminescent organique

Structure des ordinateurs – Y. Mine – ESA

1 Bac Info 2015/2016

5

2.1.5 les projecteurs

2.1.6 les diodes électroluminescentes

2.1.7 les panneaux électroluminescents

2.1.8 écran fluorescent

2.1.9 écrans FED

2.1.10 écrans SED

2.2 les imprimantes

2.2.1 les imprimantes matricielles

2.2.2 les imprimantes à jet d’encre

2.2.2.1 Le procédé thermique

2.2.2.2 Le procédé piézoélectrique

2.2.3 Les imprimantes à encre solide

2.2.4 Les imprimantes laser

2.2.5 Les imprimantes thermiques

2.2.6 Les imprimantes à transfert thermique

2.2.7 Les imprimantes à LEDS

2.2.8 Le standart Postscript

2.2.9 Le papier électronique

2.3 le pavé tactile

2.4 -

2.5 -

2.6 les technologies de communication

2.7 la carte son

2.7.1 Les hauts-parleurs

2.8 la souris

2.9 le stylet

2.10 le trackbal

2.11 Le cablage

2.12 Le clavier

2.12.1 Les touches à bascule

2.12.2 Le code ASCII

2.12.3 Les branchements

2.13 Le scanner

3. Les serveurs

3.1 les serveurs

3.2 le système RAID

3.3 organisation et administration des documents

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

145

145

146

146

147

147

148

148

149

149

150

150

151

151

152

152

153

153

154

154

155

155

156

156

157

157

158

158

159

159

160

160

161

161

162

162

163

163

164

164

165

165

166

166

167

167

168

168

169

169

170

170

171

171

172

172

173

173

174

174

175

175

176

176

177

177

178

178

179

179

180

180

181

181

182

182

183

183

184

184

185

185

186

186

187

187

188

188

189

189

190

190

191

191

192

192

193

193

194

194

195

195

196

196

197

197

198

198

199

199

200

200

201

201

202

202

203

203

204

204

205

205

206

206

207

207

208

208

209

209

210

210

211

211

212

212

213

213

214

214

215

215

216

216

217

217

218

218

219

219

220

220

221

221

222

222

223

223

224

224

225

225

226

226

227

227

228

228

229

229

230

230

231

231

232

232

233

233

234

234

235

235

236

236

237

237

238

238

239

239

240

240

241

241

242

242

243

243

244

244

245

245

246

246

247

247

248

248

249

249

250

250

251

251

252

252

253

253

254

254

255

255

256

256

257

257

258

258

259

259

260

260

261

261

262

262

263

263

264

264

265

265

266

266

267

267

268

268

269

269

270

270

271

271

272

272

273

273

274

274

275

275

276

276

277

277

278

278

279

279

280

280

281

281

282

282

283

283

284

284

285

285

1

/

285

100%